环境要求

开发环境:python3

需要导入的包:

numpy

pandas

time

QLearning算法简介

Q学习算法会根据所经历的状态和所选择的行为建立一张Q表,如下表,表格中每个单元格的初值均为0

"""

left right

s0 0.0 0.0

s1 0.0 0.0

s2 0.0 0.0

s3 0.0 0.0

s4 0.0 0.0

s5 0.0 0.0

"""

Q学习算法会根据每一轮学习得到的奖励值更新Q表,简单地讲就是:在拿到最终奖励后,这一轮学习结束,会将得到的奖励值按比率传递给前一个状态时所选择的行为,这样Q表就记住了是什么状态下选择了什么行为才拿到最终奖励,Q表中该状态下行为的值可在下一轮学习中传递给上一个状态的行为,直至初始状态的行为值被更新。

经过一轮一轮的更新,Q表中从初始状态到最终状态每一步应该选择的行为都会有较高的分值,也就完成了训练。

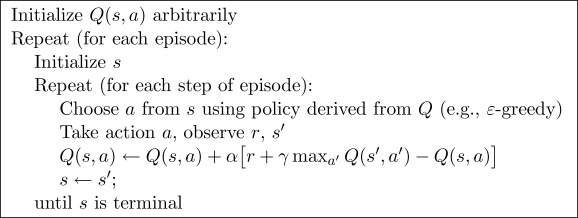

Q学习算法的实现要比上述过程稍微复杂一点,因为算法中加入了贪婪度、学习率以及奖励衰减等参数,具体流程如下图:

如上图所示,Q表的更新是用下一个状态的所能拿到的最大奖励,作为当前状态行为的目标值,与Q表中记录的实际值做比较后,对当前值进行更新。用下个状态更新当前状态,也就形成了最终奖励的反向传递,形成一条由最终状态指向初始状态的通路。由于每次更新都由下一个状态的所能拿到的最大奖励作为目标值,这使得Q学习算法具有很强的贪婪性,可以很快完成训练。

算法实现

这一次我们会用 tabular Q-learning 的方法实现一个小例子, 例子的环境是一个一维世界, 在世界的右边有宝藏, 探索者只要得到宝藏尝到了甜头, 然后以后就记住了得到宝藏的方法, 这就是他用强化学习所学习到的行为.

-o---T

# T 就是宝藏的位置, o 是探索者的位置

预设值

这一次需要的模块和参数设置:

import numpy as np

import pandas as pd

import time

N_STATES = 6 # 1维世界的宽度

ACTIONS = ['left', 'right'] # 探索者的可用动作

EPSILON = 0.9 # 贪婪度 greedy

ALPHA = 0.1 # 学习率

GAMMA = 0.9 # 奖励递减值

MAX_EPISODES = 13 # 最大回合数

FRESH_TIME = 0.3 # 移动间隔时间

Q表

对于 tabular Q learning, 我们必须将所有的 Q values (行为值) 放在 q_table 中, 更新 q_table 也是在更新他的行为准则. q_table 的 index 是所有对应的 state (探索者位置), columns 是对应的 action (探索者行为).

def build_q_table(n_states, actions):

table = pd.DataFrame(

np.zeros((n_states, len(actions))), # q_table 全 0 初始

columns=actions, # columns 对应的是行为名称

)

return table

# q_table:

"""

left right

0 0.0 0.0

1 0.0 0.0

2 0.0 0.0

3 0.0 0.0

4 0.0 0.0

5 0.0 0.0

"""

定义行为

接着定义探索者是如何挑选行为的. 这是我们引入 epsilon greedy 的概念. 因为在初始阶段, 随机的探索环境, 往往比固定的行为模式要好, 所以这也是累积经验的阶段, 我们希望探索者不会那么贪婪(greedy). 所以 EPSILON 就是用来控制贪婪程度的值. EPSILON 可以随着探索时间不断提升(越来越贪婪), 不过在这个例子中, 我们就固定成 EPSILON = 0.9, 90% 的时间是选择最优策略, 10% 的时间来探索.

# 在某个 state 地点, 选择行为

def choose_action(state, q_table):

state_actions = q_table.iloc[state, :] # 选出这个 state 的所有 action 值

if (np.random.uniform() > EPSILON) or (state_actions.all() == 0): # 非贪婪 or 或者这个 state 还没有探索过

action_name = np.random.choice(ACTIONS)

else:

action_name = state_actions.argmax() # 贪婪模式

return action_name

环境反馈

做出行为后, 环境也要给我们的行为一个反馈, 反馈出下个 state (S_) 和 在上个 state (S) 做出 action (A) 所得到的 reward( R ) . 这里定义的规则就是, 只有当 o 移动到了 T, 探索者才会得到唯一的一个奖励, 奖励值 R=1, 其他情况都没有奖励.

def get_env_feedback(S, A):

# This is how agent will interact with the environment

if A == 'right': # move right

if S == N_STATES - 2: # terminate

S_ = 'terminal'

R = 1

else:

S_ = S + 1

R = 0

else: # move left

R = 0

if S == 0:

S_ = S # reach the wall

else:

S_ = S - 1

return S_, R

环境更新

def update_env(S, episode, step_counter):

# This is how environment be updated

env_list = ['-']*(N_STATES-1) + ['T'] # '---------T' our environment

if S == 'terminal':

interaction = 'Episode %s: total_steps = %s' % (episode+1, step_counter)

print('\r{}'.format(interaction), end='')

time.sleep(2)

print('\r ', end='')

else:

env_list[S] = 'o'

interaction = ''.join(env_list)

print('\r{}'.format(interaction), end='')

time.sleep(FRESH_TIME)

Q学习主循环

def rl():

q_table = build_q_table(N_STATES, ACTIONS) # 初始 q table

for episode in range(MAX_EPISODES): # 回合

step_counter = 0

S = 0 # 回合初始位置

is_terminated = False # 是否回合结束

update_env(S, episode, step_counter) # 环境更新

while not is_terminated:

A = choose_action(S, q_table) # 选行为

S_, R = get_env_feedback(S, A) # 实施行为并得到环境的反馈

q_predict = q_table.loc[S, A] # 估算的(状态-行为)值

if S_ != 'terminal':

q_target = R + GAMMA * q_table.iloc[S_, :].max() # 实际的(状态-行为)值 (回合没结束)

else:

q_target = R # 实际的(状态-行为)值 (回合结束)

is_terminated = True # terminate this episode

q_table.loc[S, A] += ALPHA * (q_target - q_predict) # q_table 更新

S = S_ # 探索者移动到下一个 state

update_env(S, episode, step_counter+1) # 环境更新

step_counter += 1

return q_table

具体代码如下:

import numpy as np

import pandas as pd

import time

np.random.seed(2)

N_STATES = 6 # 1维世界的宽度

ACTIONS = ['left', 'right'] # 探索者的可用动作

EPSILON = 0.9 # 贪婪度 greedy

ALPHA = 0.1 # 学习率

GAMMA = 0.9 # 奖励递减值

MAX_EPISODES = 13 # 最大回合数

FRESH_TIME = 0.3 # 移动间隔时间

def build_q_table(n_states, actions):

table = pd.DataFrame(

np.zeros((n_states, len(actions))), # q_table 全 0 初始

columns=actions, # columns 对应的是行为名称

)

return table

# q_table:

"""

left right

0 0.0 0.0

1 0.0 0.0

2 0.0 0.0

3 0.0 0.0

4 0.0 0.0

5 0.0 0.0

"""

# 在某个 state 地点, 选择行为

def choose_action(state, q_table):

state_actions = q_table.iloc[state, :] # 选出这个 state 的所有 action 值

if (np.random.uniform() > EPSILON) or (state_actions.any() == 0): # 非贪婪 or 或者这个 state 还没有探索过

action_name = np.random.choice(ACTIONS)

else:

action_name = state_actions.idxmax() # 贪婪模式

return action_name

def get_env_feedback(S, A):

# This is how agent will interact with the environment

if A == 'right': # move right

if S == N_STATES - 2: # terminate

S_ = 'terminal'

R = 1

else:

S_ = S + 1

R = 0

else: # move left

R = 0

if S == 0:

S_ = S # reach the wall

else:

S_ = S - 1

return S_, R

def update_env(S, episode, step_counter):

# This is how environment be updated

env_list = ['-'] * (N_STATES - 1) + ['T'] # '---------T' our environment

if S == 'terminal':

interaction = 'Episode %s: total_steps = %s' % (episode + 1, step_counter)

print('\r{}'.format(interaction), end='')

time.sleep(2)

print('\r ', end='')

else:

env_list[S] = 'o'

interaction = ''.join(env_list)

print('\r{}'.format(interaction), end='')

time.sleep(FRESH_TIME)

def rl():

q_table = build_q_table(N_STATES, ACTIONS) # 初始 q table

for episode in range(MAX_EPISODES): # 回合

step_counter = 0

S = 0 # 回合初始位置

is_terminated = False # 是否回合结束

update_env(S, episode, step_counter) # 环境更新

while not is_terminated:

A = choose_action(S, q_table) # 选行为

S_, R = get_env_feedback(S, A) # 实施行为并得到环境的反馈

q_predict = q_table.loc[S, A] # 估算的(状态-行为)值

if S_ != 'terminal':

q_target = R + GAMMA * q_table.iloc[S_, :].max() # 实际的(状态-行为)值 (回合没结束)

else:

q_target = R # 实际的(状态-行为)值 (回合结束)

is_terminated = True # terminate this episode

q_table.loc[S, A] += ALPHA * (q_target - q_predict) # q_table 更新

S = S_ # 探索者移动到下一个 state

update_env(S, episode, step_counter + 1) # 环境更新

step_counter += 1

return q_table

if __name__ == "__main__":

q_table = rl()

print('\r\nQ-table:\n')

print(q_table)

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)