4.1 雅克比迭代法:

雅可比迭代法是一种用于求解线性方程组的迭代算法,其基本思想是将线性方程组中的系数矩阵拆分为对角线矩阵和非对角线矩阵两部分,并利用对角线矩阵的逆矩阵来迭代求解方程组。

具体地,设线性方程组为Ax=b,其中A为系数矩阵,b为常数向量,x为未知向量,雅可比迭代法的迭代公式如下:

x[i+1] = D^(-1) * (b - R * x[i])

其中,D为系数矩阵A的对角线矩阵,R为非对角线矩阵,即R=A-D。x[i]表示第i次迭代的解向量,x[i+1]表示第i+1次迭代的解向量。

雅可比迭代法的迭代过程中,每次迭代都只涉及对角线矩阵D和常数向量b的运算,因此具有简单、易于实现的优点。但是,该方法的收敛速度较慢,当系数矩阵的条件数较大时,可能需要进行大量的迭代才能达到较高的精度,因此在实际应用中,通常需要结合其他迭代算法来加速求解。

我的理解:

我的理解:

雅可比迭代法是一种用于求解线性方程组的迭代算法,其基本思想是将系数矩阵拆分成对角线矩阵和非对角线矩阵,通过迭代的方式逐步逼近方程组的解。在每次迭代中,首先将解向量的初始值代入方程组中,然后用对角线矩阵的逆矩阵来更新解向量的每个分量,使其逐步逼近真实解。这样,通过多次迭代,可以得到较为精确的解。

雅可比迭代法的优点是简单易于实现,但其收敛速度较慢,通常需要迭代多次才能得到较高的精度。因此,在实际应用中,为了提高迭代速度和精度,可以结合其他迭代算法使用,如Gauss-Seidel迭代法、SOR迭代法等。

需要注意的是,雅可比迭代法只能用于求解对称正定的线性方程组,并且系数矩阵的对角线元素不能为零。如果系数矩阵满足这些条件,那么雅可比迭代法可以是一种简单、高效的求解线性方程组的方法。

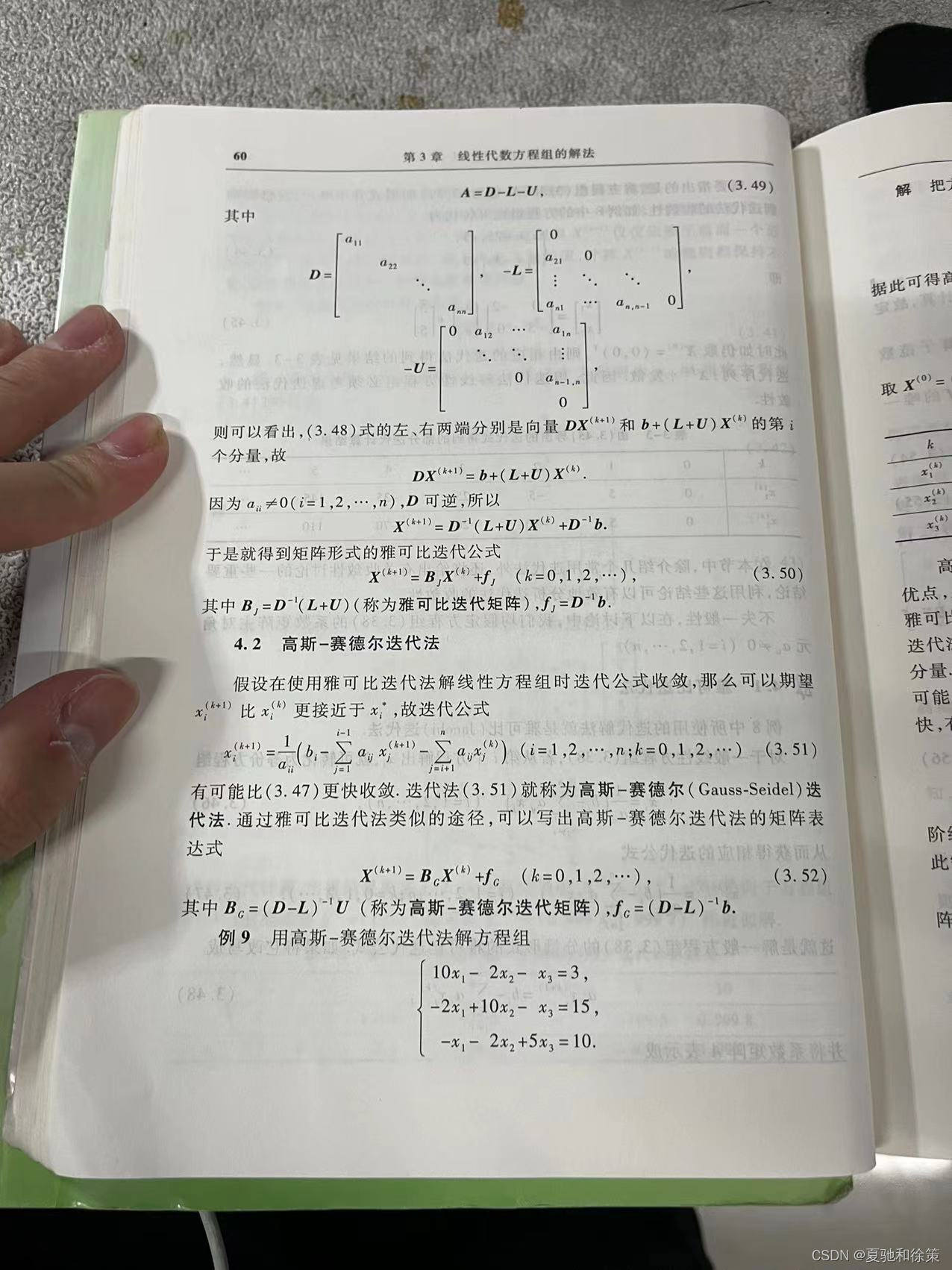

4.2 高斯—赛德尔迭代法:

高斯-赛德尔迭代法是一种用于求解线性方程组的迭代算法,其基本思想是在雅可比迭代法的基础上,每次更新解向量时,利用已经更新的分量来更新未更新的分量,从而加速迭代的过程。

具体来说,设线性方程组为Ax=b,其中A为系数矩阵,b为常数向量,x为未知向量。将系数矩阵A分解为下三角矩阵L、对角线矩阵D和上三角矩阵U的形式,即A=L+D+U。则高斯-赛德尔迭代法的迭代公式如下:

x[i+1] = (D+L)^(-1) * (-U * x[i] + b)

其中,x[i]表示第i次迭代的解向量,x[i+1]表示第i+1次迭代的解向量。在每次迭代中,首先将解向量的初始值代入方程组中,然后利用已经更新的分量来更新未更新的分量,从而逐步逼近真实解。

高斯-赛德尔迭代法相较于雅可比迭代法,可以加速迭代过程并提高收敛速度,但需要注意的是,该方法仍然只能用于求解对称正定的线性方程组,并且系数矩阵的对角线元素不能为零。此外,该方法的收敛性与系数矩阵的性质有关,不同的系数矩阵可能需要不同的迭代次数才能达到较高的精度。

我的理解:

高斯-赛德尔迭代法是一种用于求解线性方程组的迭代算法,它是雅可比迭代法的改进版。与雅可比迭代法相比,高斯-赛德尔迭代法可以加速迭代的过程并提高收敛速度。

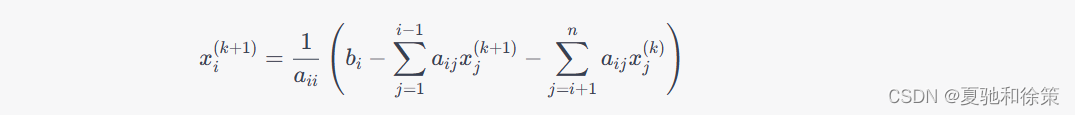

在高斯-赛德尔迭代法中,首先将系数矩阵A分解为下三角矩阵L、对角线矩阵D和上三角矩阵U的形式,即A=L+D+U。然后,迭代过程中,先使用已知的更新后的解向量的分量来更新未知的分量,这样可以利用已经得到的信息来更快地逼近真实解。具体来说,迭代公式如下:

x[i+1] = (D+L)^(-1) * (-U * x[i] + b)

其中,x[i]表示第i次迭代的解向量,x[i+1]表示第i+1次迭代的解向量,b为常数向量。在每次迭代中,利用已知的分量更新未知的分量,直到误差达到所需的精度要求。

需要注意的是,高斯-赛德尔迭代法仅适用于对称正定的线性方程组,并且系数矩阵的对角线元素不能为零。此外,该方法的收敛性与系数矩阵的性质有关,不同的系数矩阵可能需要不同的迭代次数才能达到较高的精度。

2023/5/4 补充

3.4.3 迭代法收敛条件与误差估计

线性方程组的迭代法是通过迭代求解逼近线性方程组的解的一种方法。常见的线性方程组迭代法包括Jacobi迭代法、Gauss-Seidel迭代法和SOR迭代法等。这些迭代法的收敛条件和误差估计如下:

- Jacobi迭代法

Jacobi迭代法是一种比较简单的线性方程组迭代法。设线性方程组 $Ax=b$ 的系数矩阵 $A$ 可以分解为 $A=M-N$,其中 $M$ 为 $A$ 的主对角线元素构成的对角矩阵,$N=A-M$。Jacobi迭代法的迭代公式为:

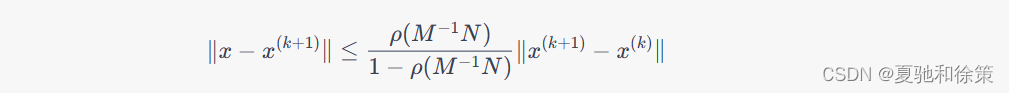

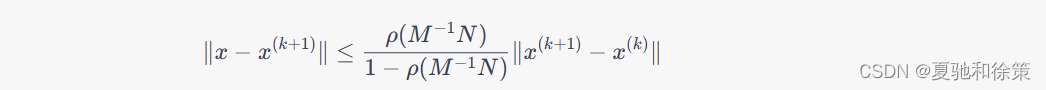

其中 $x^{(k)}$ 表示第 $k$ 次迭代的解向量。Jacobi迭代法的收敛条件为:矩阵 $M^{-1}N$ 的谱半径 $\rho(M^{-1}N)<1$,其中谱半径定义为矩阵的所有特征值的模的最大值。当满足收敛条件时,迭代解的误差满足以下误差估计式:

其中 $| \cdot |$ 表示向量的范数。

- Gauss-Seidel迭代法

Gauss-Seidel迭代法是一种基于Jacobi迭代法的改进方法。Gauss-Seidel迭代法的迭代公式为:

其中 $x_i^{(k)}$ 表示第 $k$ 次迭代的第 $i$ 个分量。Gauss-Seidel迭代法的收敛条件为:矩阵 $A$ 是对称正定矩阵或者是对称半正定矩阵。当满足收敛条件时,迭代解的误差满足以下误差估计式:

其中 $\rho(M^{-1}N)$ 是 $M^{-1}N$ 的谱半径。

- SOR迭代法

SOR迭代法是对Gauss-Seidel迭代法的一种改进方法。SOR迭代法的迭代公式为:

其中 $\omega$ 是松弛因子,$0<\omega<2$。SOR迭代法的收敛条件为:矩阵 $A$ 是对称正定矩阵或者是对称半正定矩阵,并且 $0<\omega<2$。当满足收敛条件时,迭代解的误差满足以下误差估计式:

其中 $\rho(M^{-1}N)$ 是 $M^{-1}N$ 的谱半径。

需要注意的是,迭代法的收敛速度和迭代初值的选取密切相关。如果选取的初值比较接近真解,那么迭代的收敛速度就会比较快。此外,迭代法的收敛速度还受到矩阵的条件数、系数矩阵的非零元素分布等因素的影响。

谱半径怎么求

矩阵的谱半径指的是其特征值的模中最大值,可以使用以下步骤来求解:

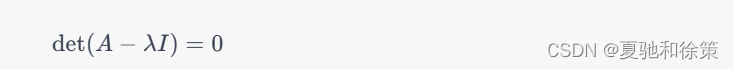

1. 求出矩阵的特征值:设矩阵为 $A$,则需要求解其特征值,即解方程 $|A - \lambda I| = 0$,其中 $I$ 为单位矩阵,$\lambda$ 为特征值。

2. 计算特征值的模:将求解得到的特征值 $\lambda_1,\lambda_2,\cdots,\lambda_n$,分别求其模,即 $\vert \lambda_i \vert$,其中 $n$ 为矩阵的阶数。

3. 取模最大值:找到所有特征值的模中的最大值,即 $\rho(A) = \max\limits_{i=1}^n \vert \lambda_i \vert$,其中 $\rho(A)$ 表示矩阵 $A$ 的谱半径。

需要注意的是,在计算特征值和特征向量时,可能会遇到矩阵特征值重复或复数特征值的情况,需要对这些情况进行特别处理,以保证求解结果的正确性。同时,在计算特征值的模时,需要注意使用合适的数值计算方法,以避免数值误差带来的影响。

特征值怎么求:

要求一个矩阵的特征值,可以解特征方程。设 $A$ 是一个 $n\times n$ 的矩阵,$\lambda$ 是一个标量,$I$ 是 $n\times n$ 的单位矩阵,则矩阵 $A$ 的特征方程为:

解特征方程,得到的所有解即为矩阵 $A$ 的特征值。

具体的你可以看我程序猿数学之线性代数的文章(传送门:5.1 矩阵的特征值和特征向量)

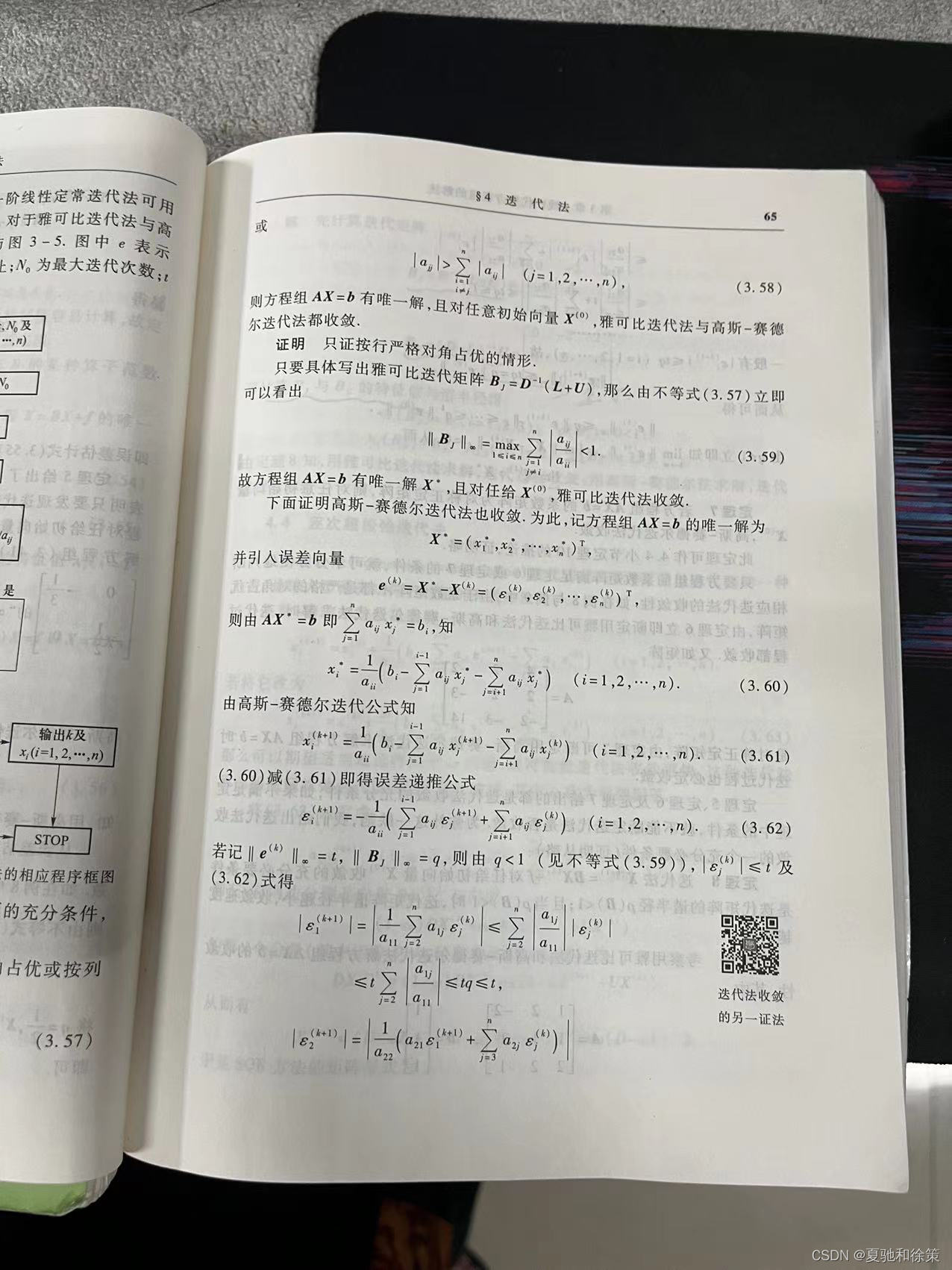

定理6的证明:

从这个证明我们可以学到:

-

迭代法的收敛性是基于系数矩阵的性质而定的,如果系数矩阵是对称正定矩阵,则 Jacobi、Gauss-Seidel、SOR 等迭代法均收敛,且收敛速度最快的是 SOR 迭代法,其收敛速度受松弛因子的影响。

-

迭代法的收敛性可以通过谱半径来判断,即当迭代矩阵的谱半径小于 1 时,迭代法才能收敛。

-

在证明迭代法的收敛性时,需要对迭代矩阵进行分析,将其写成向量形式,然后求出迭代矩阵的谱半径。

-

本质上,迭代法的收敛性是基于线性方程组的解的误差不断减小的原理。如果解的误差能够趋近于 0,那么迭代法就能够收敛。

学到的思想和方法:

从这个证明中,我们可以学到以下证明思想和方法:

-

利用向量和矩阵的运算关系简化问题。在证明迭代法收敛性时,通过将迭代矩阵写成向量形式,利用向量的范数和矩阵的乘法等性质,简化了问题的分析过程。

-

利用数学工具对问题进行分析。在证明迭代法收敛性时,使用了矩阵的谱半径、范数等概念,运用了对称正定矩阵、非负矩阵等性质,从数学的角度分析了问题的本质。

-

利用反证法进行证明。在证明迭代法收敛性时,采用了反证法,假设迭代法不收敛,然后推导出一个矛盾,进而说明迭代法必然收敛。

-

采用归纳法证明。在证明迭代法收敛性时,采用了归纳法,通过归纳证明每一步的解都能够逼近方程组的解,从而说明迭代法能够收敛。

这些证明思想和方法都是数学证明的常见手段,可以帮助我们在数学研究中更好地分析问题和解决问题。

3.4 逐次超松弛迭代法

逐次超松弛迭代法(Successive Over-Relaxation,SOR)也是一种用于求解线性方程组的迭代算法,它在雅可比迭代法和高斯-赛德尔迭代法的基础上进行了改进。

与高斯-赛德尔迭代法类似,逐次超松弛迭代法将系数矩阵A分解为下三角矩阵L、对角线矩阵D和上三角矩阵U的形式,即A=L+D+U。然后,在每次迭代中,先使用已知的更新后的解向量的分量来更新未知的分量,但是在更新的同时,使用一个松弛因子w来控制更新的幅度。这样,可以通过调整松弛因子w来控制迭代的速度和稳定性,从而提高收敛速度和精度。

具体来说,逐次超松弛迭代法的迭代公式如下:

x[i+1] = (1-w)x[i] + w(D+wL)^(-1)(-U*x[i] + b)

其中,x[i]表示第i次迭代的解向量,x[i+1]表示第i+1次迭代的解向量,b为常数向量。在每次迭代中,首先将解向量的初始值代入方程组中,然后利用已经更新的分量来更新未更新的分量,并通过调整松弛因子w来加速收敛。

需要注意的是,逐次超松弛迭代法的松弛因子w必须满足0<w<2的条件才能保证算法的收敛性。此外,松弛因子的取值对算法的收敛速度和精度有很大影响,需要根据具体问题来确定。在实际应用中,可以通过试错法或数值模拟等方法来确定合适的松弛因子。

我的理解:

逐次超松弛迭代法是一种求解线性方程组的迭代算法,它是在雅可比迭代法和高斯-赛德尔迭代法的基础上进行改进得到的。它的核心思想是通过使用一个松弛因子来控制每次迭代的幅度,从而提高迭代的速度和精度。

在每次迭代中,逐次超松弛迭代法先将系数矩阵A分解为下三角矩阵L、对角线矩阵D和上三角矩阵U的形式,即A=L+D+U。然后,使用已知的更新后的解向量的分量来更新未知的分量,但是在更新的同时,使用一个松弛因子w来控制更新的幅度。这样,在迭代的过程中,逐次超松弛迭代法可以通过调整松弛因子w来加速收敛并提高迭代的精度。

需要注意的是,逐次超松弛迭代法的松弛因子w必须满足0<w<2的条件才能保证算法的收敛性。此外,松弛因子的取值对算法的收敛速度和精度有很大影响,需要根据具体问题来确定。在实际应用中,可以通过试错法或数值模拟等方法来确定合适的松弛因子。

总的来说,逐次超松弛迭代法是一种比雅可比迭代法和高斯-赛德尔迭代法更快、更精确的求解线性方程组的方法,它在工程、科学计算等领域有着广泛的应用。

总结:

雅可比迭代法、高斯-赛德尔迭代法和逐次超松弛迭代法都是解线性方程组的迭代方法,它们的重点和难点以及易错点如下:

雅可比迭代法:

重点:

-

利用分量分离的思想,每次更新一个未知量。

-

迭代次数取决于迭代精度和初值。

难点和易错点:

-

雅可比迭代法的收敛速度较慢。

-

需要保证系数矩阵A是严格对角占优或严格对角占优加强条件。

-

初始猜测值的选择对迭代的结果有很大影响。

高斯-赛德尔迭代法:

重点:

-

利用分量分离的思想,每次更新一个未知量,同时使用前面已经更新过的未知量。

-

每次迭代相对于雅可比迭代法来说,都会使方程组的解更加接近真解。

难点和易错点:

-

需要保证系数矩阵A是对称正定。

-

初始猜测值的选择对迭代的结果有很大影响。

-

高斯-赛德尔迭代法的收敛速度比雅可比迭代法快,但是也存在收敛慢的情况。

迭代法收敛条件与误差估计:

重点:

-

迭代法的收敛条件是:迭代矩阵的谱半径小于1。

-

误差的收敛速度取决于迭代矩阵的谱半径和初始误差的大小。

难点和易错点:

-

对于非线性问题,需要对迭代过程进行线性化,才能利用迭代法求解。

-

迭代矩阵的谱半径的计算比较困难,需要使用一些数值方法进行计算。

-

在误差估计中,需要考虑迭代过程的收敛速度和初值误差的大小,需要进行一定的数值模拟和分析。

逐次超松弛迭代法:

重点:

-

利用松弛因子来控制每次迭代的幅度,从而加速收敛并提高迭代的精度。

-

松弛因子的取值对算法的收敛速度和精度有很大影响,需要根据具体问题来确定。

难点和易错点:

- 在每次迭代中,需要对系数矩阵进行分解,即将系数矩阵

对于逐次超松弛迭代法,重点在于了解如何选择松弛因子,以及该方法的优点和限制。难点在于如何平衡松弛因子的大小和迭代次数的选择,以达到更快的收敛速度。易错点在于松弛因子的选择过大或过小,可能会导致迭代过程出现不稳定或者发散。

对于迭代法的收敛条件和误差估计,重点在于了解不同迭代方法的收敛条件和误差估计方法,以及如何利用这些方法来判断迭代是否收敛和估计误差。难点在于如何理解不同的收敛条件和误差估计方法,并在具体问题中灵活运用。易错点在于收敛条件的判断错误或者误差估计不准确,可能会导致迭代结果的错误。

总的来说,对于这些迭代方法,重点在于理解其基本原理和算法步骤,难点在于实际问题的应用和参数的选择,易错点在于算法的稳定性和收敛性的保证。