这套环境实在是太复杂坑太多,配了大半年,今天终于终于成功了。

显卡驱动

直接用软件和更新安装470版本显卡驱动,出错几率最小。

查看安装状态

nvidia-smi

会出现显卡版本和CUDA支持

CUDA

首先感谢二位前辈的原贴:

https://blog.csdn.net/weixin_43491255/article/details/118549032

https://blog.csdn.net/a563562675/article/details/119458550

附上CUDA全家桶的下载链接

ubuntu2004,显卡驱动470,适配pytorch1.9.0的11.3 CUDA / 8.2.1CUDNN

deb1

deb2

deb3

run

ubuntu1804,显卡驱动470,适配pytorch1.9.0的11.3 CUDA / 8.2.1CUDNN

run

deb1

deb2

deb3

安装CUDA

首先在这里下载你需要的CUDA安装包(runfile格式)

由于你懂得原因,推荐用踢子打开,不然进不去。

https://developer.nvidia.com/cuda-toolkit-archive

一定要注意版本!!!

我推荐CUDA 11.3.0 + CUDNN 8.2.1 + Pytorch 1.10

这三者的组合非常麻烦,这套我亲测成功,别的搭配不敢保证。

由于你懂得原因,wget下载极慢,这里有个小技巧,把wget后面的链接复制一下,贴到能用踢子的浏览器,直接用浏览器下载。我当时大概3M/s,速度还不错。文件很大,2.8G,耐心下载。

由于你懂得原因,wget下载极慢,这里有个小技巧,把wget后面的链接复制一下,贴到能用踢子的浏览器,直接用浏览器下载。我当时大概3M/s,速度还不错。文件很大,2.8G,耐心下载。

下好之后改权限,

然后输入这个安装:

sudo sh cuda_11.3.0_465.19.01_linux.run

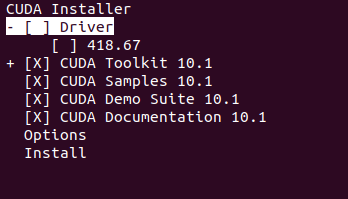

接下来会出现这个,在Driver那里按回车,不安装驱动(我们刚才已经装好驱动了),然后选Install安装。

装好之后打开环境变量

gedit ~/.bashrc

加入这两行保存,注意我这里是11.3,你如果是别的版本,要改成自己的

export PATH="/usr/local/cuda-11.3/bin:$PATH"

export LD_LIBRARY_PATH="/usr/lcoal/cuda-11.3/lib64:$LD_LIBRARY_PATH"

刷新环境变量

source ~/.bashrc

测试

终端输入

cd /usr/local/cuda-11.3/samples/1_Utilities/deviceQuery

sudo make

./deviceQuery

如果这样就说明成功了,里面显示了CUDA可用的设备信息。

CUDNN

安装

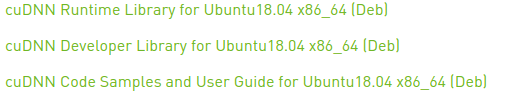

先下载三个deb包,一定要用deb,出错几率小

https://developer.nvidia.com/rdp/cudnn-archive

我的是11.3,选择里面的8.2.1 for 11.x

安装这三个包

sudo dpkg -i xxxxxxx.deb

最后安装一下依赖

sudo apt-get install libfreeimage3 libfreeimage-dev

测试

刚才有个包是cudnn自带的样例sample,运行测试一下

开始运行sample

cd /usr/src/cudnn_samples_v8

cp -r /usr/src/cudnn_samples_v8/ $HOME

cd $HOME/cudnn_samples_v8/mnistCUDNN

make clean && make

./mnistCUDNN

如果出现 Test passed,说明安装成功

查看一下cudnn版本

find / -name cudnn_version.h 2>&1 | grep -v "Permission denied"

cat /usr/include/cudnn_version.h | grep CUDNN_MAJOR -A 2

Anaconda

到清华镜像源下载安装包

https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/

下载好之后输入命令安装,记得一路选yes

bash Anaconda3-2021.05-Linux-x86_64.sh

打开condarc切换conda清华源

sudo gedit ~/.condarc

把里面的内容替换成这个。已经包括了修改defaults,TUNA官网首页的方法。

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/r

- https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

msys2: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

bioconda: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

menpo: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

pytorch: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

simpleitk: https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud

report_errors: false

auto_activate_base: false

最后创建一个虚拟环境,用来安装pytorch

conda create -n alientorch(你自己起的名字)

激活环境

activate alientorch

安装一波依赖,顺便测试一下刚才的源,如果速度很快,那么就很棒棒,一会的Pytorch也会很顺利

conda install numpy mkl cffi

Pytorch

安装

进入官网,查看你的版本对应的安装命令

https://pytorch.org/get-started/locally/

在刚才的虚拟环境里输入命令安装pytorch

在刚才的虚拟环境里输入命令安装pytorch

conda install pytorch torchvision torchaudio cudatoolkit=11.3 -c pytorch

20.04 + pytorch 1.9.0 + cuda 11.3 的指令:

conda install pytorch==1.9.0 torchvision==0.10.0 torchaudio==0.9.0 cudatoolkit=11.3 -c pytorch -c conda-forge

最新版GPU版本的:

conda install pytorch torchvision torchaudio pytorch-cuda=11.6 -c pytorch -c nvidia

CPU-Only版本的:

conda install pytorch torchvision torchaudio cpuonly -c pytorch

大家根据自己的情况从上面选一个

安装文件非常大,耐心等待即可,如果源切换成功了,这里下载会很快。

测试

进入虚拟环境,输入命令测试,大功告成!

python

import torch

torch.cuda.is_available()