文章目录

- 介绍

- 软件架构

- 版本介绍

- 更新内容

- 2023-02-19

- 2023-02-15

- 2023-02-14

- 2023-02-10

- 2022-10-20

- 2022-08-06

-

- 操作步骤

- 环境准备

-

- 解压部署包

- 修改host文件

- 脚本使用方式

- 初始化环境

-

- 安装k8s集群

-

- 组件安装

- 安装方式

- 访问prometheus

- 访问grafana

-

- ingress-nginx

- kuboard的安装

-

- 证书查看

- kubeadm 命令查看

- openssl 命令查看

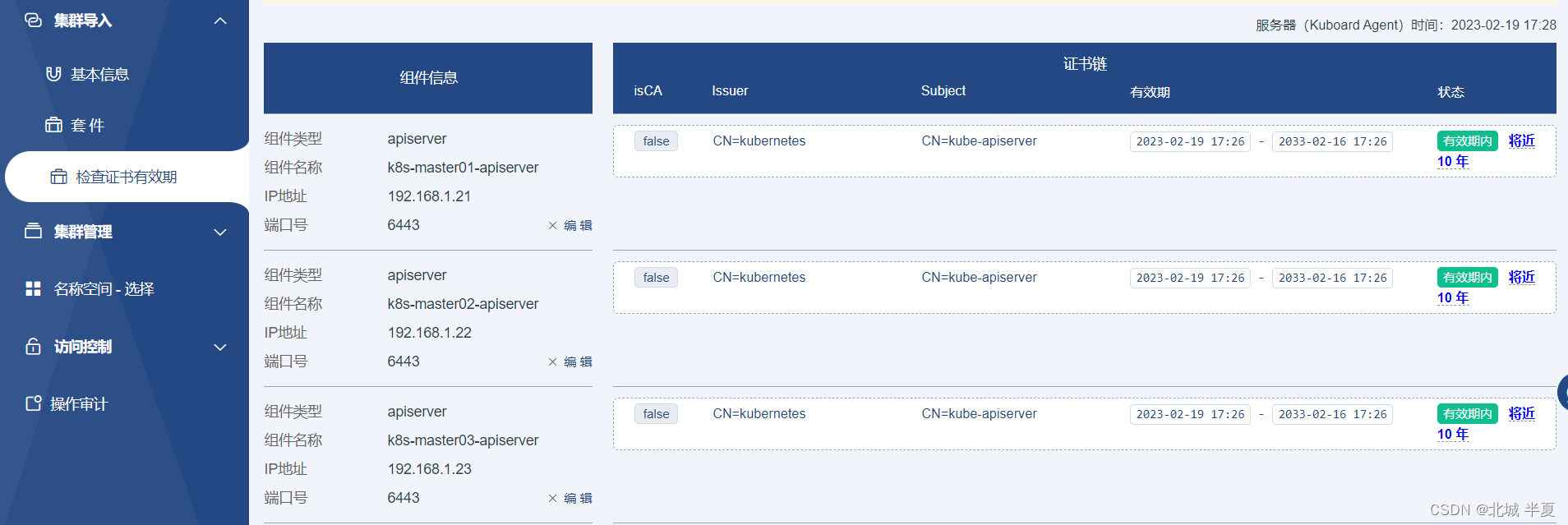

- kuboard界面查看

- 更新证书

-

- 部署包地址

- 总结

介绍

- 以1.21.1的脚本模板,重构k8s的部署方式(v1.23.7),添加私有仓库的部署及相关离线安装包的方式

- 通过kubeadm进行一键式部署k8s集群,根据不同的启动方式,可部署单节点、一主多从、多主多从高可用的k8s集群

- 通过ansible快速部署k8s的基础组件(nfs、helm、ingress、monitoring【联网|离线镜像】、kuboard【联网】)

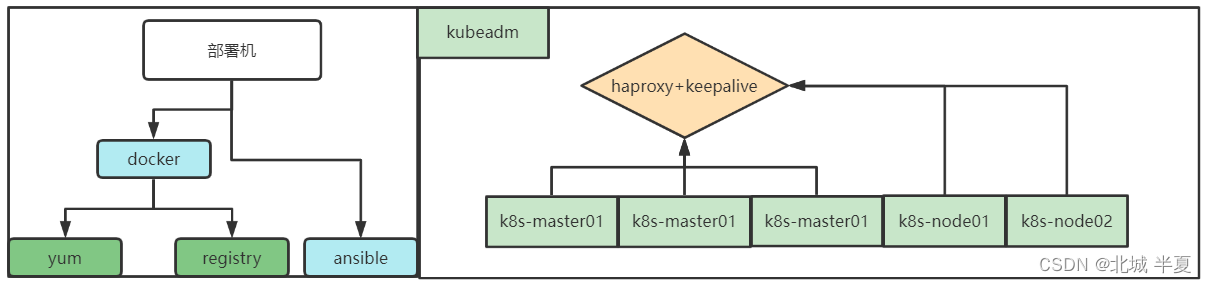

软件架构

- 通过部署包中的run.sh进行统一入口,进行初始化环境(部署节点)

- ansible+shell实现自动获取host文件中的相关信息进行自动化部署

版本介绍

- 需要提前准备多台主机,根据准备机器的多少,修改

host文件,本环境是为了开发环境中快速部署k8s集群 - 采用kubeadn安装,采用本地yum仓库,版本是:1.23.7

- 安装docker的yum源是基于Centos7.5/7.6,版本是:23.0.1

- 安装ansible时,使用离线安装,版本: 2.9.27

- 安装helm时,使用离线安装,版本: v3.8.1

- 高可用安装时:采用haproxy(1.5.18-9)+keepalived(1.3.5-19)

- 添加kuboard:v3面板的安装(ansible)主机:单节点、单容器

更新内容

2023-02-19

- 修改k8s版本及docker的版本,优化后续修改源镜像的操作

- 去除dashboard面板,添加kuboard:v3面板的安装

2023-02-15

- 离线安装helm,同时repo add 仓库(联网)

- 默认不安装,控制按钮在

host文件中的k8s_helm_enable参数 - 添加

metrics-server组件,用于实现kubectl top pod(离线安装) - 默认安装,控制按钮在

host文件中的metrics_server_enable参数

2023-02-14

- 优化监控组件,通过github上找到的yaml,结合ansible进行自动化的部署到k8s集群上

- k8s master节点的第一台机器上

/opt/deploy/grafana/node_export.json文件可以导入到grafana平台上,用于监控物理机的机器资源信息 - prometheus-k8s服务是statefulsets的服务,且有资源限制,内存400Mi,过低会导致服务无法启动

- 安装监控组件时,需要确定服务的基础设施是否符合预期

2023-02-10

- 处理内核参数有几率加载失败的情况

- 重构初始化环境的脚本,减少初始化时出现的错误

- 重写设置主机名的角色,默认删除后覆盖

/etc/hosts文件 - 新增nfs服务的安装,可以通过

storageClassName: nfs-storage字段添加pvc

- nfs目前只支持单节点部署,不支持自动化对应外部nfs

- 对接外部nfs需要手动修改对应的yaml即可,后续详细介绍

2022-10-20

- 添加kubeadm自动部署高可用版本,新增haproxy+keepalived

- 修复dashboard权限问题,添加ingress的部署方式(默认安装,通过)

- 部署包已更新至下述链接

2022-08-06

- 时间太久,忘记了。。。

准备部署包

https://download.csdn.net/download/qq_44246980/85695007

新版本未成功上传

操作步骤

环境准备

| 作用 | IP地址 | 操作系统 | 配置 |

|---|

| k8s-master01 | 192.168.1.21 | CentOS7 | 最低配置2C2G |

| k8s-master02 | 192.168.1.22 | CentOS7 | 最低配置2C2G |

| k8s-master02 | 192.168.1.23 | CentOS7 | 最低配置2C2G |

| k8s-node01 | 192.168.1.31 | CentOS7 | 最低配置2C2G |

| ansible | 192.168.1.31 | CentOS7 | 最低配置1C1G |

结构

- node节点可以填写多个,根据实际情况确认,但是不能超出单master节点的限制

- master节点至少是三个少一个都不是高可用版本

- 高可用版本

keepalived需要提前确认好vip - 建议机器处于同一网段中,或者同一局域网内

备注

- 建议单独找一台机器用于部署ansible服务,可以不接受

- 但是需要确保机器资源充足,且相关的端口不会冲突(38081【yum】、38082【registry】)

- 相关的网络关系需要提前确认

- 三台master节点,可以是2n+1台,目前因本地环境,只测试了三台master其他节点尚未涉及

解压部署包

cd /opt

yum -y install lrzsz

rz install_k8s_kubeadm_v1.23.7_20230219.tar.gz

tar -xvf install_k8s_kubeadm_v1.23.7_20230219.tar.gz

修改host文件

[deploy_server]

192.168.1.31 ansible_user="root" ansible_ssh_pass="1" ansible_ssh_port=22

[kubernetes_master]

192.168.1.21 ansible_user="root" ansible_ssh_pass="1" ansible_ssh_port=22 hostname="k8s-master01"

192.168.1.22 ansible_user="root" ansible_ssh_pass="1" ansible_ssh_port=22 hostname="k8s-master02"

192.168.1.23 ansible_user="root" ansible_ssh_pass="1" ansible_ssh_port=22 hostname="k8s-master03"

[kubernetes_node]

[nfs]

[haproxy_keepalived]

192.168.1.21 ansible_user="root" ansible_ssh_pass="1" ansible_ssh_port=22 hostname="k8s-master01"

192.168.1.22 ansible_user="root" ansible_ssh_pass="1" ansible_ssh_port=22 hostname="k8s-master02"

[docker_repositry]

[nodes:children]

kubernetes_master

kubernetes_node

[all:vars]

Number="3"

master_vip="192.168.1.120"

add_node_hosts="no"

Basic_enable="true"

set_host_enable="true"

metrics_server_enable="true"

ingress_enable="false"

k8s_nfs_enable="false"

k8s_helm_enable="false"

monitoring_enable="false"

clean_monitoring="false"

nodeExporter_enable="true"

prometheus_enable="true"

grafana_enable="true"

ControlPlane_enable="true"

prometheusAdapter_enable="true"

prometheusOperator_enable="true"

kube_state_metrics_enable="false"

alertmanager_enalbe="false"

blackboxExporter_enalbe="false"

- 一主多从需要把

kubernetes_master里只添加一个地址 - 多主多从需要把

kubernetes_master里添加三个地址,脚本只支持添加三个master节点 - 多主多从同时需要把

haproxy_keepalived角色填写

脚本使用方式

[root@registry]

[root@registry]

host images init playbook README.md run.sh yum

[root@ansible install_k8s_kubeadm]

【registry 2023-02-19 03:01:55】 sh run.sh init 初始化环境

----------------------------------------------------------------------------

【registry 2023-02-19 03:01:55】 sh run.sh online 在线安装(kuboard、monitoring组件)

【registry 2023-02-19 03:01:55】 sh run.sh offline 离线安装k8s(1.23.7)

----------------------------------------------------------------------------

【registry 2023-02-19 03:01:55】 sh run.sh ping 验证ansible的主机清单信息(ping)

【registry 2023-02-19 03:01:55】 sh run.sh install 通过host文件进行组件的单独安装

----------------------------------------------------------------------------

【registry 2023-02-19 03:01:55】 sh run.sh load offline 保存离线镜像包(monitoring组件)

【registry 2023-02-19 03:01:55】 sh run.sh load warehouse 导入上面保存的组件

【registry 2023-02-19 03:01:55】 sh run.sh load help 帮助信息

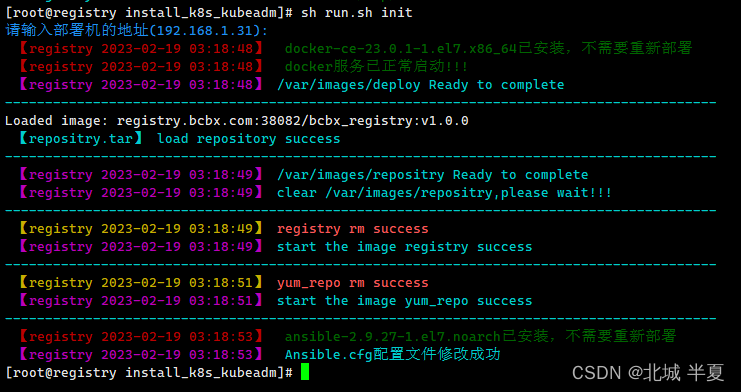

初始化环境

[root@registry install_k8s_kubeadm]

Online(在线) Dashboard

----------------------------------------------------------------------------

1) 初始化环境(ansible))

2) 安装k8s集群[一主多从](1.23.7)

3) 安装k8s集群[多主多从](1.23.7)

4) 添加k8s node节点(1.23.7)

5) 更新k8s certs,续费10年(1.23.7)

----------------------------------------------------------------------------

6) docker安装kuboard(v3)[在线安装]

7) k8s安装其他组件(nfs、monitoring、ingress)[在线安装]

----------------------------------------------------------------------------

请输入对应的数字编号:1

请输入部署机的地址(192.168.1.31):

【registry 2023-02-19 03:01:24】 docker-ce-23.0.1-1.el7.x86_64已安装,不需要重新部署

【registry 2023-02-19 03:01:24】 docker服务已正常启动!!!

【registry 2023-02-19 03:01:24】 /var/images/deploy Ready to complete

-----------------------------------------------------------------------------------------

Loaded image: registry.bcbx.com:38082/bcbx_registry:v1.0.0

【repositry.tar】 load repository success

-----------------------------------------------------------------------------------------

【registry 2023-02-19 03:01:25】 /var/images/repositry Ready to complete

【registry 2023-02-19 03:01:25】 clear /var/images/repositry,please wait!!!

-----------------------------------------------------------------------------------------

【registry 2023-02-19 03:01:25】 registry rm success

【registry 2023-02-19 03:01:25】 start the image registry success

-----------------------------------------------------------------------------------------

【registry 2023-02-19 03:01:27】 yum_repo rm success

【registry 2023-02-19 03:01:27】 start the image yum_repo success

-----------------------------------------------------------------------------------------

【registry 2023-02-19 03:01:29】 ansible-2.9.27-1.el7.noarch已安装,不需要重新部署

【registry 2023-02-19 03:01:29】 Ansible.cfg配置文件修改成功

出现上述错误,则重新执行一下

结果如下

- 安装docker服务

- 安装ansible服务,修改配置文件

- 准备离线yum仓库

- 准备离线registry仓库,相关挂载点是:/var/images/

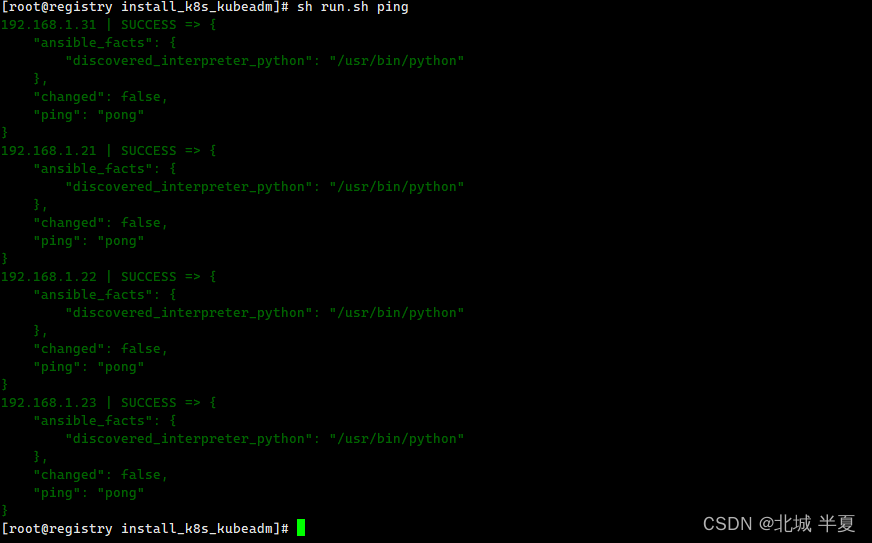

验证ansible配置

sh run.sh ping

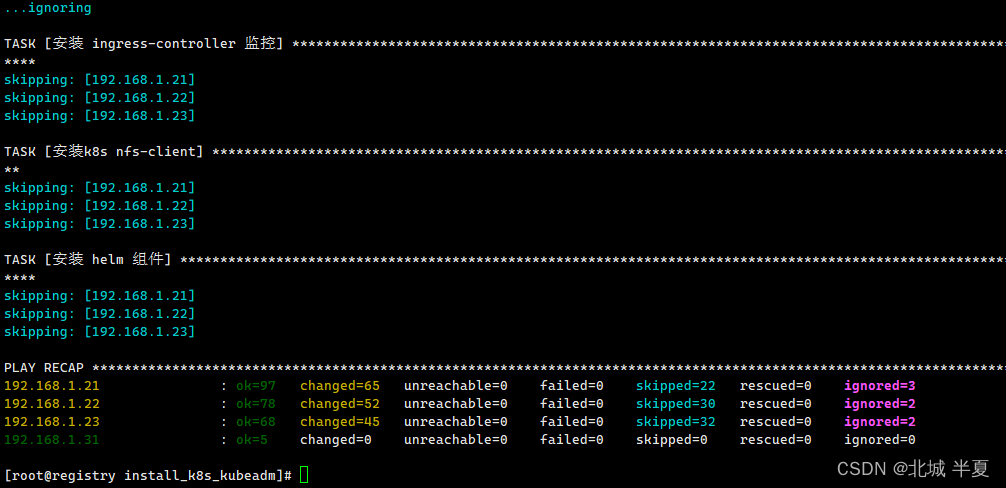

安装k8s集群

[root@registry install_k8s_kubeadm]

Online(在线) Dashboard

----------------------------------------------------------------------------

1) 初始化环境(ansible))

2) 安装k8s集群[一主多从](1.23.7)

3) 安装k8s集群[多主多从](1.23.7)

4) 添加k8s node节点(1.23.7)

5) 更新k8s certs,续费10年(1.23.7)

----------------------------------------------------------------------------

6) docker安装kuboard(v3)[在线安装]

7) k8s安装其他组件(nfs、monitoring、ingress)[在线安装]

----------------------------------------------------------------------------

请输入对应的数字编号:3

执行结果如下:

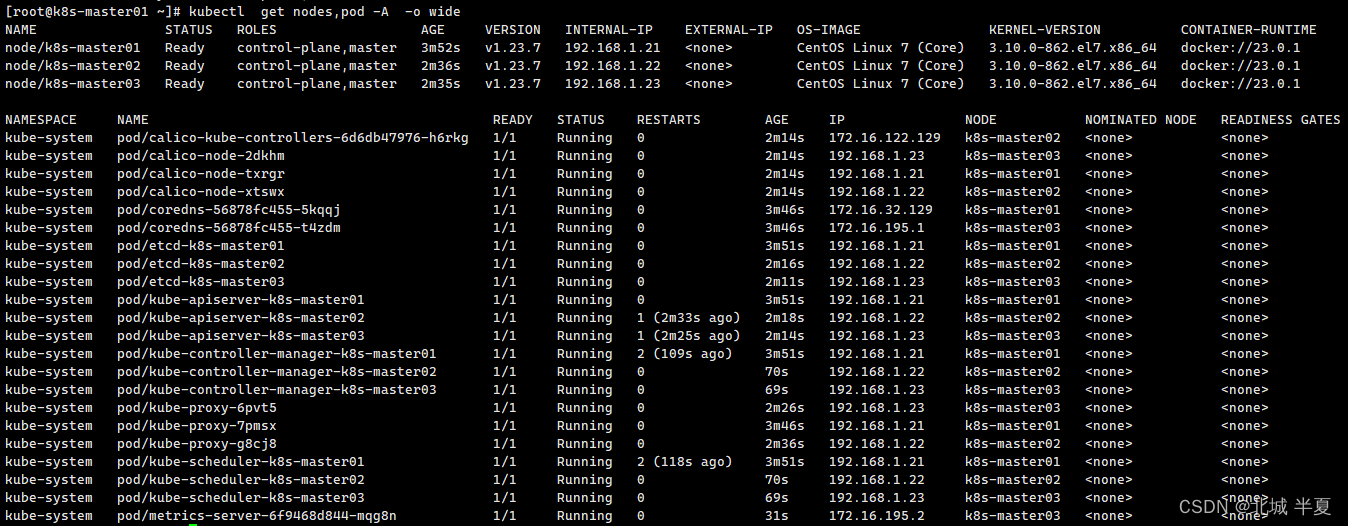

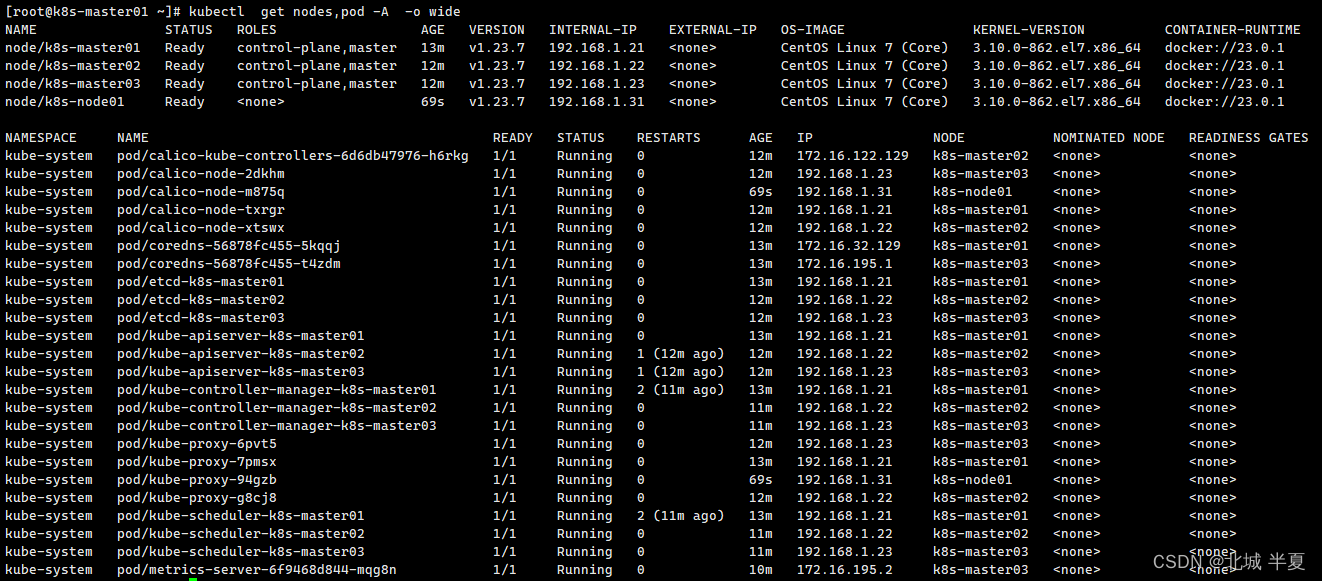

登录master的节点

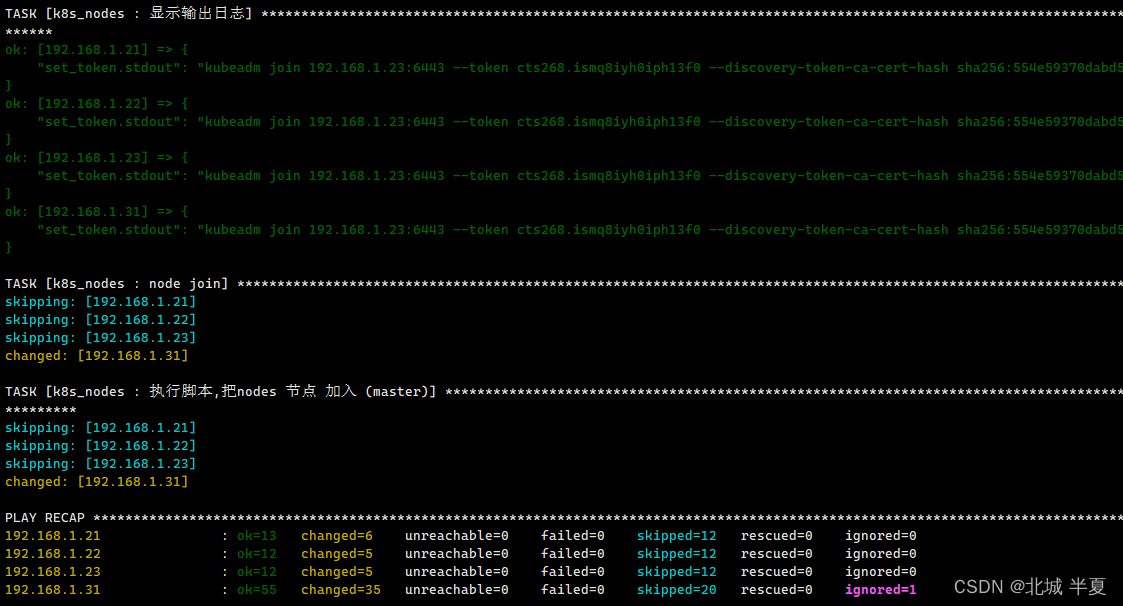

添加node节点

- 在host文件下的kubernetes_node分组下添加新增的需要新增的节点,并把之前已添加的节点删除

- 修改后执行 sh run.sh online脚本,选择4,添加node节点

- 脚本正常执行完毕后,检查各个节点的/etc/hosts文件,如果确认对应的域名解析,需要手动添加对应的主机关系

- 注意:每次添加node节点时,需要把已填入集群的节点手动删除,否则会出现重复加入的操作导致剧本执行失败

sh run.sh online

master节点状态检查

组件安装

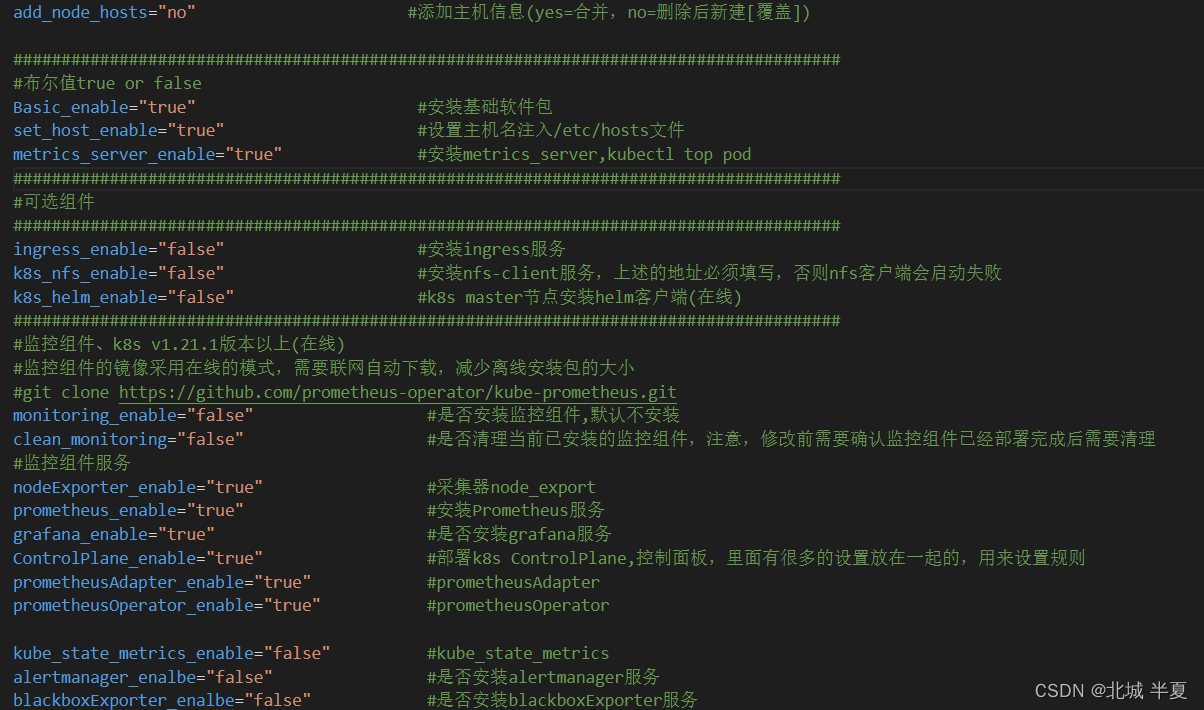

- 默认不安装,手动修改后安装,可以在按照k8s集群后进行安装使用

- 也可以在安装集群的是否安装

安装方式

[root@k8s-node01 install_k8s_kubeadm]

- 需要前修改上述图片中的布尔值,改为true时,开始执行安装

- 因本地环境资源不足,不做演示截图

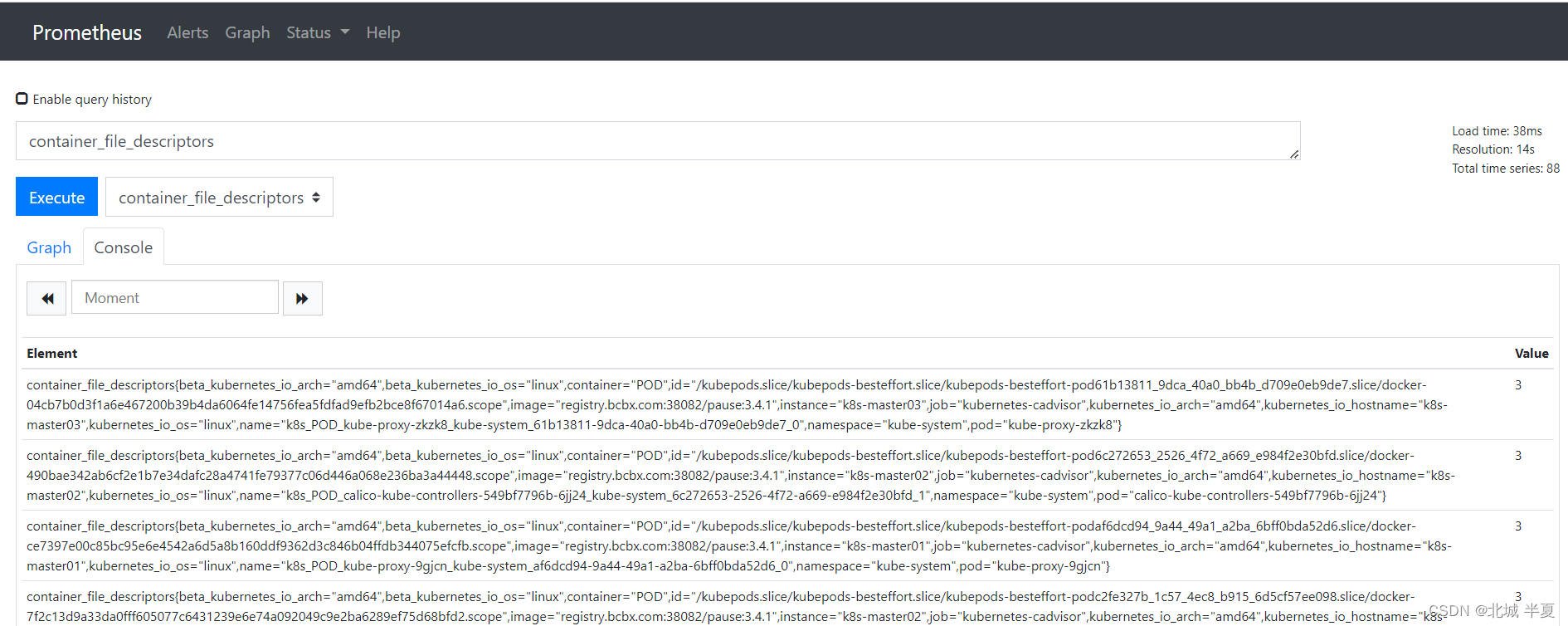

访问prometheus

访问地址: http://k8s-ip:30090/

访问grafana

访问地址: http://k8s-ip:30000/

登陆密码: admin/admin

添加node-exporter面板

- 下载k8s master节点的第一台机器上

/opt/deploy/grafana/node_export.json文件 - 通过浏览器登陆grafana平台,通过Dashboards按钮,鼠标停放,选择import

- 出现导入界面,选择upload json file按钮,选择下载到本地的文件

- 其他都是自动填充的,最后一个选择prometheus data source数据源后点击导入即可

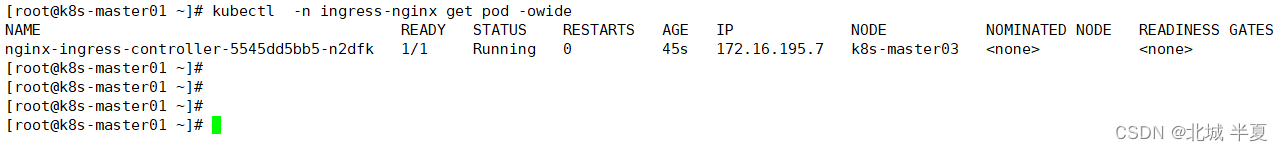

ingress-nginx

使用方式,自行百度

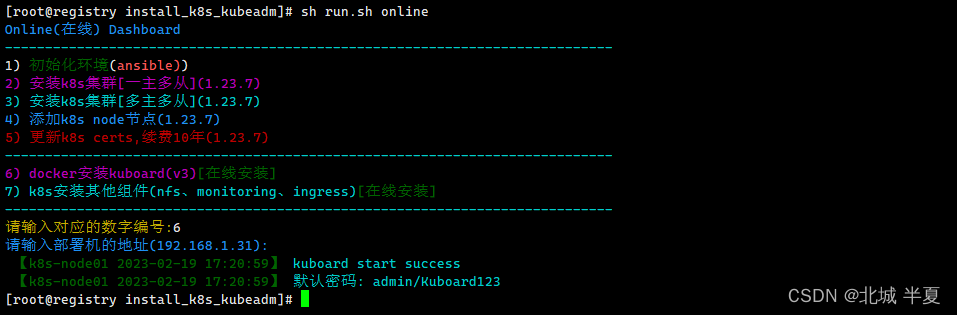

kuboard的安装

docker pull swr.cn-east-2.myhuaweicloud.com/kuboard/kuboard:v3

docker save swr.cn-east-2.myhuaweicloud.com/kuboard/kuboard:v3 -i kuboard.tar.gz

docker load -i kuboard.tar.gz

[root@registry ~]

2d8252e11370: Loading layer [==================================================>] 3.072kB/3.072kB

22d9813f1d6a: Loading layer [==================================================>] 9.216kB/9.216kB

331120fa4807: Loading layer [==================================================>] 23.75MB/23.75MB

b6e875ecbb12: Loading layer [==================================================>] 18.77MB/18.77MB

9b6a33d74d53: Loading layer [==================================================>] 42.52MB/42.52MB

87405db6d205: Loading layer [==================================================>] 2.024MB/2.024MB

c502deb85597: Loading layer [==================================================>] 28.67kB/28.67kB

f062a9dd21ed: Loading layer [==================================================>] 61.95kB/61.95kB

20f6f032efed: Loading layer [==================================================>] 42.06MB/42.06MB

ba47fe085ef6: Loading layer [==================================================>] 13.32MB/13.32MB

Loaded image: swr.cn-east-2.myhuaweicloud.com/kuboard/kuboard:v3

[root@registry install_k8s_kubeadm]

访问kuboard

http://ansible-ip:18080

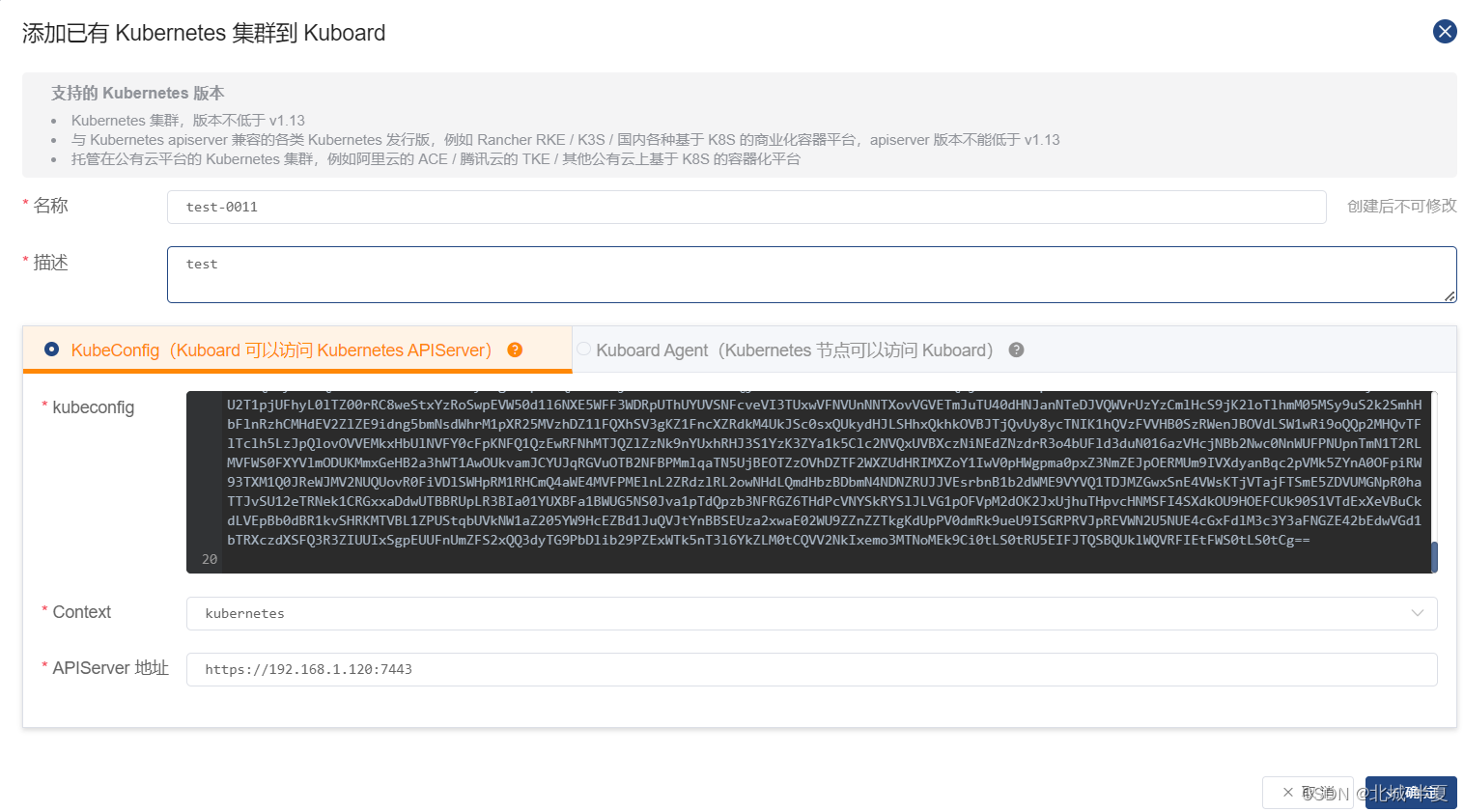

纳管集群

- 详细功能请查看kuboard的官方

- https://www.kuboard.cn/

证书查看

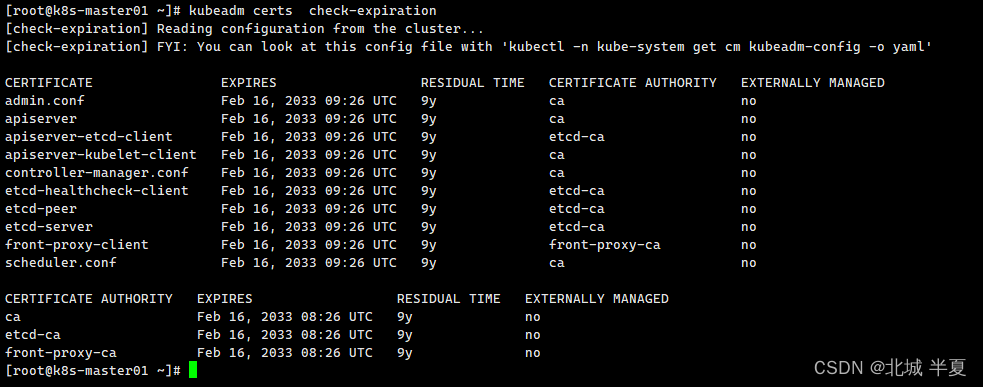

kubeadm 命令查看

kubeadm alpha certs check-expiration

kubeadm certs check-expiration

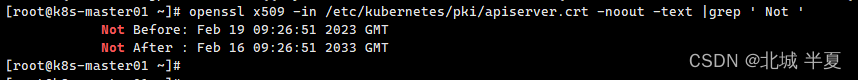

openssl 命令查看

openssl x509 -in /etc/kubernetes/pki/apiserver.crt -noout -text |grep ' Not '

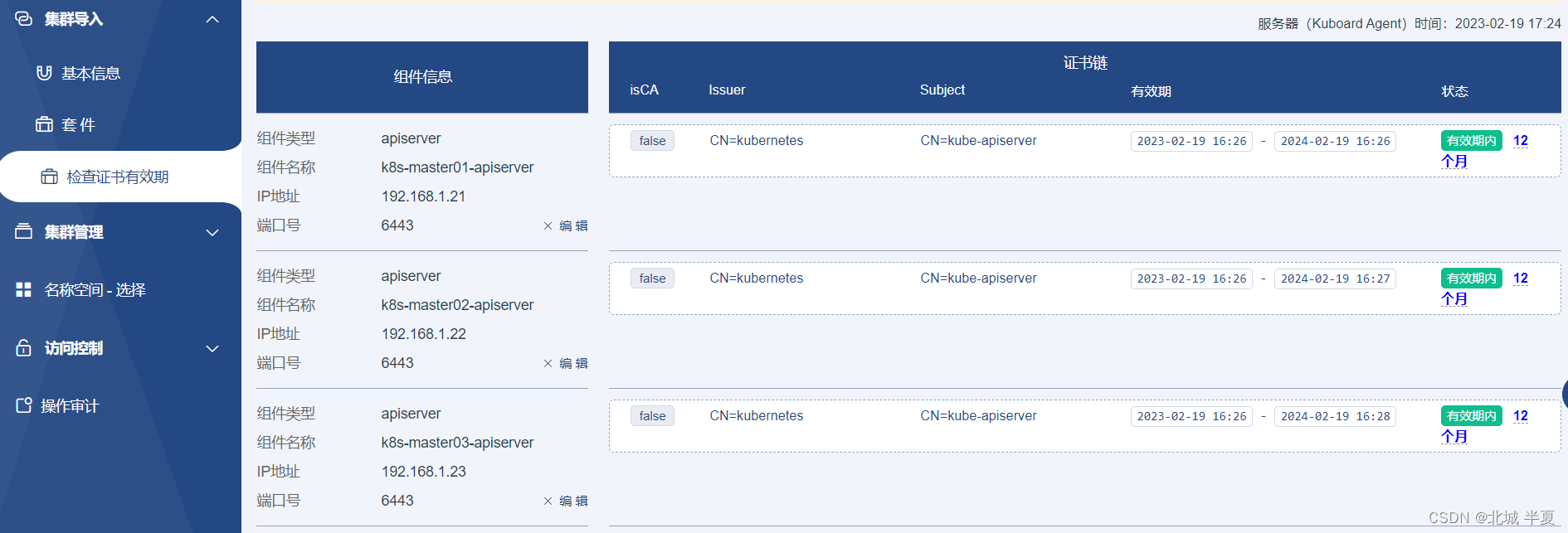

kuboard界面查看

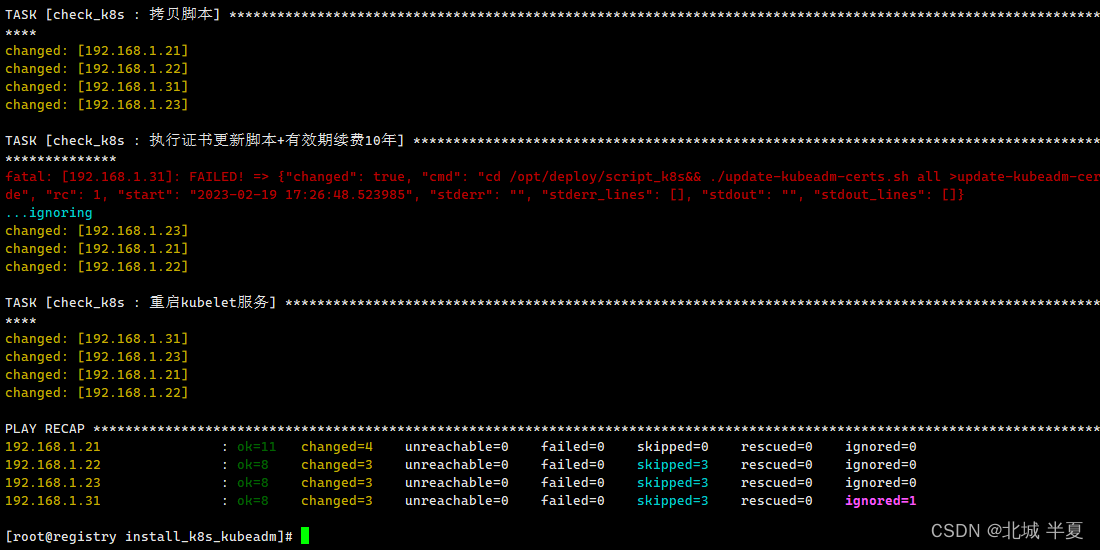

更新证书

Kubenetes通过脚本自动更新证书有效期脚本来源

[root@registry install_k8s_kubeadm]

Online(在线) Dashboard

----------------------------------------------------------------------------

1) 初始化环境(ansible))

2) 安装k8s集群[一主多从](1.23.7)

3) 安装k8s集群[多主多从](1.23.7)

4) 添加k8s node节点(1.23.7)

5) 更新k8s certs,续费10年(1.23.7)

----------------------------------------------------------------------------

6) docker安装kuboard(v3)[在线安装]

7) k8s安装其他组件(nfs、monitoring、ingress)[在线安装]

----------------------------------------------------------------------------

请输入对应的数字编号:5

验证证书有效期

部署包地址

链接:https://pan.baidu.com/s/1Q31dwjvQJVZOZWxbR4Uv7w?pwd=bcbx

提取码:bcbx

总结

- 上述则是当前部署中可运行正常的服务

- 执行

sh Run.sh init,则可以调试脚本,对应的启动文件,修改,则可以进行调试 - 执行

sh Run.sh install,修改host文件,则可以进行安装组件

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)