•DKT:Deep knowledge tracing. In Advances in neural information processing systems.这是一种开创性的方法,它使用单层LSTM模型来预测学生的表现。在我们的DKT实现中,我们使用规范裁剪和提前停止来提高性能,

•SAKT:A Self-Attentive model for Knowledge Tracing. arXiv preprint arXiv:1907.06837该模型利用自我注意机制[37]为先前回答的练习分配权重,以预测学生在特定练习中的表现。

•DKVMN:2017 Dynamic key-value memory networks for knowledge tracing. In Proceedings of the 26th international conference on World Wide Web.这是一种基于记忆增强的递归神经网络方法,其中不同KC之间的关系用键矩阵表示,学生对每个KC的掌握程度用值矩阵表示。

•DKT+ Forget:Augmenting Knowledge Tracing by Considering Forgetting Behavior. In The World Wide Web Conference.这是DKT方法的一个扩展,它利用学生的学习顺序和模糊行为来预测学生的表现。

•EERNN:Exercise-enhanced sequential modeling for student performance prediction. In Thirty-Second AAAI Conference on Artificial Intelligence.该模型利用练习的文本内容和学生的练习记录来预测学生的表现。他们以RNN为基础模型学习习题嵌入和学生知识表示。此外,他们利用过去互动和下一个练习之间的余弦相似性来参与过去的互动。

•EKT: EKT: Exercise-aware Knowledge Tracing for Student Performance Prediction. arXiv preprint arXiv:1906.05658 (2019).该模型是EERN模型的扩展,该模型还跟踪学生对多种技能的知识获取。具体地说,它对底层知识概念之间的关系进行建模,以增强EERN模型。

viaPrediction-Consistent Regularization

Chun-Kit Yeung等人在2018年6月发表论文中指出DKT模型现存的缺点,即对输入序列存在重构问题和预测结果的波动性,进而论文提出了改善上述问题的方法:增加对应的正则项,得到DKT+(增强的DKT模型)。

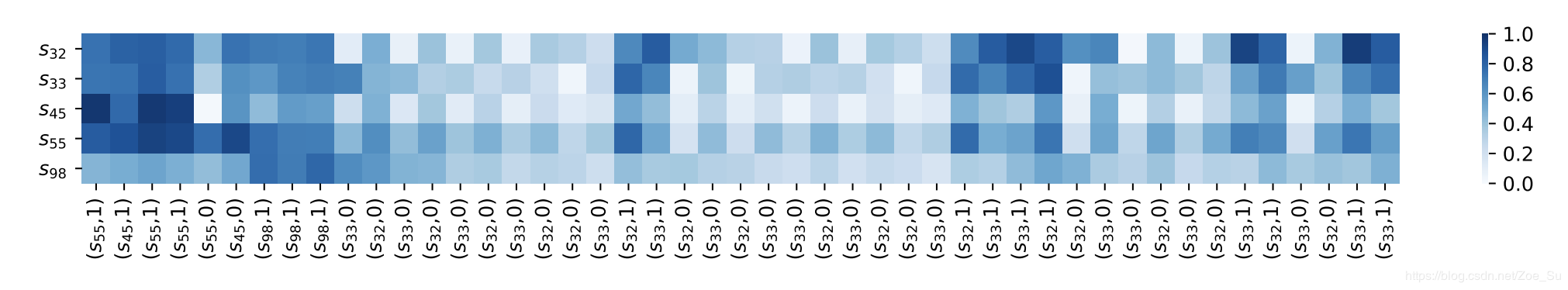

如上图所示,纵轴SiSi表示知识成分,横轴为学生在各个知识成分上的答题情况。

问题一,在图1中的第6个时间步,与上一个时间步相比,正确回答s45相关练习的概率增加,即使学生回答s45不正确。

问题二,我们观察到,预测输出的转变,即学生的知识状态,跨时间步是不一致的。如图1所示,一些技能的预期表现在时间步长上会出现突然的波动和骤降。例如,当学生在学习序列的中间回答s32和s33时,正确回答s32、s33、s45和s55的概率波动。这在直觉上是不可取的,也是不合理的,因为学生的知识状态会随着时间的推移逐渐过渡,但不会在已掌握和尚未掌握之间交替。因此,这种波浪式的转换是不有利的,因为它会误导学生对知识状态的理解。

对于问题1,作者认为出现这种情况是由于,在DKT模型采用的损失函数中并没有考虑到时间t时刻的输入值,只是考虑了t时刻的输出值和t+1时刻的输入值。为了解决上述问题,作者在损失函数中引入正则项,并在正则项中引入了时间t时刻的输入值,正则项r如下:

对于问题2,作者认为可能是由于RNN的隐层表示问题,RNN的隐含层htht依赖于前一隐含层的输出ht−1ht−1和当前输入xtxt,隐含层表示了潜在的学生知识掌握程度,但是很难说清隐含层的每个状态是如何影响对知识成分的预测。所以简答起见,直接对输出结果进行正则约束(L1,L2正则),使预测结果能够平滑输出,所加正则项如下:

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)