在安装HBase之前你需要先安装Hadoop和Zookeeper,如果你还没有安装可以通过这两个实训来学习:Hadoop安装与配置,Zookeeper安装与配置。 本次实训的环境已经默认安装好了Hadoop,接下来我们就开始安装配置HBase吧。

HBase安装

HBase的安装也分为三种,单机版、伪分布式、分布式;我们先来安装单机版。

单机版安装

首先我们去官网下载好HBase的安装包;

接下来,将压缩包解压缩到你想安装的目录(安装包在平台已经下载好了,在/opt目录下,无需你再进行下载,我们统一将HBase解压到/app目录下):

mkdir /app

cd /opt

ulimit -f 1000000

tar -zxvf hbase-2.1.1-bin.tar.gz -C /app

安装单机版很简单,我们只需要配置JDK的路径即可,我们将JDK的路径配置到conf/下的

cd /app/hbase-2.1.1/conf

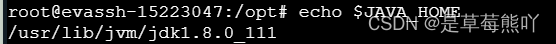

我们先来复制JAVA_HOME的路径,以方便之后的配置:

echo $JAVA_HOME

接着我们编辑`HBase conf`目录下的`hbase-env.sh`文件,将其中的`JAVA_HOME`指向到你`Java`的安装目录,最后保存设置:

vim /app/hbase-2.1.1/conf/hbase-env.sh

export JAVA_HOME=/usr/lib/jvm/jdk.1.8.0_111

然后编辑hbase-site.xml文件,在<configuration>标签中添加如下内容:

<configuration>

<property>

<name>hbase.rootdir</name>

<value>file:///root/data/hbase/data</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/root/data/hbase/zookeeper</value>

</property>

<property>

<name>hbase.unsafe.stream.capability.enforce</name>

<value>false</value>

</property>

</configuration>

以上各参数的解释:

-

hbase.rootdir:这个目录是region server的共享目录,用来持久化Hbase。URL需要是'完全正确'的,还要包含文件系统的scheme。例如,要表示hdfs中的 /hbase目录,namenode 运行在namenode.example.org的9090端口。则需要设置为hdfs://namenode.example.org:9000 /hbase。默认情况下Hbase是写到/tmp的。不改这个配置,数据会在重启的时候丢失;

-

hbase.zookeeper.property.dataDir:ZooKeeper的zoo.conf中的配置。快照的存储位置,默认是:${hbase.tmp.dir}/zookeeper;

-

hbase.unsafe.stream.capability.enforce:控制HBase是否检查流功能(hflush / hsync),如果您打算在rootdir表示的LocalFileSystem上运行,那就禁用此选项。

配置好了之后我们就可以启动HBase了,在启动之前我们可以将Hbase的bin目录配置到/etc/profile中,这样更方便我们以后操作。 在etc/profile的文件末尾添加如下内容:

#vi /etc/profile

# SET HBASE_enviroment

HBASE_HOME=/app/hbase-2.1.1

export PATH=$PATH:$HBASE_HOME/bin

HBASE_HOME为你自己本机Hbase的地址。

source /etc/profile

使刚刚的配置生效。

接下来我们就可以运行HBase来初步的体验它的功能了:

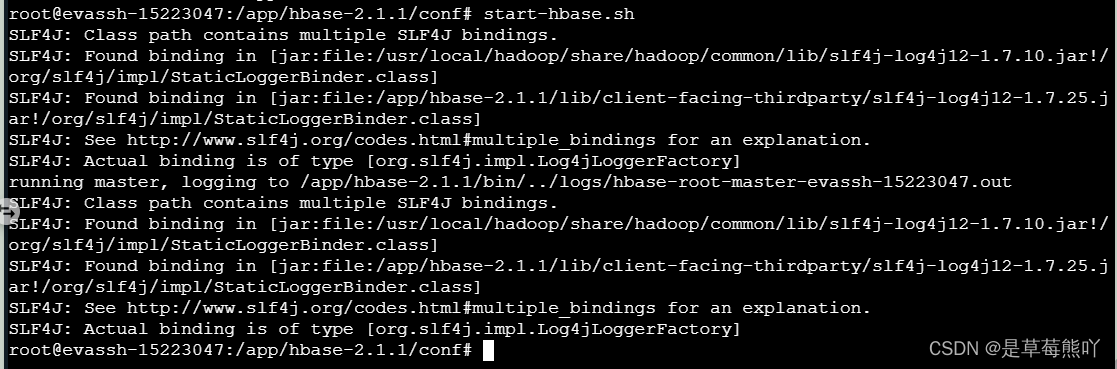

在命令行输入start-hbase.sh来启动HBase,接着输入jps查看是否启动成功,出现了HMaster进程即表示启动成功了。

启动成功之后,咱们就可以对Hbase进行一些基本的操作了。

在之后的实训中,我们将会实现伪分布式与分布式HBase数据库的安装。

编程要求

根据上述步骤安装配置好HBase数据库,并启动成功。