| 序号 | 主机 | 主机名 | 系统 | 配置 | 备注 |

| 1 | 192.168.3.146 192.168.8.146 | node1 | rocky8.6最小化安装 | /sda 40g /sdb 20g /sdc 20g /sdd 20g | |

| 2 | 192.168.3.147 192.168.8.147 | node2 | rocky8.6最小化安装 | /sda 40g /sdb 20g /sdc 20g /sdd 20g | |

| 3 | 192.168.3.148 192.168.8.148 | node3 | rocky8.6最小化安装 | /sda 40g /sdb 20g /sdc 20g /sdd 20g | |

1、环境准备(三台)

关闭selinux 及防火墙

sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config

systemctl disable firewalld

systemctl stop firewalld

更改yum源为阿里云

sed -e 's|^mirrorlist=|#mirrorlist=|g' \

-e 's|^#baseurl=http://dl.rockylinux.org/$contentdir|baseurl=https://mirrors.aliyun.com/rockylinux|g' \

-i.bak \

/etc/yum.repos.d/Rocky-*.repo

dnf makecache

安装软件包(可选)

yum install -y wget bash-completion net-tools vim

安装epel源及ceph源

yum install -y https://mirrors.aliyun.com/epel/epel-release-latest-8.noarch.rpm

sed -i 's|^#baseurl=https://download.example/pub|baseurl=https://mirrors.aliyun.com|' /etc/yum.repos.d/epel*

sed -i 's|^metalink|#metalink|' /etc/yum.repos.d/epel*

vim /etc/yum.repos.d/ceph.repo

[ceph-norch]

name=ceph-norch

baseurl=https://mirrors.aliyun.com/ceph/rpm-quincy/el8/noarch/

enable=1

gpgcheck=0

[ceph-x86_64]

name=ceph-x86_64

baseurl=https://mirrors.aliyun.com/ceph/rpm-quincy/el8/x86_64/

enable=1

gpgcheck=0

[ceph-source]

name=ceph-source

baseurl=https://mirrors.aliyun.com/ceph/rpm-quincy/el8/SRPMS/

enable=1

gpgcheck=0

dnf makecache

在/etc/hosts 填加如下行

192.168.3.146 node1

192.168.3.147 node2

192.168.3.148 node3

192.168.8.146 node1

192.168.8.147 node2

192.168.8.148 node3

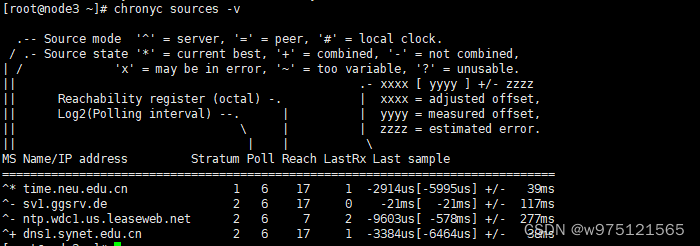

配置时间同步

dnf install -y chrony

systemctl enable --now chronyd

chronyc sources -v

配置免密登录(可选)

ssh-keygen

ssh-copy-id node1

ssh-copy-id node2

ssh-copy-id node3

for host in node1 node2 node3;do ssh root@$host date;done

安装docker

dnf -y install docker

2、安装ceph(node1)

安装cephadm

dnf -y install cephadm

cephadm -h

初始化集群

cephadm bootstrap --mon-ip 192.168.3.146 --cluster-network 192.168.8.0/24

集群初如化成功

sudo /usr/sbin/cephadm shell --fsid fc0ce88c-2f6d-11ed-b23c-000c293e2d96 -c /etc/ceph/ceph.conf -k /etc/ceph/ceph.client.admin.keyring

ceph -s

ceph version

也可退出容器执行

cephadm shell ceph -s

三台服务器安装 ceph-common

dnf -y install ceph-common

安装完毕后,退出容器可执行命令ceph -s

key 文件:

cat /etc/ceph/ceph.client.admin.keyring

[client.admin]

key = AQDH2RljgCNXBRAAKaOpbXMB6hD9G3uVC9KRYQ==

caps mds = "allow *"

caps mgr = "allow *"

caps mon = "allow *"

caps osd = "allow *"

docker ps

加入node2 node3

ssh-copy-id -f -i /etc/ceph/ceph.pub node2

ssh-copy-id -f -i /etc/ceph/ceph.pub node3

ceph orch host ls

ceph orch host add node2 192.168.3.147

ceph orch host add node3 192.168.3.148

ceph orch host ls

填加标签

ceph orch host label add node2 _admin

ceph orch host label add node3 _admin

mon mgr填加节点后会自动部署

web登陆查看

填加OSD

ceph orch daemon add osd node1:/dev/sdb,/dev/sdc

ceph orch daemon add osd node2:/dev/sdb,/dev/sdc

ceph orch daemon add osd node3:/dev/sdb,/dev/sdc

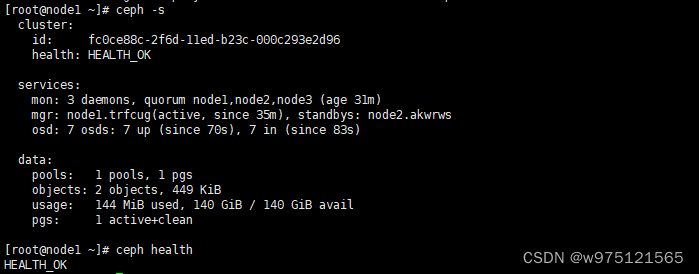

检查集群状态

ceph -s

ceph health

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)