我明明配置了3个节点的datanode,但是在

http://mini2:50070/dfshealth.html#tab-overview

的管理界面了只看到两天存活

Live Nodes 为 2,

Dead Nodes 为 0

我想就算有一台挂掉也不应该是这样,Dead Nodes 应该为 1才对,

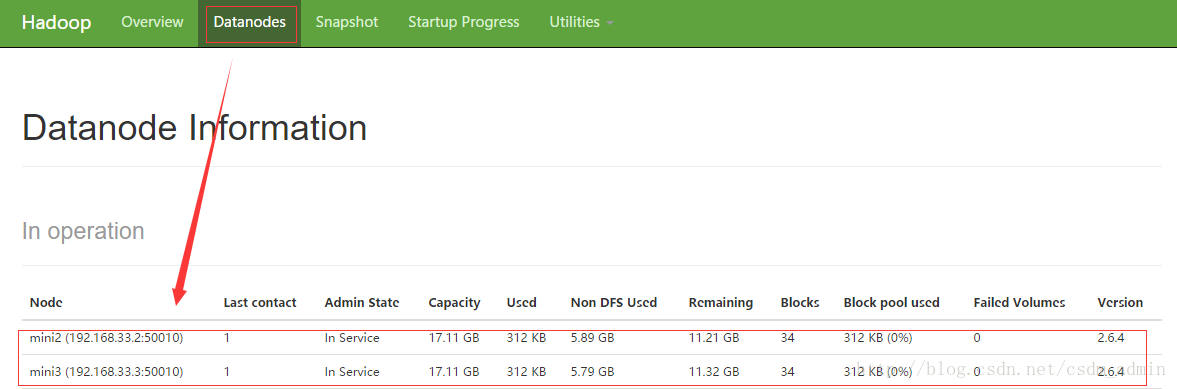

然后我切换到Datanodes界面查看:

发现mini2和mini3存活, 我就刷新了几下, 发现变成了mini3和mini4存活了, 我一直刷呀刷,发现有mini2就没有mini4,有mini4就没有mini2, mini2与mini4互相排斥,

然后我上传了一个文件,结果mini2挂掉了 , 经过排查发现是我的

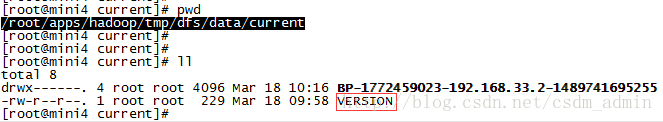

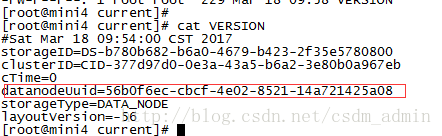

/root/apps/hadoop/tmp/dfs/data/current目录下了VERSION文件里:

mini2和mini4的 datanodeUuid是一样的,哦明白了,datanodeUuid冲突了, 解决方法:把mini4的VERSION文件删除,重启datanode, OK, 搞定..!

停止: hadoop-daemon.sh stop datanode

启动: hadoop-daemon.sh start datanode