最近想使用YOLOv5模型训练自己的数据集,但是没有GPU。。。。。所以白嫖一下Google的Colab。

第一:制作自己的数据集

这里给出一篇自己看过的博客写和博主自制的视频,我觉得讲的挺好,数据集方面不太懂得可以看看。文章:目标检测---利用labelimg制作自己的深度学习目标检测数据集_didiaopao的博客-CSDN博客

视频:手把手教你搭建自己的yolov5目标检测平台_哔哩哔哩_bilibili(视频包括数据集制作,数据集转换)

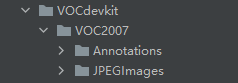

图片是使用 labelimg工具进行标注的,自制数据集的格式如下:

JPEGImage 存放需要打标签的图片文件

Annotations 存放标注的标签文件

其他的文件夹可以忽略,现在我们的数据集是VOC格式的,标注文件的后缀是xml,YOLOv5网络模型需要YOLO格式的数据值,所以下面需要将VOC格式转换为YOLO格式,并且将数据集中的图片分为训练集和验证集,这里也给出一个参考的博客:目标检测---数据集格式转化及训练集和验证集划分_didiaopao的博客-CSDN博客

数据集格式转换的代码如下,需要新建一个py文件将代码拷贝进去,运行一下就可以了(注意需要将classes改为自己要检测的类)

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

import random

from shutil import copyfile

classes = ["hat", "person"]

#改成自己的类

#classes=["ball"]

TRAIN_RATIO = 80

def clear_hidden_files(path):

dir_list = os.listdir(path)

for i in dir_list:

abspath = os.path.join(os.path.abspath(path), i)

if os.path.isfile(abspath):

if i.startswith("._"):

os.remove(abspath)

else:

clear_hidden_files(abspath)

def convert(size, box):

dw = 1./size[0]

dh = 1./size[1]

x = (box[0] + box[1])/2.0

y = (box[2] + box[3])/2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x*dw

w = w*dw

y = y*dh

h = h*dh

return (x,y,w,h)

def convert_annotation(image_id):

in_file = open('VOCdevkit/VOC2007/Annotations/%s.xml' %image_id)

out_file = open('VOCdevkit/VOC2007/YOLOLabels/%s.txt' %image_id, 'w')

tree=ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text), float(xmlbox.find('ymax').text))

bb = convert((w,h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

in_file.close()

out_file.close()

wd = os.getcwd()

wd = os.getcwd()

data_base_dir = os.path.join(wd, "VOCdevkit/")

if not os.path.isdir(data_base_dir):

os.mkdir(data_base_dir)

work_sapce_dir = os.path.join(data_base_dir, "VOC2007/")

if not os.path.isdir(work_sapce_dir):

os.mkdir(work_sapce_dir)

annotation_dir = os.path.join(work_sapce_dir, "Annotations/")

if not os.path.isdir(annotation_dir):

os.mkdir(annotation_dir)

clear_hidden_files(annotation_dir)

image_dir = os.path.join(work_sapce_dir, "JPEGImages/")

if not os.path.isdir(image_dir):

os.mkdir(image_dir)

clear_hidden_files(image_dir)

yolo_labels_dir = os.path.join(work_sapce_dir, "YOLOLabels/")

if not os.path.isdir(yolo_labels_dir):

os.mkdir(yolo_labels_dir)

clear_hidden_files(yolo_labels_dir)

yolov5_images_dir = os.path.join(data_base_dir, "images/")

if not os.path.isdir(yolov5_images_dir):

os.mkdir(yolov5_images_dir)

clear_hidden_files(yolov5_images_dir)

yolov5_labels_dir = os.path.join(data_base_dir, "labels/")

if not os.path.isdir(yolov5_labels_dir):

os.mkdir(yolov5_labels_dir)

clear_hidden_files(yolov5_labels_dir)

yolov5_images_train_dir = os.path.join(yolov5_images_dir, "train/")

if not os.path.isdir(yolov5_images_train_dir):

os.mkdir(yolov5_images_train_dir)

clear_hidden_files(yolov5_images_train_dir)

yolov5_images_test_dir = os.path.join(yolov5_images_dir, "val/")

if not os.path.isdir(yolov5_images_test_dir):

os.mkdir(yolov5_images_test_dir)

clear_hidden_files(yolov5_images_test_dir)

yolov5_labels_train_dir = os.path.join(yolov5_labels_dir, "train/")

if not os.path.isdir(yolov5_labels_train_dir):

os.mkdir(yolov5_labels_train_dir)

clear_hidden_files(yolov5_labels_train_dir)

yolov5_labels_test_dir = os.path.join(yolov5_labels_dir, "val/")

if not os.path.isdir(yolov5_labels_test_dir):

os.mkdir(yolov5_labels_test_dir)

clear_hidden_files(yolov5_labels_test_dir)

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'w')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'w')

train_file.close()

test_file.close()

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'a')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'a')

list_imgs = os.listdir(image_dir) # list image files

prob = random.randint(1, 100)

print("Probability: %d" % prob)

for i in range(0,len(list_imgs)):

path = os.path.join(image_dir,list_imgs[i])

if os.path.isfile(path):

image_path = image_dir + list_imgs[i]

voc_path = list_imgs[i]

(nameWithoutExtention, extention) = os.path.splitext(os.path.basename(image_path))

(voc_nameWithoutExtention, voc_extention) = os.path.splitext(os.path.basename(voc_path))

annotation_name = nameWithoutExtention + '.xml'

annotation_path = os.path.join(annotation_dir, annotation_name)

label_name = nameWithoutExtention + '.txt'

label_path = os.path.join(yolo_labels_dir, label_name)

prob = random.randint(1, 100)

print("Probability: %d" % prob)

if(prob < TRAIN_RATIO): # train dataset

if os.path.exists(annotation_path):

train_file.write(image_path + '\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_train_dir + voc_path)

copyfile(label_path, yolov5_labels_train_dir + label_name)

else: # test dataset

if os.path.exists(annotation_path):

test_file.write(image_path + '\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_test_dir + voc_path)

copyfile(label_path, yolov5_labels_test_dir + label_name)

train_file.close()

test_file.close()

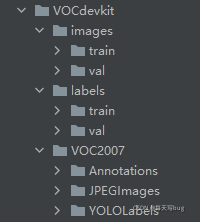

在运行代码的时候要注意,这段代码是对应一个固定的文件夹格式的(这里是上面那篇博客作者的文件夹形式,我的跟他的基本一致,只有一个文件夹的名称不同,他的VOC2007,我用的是VOC2020,命名什么都是可以的,只要把上面对应的代码改了就行):

如果文件夹是这个格式的,那这段代码就不用改动,只需要把classes那一行后面的类别给为你要检测的类别就可以了,并且这里把训练集和验证集的比例设定为8:2,代码中是TRAIN_RATIO = 80,需要修改的话直接改动数字就可以了,随后运行即可。如果不是那就需要在代码中把对应的文件夹名称修改一下,运行之后的文件形式为:

到这里数据集就已经制作完成了。然后我们需要下载YOLOv5的文件,直接去GitHub上下载就可以了,这里也给出一个连接:https://github.com/ultralytics/yolov5,解压之后把我们制作好的数据集文件拷贝到YOLOv5的文件中:

还有一点就是YOLOv5有很多种形式

你需要使用哪种形式就要下载对应的训练权重,我用的YOLOv5s,这里也给出一个连接:Releases · ultralytics/yolov5 · GitHub,下载该链接中的yolov5s.pt,并把他复制到YOLOv5文件的weights文集夹里面。

第二:Colab训练

首先就是科学上网,打开colab,进入之后的页面:

然后就是把自己准备好的YOLOv5文件上传到自己的云端硬盘,鼠标右键点击我的云端硬盘就可以看到下面低的选项了。上传速度可能有点慢,需要等一会。

然后就是点击新建,选择更多,随后选择下面红框标志的Colab

下面第一步需要把我们自己的云端硬盘加载进来,运行代码(运行之后需要点击显示的网址验证一下):

import os

from google.colab import drive

drive.mount('/content/drive')

然后切换到你自己YOLOv5的文件目录下:

运行代码(这里需要根据你自己工程的路径来切换):

%cd /content/drive/MyDrive/yolov5-5.0

接下来安装一下YOLOv5运行需要的环境,需要运行的代码如下:

!pip install -r requirements.txt

requirements.txt文件是YOLOv5作者提供好的,我们只需要运行一下就会自动安装YOLOv5需要的环境

最后需要建立两个文件,修改一个文件,这里给出一篇参考的博客:目标检测---教你利用yolov5训练自己的目标检测模型_didiaopao的博客-CSDN博客

首先要在data文件夹下新建一个yaml文件(文件的名称自己随便取,我这里的名称是fire.yaml),yaml文件中的代码如下:

# PASCAL VOC dataset http://host.robots.ox.ac.uk/pascal/VOC/

# Train command: python train.py --data voc.yaml

# Default dataset location is next to /yolov5:

# /parent_folder

# /VOC

# /yolov5

# download command/URL (optional)

#download: bash data/scripts/get_voc.sh

# train and val data as 1) directory: path/images/, 2) file: path/images.txt, or 3) list: [path1/images/, path2/images/]

train: VOCdevkit/images/train # 16551 images

val: VOCdevkit/images/val # 4952 images

test: VOCdevkit/images/test

# number of classes

nc: 1

# class names

names: [ 'fire']

train: VOCdevkit/images/train 是我们用于训练图片的路径

val: VOCdevkit/images/val 是我们用于验证图片的路径

nc:就是你检测的类别数量(我这里只检测一个类别所以写的是1)

names:是检测类别的名称(我检测的是火焰,fire)

(这里还有一个点就是如果你需要测试自己训练的精度等指标,你需要做一个新的图片数据,就是上面代码中的test那一行,数据的格式是跟train和val一样的)

然后就是models文件夹新建一个yaml文件(文件的名称自己随便取,我这里的名称是fire.yaml),yaml文件中的代码如下:

# parameters

nc: 1 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

# anchors

anchors:

- [10,13, 16,30, 33,23] # P3/8

- [30,61, 62,45, 59,119] # P4/16

- [116,90, 156,198, 373,326] # P5/32

# YOLOv5 backbone

backbone:

# [from, number, module, args]

[[-1, 1, Focus, [64, 3]], # 0-P1/2

[-1, 1, Conv, [128, 3, 2]], # 1-P2/4

[-1, 3, C3, [128]],

[-1, 1, Conv, [256, 3, 2]], # 3-P3/8

[-1, 9, C3, [256]],

[-1, 1, Conv, [512, 3, 2]], # 5-P4/16

[-1, 9, C3, [512]],

[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32

[-1, 1, SPP, [1024, [5, 9, 13]]],

[-1, 3, C3, [1024, False]], # 9

]

# YOLOv5 head

head:

[[-1, 1, Conv, [512, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 6], 1, Concat, [1]], # cat backbone P4

[-1, 3, C3, [512, False]], # 13

[-1, 1, Conv, [256, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 4], 1, Concat, [1]], # cat backbone P3

[-1, 3, C3, [256, False]], # 17 (P3/8-small)

[-1, 1, Conv, [256, 3, 2]],

[[-1, 14], 1, Concat, [1]], # cat head P4

[-1, 3, C3, [512, False]], # 20 (P4/16-medium)

[-1, 1, Conv, [512, 3, 2]],

[[-1, 10], 1, Concat, [1]], # cat head P5

[-1, 3, C3, [1024, False]], # 23 (P5/32-large)

[[17, 20, 23], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)

]

这里只需要将代码中的nc后面的数字修改为你自己检测的类别数量即可。

最后一步就是修改train.py文件,train.py中需要修改的代码为:

if __name__ == '__main__':

"""

opt模型主要参数解析:

--weights:初始化的权重文件的路径地址

--cfg:模型yaml文件的路径地址

--data:数据yaml文件的路径地址

--hyp:超参数文件路径地址

--epochs:训练轮次

--batch-size:喂入批次文件的多少

--img-size:输入图片尺寸

--rect:是否采用矩形训练,默认False

--resume:是否从最新的last.pt中恢复训练

--nosave:不保存模型,默认False

--notest:不进行test,默认False

--noautoanchor:不自动调整anchor,默认False

--evolve:是否进行超参数进化,默认False

--bucket:谷歌云盘bucket,一般不会用到

--cache-images:是否提前缓存图片到内存,以加快训练速度,默认False

--image-weights:使用加权图像选择进行训练

--device:训练的设备,cpu;0(表示一个gpu设备cuda:0);0,1,2,3(多个gpu设备)

--multi-scale:是否进行多尺度训练,默认False

--single-cls:数据集是否只有一个类别,默认False

--adam:是否使用adam优化器

--sync-bn:是否使用跨卡同步BN,在DDP模式使用

--local_rank:DDP参数,请勿修改

--workers:最大工作核心数

--project:训练模型的保存位置

--name:模型保存的目录名称

--exist-ok:模型目录是否存在,不存在就创建

"""

parser = argparse.ArgumentParser()

parser.add_argument('--weights', type=str, default='yolov5s.pt', help='initial weights path')

parser.add_argument('--cfg', type=str, default='', help='model.yaml path')

parser.add_argument('--data', type=str, default='data/coco128.yaml', help='data.yaml path')

parser.add_argument('--hyp', type=str, default='data/hyp.scratch.yaml', help='hyperparameters path')

parser.add_argument('--epochs', type=int, default=300)

parser.add_argument('--batch-size', type=int, default=16, help='total batch size for all GPUs')

parser.add_argument('--img-size', nargs='+', type=int, default=[640, 640], help='[train, test] image sizes')

parser.add_argument('--rect', action='store_true', help='rectangular training')

parser.add_argument('--resume', nargs='?', const=True, default=False, help='resume most recent training')

parser.add_argument('--nosave', action='store_true', help='only save final checkpoint')

parser.add_argument('--notest', action='store_true', help='only test final epoch')

parser.add_argument('--noautoanchor', action='store_true', help='disable autoanchor check')

parser.add_argument('--evolve', action='store_true', help='evolve hyperparameters')

parser.add_argument('--bucket', type=str, default='', help='gsutil bucket')

parser.add_argument('--cache-images', action='store_true', help='cache images for faster training')

parser.add_argument('--image-weights', action='store_true', help='use weighted image selection for training')

parser.add_argument('--device', default='', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')

parser.add_argument('--multi-scale', action='store_true', help='vary img-size +/- 50%%')

parser.add_argument('--single-cls', action='store_true', help='train multi-class data as single-class')

parser.add_argument('--adam', action='store_true', help='use torch.optim.Adam() optimizer')

parser.add_argument('--sync-bn', action='store_true', help='use SyncBatchNorm, only available in DDP mode')

parser.add_argument('--local_rank', type=int, default=-1, help='DDP parameter, do not modify')

parser.add_argument('--workers', type=int, default=8, help='maximum number of dataloader workers')

parser.add_argument('--project', default='runs/train', help='save to project/name')

parser.add_argument('--entity', default=None, help='W&B entity')

parser.add_argument('--name', default='exp', help='save to project/name')

parser.add_argument('--exist-ok', action='store_true', help='existing project/name ok, do not increment')

parser.add_argument('--quad', action='store_true', help='quad dataloader')

parser.add_argument('--linear-lr', action='store_true', help='linear LR')

parser.add_argument('--label-smoothing', type=float, default=0.0, help='Label smoothing epsilon')

parser.add_argument('--upload_dataset', action='store_true', help='Upload dataset as W&B artifact table')

parser.add_argument('--bbox_interval', type=int, default=-1, help='Set bounding-box image logging interval for W&B')

parser.add_argument('--save_period', type=int, default=-1, help='Log model after every "save_period" epoch')

parser.add_argument('--artifact_alias', type=str, default="latest", help='version of dataset artifact to be used')

opt = parser.parse_args()

需要修改的地方在 train.py文件中的第458到460行,如上图所示,第一个红色方框表示的是训练权重的路径,只需要在default写上权重的路径就可以了(第一次训练应该写weights/yolov5s.pt,之所以我写的不是这个是因为我训练过程中中断了,我从中断的地方开始训练的)。

第二个红色方框表示的是model.yaml的路径,就是我们刚才在models文件夹新建的yaml文件,只需要在default写上model.yaml的路径就可以了(models/fire.yaml)

第三个红色方框表示的是data.yaml的路径,就是我们刚才在data文件夹新建的yaml文件,只需要在default写上data.yaml的路径就可以了(data/fire.yaml)

在训练之前为了更加方便的观察训练过程可以安装训练可视化工具,运行命令:

!pip install wandb

到这里训练之前所有的准备工作就完成了,然后就是开始训练,代码为:

!python train.py

训练可视化过程如下:

训练好的权重会保存在runs/train目录下,共有两个权重文件best.pt和last.pt,我们进行测试用的是best.pt。

测试使用的是test.py文件,这个文件需要修改的地方三处(在原文件的288行、289行、294行):

if __name__ == '__main__':

parser = argparse.ArgumentParser(prog='test.py')

parser.add_argument('--weights', nargs='+', type=str, default='runs/train/exp27/weights/best.pt', help='model.pt path(s)')

parser.add_argument('--data', type=str, default='data/fire.yaml', help='*.data path')

parser.add_argument('--batch-size', type=int, default=16, help='size of each image batch')

parser.add_argument('--img-size', type=int, default=640, help='inference size (pixels)')

parser.add_argument('--conf-thres', type=float, default=0.001, help='object confidence threshold')

parser.add_argument('--iou-thres', type=float, default=0.5, help='IOU threshold for NMS')

parser.add_argument('--task', default='test', help='train, val, test, speed or study')

parser.add_argument('--device', default='', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')

parser.add_argument('--single-cls', action='store_true', help='treat as single-class dataset')

parser.add_argument('--augment', action='store_true', help='augmented inference')

parser.add_argument('--verbose', action='store_true', help='report mAP by class')

parser.add_argument('--save-txt', action='store_true', help='save results to *.txt')

parser.add_argument('--save-hybrid', action='store_true', help='save label+prediction hybrid results to *.txt')

parser.add_argument('--save-conf', action='store_true', help='save confidences in --save-txt labels')

parser.add_argument('--save-json', action='store_true', help='save a cocoapi-compatible JSON results file')

parser.add_argument('--project', default='runs/test', help='save to project/name')

parser.add_argument('--name', default='exp', help='save to project/name')

parser.add_argument('--exist-ok', action='store_true', help='existing project/name ok, do not increment')

opt = parser.parse_args()

opt.save_json |= opt.data.endswith('coco.yaml')

opt.data = check_file(opt.data) # check file

print(opt)

check_requirements()

第一处需要修改的地方是weights,这里我们在default后面需要将刚才best.pt权重的路径写进来;第二处是data处,需要将刚才新建的fire.yaml的路径放进去(data文件夹下,跟训练文件需要填写的文件路径相同);

第三处是task,需要在default出写上test,因为默认的val(验证数据),进行测试的话需要用新的图片数据,不然精度会和训练的时候的精度相同

修改完成之后运行命令:

!python test.py

运行的结果会显示P,R,MAP等结果:

最后就是使用detect.py进行图片(不需要打标签的图片)的检测了 ,该文件需要修改的地方有两处(原文件第151和152行)

if __name__ == '__main__':

parser = argparse.ArgumentParser()

parser.add_argument('--weights', nargs='+', type=str, default='runs/exp23/weights/best.pt', help='model.pt path(s)')

parser.add_argument('--source', type=str, default='VOCdevkit/smallfirepicture', help='source') # file/folder, 0 for webcam

parser.add_argument('--img-size', type=int, default=640, help='inference size (pixels)')

parser.add_argument('--conf-thres', type=float, default=0.25, help='object confidence threshold')

parser.add_argument('--iou-thres', type=float, default=0.5, help='IOU threshold for NMS')

parser.add_argument('--device', default='', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')

parser.add_argument('--view-img', action='store_true', help='display results')

parser.add_argument('--save-txt', action='store_true', help='save results to *.txt')

parser.add_argument('--save-conf', action='store_true', help='save confidences in --save-txt labels')

parser.add_argument('--nosave', action='store_true', help='do not save images/videos')

parser.add_argument('--classes', nargs='+', type=int, help='filter by class: --class 0, or --class 0 2 3')

parser.add_argument('--agnostic-nms', action='store_true', help='class-agnostic NMS')

parser.add_argument('--augment', action='store_true', help='augmented inference')

parser.add_argument('--update', action='store_true', help='update all models')

parser.add_argument('--project', default='runs/detect', help='save results to project/name')

parser.add_argument('--name', default='exp', help='save results to project/name')

parser.add_argument('--exist-ok', action='store_true', help='existing project/name ok, do not increment')

opt = parser.parse_args()

print(opt)

check_requirements(exclude=('pycocotools', 'thop'))

第一处需要修改的地方是weights,这里我们在default后面需要还是将刚才best.pt权重的路径写进来;

第二处是source处,需要将待检测图片的路径放进去;

到此整个检测就圆满完成了。

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)