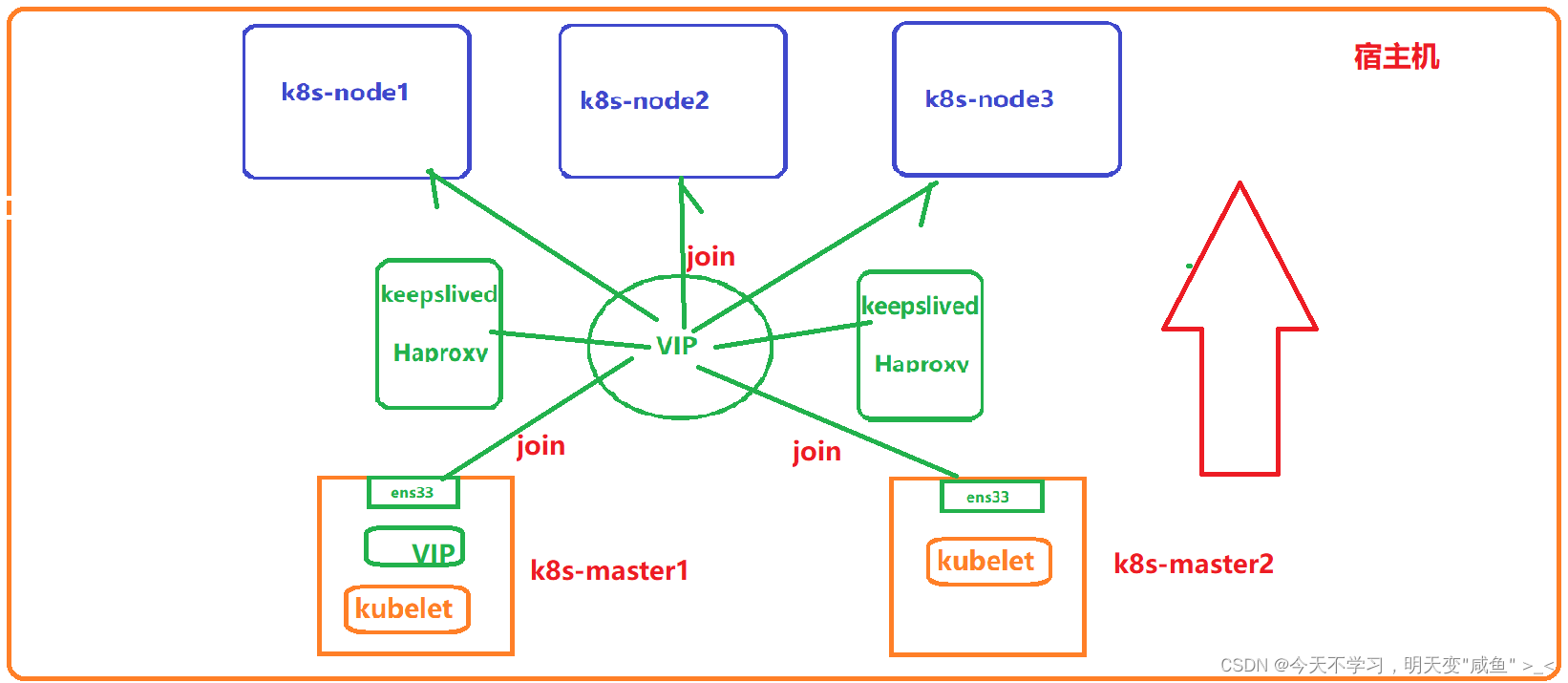

kubeadm部署高可用集群

注意事项

-

最新的版本不一定好,但相对于旧版本,核心功能稳定,但新增功能、接口相对不稳

-

学会一个版本的 高可用部署,其他版本操作都差不多

-

不要使用带中文的服务器

-

宿主机尽量不要使用克隆(可能在后期calico网络部署时,pod网络不同的问题),使用全新的机器

-

宿主机尽量升级到CentOS 7.9

-

内核kernel升级到 4.19+ 这种稳定的内核

-

部署k8s版本时,尽量找 1.xx.5 这种大于5的小版本(这种一般是比较稳定的版本)

-

k8s版本在一年之内进行更新一次

-

master在测试环境 为 2核3G

-

node节点在测试环境为 2核2G

k8s部署 二进制与高可用的区别

二进制部署

- 部署难,管理方便,集群伸展性能好

- 更稳定,集群规模到达一定的规模(几百个节点、上万个Pod),二进制稳定性是要高于kubeadm部署

- 遇到故障,宿主机起来了,进程也会起来

kubeadm部署

- 部署简单,管理难

- 是以一种容器管理容器的方式允许的组件及服务,故障恢复时间比二进制慢

- 遇到故障,启动宿主机,在启动进程,最后去启动容器,集群才能恢复,速度比二进制慢

一、环境配置

| Sys-Version | hostname | IP地址 | 性能 |

|---|

| CentOS7.9 | k8s-master1 | 192.168.178.51 | 2核3G |

| CentOS7.9 | k8s-master2 | 192.168.178.52 | 2核3G |

| CentOS7.9 | k8s-master3 | 192.168.178.53 | 2核3G |

| CentOS7.9 | k8s-node1 | 192.168.178.54 | 2核2G |

| CentOS7.9 | k8s-node2 | 192.168.178.55 | 2核2G |

| Sys-Version | APP |

|---|

| v1.20.12 | Kubernetes |

| v20.10.10 | Docker |

| v3.15.3 | Calico |

| v2.0.4 | Dashboard |

1、所有节点修改主机名

2、所有节点进行域名解析

192.168.178.51 k8s-master1

192.168.178.52 k8s-master2

192.168.178.53 k8s-master3

192.168.178.200 k8s-master-lb

192.168.178.54 k8s-node1

192.168.178.55 k8s-node2

3、所有节点关闭相关应用

3.1、防火墙关闭

3.2、dnsmasq关闭

3.3、NetworkManager关闭

3.4、关闭SWAP分区

3.5、检查MAC和product_uuid

4、所有节点获取相关软件

4.1、获取aliyun源

4.2、获取docker-yum源

4.3、配置k8s-Yum源

cat <<EOF > /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

4.4、安装必备工具

5、所有节点时间同步

5.1、安装ntpdate

5.2、时间同步

5.3、计划任务时间同步

添加并保存退出,每隔5秒进行时间同步

*/5 * * * * /usr/sbin/ntpdate time2.aliyun.com

*/5 * * * * /usr/sbin/ntpdate time2.aliyun.com

6、所有节点实现Linux的资源限制

* soft nofile 65536

* hard nofile 131072

* soft nproc 65535

* hard nproc 655350

* soft memlock unlimited

* hard memlock unlimited

7、master1进行免密

生成公钥

公钥推送

二、内核配置

1、所有节点进行升级update、重启

2、所有节点升级内核

2.1、master1获取RPM包

[root@k8s-master1 ~]

[root@k8s-master1 ~]

2.2、master1拷贝至所有节点

2.3、安装内核

2.3、更改内核启动方式

3、所有节点安装与配置ipvsadm

1、安装软件

2、配置内核参数

🔺注意:所有节点配置ipvs模块,在内核**4.19+**版本nf_conntrack_ipv4已经改为nf_conntrack, 4.18-以下使用nf_conntrack_ipv4即可

modprobe -- ip_vs

modprobe -- ip_vs_rr

modprobe -- ip_vs_wrr

modprobe -- ip_vs_sh

modprobe -- nf_conntrack

ip_vs

ip_vs_lc

ip_vs_wlc

ip_vs_rr

ip_vs_wrr

ip_vs_lblc

ip_vs_lblcr

ip_vs_dh

ip_vs_sh

ip_vs_fo

ip_vs_nq

ip_vs_sed

ip_vs_ftp

ip_vs_sh

nf_conntrack

ip_tables

ip_set

xt_set

ipt_set

ipt_rpfilter

ipt_REJECT

ipip

3、配置生效

4、开启k8s必须的内核参数

cat <<EOF > /etc/sysctl.d/k8s.conf

net.ipv4.ip_forward = 1

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-ip6tables = 1

fs.may_detach_mounts = 1

vm.overcommit_memory=1

vm.panic_on_oom=0

fs.inotify.max_user_watches=89100

fs.file-max=52706963

fs.nr_open=52706963

net.netfilter.nf_conntrack_max=2310720

net.ipv4.tcp_keepalive_time = 600

net.ipv4.tcp_keepalive_probes = 3

net.ipv4.tcp_keepalive_intvl =15

net.ipv4.tcp_max_tw_buckets = 36000

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_max_orphans = 327680

net.ipv4.tcp_orphan_retries = 3

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.ip_conntrack_max = 65536

net.ipv4.tcp_max_syn_backlog = 16384

net.ipv4.tcp_timestamps = 0

net.core.somaxconn = 16384

EOF

5、重启,加载内核

三、基本组件安装、配置

1、所有节点部署Docker

1.1、安装docker-ce

1.2、修改 CgroupDriver 为 systemd

🔺**注意:**由于新版kubelet建议使用systemd,所以可以把docker的CgroupDriver改成systemd

cat > /etc/docker/daemon.json <<EOF

{

"exec-opts": ["native.cgroupdriver=systemd"]

}

EOF

1.3、开机自启动Docker

Cgroup Driver: systemd

Docker version 20.10.10, build b485636

2、所有节点安装k8s组件

2.1、查看可安装的k8版本

2.2、安装kubeadm

1、安装指定版本(本实验采用)

2、安装最新版本

2.3、配置默认的拉取镜像仓库

🔺**注意:**默认配置的pause镜像使用gcr.io仓库, 国内可能无法访问, 所以这里配置Kubelet使用阿里云的pause镜像

cat >/etc/sysconfig/kubelet<<EOF

KUBELET_EXTRA_ARGS="--cgroup-driver=systemd --pod-infra-container-image=registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.2"

EOF

2.4、设置kubelet开机自启

四、高可用组件安装、配置

🔺**注意:**如果不是高可用集群,haproxy和keepalived无需安装

公有云要用公有云自带的负载均衡,比如阿里云的SLB,腾讯云的ELB,用来替代haproxy和keepalived,因为公有云大部分都是不支持keepalived的,另外如果用阿里云的话,kubectl控制端不能放在master节点,推荐使用腾讯云,因为阿里云的slb有回环的问题,也就是slb代理的服务器不能反向访问SLB,但是腾讯云修复了这个问题。

1、master节点部署Haproxy

1.1、安装haproxy

1.2、编写haproxy配置

所有master节点配置一致

global

maxconn 2000

ulimit-n 16384

log 127.0.0.1 local0 err

stats timeout 30s

defaults

log global

mode http

option httplog

timeout connect 5000

timeout client 50000

timeout server 50000

timeout http-request 15s

timeout http-keep-alive 15s

frontend monitor-in

bind *:33305

mode http

option httplog

monitor-uri /monitor

frontend k8s-master

bind 0.0.0.0:16443

bind 127.0.0.1:16443

mode tcp

option tcplog

tcp-request inspect-delay 5s

default_backend k8s-master

backend k8s-master

mode tcp

option tcplog

option tcp-check

balance roundrobin

default-server inter 10s downinter 5s rise 2 fall 2 slowstart 60s maxconn 250 maxqueue 256 weight 100

server k8s-master1 192.168.178.51:6443 check

server k8s-master2 192.168.178.52:6443 check

server k8s-master3 192.168.178.53:6443 check

2、master节点部署keepalived

2.1、安装keepalived

2.2、配置keepalived

a、master1配置

! Configuration File for keepalived

global_defs {

router_id k8s-master1

script_user root

enable_script_security

}

vrrp_script chk_apiserver {

script "/etc/keepalived/check_apiserver.sh"

interval 5

weight -5

fall 2

rise 1

}

vrrp_instance VI_1 {

state MASTER

interface ens33

mcast_src_ip 192.168.178.51

virtual_router_id 51

priority 101

advert_int 2

authentication {

auth_type PASS

auth_pass K8SHA_KA_AUTH

}

virtual_ipaddress {

192.168.178.200

}

track_script {

chk_apiserver

}

}

b、master2配置

! Configuration File for keepalived

global_defs {

router_id k8s-master2

script_user root

enable_script_security

}

vrrp_script chk_apiserver {

script "/etc/keepalived/check_apiserver.sh"

interval 5

weight -5

fall 2

rise 1

}

vrrp_instance VI_1 {

state BACKUP

interface ens33

mcast_src_ip 192.168.178.52

virtual_router_id 51

priority 100

advert_int 2

authentication {

auth_type PASS

auth_pass K8SHA_KA_AUTH

}

virtual_ipaddress {

192.168.178.200

}

track_script {

chk_apiserver

}

}

c、master3配置

! Configuration File for keepalived

global_defs {

router_id k8s-master3

script_user root

enable_script_security

}

vrrp_script chk_apiserver {

script "/etc/keepalived/check_apiserver.sh"

interval 5

weight -5

fall 2

rise 1

}

vrrp_instance VI_1 {

state BACKUP

interface ens33

mcast_src_ip 192.168.178.53

virtual_router_id 51

priority 100

advert_int 2

authentication {

auth_type PASS

auth_pass K8SHA_KA_AUTH

}

virtual_ipaddress {

192.168.178.200

}

track_script {

chk_apiserver

}

}

2.3、创建对应的脚本文件

err=0

for k in $(seq 1 3)

do

check_code=$(pgrep haproxy)

if [[ $check_code == "" ]]; then

err=$(expr $err + 1)

sleep 1

continue

else

err=0

break

fi

done

if [[ $err != "0" ]]; then

echo "systemctl stop keepalived"

/usr/bin/systemctl stop keepalived

exit 1

else

exit 0

fi

🔺**注意:**这里还有一个脚本可以选择,两个脚本选择其中一个即可,看自己的需求

#!/bin/bash

counter=$(ps -C haproxy --no-heading|wc -l)

if [ "${counter}" = "0" ]; then

systemctl restart haproxy

sleep 5

counter=$(ps -C haproxy --no-heading|wc -l)

if [ "${counter}" = "0" ]; then

systemctl stop keepalived

fi

fi

2.4、脚本授权

total 12

-rwxr-xr-x 1 root root 356 Nov 4 20:09 check_apiserver.sh

-rw-r--r-- 1 root root 590 Nov 4 20:31 keepalived.conf

-rw-r--r-- 1 root root 3598 Nov 4 19:51 keepalived.conf.b

3、master节点启动LB与HA

1、开机自启动

2、检测VIP可用性

1、在master1上查看VIP:

[root@k8s-master1 keepalived]

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

inet 192.168.178.51/24 brd 192.168.178.255 scope global ens33

inet 192.168.178.200/32 scope global ens33

2、所有节点ping,测试VIP:

PING 192.168.178.200 (192.168.178.200) 56(84) bytes of data.

64 bytes from 192.168.178.200: icmp_seq=1 ttl=64 time=0.029 ms

64 bytes from 192.168.178.200: icmp_seq=2 ttl=64 time=0.027 ms

64 bytes from 192.168.178.200: icmp_seq=3 ttl=64 time=0.079 ms

Trying 192.168.178.200...

Connected to 192.168.178.200.

Escape character is '^]'.

Connection closed by foreign host.

五、集群初始化

所有master节点

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.20.0

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver:v1.20.0

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler:v1.20.0

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager:v1.20.0

registry.cn-hangzhou.aliyuncs.com/google_containers/etcd:3.4.13-0

registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.7.0

registry.cn-hangzhou.aliyuncs.com/google_containers/pause:3.2

registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.2

所有node节点

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy:v1.20.0

registry.cn-hangzhou.aliyuncs.com/google_containers/pause-amd64:3.2

registry.cn-hangzhou.aliyuncs.com/google_containers/coredns:1.7.0 #只在一个节点,使用选择器

1、master1编写yaml配置文件

apiVersion: kubeadm.k8s.io/v1beta2

bootstrapTokens:

- groups:

- system:bootstrappers:kubeadm:default-node-token

token: 7t2weq.bjbawausm0jaxury

ttl: 24h0m0s

usages:

- signing

- authentication

kind: InitConfiguration

localAPIEndpoint:

advertiseAddress: 192.168.178.51

bindPort: 6443

nodeRegistration:

criSocket: /var/run/dockershim.sock

name: k8s-master1

taints:

- effect: NoSchedule

key: node-role.kubernetes.io/master

---

apiServer:

certSANs:

- 192.168.178.200

timeoutForControlPlane: 4m0s

apiVersion: kubeadm.k8s.io/v1beta2

certificatesDir: /etc/kubernetes/pki

clusterName: kubernetes

controlPlaneEndpoint: 192.168.178.200:16443

controllerManager: {}

dns:

type: CoreDNS

etcd:

local:

dataDir: /var/lib/etcd

imageRepository: registry.cn-hangzhou.aliyuncs.com/google_containers

kind: ClusterConfiguration

kubernetesVersion: v1.20.0

networking:

dnsDomain: cluster.local

podSubnet: 172.168.0.0/12

serviceSubnet: 10.96.0.0/12

scheduler: {}

2、更新 Yaml 文件

2、master所有节点提前拉取镜像

2.1、master1拉取镜像

[root@k8s-master1 ~]

[root@k8s-master1 ~]

REPOSITORY TAG IMAGE ID CREATED SIZE

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy v1.20.0 10cc881966cf 11 months ago 118MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver v1.20.0 ca9843d3b545 11 months ago 122MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager v1.20.0 b9fa1895dcaa 11 months ago 116MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler v1.20.0 3138b6e3d471 11 months ago 46.4MB

registry.cn-hangzhou.aliyuncs.com/google_containers/etcd 3.4.13-0 0369cf4303ff 14 months ago 253MB

registry.cn-hangzhou.aliyuncs.com/google_containers/coredns 1.7.0 bfe3a36ebd25 16 months ago 45.2MB

registry.cn-hangzhou.aliyuncs.com/google_containers/pause 3.2 80d28bedfe5d 20 months ago 683kB

[root@k8s-master1 ~]

[root@k8s-master1 ~]

2.2、master2拉取镜像

[root@k8s-master2 ~]

[root@k8s-master2 ~]

REPOSITORY TAG IMAGE ID CREATED SIZE

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy v1.20.0 10cc881966cf 11 months ago 118MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver v1.20.0 ca9843d3b545 11 months ago 122MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager v1.20.0 b9fa1895dcaa 11 months ago 116MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler v1.20.0 3138b6e3d471 11 months ago 46.4MB

registry.cn-hangzhou.aliyuncs.com/google_containers/etcd 3.4.13-0 0369cf4303ff 14 months ago 253MB

registry.cn-hangzhou.aliyuncs.com/google_containers/coredns 1.7.0 bfe3a36ebd25 16 months ago 45.2MB

registry.cn-hangzhou.aliyuncs.com/google_containers/pause 3.2 80d28bedfe5d 20 months ago 683kB

2.3、master3拉取镜像

[root@k8s-master3 keepalived]

[root@k8s-master3 keepalived]

REPOSITORY TAG IMAGE ID CREATED SIZE

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-proxy v1.20.0 10cc881966cf 11 months ago 118MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-controller-manager v1.20.0 b9fa1895dcaa 11 months ago 116MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-scheduler v1.20.0 3138b6e3d471 11 months ago 46.4MB

registry.cn-hangzhou.aliyuncs.com/google_containers/kube-apiserver v1.20.0 ca9843d3b545 11 months ago 122MB

registry.cn-hangzhou.aliyuncs.com/google_containers/etcd 3.4.13-0 0369cf4303ff 14 months ago 253MB

registry.cn-hangzhou.aliyuncs.com/google_containers/coredns 1.7.0 bfe3a36ebd25 16 months ago 45.2MB

registry.cn-hangzhou.aliyuncs.com/google_containers/pause 3.2 80d28bedfe5d 20 months ago 683kB

3、所有节点自启动kubelet

4、master1进行初始化

4.1、master1节点进行初始化

🔺**注意:**Master1节点初始化,初始化以后会在 /etc/kubernetes 目录下生成对应的证书和配置文件,之后其他Master节点加入Master1即可:

[root@k8s-master1 ~]

.........

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

You can now join any number of the control-plane node running the following command on each as root:

kubeadm join 192.168.178.200:16443 --token 7t2weq.bjbawausm0jaxury \

--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98 \

--control-plane --certificate-key 0f2a7ff2c46ec172f834e237fcca8a02e7c29500746594c25d995b78c92dde96

Please note that the certificate-key gives access to cluster sensitive data, keep it secret!

As a safeguard, uploaded-certs will be deleted in two hours; If necessary, you can use

"kubeadm init phase upload-certs --upload-certs" to reload certs afterward.

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join 192.168.178.200:16443 --token 7t2weq.bjbawausm0jaxury \

--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98

4.1.1、初始化失败,进行的操作

4.2、master1节点配置环境变量

cat <<EOF >> /root/.bashrc

export KUBECONFIG=/etc/kubernetes/admin.conf

EOF

[root@k8s-master1 ~]

[root@k8s-master1 ~]

NAME STATUS ROLES AGE VERSION

k8s-master01 NotReady control-plane,master 4m59s v1.20.12

[root@k8s-master1 ~]

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 8m59s

[root@k8s-master1 ~]

NAME READY STATUS RESTARTS AGE

coredns-54d67798b7-7d676 0/1 Pending 0 12m

coredns-54d67798b7-mkrmq 0/1 Pending 0 12m

etcd-k8s-master01 1/1 Running 0 12m

kube-apiserver-k8s-master01 1/1 Running 0 12m

kube-controller-manager-k8s-master01 1/1 Running 0 12m

kube-proxy-tbl27 1/1 Running 0 12m

kube-scheduler-k8s-master01 1/1 Running 0 12m

4.3、kubelet命令补全

[root@k8s-master1 ~]

[root@k8s-master1 ~]

[root@k8s-master1 ~]

5、所有节点加入集群

5.1、master节点加入集群

kubeadm join 192.168.178.200:16443 --token 7t2weq.bjbawausm0jaxury \

--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98 \

--control-plane --certificate-key 0f2a7ff2c46ec172f834e237fcca8a02e7c29500746594c25d995b78c92dde96

.........

This node has joined the cluster and a new control plane instance was created:

* Certificate signing request was sent to apiserver and approval was received.

* The Kubelet was informed of the new secure connection details.

* Control plane (master) label and taint were applied to the new node.

* The Kubernetes control plane instances scaled up.

* A new etcd member was added to the local/stacked etcd cluster.

To start administering your cluster from this node, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Run 'kubectl get nodes' to see this node join the cluster.

5.2、node节点加入集群

kubeadm join 192.168.178.200:16443 --token 7t2weq.bjbawausm0jaxury \

--discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98

.........

This node has joined the cluster:

* Certificate signing request was sent to apiserver and a response was received.

* The Kubelet was informed of the new secure connection details.

Run 'kubectl get nodes' on the control-plane to see this node join the cluster.

5.3、master1再次查看集群信息

[root@k8s-master1 ~]

NAME STATUS ROLES AGE VERSION

k8s-master01 NotReady control-plane,master 25m v1.20.12

k8s-master2 NotReady control-plane,master 3m51s v1.20.12

k8s-master3 NotReady control-plane,master 2m52s v1.20.12

k8s-node1 NotReady <none> 102s v1.20.12

k8s-node2 NotReady <none> 98s v1.20.12

六、master1 网络插件 Calico 部署

所有节点

registry.cn-beijing.aliyuncs.com/dotbalo/cni

registry.cn-beijing.aliyuncs.com/dotbalo/pod2daemon-flexvol

registry.cn-beijing.aliyuncs.com/dotbalo/node

registry.cn-beijing.aliyuncs.com/dotbalo/kube-controllers #只有该镜像只在一个节点 replicas:1

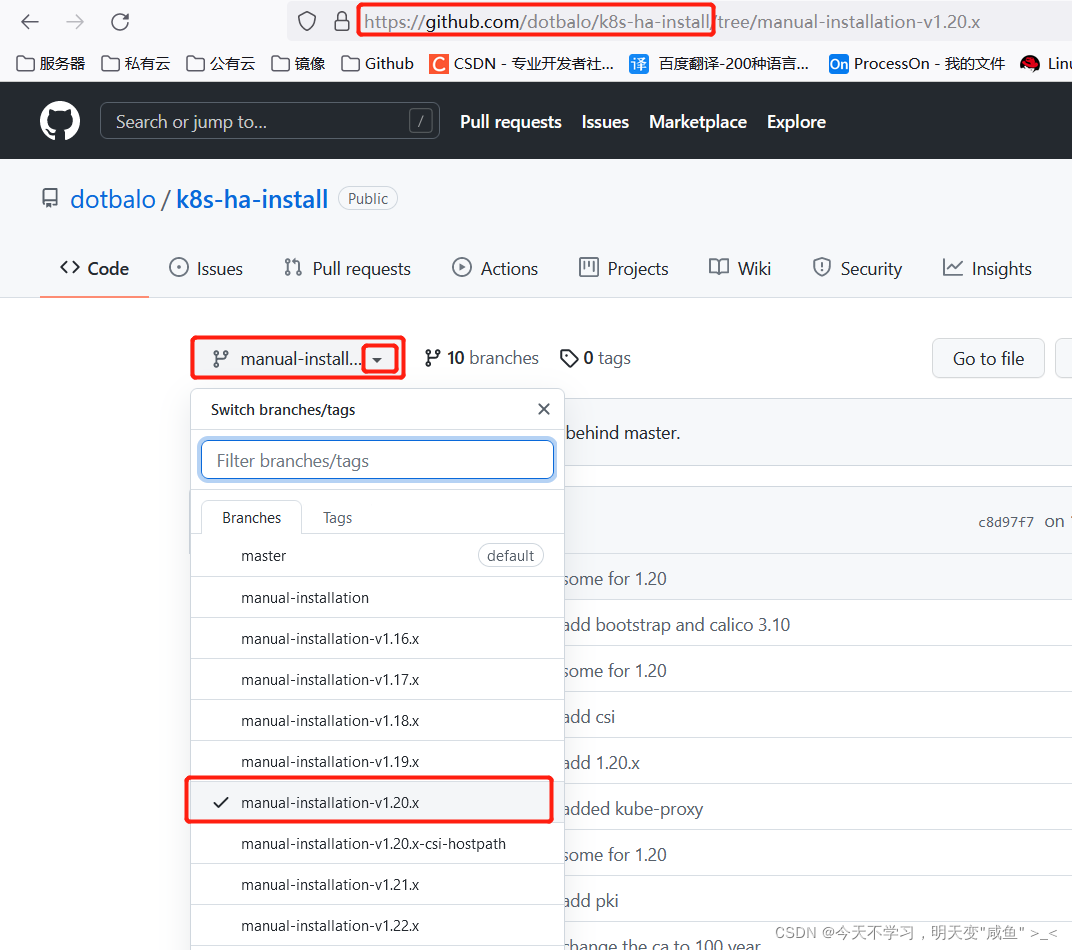

1、下载所需的源码文件

**下载地址:**https://codeload.github.com/dotbalo/k8s-ha-install/zip/refs/heads/manual-installation-v1.20.x

[root@k8s-master1 ~]

将下载的压缩包上传该目录

[root@k8s-master1 git]

[root@k8s-master1 git]

[root@k8s-master1 git]

k8s-ha-install-manual-installation-v1.20.x

2、修改yaml配置文件

2.1、修改etcd_endpoints为master节点IP

[root@k8s-master1 git]

[root@k8s-master1 calico]

2.2、将etcd的CA证书进行加密、赋值

解析:

- 先将 ca.crt 证书进行 base64 加密,去掉换行符,赋值给 ETCD_CA

- 先将 server.crt 证书进行 base64 加密,去掉换行符,赋值给 ETCD_CERT

- 先将 server.key 证书进行 base64 加密,去掉换行符,赋值给 ETCD_KEY

[root@k8s-master1 calico]

[root@k8s-master1 calico]

[root@k8s-master1 calico]

2.3、将值对内容进行替换

解析:

对 calico-etcd.yaml 文件进行操作

-

将内容中的 # etcd-key: null 替换为 etcd-key: ${ETCD_KEY}

-

将内容中的 # etcd-cert: null 替换为 etcd-cert: ${ETCD_CERT}

-

将内容中的 # etcd-ca: null 替换为 etcd-ca: ${ETCD_CA}@g

-

将内容中的 etcd_ca: “” 替换为 etcd_ca: “/calico-secrets/etcd-ca”

-

将内容中的 etcd_cert: “” 替换为 etcd_cert: “/calico-secrets/etcd-cert”

-

将内容中的 etcd_key: “” 替换为 etcd_key: “/calico-secrets/etcd-key”

[root@k8s-master1 calico]

[root@k8s-master1 calico]

2.4、定义Calico的网段

[root@k8s-master1 ~]

172.168.0.0/12

[root@k8s-master1 calico]

[root@k8s-master1 calico]

[root@k8s-master1 calico]

- name: CALICO_IPV4POOL_CIDR

value: 172.168.0.0/12

3、执行配置文件

[root@k8s-master1 calico]

secret/calico-etcd-secrets created

configmap/calico-config created

clusterrole.rbac.authorization.k8s.io/calico-kube-controllers created

clusterrolebinding.rbac.authorization.k8s.io/calico-kube-controllers created

clusterrole.rbac.authorization.k8s.io/calico-node created

clusterrolebinding.rbac.authorization.k8s.io/calico-node created

daemonset.apps/calico-node created

serviceaccount/calico-node created

deployment.apps/calico-kube-controllers created

serviceaccount/calico-kube-controllers created

[root@k8s-master1 calico]

NAME READY STATUS RESTARTS AGE

calico-kube-controllers-5f6d4b864b-5tfck 1/1 Running 0 2m6s

calico-node-8zn7h 1/1 Running 0 2m6s

calico-node-btngk 1/1 Running 0 2m6s

calico-node-j6847 1/1 Running 0 2m6s

calico-node-k86mh 1/1 Running 0 2m6s

calico-node-v78kq 1/1 Running 0 2m6s

coredns-54d67798b7-7d676 1/1 Running 0 73m

coredns-54d67798b7-mkrmq 1/1 Running 0 73m

etcd-k8s-master01 1/1 Running 2 73m

etcd-k8s-master2 1/1 Running 0 51m

etcd-k8s-master3 1/1 Running 0 49m

kube-apiserver-k8s-master01 1/1 Running 2 73m

kube-apiserver-k8s-master2 1/1 Running 0 51m

kube-apiserver-k8s-master3 1/1 Running 1 49m

kube-controller-manager-k8s-master01 1/1 Running 3 73m

kube-controller-manager-k8s-master2 1/1 Running 0 51m

kube-controller-manager-k8s-master3 1/1 Running 0 50m

kube-proxy-87g9m 1/1 Running 0 50m

kube-proxy-fwj5h 1/1 Running 0 49m

kube-proxy-rl6r5 1/1 Running 0 51m

kube-proxy-tbl27 1/1 Running 2 73m

kube-proxy-w7pz2 1/1 Running 0 49m

kube-scheduler-k8s-master01 1/1 Running 3 73m

kube-scheduler-k8s-master2 1/1 Running 0 51m

kube-scheduler-k8s-master3 1/1 Running 0 49m

[root@k8s-master1 calico]

NAME STATUS ROLES AGE VERSION

k8s-master01 Ready control-plane,master 75m v1.20.12

k8s-master2 Ready control-plane,master 54m v1.20.12

k8s-master3 Ready control-plane,master 53m v1.20.12

k8s-node1 Ready <none> 51m v1.20.12

k8s-node2 Ready <none> 51m v1.20.12

4、calico网络测试

**解析:**测试Calico部署的网络是否有用,创建多个Pod,Pod之间的通信,与Svc之间的通信等。

[root@k8s-master1 ~]

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: nginx-deploy

name: nginx-deploy

spec:

replicas: 2

selector:

matchLabels:

app: nginx-deploy

template:

metadata:

labels:

app: nginx-deploy

spec:

containers:

- image: daocloud.io/library/nginx:latest

name: nginx

---

apiVersion: v1

kind: Service

metadata:

name: nginx-svc

spec:

type: NodePort

ports:

- name: http

port: 80

targetPort: 80

nodePort: 30080

selector:

app: nginx-deploy

[root@k8s-master1 ~]

deployment.apps/nginx-deploy created

service/nginx-svc created

[root@k8s-master1 ~]

NAME READY STATUS RESTARTS AGE IP NODE

nginx-deploy-76bcbdfc49-vlzzd 1/1 Running 0 52s 172.173.131.7 k8s-node2

nginx-deploy-76bcbdfc49-whkxh 1/1 Running 0 52s 172.175.156.68 k8s-node1

[root@k8s-master1 ~]

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 13h

nginx-svc NodePort 10.109.140.116 <none> 80:30080/TCP 68s

1、使用Pod-IP访问:

[root@k8s-master1 ~]

HTTP/1.1 200 OK

Server: nginx/1.19.6

Date: Fri, 05 Nov 2021 04:16:16 GMT

[root@k8s-master1 ~]

HTTP/1.1 200 OK

Server: nginx/1.19.6

Date: Fri, 05 Nov 2021 04:16:27 GMT

2、使用的clustr-IP访问:

[root@k8s-master1 ~]

HTTP/1.1 200 OK

Server: nginx/1.19.6

Date: Fri, 05 Nov 2021 04:17:12 GMT

3、使用NodePort-IP访问:

[root@k8s-master1 ~]

HTTP/1.1 200 OK

Server: nginx/1.19.6

Date: Fri, 05 Nov 2021 04:18:22 GMT

[root@k8s-master1 ~]

HTTP/1.1 200 OK

Server: nginx/1.19.6

Date: Fri, 05 Nov 2021 04:19:11 GMT

4、使用容器中的Pod访问:

[root@k8s-master1 ~]

HTTP/1.1 200 OK

Server: nginx/1.19.6

Date: Fri, 05 Nov 2021 04:22:03 GMT

HTTP/1.1 200 OK

Server: nginx/1.19.6

Date: Fri, 05 Nov 2021 04:23:42 GMT

七、Master1 部署 Metrics

你可以通过 节点选择 去部署该组件,只在一个节点部署即可

registry.cn-beijing.aliyuncs.com/dotbalo/metrics-server:v0.4.1

**解析:**Kubernetes中系统资源的采集均使用Metrics-server,可以通过Metrics采集节点和Pod的内存、磁盘、CPU和网络的使用率。

1、Master1节点操作

解析:将Master01节点的front-proxy-ca.crt复制到所有Node节点

[root@k8s-master1 ~]

[root@k8s-master1 ~]

2、master1节点apply

[root@k8s-master1 ~]

[root@k8s-master1 metrics-server-0.4.x-kubeadm]

comp.yaml

[root@k8s-master1 metrics-server-0.4.x-kubeadm]

serviceaccount/metrics-server created

clusterrole.rbac.authorization.k8s.io/system:aggregated-metrics-reader created

clusterrole.rbac.authorization.k8s.io/system:metrics-server created

rolebinding.rbac.authorization.k8s.io/metrics-server-auth-reader created

clusterrolebinding.rbac.authorization.k8s.io/metrics-server:system:auth-delegator created

clusterrolebinding.rbac.authorization.k8s.io/system:metrics-server created

service/metrics-server created

deployment.apps/metrics-server created

apiservice.apiregistration.k8s.io/v1beta1.metrics.k8s.io created

3、查看效果

[root@k8s-master1 ~]

NAME CPU(cores) CPU% MEMORY(bytes) MEMORY%

k8s-master01 123m 6% 1000Mi 34%

k8s-master2 122m 6% 1438Mi 50%

k8s-master3 125m 6% 1369Mi 47%

k8s-node1 54m 2% 813Mi 40%

k8s-node2 64m 3% 876Mi 43%

[root@k8s-master1 ~]

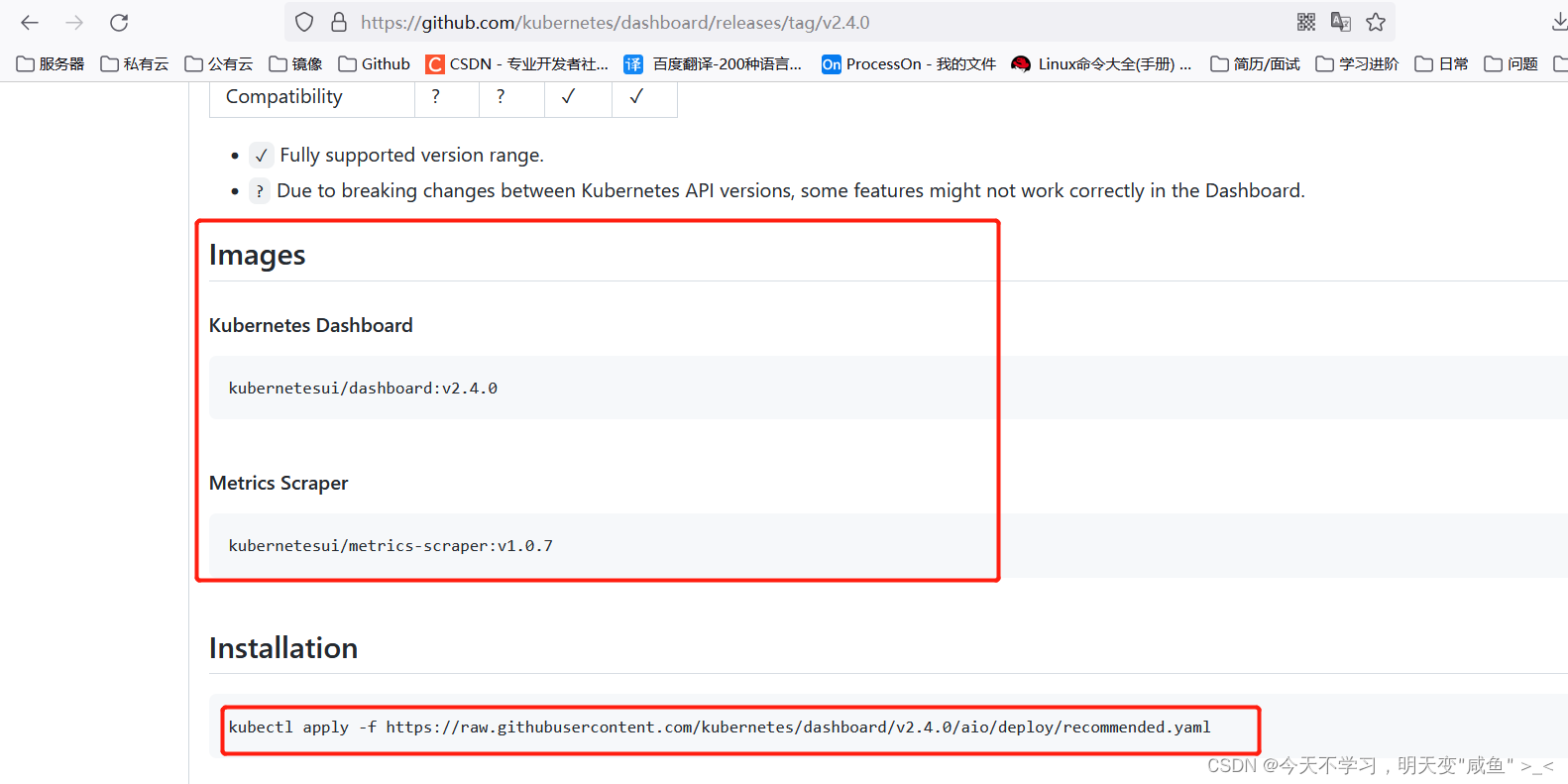

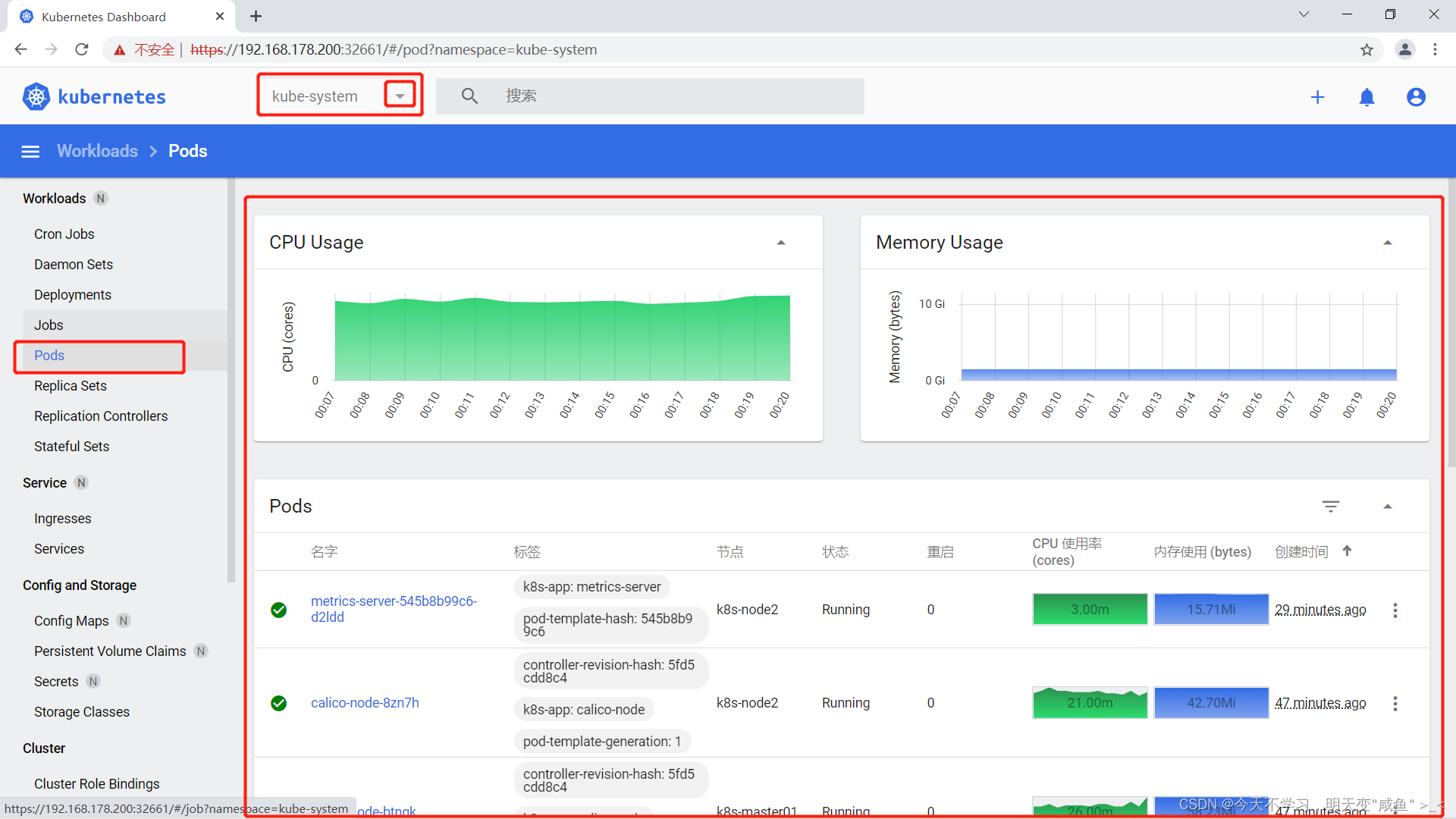

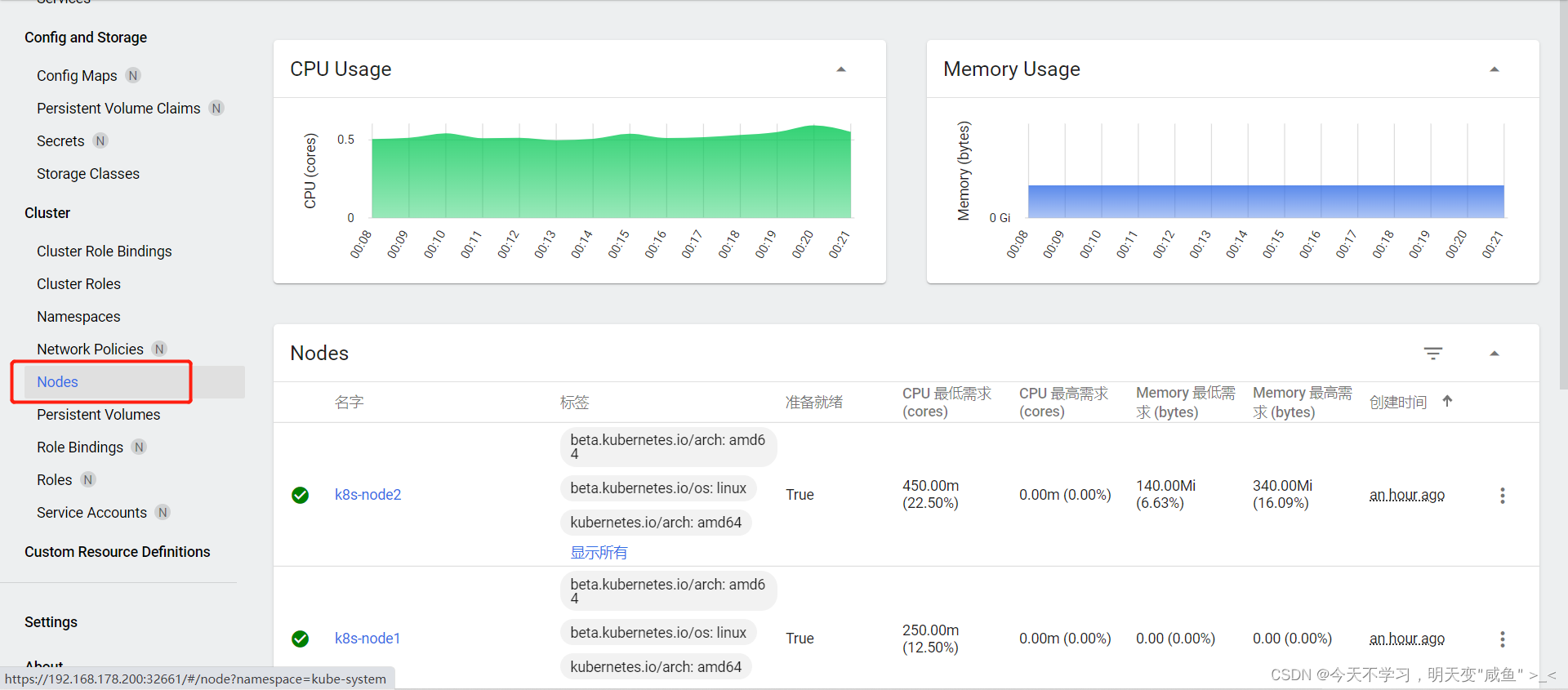

八、Master1 部署 Dashboard

你可以通过 节点选择 去部署该组件,只在一个节点部署即可

registry.cn-beijing.aliyuncs.com/dotbalo/dashboard:v2.0.4

registry.cn-beijing.aliyuncs.com/dotbalo/metrics-scraper:v1.0.4

1、指定版本安装(本实验)

[root@k8s-master1 ~]

[root@k8s-master1 dashboard]

dashboard-user.yaml dashboard.yaml

[root@k8s-master1 dashboard]

serviceaccount/admin-user created

clusterrolebinding.rbac.authorization.k8s.io/admin-user created

namespace/kubernetes-dashboard created

serviceaccount/kubernetes-dashboard created

service/kubernetes-dashboard created

secret/kubernetes-dashboard-certs created

secret/kubernetes-dashboard-csrf created

secret/kubernetes-dashboard-key-holder created

configmap/kubernetes-dashboard-settings created

role.rbac.authorization.k8s.io/kubernetes-dashboard created

clusterrole.rbac.authorization.k8s.io/kubernetes-dashboard created

rolebinding.rbac.authorization.k8s.io/kubernetes-dashboard created

clusterrolebinding.rbac.authorization.k8s.io/kubernetes-dashboard created

deployment.apps/kubernetes-dashboard created

service/dashboard-metrics-scraper created

deployment.apps/dashboard-metrics-scraper created

[root@k8s-master1 dashboard]

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

dashboard-metrics-scraper ClusterIP 10.109.202.201 <none> 8000/TCP 5m29s

kubernetes-dashboard ClusterIP 10.96.194.27 <none> 443/TCP 5m29s

2、安装最新版本(二选一)

🥇**官方GitHub地址:**https://github.com/kubernetes/dashboard

2.1、官网指定命令执行

2.2、创建管理员用户

apiVersion: v1

kind: ServiceAccount

metadata:

name: admin-user

namespace: kube-system

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: admin-user

annotations:

rbac.authorization.kubernetes.io/autoupdate: "true"

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

- kind: ServiceAccount

name: admin-user

namespace: kube-system

3、登入Web页面

3.1、更改dashboard的svc为NodePort

[root@k8s-master1 dashboard]

spec:

clusterIP: 10.96.194.27

clusterIPs:

- 10.96.194.27

ports:

- port: 443

protocol: TCP

targetPort: 8443

selector:

k8s-app: kubernetes-dashboard

sessionAffinity: None

type: NodePort

3.2、再次查看svc

[root@k8s-master1 dashboard]

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

dashboard-metrics-scraper ClusterIP 10.109.202.201 <none> 8000/TCP 7m40s

kubernetes-dashboard NodePort 10.96.194.27 <none> 443:32661/TCP 7m40s

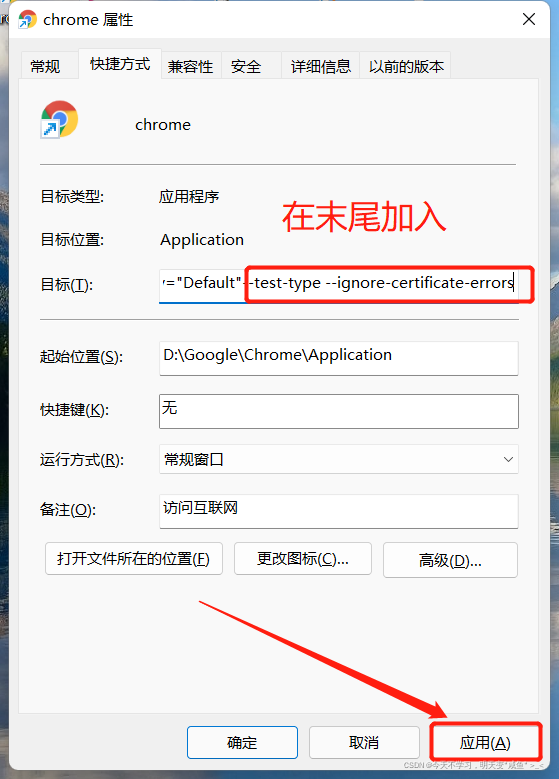

3.3、访问Web页面

关闭该提示,注意 此为 谷歌浏览器 Google

参数:–test-type --ignore-certificate-errors

重启浏览器,再次访问,没有提示

3.4、获取token

[root@k8s-master1 dashboard]

Name: admin-user-token-7pm6f

Namespace: kube-system

Labels: <none>

Annotations: kubernetes.io/service-account.name: admin-user

kubernetes.io/service-account.uid: f52de3a4-31b0-4ffa-8851-7dba77a8b029

Type: kubernetes.io/service-account-token

Data

====

ca.crt: 1066 bytes

namespace: 11 bytes

token: eyJhbGciOiJSUzI1NiIsImtpZCI6IlA1a3A5M2pydjdFZGlycTFjaFhfRUdXLVBfNnNzNGQ2UGdNdjN4NW9RTkkifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJrdWJlLXN5c3RlbSIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VjcmV0Lm5hbWUiOiJhZG1pbi11c2VyLXRva2VuLTdwbTZmIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQubmFtZSI6ImFkbWluLXVzZXIiLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC51aWQiOiJmNTJkZTNhNC0zMWIwLTRmZmEtODg1MS03ZGJhNzdhOGIwMjkiLCJzdWIiOiJzeXN0ZW06c2VydmljZWFjY291bnQ6a3ViZS1zeXN0ZW06YWRtaW4tdXNlciJ9.SwF42kujMIzyHtGWSitDXASeSqgZ5PL2PJjdq-cIe-2hYAh9SsYsXVFRWuka6jG66OeNG71IZ7huKe8_sfv5cQ_v_j0ilMiP0aTo3YQhdU-PKKWIsfGwI7BfiRtk9JzWQlDYJCPM8Nn_lFZDLCMoeJ_FeQG8zBxoAkgL1nvAaJICPQbs_A-PwwMTmuUurttiu9CF6HOoiWlCxCMWLEGXIwGl43Wc4evP3qpuBYcsrymeC91LSd4Szn-uqb5_aS6JKKYtTQb2_nQ8LjECCvMyH6tPbqW_pPSi8FNfqhSUtMV3ls93Ilmm8X6ZJNjCkBxcxN89ED1RKcrJBrGgL2aE_A

3.5、登入Web页面查看

九、kube-proxy开启 ipvs

🔺**注意:**在后期实验中发现,要实现Pod内部与Service之间的通信,就是我们可以通过 ServiceName.Namespace.svc.cluster.local 访问到Service,必须把kube-proxy的模式修改为 IPVS 模式,才能进行通信。

1、Mastrer1 修改模式

[root@k8s-master1 ~]

ipvs:

excludeCIDRs: null

minSyncPeriod: 0s

scheduler: ""

strictARP: false

syncPeriod: 0s

tcpFinTimeout: 0s

tcpTimeout: 0s

udpTimeout: 0s

kind: KubeProxyConfiguration

metricsBindAddress: ""

mode: "ipvs"

2、更新kube-proxy

[root@k8s-master1 ~]

3、所有节点进行验证

[root@k8s-master1 ~]

ipvs

[root@k8s-master2 ~]

ipvs

[root@k8s-master3 keepalived]

ipvs

[root@k8s-node1 ~]

ipvs

[root@k8s-node2 ~]

ipvs

十、学会查看官方文档 -> kubectl备忘录

🥇**官网地址:**https://kubernetes.io/

🥇**官方文档:**https://kubernetes.io/zh/docs/reference/kubectl/

十一、测试环境节省资源,驱离Node节点

🗡**注意:**进行驱离Node节点节省资源,驱离完成后,需要在master上部署Pod,但master节点上有污点,参考下方的 "问题解决 " 中的 < 2、master节点 无法部署非系统Pod >

1、驱离 k8s-node1

[root@k8s-master1 ~]

Flag --delete-local-data has been deprecated, This option is deprecated and will be deleted. Use --delete-emptydir-data.

node/k8s-node2 already cordoned

WARNING: ignoring DaemonSet-managed Pods: kube-system/calico-node-8zn7h, kube-system/kube-proxy-6t2b8

evicting pod kubernetes-dashboard/dashboard-metrics-scraper-7645f69d8c-78x8r

evicting pod default/nginx-deploy-7d5f68dc69-smjtv

evicting pod kube-system/coredns-54d67798b7-mkrmq

evicting pod kube-system/coredns-54d67798b7-7d676

evicting pod kube-system/metrics-server-545b8b99c6-d2ldd

pod/dashboard-metrics-scraper-7645f69d8c-78x8r evicted

pod/metrics-server-545b8b99c6-d2ldd evicted

pod/nginx-deploy-7d5f68dc69-smjtv evicted

pod/coredns-54d67798b7-mkrmq evicted

pod/coredns-54d67798b7-7d676 evicted

node/k8s-node2 evicted

[root@k8s-master1 ~]

NAME STATUS ROLES AGE VERSION

k8s-master01 Ready control-plane,master 37h v1.20.12

k8s-master2 Ready control-plane,master 37h v1.20.12

k8s-master3 Ready control-plane,master 37h v1.20.12

k8s-node1 Ready <none> 37h v1.20.12

k8s-node2 Ready,SchedulingDisabled <none> 37h v1.20.12

[root@k8s-master1 ~]

node "k8s-node2" deleted

[root@k8s-master1 ~]

NAME STATUS ROLES AGE VERSION

k8s-master01 Ready control-plane,master 37h v1.20.12

k8s-master2 Ready control-plane,master 37h v1.20.12

k8s-master3 Ready control-plane,master 37h v1.20.12

k8s-node1 Ready <none> 37h v1.20.12

2、驱离k8s-node2

[root@k8s-master1 ~]

Flag --delete-local-data has been deprecated, This option is deprecated and will be deleted. Use --delete-emptydir-data.

node/k8s-node1 cordoned

WARNING: ignoring DaemonSet-managed Pods: kube-system/calico-node-k86mh, kube-system/kube-proxy-rswpm

evicting pod kubernetes-dashboard/kubernetes-dashboard-78cb679857-gvfx2

evicting pod default/hello-f9jr6

evicting pod default/nginx-deploy-7d5f68dc69-v6s8p

evicting pod kube-system/calico-kube-controllers-5f6d4b864b-5tfck

evicting pod kube-system/metrics-server-545b8b99c6-jnc9r

evicting pod default/nginx-deploy-7d5f68dc69-xtrdr

pod/hello-f9jr6 evicted

pod/nginx-deploy-7d5f68dc69-xtrdr evicted

pod/metrics-server-545b8b99c6-jnc9r evicted

pod/kubernetes-dashboard-78cb679857-gvfx2 evicted

pod/nginx-deploy-7d5f68dc69-v6s8p evicted

pod/calico-kube-controllers-5f6d4b864b-5tfck evicted

node/k8s-node1 evicted

[root@k8s-master1 ~]

node "k8s-node1" deleted

[root@k8s-master1 ~]

NAME STATUS ROLES AGE VERSION

k8s-master01 Ready control-plane,master 37h v1.20.12

k8s-master2 Ready control-plane,master 37h v1.20.12

k8s-master3 Ready control-plane,master 37h v1.20.12

3、测试查看

**解析:**可以编写一个简单的 yaml 文件进行测试,查看 Pod部署的主机

[root@k8s-master1 ~]

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: nginx-deploy

name: nginx-deploy

spec:

replicas: 2

selector:

matchLabels:

app: nginx-deploy

template:

metadata:

labels:

app: nginx-deploy

spec:

containers:

- image: daocloud.io/library/nginx:latest

imagePullPolicy: IfNotPresent

name: nginx

---

apiVersion: v1

kind: Service

metadata:

name: nginx-svc

spec:

type: NodePort

ports:

- name: http

port: 80

targetPort: 80

nodePort: 80

selector:

app: nginx-deploy

[root@k8s-master1 ~]

NAME READY STATUS RESTARTS AGE IP NODE

nginx-deploy-7d5f68dc69-hjnhq 1/1 Running 0 28s 172.171.95.195 k8s-master3

nginx-deploy-7d5f68dc69-nvj4b 1/1 Running 0 22s 172.170.159.132 k8s-master01

十二、问题解决

1、加入集群的 Token 过期

🔺**注意:**Token值在集群初始化后,有效期为 24小时 ,过了24小时过期。进行重新生成Token,再次加入集群,新生成的Token为 2小时。

1.1、生成Node节点加入集群的 Token

[root@k8s-master1 ~]

kubeadm join 192.168.178.200:16443 --token menw99.1hbsurvl5fiz119n --discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab865 12420215242c4313fb830a4eb98

1.2、生成Master节点加入集群的 --certificate-key

[root@k8s-master1 ~]

I1105 12:33:08.201601 93226 version.go:254] remote version is much newer: v1.22.3; falling back to: stable-1.20

[upload-certs] Storing the certificates in Secret "kubeadm-certs" in the "kube-system" Namespace

[upload-certs] Using certificate key:

38dba94af7a38700c3698b8acdf8e23f273be07877f5c86f4977dc023e333deb

kubeadm join 192.168.178.200:16443 --token menw99.1hbsurvl5fiz119n --discovery-token-ca-cert-hash sha256:e76e4525ca29a9ccd5c24142a724bdb6ab86512420215242c4313fb830a4eb98 \

--control-plane --certificate-key 38dba94af7a38700c3698b8acdf8e23f273be07877f5c86f4977dc023e333deb

2、master节点 无法部署非系统Pod

**解析:**主要是因为master节点被加上污点,污点是不允许部署非系统 Pod,在 测试 环境,可以将污点去除,节省资源,可利用率。

2.1、查看污点

[root@k8s-master1 ~]

Taints: node-role.kubernetes.io/master:NoSchedule

Taints: node-role.kubernetes.io/master:NoSchedule

Taints: node-role.kubernetes.io/master:NoSchedule

2.2、取消污点

[root@k8s-master1 ~]

node/k8s-master01 untainted

node/k8s-master02 untainted

node/k8s-master03 untainted

[root@k8s-master1 ~]

Taints: <none>

Taints: <none>

Taints: <none>

3、修改NodePort的默认端口

原理: 默认k8s的使用端口的范围为30000左右,作为对外部提供的端口。我们也可以通过对配置文件的修改去指定默认的对外端口的范围。

The Service "nginx-svc" is invalid: spec.ports[0].nodePort: Invalid value: 80: provided port is not in the valid range. The range of valid ports is 30000-32767

[root@k8s-master1 ~]

- --service-cluster-ip-range=10.96.0.0/12

- --service-node-port-range=1-65535

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)