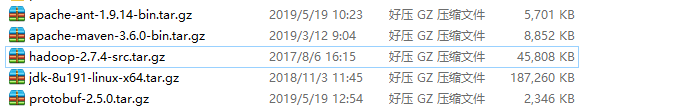

一、所需工具

JDK

maven

protobuf

CMake

ant

hadoop-2.x.x-src

如下所示:

二、安装

1、安装jdk

2、安装maven

可以参考如下地址:

https://blog.csdn.net/qq_26709459/article/details/80466239

3、安装protobuf

首先安装如下工具:

yum install gcc

yum install gcc-c++

yum install make

安装完如上工具后开始安装protobuf:

先解压

tar -zvxf protobuf-2.5.0.tar.gz

进入解压目录:

cd protobuf-2.5.0

执行如下命令

./ configure

make

make install

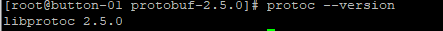

查看是否安装成功

protoc --version

如下所示:

4、安装CMake

yum install cmake

yum install openssl-devel

yum install ncurses-devel

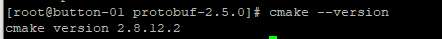

查看当前版本:

cmake --version

如下所示:

5、安装ant

解压:

tar -zxvf apache-ant-1.9.14-bin.tar.gz

配置环境变量:

vim /etc/profile

加入如下内容:

export ANT_HOME=/usr/local/dev/ant/apache-ant-1.9.14

export PATH=.:$PATH:$JAVA_HOME/bin:$MAVEN_HOME/bin:$ANT_HOME/bin

注:ant目录根据自己目录配置。

让配置生效:

source /etc/profile

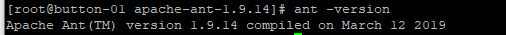

查看是否安装成功:

ant -version

6、编译hadoop源码包

解压:

tar -zxvf hadoop-2.7.4-src.tar.gz

解压之后进入解压目录,可以看到里面有一个“BUILDING.txt”文件,里面注明了编译所需要的一些环境要求。

进入解压目录:

cd hadoop-2.7.4-src/

编译hadoop:

mvn package -Pdist -DskipTests -Dtar -Dmaven.javadoc.skip=true 仅编译正常源码部分,对于native部分不进行编译,最终结果打包

或

mvn package -Pdist,native,docs -DskipTests -Dtar 编译正常部分源码、native依赖库以及帮助文档,最终结果打包

看到如下信息则表示编译成功:

[INFO] Executed tasks

[INFO]

[INFO] --- maven-javadoc-plugin:2.8.1:jar (module-javadocs) @ hadoop-dist ---

[INFO] Skipping javadoc generation

[INFO] ------------------------------------------------------------------------

[INFO] Reactor Summary for Apache Hadoop Main 2.7.4:

[INFO]

[INFO] Apache Hadoop Main ................................. SUCCESS [01:29 min]

[INFO] Apache Hadoop Build Tools .......................... SUCCESS [ 53.817 s]

[INFO] Apache Hadoop Project POM .......................... SUCCESS [ 18.119 s]

[INFO] Apache Hadoop Annotations .......................... SUCCESS [ 10.544 s]

[INFO] Apache Hadoop Assemblies ........................... SUCCESS [ 0.321 s]

[INFO] Apache Hadoop Project Dist POM ..................... SUCCESS [ 14.711 s]

[INFO] Apache Hadoop Maven Plugins ........................ SUCCESS [ 23.348 s]

[INFO] Apache Hadoop MiniKDC .............................. SUCCESS [05:00 min]

[INFO] Apache Hadoop Auth ................................. SUCCESS [02:37 min]

[INFO] Apache Hadoop Auth Examples ........................ SUCCESS [ 12.242 s]

[INFO] Apache Hadoop Common ............................... SUCCESS [03:05 min]

[INFO] Apache Hadoop NFS .................................. SUCCESS [ 1.767 s]

[INFO] Apache Hadoop KMS .................................. SUCCESS [ 36.501 s]

[INFO] Apache Hadoop Common Project ....................... SUCCESS [ 0.108 s]

[INFO] Apache Hadoop HDFS ................................. SUCCESS [01:10 min]

[INFO] Apache Hadoop HttpFS ............................... SUCCESS [ 12.646 s]

[INFO] Apache Hadoop HDFS BookKeeper Journal .............. SUCCESS [ 27.643 s]

[INFO] Apache Hadoop HDFS-NFS ............................. SUCCESS [ 1.616 s]

[INFO] Apache Hadoop HDFS Project ......................... SUCCESS [ 0.105 s]

[INFO] hadoop-yarn ........................................ SUCCESS [ 0.097 s]

[INFO] hadoop-yarn-api .................................... SUCCESS [ 8.547 s]

[INFO] hadoop-yarn-common ................................. SUCCESS [01:28 min]

[INFO] hadoop-yarn-server ................................. SUCCESS [ 0.109 s]

[INFO] hadoop-yarn-server-common .......................... SUCCESS [ 2.192 s]

[INFO] hadoop-yarn-server-nodemanager ..................... SUCCESS [ 4.270 s]

[INFO] hadoop-yarn-server-web-proxy ....................... SUCCESS [ 1.050 s]

[INFO] hadoop-yarn-server-applicationhistoryservice ....... SUCCESS [ 2.050 s]

[INFO] hadoop-yarn-server-resourcemanager ................. SUCCESS [ 8.709 s]

[INFO] hadoop-yarn-server-tests ........................... SUCCESS [ 1.530 s]

[INFO] hadoop-yarn-client ................................. SUCCESS [ 1.893 s]

[INFO] hadoop-yarn-server-sharedcachemanager .............. SUCCESS [ 1.269 s]

[INFO] hadoop-yarn-applications ........................... SUCCESS [ 0.082 s]

[INFO] hadoop-yarn-applications-distributedshell .......... SUCCESS [ 0.911 s]

[INFO] hadoop-yarn-applications-unmanaged-am-launcher ..... SUCCESS [ 0.735 s]

[INFO] hadoop-yarn-site ................................... SUCCESS [ 0.069 s]

[INFO] hadoop-yarn-registry ............................... SUCCESS [ 1.555 s]

[INFO] hadoop-yarn-project ................................ SUCCESS [ 4.385 s]

[INFO] hadoop-mapreduce-client ............................ SUCCESS [ 0.251 s]

[INFO] hadoop-mapreduce-client-core ....................... SUCCESS [ 5.753 s]

[INFO] hadoop-mapreduce-client-common ..................... SUCCESS [ 3.817 s]

[INFO] hadoop-mapreduce-client-shuffle .................... SUCCESS [ 1.173 s]

[INFO] hadoop-mapreduce-client-app ........................ SUCCESS [ 3.562 s]

[INFO] hadoop-mapreduce-client-hs ......................... SUCCESS [ 2.683 s]

[INFO] hadoop-mapreduce-client-jobclient .................. SUCCESS [ 9.222 s]

[INFO] hadoop-mapreduce-client-hs-plugins ................. SUCCESS [ 0.567 s]

[INFO] Apache Hadoop MapReduce Examples ................... SUCCESS [ 1.940 s]

[INFO] hadoop-mapreduce ................................... SUCCESS [ 2.674 s]

[INFO] Apache Hadoop MapReduce Streaming .................. SUCCESS [ 5.085 s]

[INFO] Apache Hadoop Distributed Copy ..................... SUCCESS [ 12.091 s]

[INFO] Apache Hadoop Archives ............................. SUCCESS [ 0.626 s]

[INFO] Apache Hadoop Rumen ................................ SUCCESS [ 1.251 s]

[INFO] Apache Hadoop Gridmix .............................. SUCCESS [ 1.378 s]

[INFO] Apache Hadoop Data Join ............................ SUCCESS [ 0.551 s]

[INFO] Apache Hadoop Ant Tasks ............................ SUCCESS [ 0.330 s]

[INFO] Apache Hadoop Extras ............................... SUCCESS [ 0.701 s]

[INFO] Apache Hadoop Pipes ................................ SUCCESS [ 0.055 s]

[INFO] Apache Hadoop OpenStack support .................... SUCCESS [ 0.960 s]

[INFO] Apache Hadoop Amazon Web Services support .......... SUCCESS [01:13 min]

[INFO] Apache Hadoop Azure support ........................ SUCCESS [ 13.848 s]

[INFO] Apache Hadoop Client ............................... SUCCESS [ 5.496 s]

[INFO] Apache Hadoop Mini-Cluster ......................... SUCCESS [ 1.881 s]

[INFO] Apache Hadoop Scheduler Load Simulator ............. SUCCESS [ 2.662 s]

[INFO] Apache Hadoop Tools Dist ........................... SUCCESS [ 4.871 s]

[INFO] Apache Hadoop Tools ................................ SUCCESS [ 0.068 s]

[INFO] Apache Hadoop Distribution ......................... SUCCESS [ 15.156 s]

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 22:54 min

[INFO] Finished at: 2019-05-29T21:30:38+08:00

[INFO] ------------------------------------------------------------------------

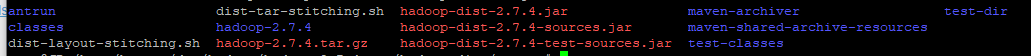

编译完成之后 hadoop-dist文件夹,进入里面的target就可以找到编译之后的安装包。

hadoop-2.7.4-src/hadoop-dist/target/hadoop-2.7.4.tar.gz

注:若编译过程中遇到错误,百度解决吧!!!

相关资料如下,需者自提:

链接:https://pan.baidu.com/s/13zaUO0y1VbUz4vF_vRHNDg

提取码:uy1c

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)