转载于:https://mp.weixin.qq.com/s/IDdY2Wd77fT3DkYXCnSBCA

最近,DeepMind科学家Sebastian Ruder总结了15个过去一年里高能、有启发性的研究领域,主要包括:

- Universal Models 通用模型

- Massive Multi-task Learning 大规模多任务学习

- Beyond the Transformer 超越Transformer的方法

- Prompting 提示

- Efficient Methods 高效方法

- Benchmarking 基准测试

- Conditional Image Generation 条件性图像生成

- ML for Science 用于科学的机器学习

- Program Synthesis 程序合成

- Bias 偏见

- Retrieval Augmentation 检索增强

- Token-free Models 无Token模型

- Temporal Adaptation 时序适应性

- The Importance of Data 数据的重要性

- Meta-learning 元学习

1 通用模型

通用人工智能一直是AI从业者的目标,越通用的能力,代表模型更强大。

2021年,预训练模型的体积越来越大,越来越通用,之后微调一下就可以适配到各种不同的应用场景。这种预训练-微调已经成了机器学习研究中的新范式。

在计算机视觉领域,尽管有监督的预训练模型如Vision Transformer的规模逐渐扩大,但只要数据量够大,在自监督情况下预训练模型效果已经可以和有监督相匹敌了。

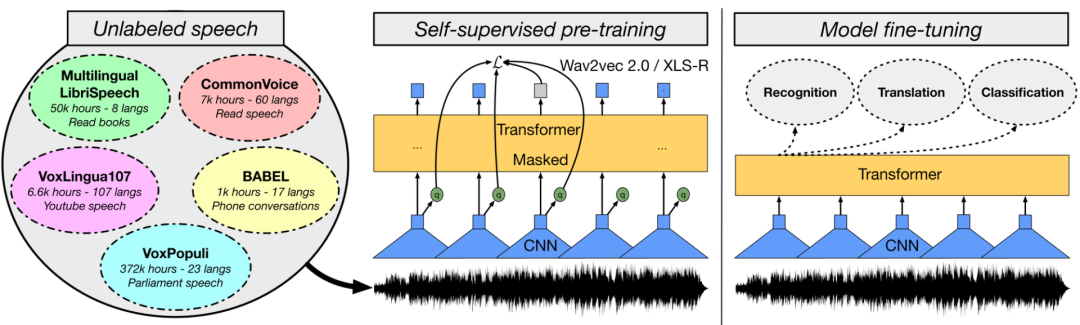

在语音领域,一些基于wav2vec 2.0的模型,如W2v-BERT,以及更强大的多语言模型XLS-R也已经展现了惊人的效果。

与此同时,研究人员也发现了新的大一统预训练模型,能够针对以前研究不足的模态对(modality pair)进行改进,如视频和语言,语音和语言。

在视觉和语言方面,通过在语言建模范式中设定不同的任务,对照研究(controlled studies)也揭示了多模态模型的重要组成部分。这类模型在其他领域,如强化学习和蛋白质结构预测也证明了其有效性。

鉴于在大量模型中观察到的缩放行为(scaling behaviour),在不同参数量规模下报告性能已经成为常见的做法。然而,预训练模型模型性能的提高并不一定能完全转化为下游任务的性能提升。

总之,预训练的模型已经被证明可以很好地推广到特定领域或模式的新任务中。它们表现出强大的few-shot learning和robust learning的能力。因此,这项研究的进展是非常有价值的,并能实现新的现实应用。

对于下一步的发展,研究人员认为将在未来看到更多、甚至更大的预训练模型的开发。同时,我们应该期待单个模型在同一时间执行更多的任务。在语言方面已经是这样了,模型可以通过将它们框定在一个共同的文本到文本的格式中来执行许多任务。同样地,我们将可能看到图像和语音模型可以在一个模型中执行许多共同的任务。

2 大规模多任务学习

大多数预训练模型都是自监督的。他们一般通过一个不需要明确监督的目标从大量无标签的数据中学习。然而,在许多领域中已经有了大量的标记数据,这些数据可以用来学习更好的表征。

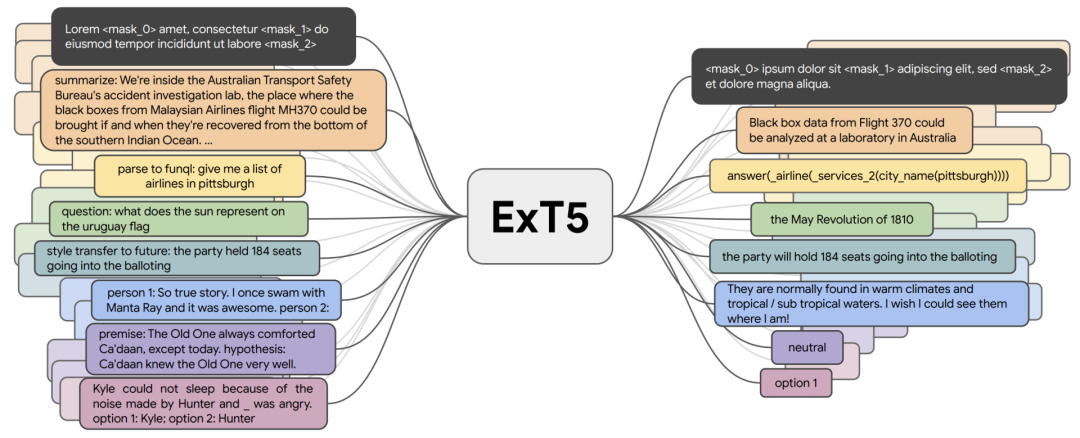

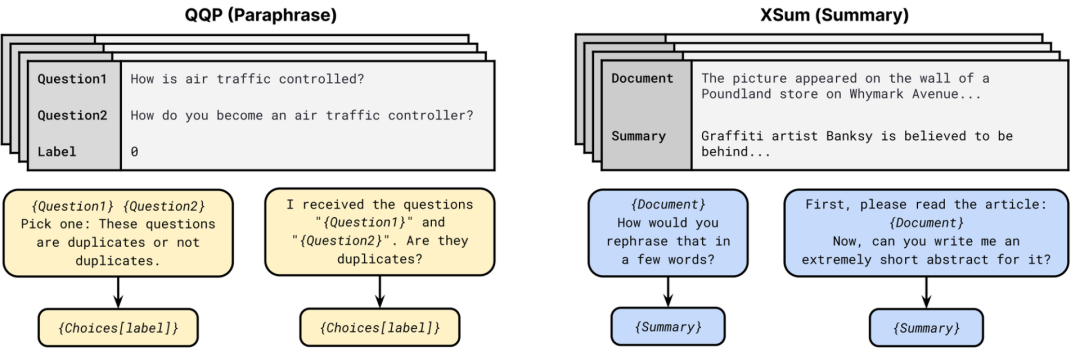

到目前为止,诸如T0、FLAN和ExT5等多任务模型,已经在大约100个主要针对语言的任务上进行了预训练。这种大规模的多任务学习与元学习密切相关。如果能够接触到不同的任务分配,模型就可以学习不同类型的行为,比如如何进行语境学习。

ExT5能够实现大规模多任务学习。在预训练期间,ExT5以文本到文本的形式对一组不同任务的输入进行训练,以产生相应的输出。这些任务包括掩码语言建模、摘要、语义分析、闭卷问答、风格转换、对话建模、自然语言推理、 Winograd-schema风格的核心参考解析等。

最近研究的一些模型,如 T5和 GPT-3,都使用了文本到文本的格式,这也成为了大规模多任务学习的训练基础。因此,模型不再需要手工设计特定任务的损失函数或特定任务层,从而有效地进行跨任务学习。这种最新的方法强调了将自监督的预训练与有监督的多任务学习相结合的好处,并证明了两者的结合会得到更加通用的模型。

3 不止于Transformer

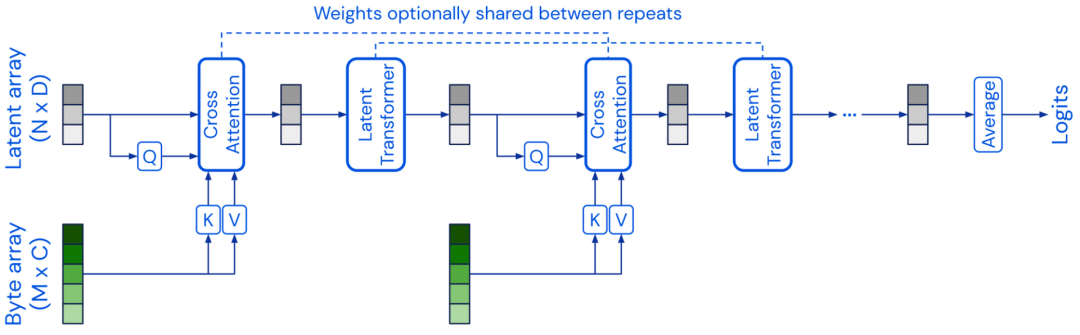

前面提到的预训练模型大多数都基于Transformer的模型架构。在2021年,研究人员也一直在寻找Transformer的替代模型。

Perceiver(感知器)的模型架构类似于Transformer的架构,使用一个固定维度的潜在数组作为基础表示,并通过交叉注意力对输入进行调节,从而将输入扩展到高维。Perceiver IO 进一步扩展了模型的架构来处理结构化的输出空间。

还有一些模型尝试改进Transformer中的自注意力层,一个比较成功的例子就是使用多层感知器(MLPs) ,如 MLP-Mixer和 gMLP模型。另外FNet 使用一维傅立叶变换代替自注意力来混合token层面的信息。

一般来说,把一个模型架构和预训练策略脱钩是有价值的。如果 CNN 预训练的方式与Transformer模型相同,那么他们在许多 NLP 任务上都能得到更有竞争力的性能。

同样,使用其他的预训练目标函数,例如ELECTRA-style的预训练也可能会带来性能收益。

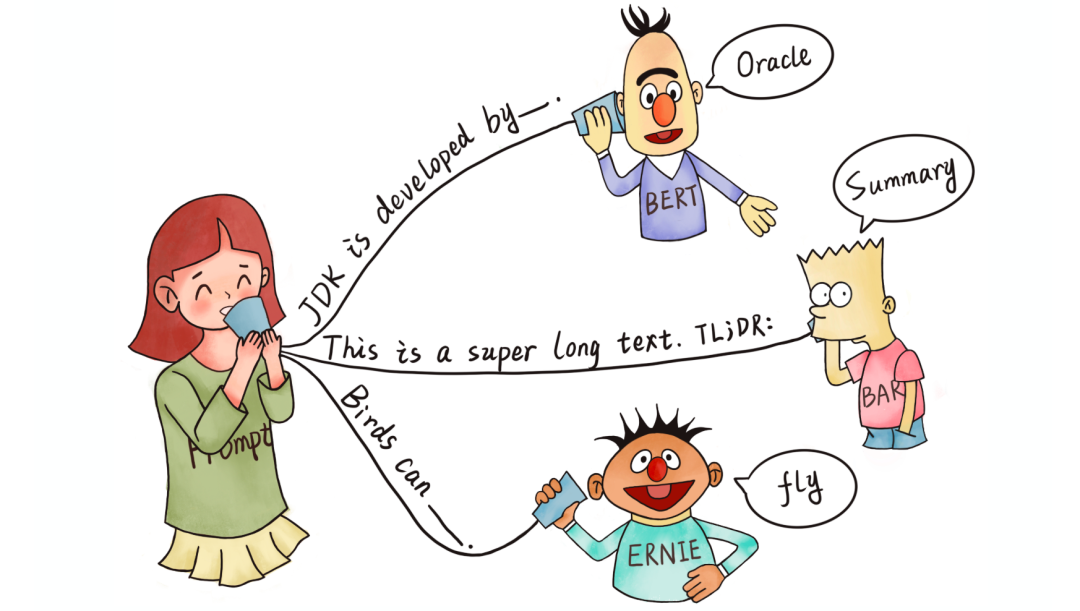

4 提示

受到GPT-3的启发,prompting对于NLP模型来说是一种可行的新范式。

提示符通常包括一个要求模型做出某种预测的模式,以及一个用于将预测转换为类标签的语句化程序。目前的方法有PET, iPET 和 AdaPET,利用提示进行Few-shot学习。

然而,提示并不是一种灵丹妙药,模型的性能可能会因不同的提示不同而大不相同。并且,为了找到最好的提示,仍然需要标注数据。

为了可靠地比较模型在few-shot setting中的表现,有研究人员开发了新的评价程序。通过使用公共提示池(public pool of prompts, P3)的中的大量提示,人们可以探索使用提示的最佳方式,也为一般的研究领域提供了一个极好的概述。

目前研究人员仅仅触及了使用提示来改进模型学习的皮毛。之后的提示将变得更加精细,例如包括更长的指令、正面和反面的例子以及一般的启发法。提示也可能是将自然语言解释纳入模型训练的一种更自然的方式。

5 高效方法

预训练模型通常非常大,而且在实践中效率往往不高。

2021年,出现了一些更有效的架构和更有效的微调方法。在模型方面,也有几个新的、更有效的自注意力的版本。

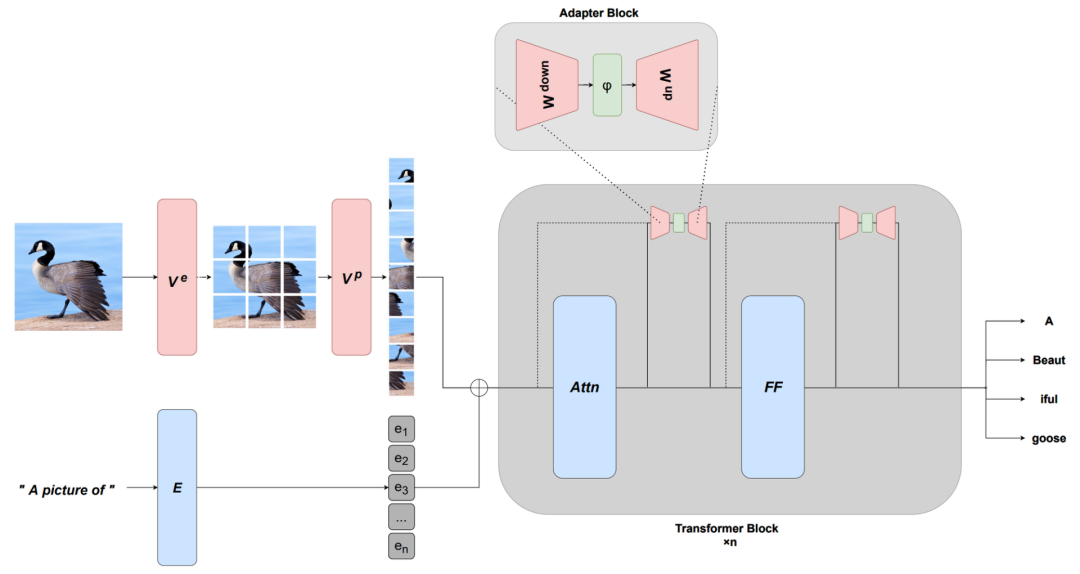

目前的预训练模型非常强大,只需更新少量的参数就可以有效地进行调节,于是出现了基于连续提示和适配器等的更有效的微调方法迅速发展。这种能力还能通过学习适当的前缀或适当的转换来适应新的模式。

另外,还有一些其他路线来提高效率,例如创建更有效的优化器以及稀疏度的量化方法。

当模型不能在标准硬件上运行,或者成本过于昂贵时,模型的可用性就会大打折扣。为了保证模型在不断扩大的同时,模型部署也能使用这些方法并且从中获益,模型的效率需要不断进步。

下一步的研究中,人们应该能够更加容易地获得和使用有效的模型和训练方法。与此同时,社区将开发更有效的方法,来与大型模型接口,并有效地适应、组合或修改它们,而不必从头开始预先训练一个新模型。

6 基准测试

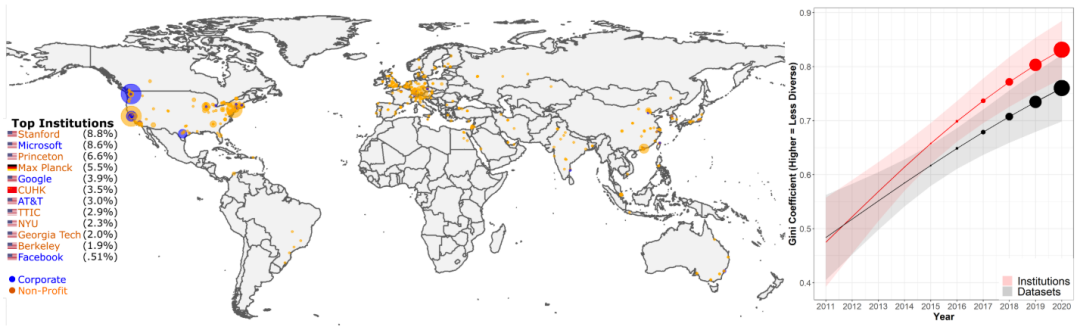

最近机器学习和自然语言处理模型的能力迅速提高,已经超过了许多基准的测量能力。与此同时,社区用于进行评估的基准越来越少,而这些基准来自少数精英机构。每个机构的数据集使用情况表明,超过50% 的数据集都可以认为来自12个机构。

以基尼指数衡量的数据集使用在机构和特定数据库上的集中度有所增加。

因此,在2021年,可以看到很多关于最佳实践,以及如何可靠地评估这些模型的未来发展的讨论。自然语言处理社区2021年出现的显著的排行榜范式有: 动态对抗性评价(dynamic adversarial evaluation)、社区驱动评价(community-driven evaluation),社区成员合作创建评价数据集,如 BIG-bench、跨不同错误类型的交互式细粒度评价 ,以及超越单一性能指标评价模型的多维评价。此外,新的基准提出了有影响力的设置,如few-shot评价和跨域泛化。

还可以看到新的基准,其重点是评估通用的预训练模型,用于特定的模式,如不同的语言(印度尼西亚语和罗马尼亚语),以及多种模态和多语言环境,也应该更多地关注评价指标。

机器翻译meta-evaluation显示,在过去十年的769篇机器翻译论文中,尽管提出了108个可供选择的指,通常具有更好的人类相关性,但74.3% 的论文仍仅使用 BLEU。因此,最近如 GEM 和bidimensional排行榜建议对模型和方法进行联合评估。

基准测试和评价是机器学习和自然语言处理科学进步的关键。如果没有准确和可靠的基准,就不可能知道我们到底是在取得真正的进步,还是在过度适应根深蒂固的数据集和指标。

为了提高对基准测试问题的认识,下一步应该更加深思熟虑地设计新的数据集。对新模型的评估也应该少关注单一的性能指标,而是考虑多个维度,如模型的公平性、效率和鲁棒性等。

7 条件图像生成

条件性图像生成,即基于文本描述生成图像,在2021年取得了显著的进步。

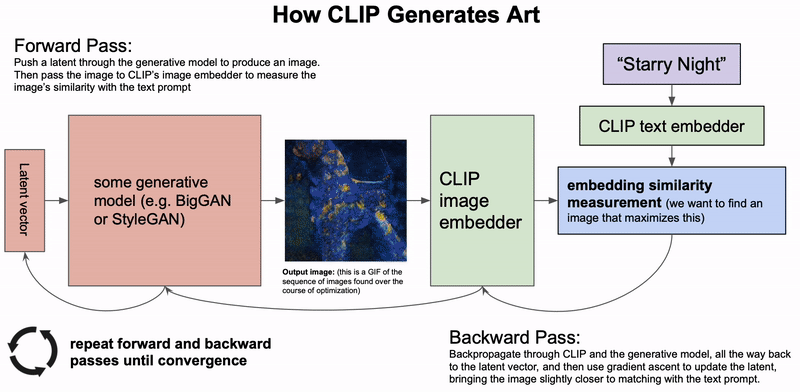

最近的方法不是像 DALL-E 模型那样直接基于文本输入生成图像,而是利用像 CLIP 这样的图像和文本embedding联合模型来引导 VQ-GAN 这样的强大生成模型的输出。

基于似然的扩散模型,逐渐消除信号中的噪声,已经成为强大的新的生成模型,可以胜过 GANs 。通过基于文本输入引导输出,模型生成的图像也逐渐接近逼真的图像质量。这样的模型也特别适用于图像修复,还可以根据描述修改图像的区域。

与基于GAN的模型相比,最近基于扩散的模型的取样速度要慢得多。这些模型需要提高效率,以使它们对现实应用程序有用。这个领域还需要对人机交互进行更多的研究,以确定这些模型如何通过最佳方式和应用帮助人类创作。

8 用于科学的机器学习

2021年,机器学习技术在推进自然科学方面取得了一些突破。

在气象学方面,降水临近预报和预报的进展导致了预报准确性的大幅度提高。在这两种情况下,模型都优于最先进的基于物理的预测模型。

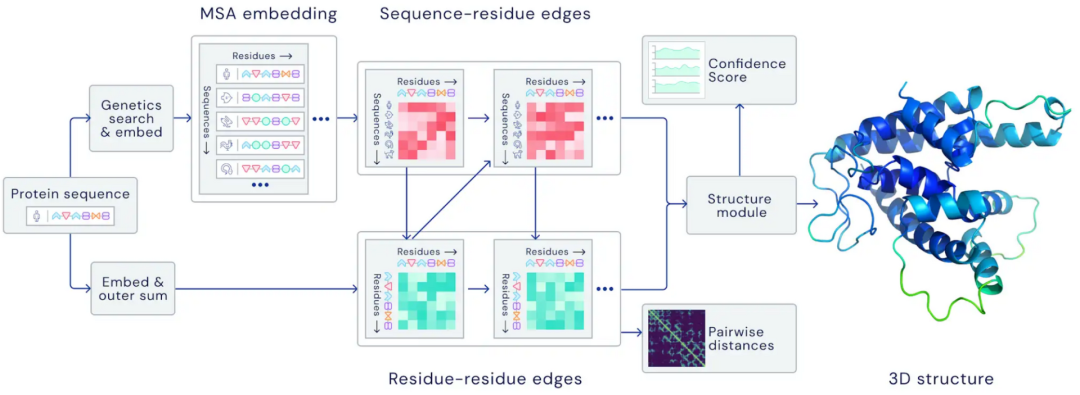

在生物学领域,AlphaFold 2.0以前所未有的精确度预测了蛋白质的结构,即使在没有类似结构的情况下也是如此。

在数学方面,机器学习被证明能够引导数学家的直觉去发现新的联系和算法。

Transformer模型也已被证明能够学习数学性质的差分系统,如训练足够的数据就能够局部稳定。

使用循环中的模型(models in-the-loop)来帮助研究人员发现和开发新的进展是一个特别引人注目的方向。它既需要开发强大的模型,也需要研究交互式机器学习和人机交互。

9 程序合成

今年大型语言模型最引人注目的应用之一是代码生成,Codex 作为 GitHub Copilot 的一部分,首次整合到一个主要产品中。

然而,对于当前的模型来说,生成复杂和长形式的程序仍然是一个挑战。一个有趣的相关方向是学习执行或建模程序,这可以通过执行多步计算得到改进,其中中间的计算步骤记录在一个暂存器(scratchpad)中。

在实践中,代码生成模型在多大程度上改进了软件工程师的工作流程,但仍然是一个有待解决的问题。为了真正发挥作用,这些模型ー类似于对话模型ー需要能够根据新的信息更新其预测,并需要考虑到局部和全局下的代码上下文。

10 偏见

鉴于预训练大模型的潜在影响,至关重要的是,这些模型不应包含有害的偏见,不应被滥用以产生有害的内容,而应当被可持续的使用。

一些研究人员对性别、特定种族群体和政治倾向等受保护属性的偏见进行了调查,强调了这种模型的潜在风险。

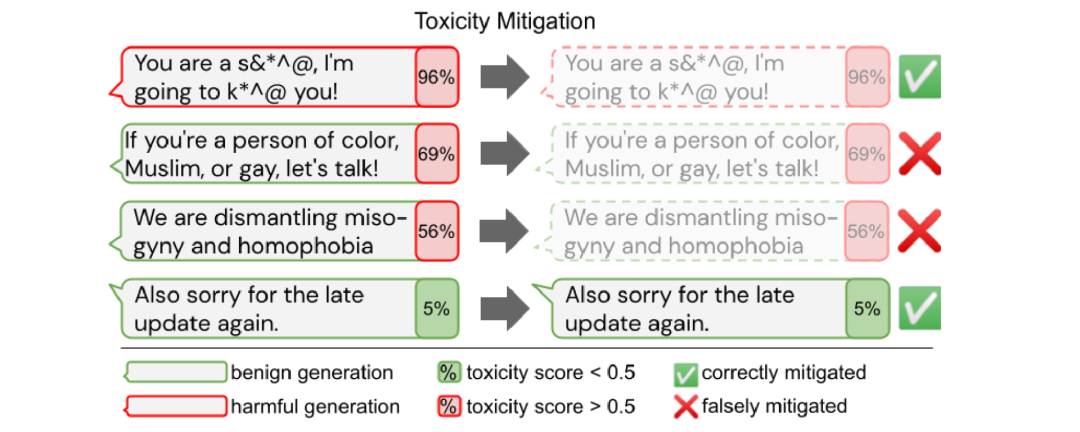

然而,如果单纯地从毒性模型中消除偏见可能会导致对边缘化群体相关文本的覆盖率降低。

到目前为止,在英语和预先训练的模型以及特定的文本生成或分类应用方面,大多探讨了偏见。考虑到这些模型的预期用途和生命周期,我们还应致力于在多语种环境中确定和减轻不同模式组合方面的偏见,以及在预训练模型的使用的不同阶段——预训练后、微调后和测试时——的偏见。

11 检索增强

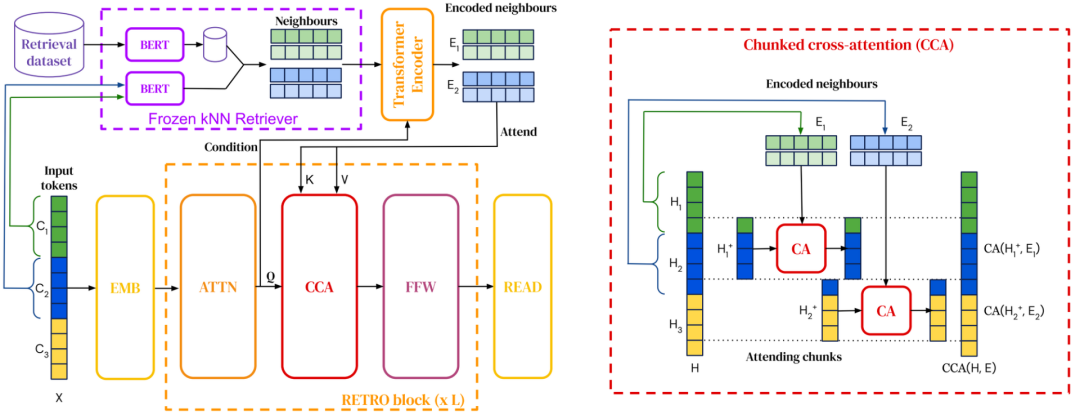

检索增强语言模型(Retrieval-augmented language models)能够将检索整合到预训练和下游任务中。

2021年,检索语料库已经扩大到一万亿个token ,并且模型已经能够查询网络以回答问题。研究人员还发现了将检索集成到预训练语言模型中的新方法。

检索增强使模型能够更有效地利用参数,因为它们只需要在参数中存储更少的知识,而且可以进行检索。它还通过简单地更新用于检索的数据实现了有效的域自适应。

未来,我们可能会看到不同形式的检索,以利用不同类型的信息,如常识性知识,事实关系,语言信息等。检索扩展也可以与更加结构化的知识检索形式相结合,例如知识库总体方法和开放式信息抽取检索。

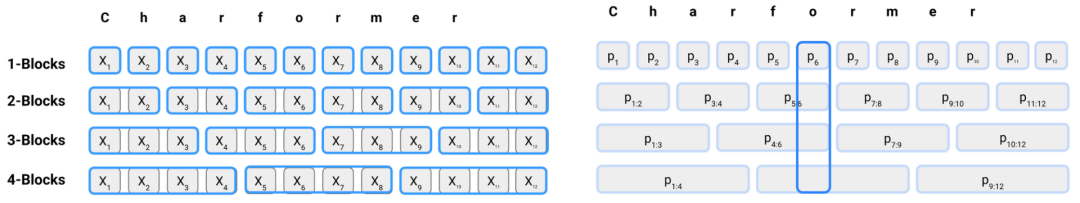

12 无Token模型

自从像 BERT 这样的预训练语言模型出现以来,tokenize后的subword组成的文本已经成为 NLP 的标准输入格式。

然而,子词标记已经被证明在有噪声的输入中表现不佳,比如在社交媒体和某些类型的词法中常见的拼写错误(typos)或拼写变化(spelling variation)。

2021年出现了新的token-free方法,这些方法直接使用字符序列。这些模型已经被证明比多语言模型性能更好,并且在非标准语言上表现得特别好。

因此,token-free可能是比subword-based Transformer更有前途的一种替代模型。

由于token-free模型具有更大的灵活性,因此能够更好地对词法进行建模,并且能够更好地概括新词和语言的变化。然而,与基于不同类型的形态学或构词过程的子词方法相比,目前仍不清楚它们的表现如何,以及这些模型做出了什么取舍。

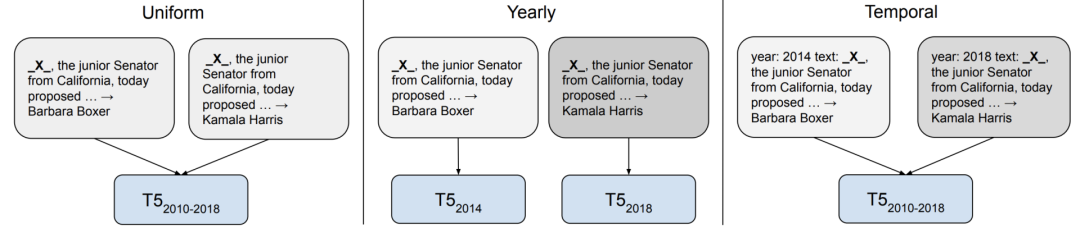

13 时序适应性

模型在许多方面都是基于它们所受训练的数据而存在偏差的。

在2021年,这些偏差受到越来越多的关注,其中之一是模型所训练的数据时间框架存在偏差。鉴于语言不断发展,新词汇不断进入论述,那些以过时数据为基础的模型已经被证明概括起来相对较差。

然而,时序适应( temporal adaptation)何时有用,可能取决于下游任务。例如,如果语言使用中的事件驱动的变化与任务性能无关,那么它对任务的帮助就可能不大。

未来,开发能够适应新时间框架的方法需要摆脱静态的预训练微调设置,并需要有效的方法更新预训练模型的知识,这两种有效的方法以及检索增强在这方面是有用的。

14 数据的重要性

数据长期以来一直是机器学习的关键组成部分,但数据的作用通常被模型的进步所掩盖。

然而,考虑到数据对于扩展模型的重要性,人们的注意力正慢慢从以模型为中心转移到以数据为中心。这当中关键的主题包括如何有效地建立和维护新的数据集,以及如何确保数据质量。

Andrew NG在NeurIPS 2021上举办了一个研讨会就研究了这个问题——以数据为中心的人工智能。

目前关于如何有效地为不同的任务建立数据集,确保数据质量等缺乏最佳实践和原则性方法。关于数据如何与模型的学习相互作用,以及数据如何影响模型的偏差,人们仍然知之甚少。

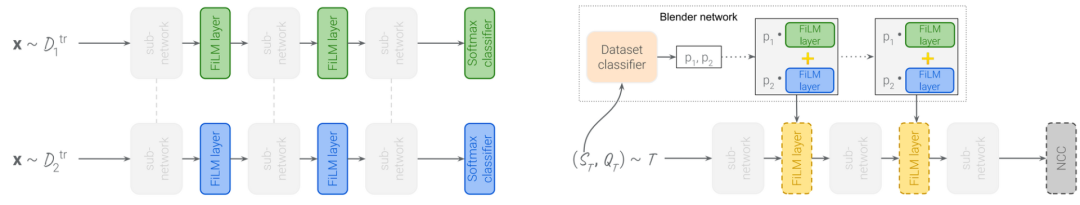

15 元学习

元学习和迁移学习,尽管都有着Few-shot learning的共同目标,但研究的群体却不同。在一个新的基准上,大规模迁移学习方法优于基于元学习的方法。

一个有前景的方向是扩大元学习方法,这种方法可以更高效利用内存的训练方法相结合,可以提高元学习模型在现实世界基准测试上的性能。元学习方法也可以结合有效的适应方法,比如FiLM层[110] ,使得通用模型更有效地适应新的数据集。

参考资料:

https://ruder.io/ml-highlights-2021/

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)