大数据分析引擎之presto简介

简介:

presto是一个大数据分析引擎,不属于hadoop体系,他是基于内存的。他的集群模式是主从式的。

他可以与任何的大数据存储引擎做集成,集成的时候使用它的Connectors集成

从这里我们可以他可以和kafka、mysql、内存、hive来做集成

安装:

1.解压:tar -zxvf presto-server-0.217.tar.gz -C ~/training/

2.创建etc目录,并包含以下配置文件

cd ~/training/presto-server-0.217/

mkdir etc

① Node Properties: 节点的配置信息

② JVM Config: 命令行工具的JVM配置参数

③ Config Properties: Presto Server的配置参数

④ Catalog Properties: 数据源(Connectors)的配置参数

⑤ Log Properties:日志参数配置

node.properties

#集群名称。所有在同一个集群中的Presto节点必须拥有相同的集群名称。

node.environment=production

#每个Presto节点的唯一标示。每个节点的node.id都必须是唯一的。在Presto进行重启或者升级过程中每个节点的node.id必须保持不变。如果在一个节点上安装多个Presto实例(例如:在同一台机器上安装多个Presto节点),那么每个Presto节点必须拥有唯一的node.id。

node.id=ffffffff-ffff-ffff-ffff-ffffffffffff

# 数据存储目录的位置(操作系统上的路径)。Presto将会把日期和数据存储在这个目录下。

node.data-dir=/root/training/presto-server-0.217/data

jvm.config(内存相关配置)

-server

-Xmx16G

-XX:+UseG1GC

-XX:G1HeapRegionSize=32M

-XX:+UseGCOverheadLimit

-XX:+ExplicitGCInvokesConcurrent

-XX:+HeapDumpOnOutOfMemoryError

-XX:+ExitOnOutOfMemoryError

config.properties(因为测试用到的一台虚拟机所以我们只简单配置一个文件就行了,如果我们是全分布式的需要配置主节点和从节点的)

coordinator=true

node-scheduler.include-coordinator=true

http-server.http.port=8080

query.max-memory=5GB

query.max-memory-per-node=1GB

query.max-total-memory-per-node=2GB

discovery-server.enabled=true

discovery.uri=http://192.168.112.111:8080

log.properties (日志相关配置)

com.facebook.presto=INFO

集成hive,集成hive的时候我们必须在presto的etc文件夹下创建一个catalog目录,所有集成数据源都在这里配置

mkdir /root/training/presto-server-0.217/etc/catalog

hive.properties(集成hive的配置文件)

#注明hadoop的版本

connector.name=hive-hadoop2

#hive-site中配置的地址

hive.metastore.uri=thrift://192.168.157.111:9083

#hadoop的配置文件路径

hive.config.resources=/root/training/hadoop-3.1.2/etc/hadoop/core-site.xml,/root/training/hadoop-3.1.2/etc/hadoop/hdfs-site.xml

注意:要访问Hive的话,需要将Hive的MetaStore启动:hive --service metastore

这个窗口不能关掉

用来另一个窗口启动Presto

启动Presto Server

./launcher start

运行presto-cli

下载:presto-cli-0.217-executable.jar

重命名jar包,并增加执行权限

cp presto-cli-0.217-executable.jar presto

chmod a+x presto

连接Presto Server

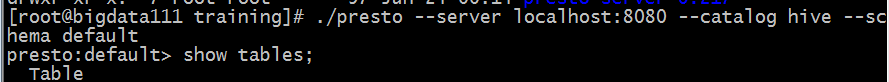

./presto --server localhost:8080 --catalog hive --schema default

然后我们使用presto命令行模式连接到hive的default默认的数据库中

可以使用show tables查看一下default库中的table,并查看一下它里边的表

这样我们就把presto配置完成了