在应用机器学习算法时,我们常采用梯度下降法来对才用的算法进行训练。梯度下降法有三种不同的形式:批量梯度下降(Batch Gradient Descent)、随机梯度下降(Stochastic Gradient Descent)以及小批量梯度下降(Mini-Batch Gradient Descent)。接下来,我们将对这三种不同的梯度下降法进行理解。

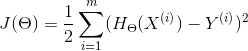

梯度下降算法需要对损失函数求梯度,也就是求导。一般线性函数对应的损失函数为:

一、批量梯度下降(Batch Gradient Descent,BGD)

批量梯度下降法是最原始的形式,它是指在每一次迭代时使用所有样本来进行梯度的更新。从数学上理解如下:

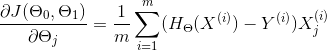

(1)对目标函数求偏导:

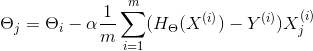

(2)每次迭代对参数进行更新:

我们要不断重复这一步直到算法收敛,也就是参数不断更新,直到梯度为0。但是,我们的每次迭代更新,都要对所有的m个样本数据进行求和。

那么我们如何检测参数是否已经收敛了呢?一种是检验两次迭代,如果两次迭代中,是否改变了很多&#x