源码地址:

该项目代码在本人GitHub代码仓库开源,本人GitHub主页为:GitHub

项目代码:

https://github.com/guojin-yan/Inference/blob/master/tensorrt/cpp_tensorrt_yolov5/cpp_tensorrt_yolov5.cpp

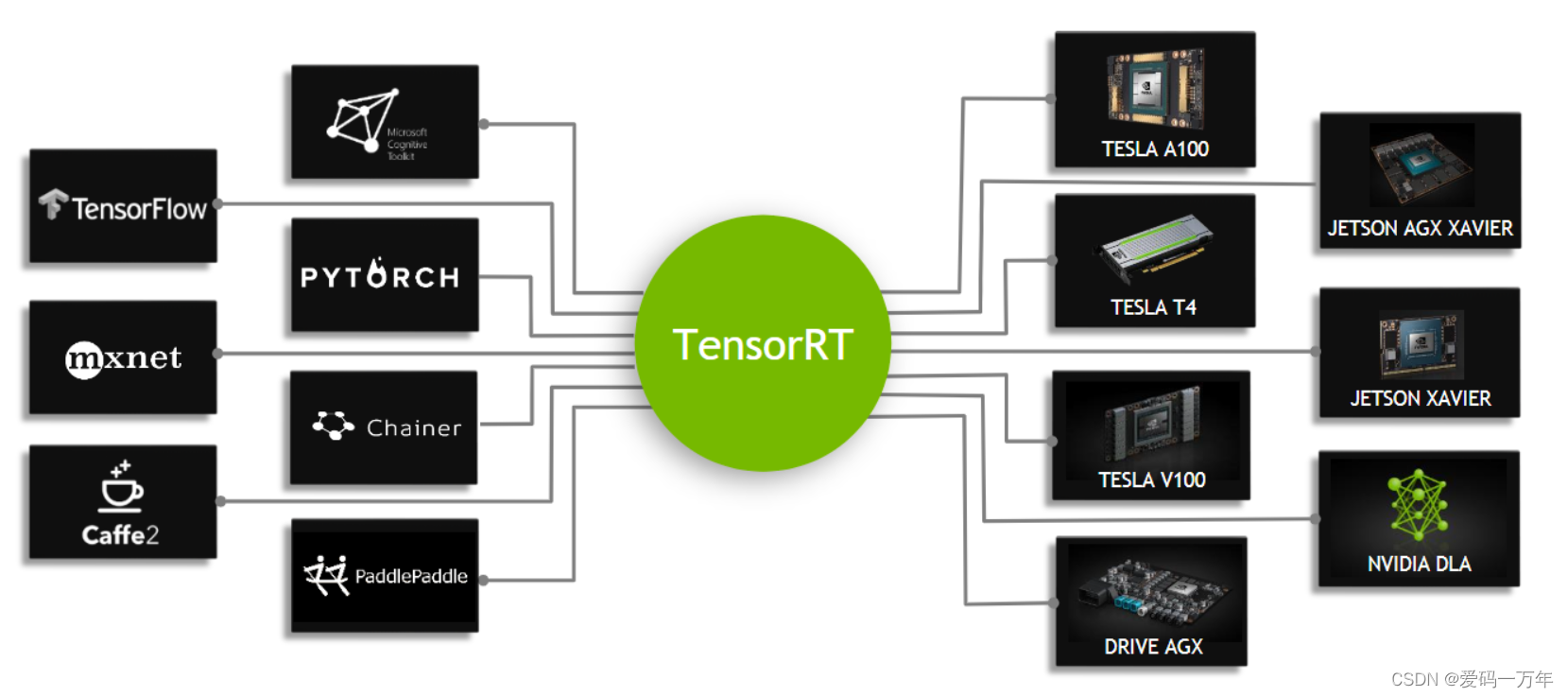

NVIDIA TensorRT™ 是用于高性能深度学习推理的 SDK,可为深度学习推理应用提供低延迟和高吞吐量。详细安装方式参考以下博客: NVIDIA TensorRT 安装 (Windows C++)

1. TensorRT部署模型基本步骤

经典的一个TensorRT部署模型步骤为:onnx模型转engine、读取本地模型、创建推理引擎、创建推理上下文、创建GPU显存缓冲区、配置输入数据、模型推理以及处理推理结果。

1.1 onnx模型转engine

TensorRT支持多种模型文件,不过随着onnx模型的发展,目前多种模型框架都将onnx模型当作中间转换格式,是的该模型结构变得越来越通用,因此TensorRT目前主要在更新的就是针对该模型的转换。TensorRT是可以直接读取engine文件,对于onnx模型需要进行一些列转换配置,转为engine引擎才可以进行后续的推理,因此在进行模型推理前,需要先进行模型的转换。项目中已经提供了转换方法接口:

void onnx_to_engine(std::string onnx_file_path, std::string engine_file_path, int type) {

// 构建器,获取cuda内核目录以获取最快的实现

// 用于创建config、network、engine的其他对象的核心类

nvinfer1::IBuilder* builder = nvinfer1::createInferBuilder(gLogger);

const auto explicitBatch = 1U << static_cast<uint32_t>(nvinfer1::NetworkDefinitionCreationFlag::kEXPLICIT_BATCH);

// 解析onnx网络文件

// tensorRT模型类

nvinfer1::INetworkDefinition* network = builder->createNetworkV2(explicitBatch);

// onnx文件解析类

// 将onnx文件解析,并填充rensorRT网络结构

nvonnxparser::IParser* parser = nvonnxparser::createParser(*network, gLogger);

// 解析onnx文件

parser->parseFromFile(onnx_file_path.c_str(), 2);

for (int i = 0; i < parser->getNbErrors(); ++i) {

std::cout << "load error: " << parser->getError(i)->desc() << std::endl;

}

printf("tensorRT load mask onnx model successfully!!!...\n");

// 创建推理引擎

// 创建生成器配置对象。

nvinfer1::IBuilderConfig* config = builder->createBuilderConfig();

// 设置最大工作空间大小。

config->setMaxWorkspaceSize(16 * (1 << 20));

// 设置模型输出精度

if (type == 1) {

config->setFlag(nvinfer1::BuilderFlag::kFP16);

}

if (type == 2) {

config->setFlag(nvinfer1::BuilderFlag::kINT8);

}

// 创建推理引擎

nvinfer1::ICudaEngine* engine = builder->buildEngineWithConfig(*network, *config);

// 将推理银枪保存到本地

std::cout << "try to save engine file now~~~" << std::endl;

std::ofstream file_ptr(engine_file_path, std::ios::binary);

if (!file_ptr) {

std::cerr << "could not open plan output file" << std::endl;

return;

}

// 将模型转化为文件流数据

nvinfer1::IHostMemory* model_stream = engine->serialize();

// 将文件保存到本地

file_ptr.write(reinterpret_cast<const char*>(model_stream->data()), model_stream->size());

// 销毁创建的对象

model_stream->destroy();

engine->destroy();

network->destroy();

parser->destroy();

std::cout << "convert onnx model to TensorRT engine model successfully!" << std::endl;

}

1.2 读取本地模型

此处读取本地模型为读取上一步保存在本地的engine二进制文件,将模型文件信息读取到内存中。该文件保存了模型的所有信息以及电脑的配置信息,因此该模型文件不支持在不同电脑上使用。

std::ifstream file_ptr(model_path_engine, std::ios::binary);

size_t size = 0;

file_ptr.seekg(0, file_ptr.end); // 将读指针从文件末尾开始移动0个字节

size = file_ptr.tellg(); // 返回读指针的位置,此时读指针的位置就是文件的字节数

file_ptr.seekg(0, file_ptr.beg); // 将读指针从文件开头开始移动0个字节

char* model_stream = new char[size];

file_ptr.read(model_stream, size);

file_ptr.close();

1.3 创建推理引擎

首先需要初始化日志记录接口类,该类用于创建后续反序列化引擎使用;然后创建反序列化引擎,其主要作用是允许对序列化的功能上不安全的引擎进行反序列化,接下调用反序列化引擎来创建推理引擎,这一步只需要输入上一步中读取的模型文件数据以及长度即可。

// 日志记录接口

Logger logger;

// 反序列化引擎

nvinfer1::IRuntime* runtime = nvinfer1::createInferRuntime(logger);

// 推理引擎

nvinfer1::ICudaEngine* engine = runtime->deserializeCudaEngine(model_stream, size);

1.4 创建推理上下文

这里的推理上下文与OpenVINO中的推理请求相似,为后面进行模型推理的类。

nvinfer1::IExecutionContext* context = engine->createExecutionContext();

1.5 创建GPU显存缓冲区

TensorRT是利用英伟达显卡进行模型推理的,但是我们的推理数据以及后续处理数据是在内存中实现的,因此需要创建显存缓冲区,用于输入推理数据以及读取推理结果数据。

// 创建GPU显存缓冲区

void** data_buffer = new void* [num_ionode];

// 创建GPU显存输入缓冲区

int input_node_index = engine->getBindingIndex(input_node_name);

cudaMalloc(&(data_buffer[input_node_index]), input_data_length * sizeof(float));

// 创建GPU显存输出缓冲区

int output_node_index = engine->getBindingIndex(output_node_name);

cudaMalloc(&(data_buffer[output_node_index]), output_data_length * sizeof(float));

1.6 配置输入数据

配置输入数据时只需要调用cudaMemcpyAsync()方法,便可将cuda流数据加载到与i里模型上。但数据需要根据模型要求进行预处理,除此以外需要将数据结果加入到cuda流中。

// 创建输入cuda流

cudaStream_t stream;

cudaStreamCreate(&stream);

std::vector<float> input_data(input_data_length);

memcpy(input_data.data(), BN_image.ptr<float>(), input_data_length * sizeof(float));

// 输入数据由内存到GPU显存

cudaMemcpyAsync(data_buffer[input_node_index], input_data.data(), input_data_length * sizeof(float), cudaMemcpyHostToDevice, stream);

1.7 模型推理

context->enqueueV2(data_buffer, stream, nullptr);

1.8 处理推理结果

我们最后处理数据是在内存上实现的,首先需要将数据由显存读取到内存中。

float* result_array = new float[output_data_length];

cudaMemcpyAsync(result_array, data_buffer[output_node_index], output_data_length * sizeof(float), cudaMemcpyDeviceToHost, stream);

接下来就是根据模型输出结果进行数据处理,不同的模型会有不同的数据处理方式。

2. TensorRT 部署Yolov5模型

2.1 新建C++项目

右击解决方案,选择添加新建项目,添加一个C++空项目,将C++项目命名为:cpp_tensorrt_yolov5。进入项目后,右击源文件,选择添加→新建项→C++文件(cpp),进行的文件的添加。

右击当前项目,进入属性设置,配置TensorRT以及OpenCV的属性。

设置包含目录:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\include

D:\Program Files\TensorRT-8.4.0.6\include

E:\OpenCV Source\opencv-4.5.5\build\include

E:\OpenCV Source\opencv-4.5.5\build\include\opencv2

设置 ** 库目录**:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\lib

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4\lib\x64

D:\Program Files\TensorRT-8.4.0.6\lib

E:\OpenCV Source\opencv-4.5.5\build\x64\vc15\lib

设置附加依赖项:

nvinfer.lib

nvinfer_plugin.lib

nvonnxparser.lib

nvparsers.lib

cublas.lib

cublasLt.lib

cuda.lib

cudadevrt.lib

cudart.lib

cudart_static.lib

cudnn.lib

cudnn64_8.lib

cudnn_adv_infer.lib

cudnn_adv_infer64_8.lib

cudnn_adv_train.lib

cudnn_adv_train64_8.lib

cudnn_cnn_infer.lib

cudnn_cnn_infer64_8.lib

cudnn_cnn_train.lib

cudnn_cnn_train64_8.lib

cudnn_ops_infer.lib

cudnn_ops_infer64_8.lib

cudnn_ops_train.lib

cudnn_ops_train64_8.lib

cufft.lib

cufftw.lib

curand.lib

cusolver.lib

cusolverMg.lib

cusparse.lib

nppc.lib

nppial.lib

nppicc.lib

nppidei.lib

nppif.lib

nppig.lib

nppim.lib

nppist.lib

nppisu.lib

nppitc.lib

npps.lib

nvblas.lib

nvjpeg.lib

nvml.lib

nvrtc.lib

OpenCL.lib

opencv_world455.lib

2.2 定义yolov5模型相关信息

const char* model_path_onnx = "E:/Text_Model/yolov5/yolov5s.onnx";

const char* model_path_engine = "E:/Text_Model/yolov5/yolov5s.engine";

const char* image_path = "E:/Text_dataset/YOLOv5/0001.jpg";

std::string lable_path = "E:/Git_space/Al模型部署开发方式/model/yolov5/lable.txt";

const char* input_node_name = "images";

const char* output_node_name = "output";

int num_ionode = 2;

2.3 读取本地模型信息

std::ifstream file_ptr(model_path_engine, std::ios::binary);

if (!file_ptr.good()) {

std::cerr << "文件无法打开,请确定文件是否可用!" << std::endl;

}

size_t size = 0;

file_ptr.seekg(0, file_ptr.end); // 将读指针从文件末尾开始移动0个字节

size = file_ptr.tellg(); // 返回读指针的位置,此时读指针的位置就是文件的字节数

file_ptr.seekg(0, file_ptr.beg); // 将读指针从文件开头开始移动0个字节

char* model_stream = new char[size];

file_ptr.read(model_stream, size);

file_ptr.close();

2.4 初始化推理引擎

在此处我们需要初始化反序列化引擎以及推理引擎,并创建用于推理的上下文。

Logger logger;

// 反序列化引擎

nvinfer1::IRuntime* runtime = nvinfer1::createInferRuntime(logger);

// 推理引擎

nvinfer1::ICudaEngine* engine = runtime->deserializeCudaEngine(model_stream, size);

// 上下文

nvinfer1::IExecutionContext* context = engine->createExecutionContext();

2.5 创建GPU显存缓冲区

GPU显存缓冲区的数量主要与模型的输入输出节点有关,我们在此处只需要按照模型输入输出的节点数量进行设置。

void** data_buffer = new void* [num_ionode];

// 创建GPU显存输入缓冲区

int input_node_index = engine->getBindingIndex(input_node_name);

nvinfer1::Dims input_node_dim = engine->getBindingDimensions(input_node_index);

size_t input_data_length = input_node_dim.d[1]* input_node_dim.d[2] * input_node_dim.d[3];

cudaMalloc(&(data_buffer[input_node_index]), input_data_length * sizeof(float));

// 创建GPU显存输出缓冲区

int output_node_index = engine->getBindingIndex(output_node_name);

nvinfer1::Dims output_node_dim = engine->getBindingDimensions(output_node_index);

size_t output_data_length = output_node_dim.d[1] * output_node_dim.d[2] ;

cudaMalloc(&(data_buffer[output_node_index]), output_data_length * sizeof(float));

2.6 配置模型输入

首先对输入图片按照模型数据输入要求进行处理,首先是将图片数据复制到正方形背景中,然后交换RGB通道、缩放至指定大小以及归一化处理,在OpenCV中,blobFromImage()方法可以直接实现上述功能。

// 图象预处理 - 格式化操作

cv::Mat image = cv::imread(image_path);

int max_side_length = std::max(image.cols, image.rows);

cv::Mat max_image = cv::Mat::zeros(cv::Size(max_side_length, max_side_length), CV_8UC3);

cv::Rect roi(0, 0, image.cols, image.rows);

image.copyTo(max_image(roi));

// 将图像归一化,并放缩到指定大小

cv::Size input_node_shape(input_node_dim.d[2], input_node_dim.d[3]);

cv::Mat BN_image = cv::dnn::blobFromImage(max_image, 1 / 255.0, input_node_shape, cv::Scalar(0, 0, 0), true, false);

接下来创建cuda流,将处理后的数据放置在input_data容器里;最后直接使用cudaMemcpyAsync()方法,将输入数据输送到显存。

// 创建输入cuda流

cudaStream_t stream;

cudaStreamCreate(&stream);

std::vector<float> input_data(input_data_length);

memcpy(input_data.data(), BN_image.ptr<float>(), input_data_length * sizeof(float));

// 输入数据由内存到GPU显存

cudaMemcpyAsync(data_buffer[input_node_index], input_data.data(), input_data_length * sizeof(float), cudaMemcpyHostToDevice, stream);

2.7 模型推理

context->enqueueV2(data_buffer, stream, nullptr);

2.8 处理推理结果

首先读取推理结果数据,主要是将GPU显存上的推理数据结果赋值到内存上,方便后续对数据的进一步处理。

float* result_array = new float[output_data_length];

cudaMemcpyAsync(result_array, data_buffer[output_node_index], output_data_length * sizeof(float), cudaMemcpyDeviceToHost, stream);

接下来就是处理数据,Yolov5输出结果为85x25200大小的数组,其中没85个数据为一组,在该项目中我们提供了专门用于处理yolov5数据结果的结果处理类,因此在此处我们只需要调用该结果类即可:

ResultYolov5 result;

result.factor = max_side_length / (float) input_node_dim.d[2];

result.read_class_names(lable_path);

cv::Mat result_image = result.yolov5_result(image, result_array);

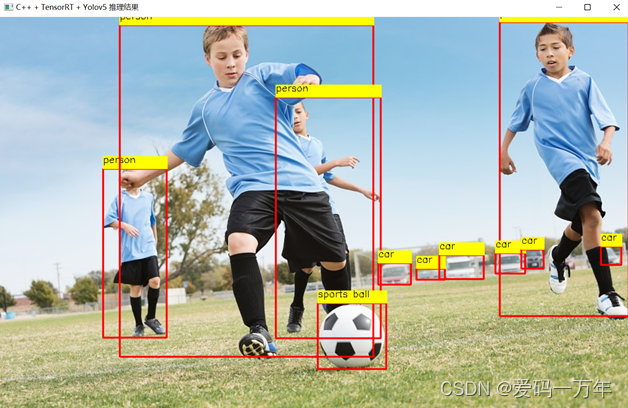

下图为我们测试效果。