mmclassification数据集并训练

1.数据集准备

import numpy as np

import os

import shutil

生成train.txt和val.txt

train_path = './train'

train_out = './train.txt'

val_path = './valid'

val_out = './val.txt'

data_train_out = './train_filelist'

data_val_out = './val_filelist'

def get_filelist(input_path,output_path):

with open(output_path,'w') as f:

for dir_path,dir_names,file_names in os.walk(input_path): #dir_path 文件夹作为标签

if dir_path != input_path:

label = int(dir_path.split('\\')[-1]) -1

#print(label)

for filename in file_names:

f.write(filename +' '+str(label)+"\n")

def move_imgs(input_path,output_path):

for dir_path, dir_names, file_names in os.walk(input_path):

for filename in file_names:

#print(os.path.join(dir_path,filename))

source_path = os.path.join(dir_path,filename)

shutil.copyfile(source_path, os.path.join(output_path,filename))

get_filelist(train_path,train_out)

get_filelist(val_path,val_out)

move_imgs(train_path,data_train_out)

move_imgs(val_path,data_val_out)

dataset

import numpy as np

from .builder import DATASETS

from .base_dataset import BaseDataset

修改configs文件

# Copyright (c) OpenMMLab. All rights reserved.

from .base_dataset import BaseDataset

from .builder import (DATASETS, PIPELINES, SAMPLERS, build_dataloader,

build_dataset, build_sampler)

from .cifar import CIFAR10, CIFAR100

from .dataset_wrappers import (ClassBalancedDataset, ConcatDataset,

KFoldDataset, RepeatDataset)

from .imagenet import ImageNet

from .imagenet21k import ImageNet21k

from .mnist import MNIST, FashionMNIST

from .multi_label import MultiLabelDataset

from .samplers import DistributedSampler, RepeatAugSampler

from .voc import VOC

from .my_filelist import MyFilelist #右边是我的py文件的名字,右边是我自己起的类名

# 初始化函数,注册机制

__all__ = [

'BaseDataset', 'ImageNet', 'CIFAR10', 'CIFAR100', 'MNIST', 'FashionMNIST',

'VOC', 'MultiLabelDataset', 'build_dataloader', 'build_dataset',

'DistributedSampler', 'ConcatDataset', 'RepeatDataset',

'ClassBalancedDataset', 'DATASETS', 'PIPELINES', 'ImageNet21k', 'SAMPLERS',

'build_sampler', 'RepeatAugSampler', 'KFoldDataset', 'MyFilelist'

]

@DATASETS.register_module()

class MyFilelist(BaseDataset):

CLASSES = [

'有102个。。。', #0号

'我懒得写名字了,有102个。。。', #1号

]

#加载标注

def load_annotations(self):

assert isinstance(self.ann_file, str)

#这些东西根据自己的数据自己写的

data_infos = []

with open(self.ann_file) as f:

samples = [x.strip().split(' ') for x in f.readlines()]

for filename, gt_label in samples:

info = {'img_prefix': self.data_prefix}

info['img_info'] = {'filename': filename}

info['gt_label'] = np.array(gt_label, dtype=np.int64)

data_infos.append(info)

return data_infos

修改mmclassification代码

#-*-coding:utf-8-*-

model = dict(

type='ImageClassifier',

backbone=dict(

type='ResNet',

depth=18,

num_stages=4,

out_indices=(3, ),

style='pytorch'),

neck=dict(type='GlobalAveragePooling'),

head=dict(

type='LinearClsHead',

num_classes=102, #

in_channels=512,

loss=dict(type='CrossEntropyLoss', loss_weight=1.0),

topk=(1, 5)))

dataset_type = 'ImageNet'

img_norm_cfg = dict(

mean=[123.675, 116.28, 103.53], std=[58.395, 57.12, 57.375], to_rgb=True)

train_pipeline = [

dict(type='LoadImageFromFile'),

dict(type='RandomResizedCrop', size=224), #look capbility of GPU

dict(type='RandomFlip', flip_prob=0.5, direction='horizontal'),

dict(

type='Normalize',

mean=[123.675, 116.28, 103.53],

std=[58.395, 57.12, 57.375],

to_rgb=True),

dict(type='ImageToTensor', keys=['img']),

dict(type='ToTensor', keys=['gt_label']),

dict(type='Collect', keys=['img', 'gt_label'])

]

test_pipeline = [

dict(type='LoadImageFromFile'),

dict(type='Resize', size=(256, -1)),

dict(type='CenterCrop', crop_size=224),

dict(

type='Normalize',

mean=[123.675, 116.28, 103.53],

std=[58.395, 57.12, 57.375],

to_rgb=True),

dict(type='ImageToTensor', keys=['img']),

dict(type='Collect', keys=['img'])

]

data = dict(

samples_per_gpu=8,

workers_per_gpu=2,

train=dict(

type='MyFilelist',

data_prefix='./train_filelist', #site of train

ann_file='./train.txt',

pipeline=[

dict(type='LoadImageFromFile'),

dict(type='RandomResizedCrop', size=224),

dict(type='RandomFlip', flip_prob=0.5, direction='horizontal'),

dict(

type='Normalize',

mean=[123.675, 116.28, 103.53],

std=[58.395, 57.12, 57.375],

to_rgb=True),

dict(type='ImageToTensor', keys=['img']),

dict(type='ToTensor', keys=['gt_label']),

dict(type='Collect', keys=['img', 'gt_label'])

]),

val=dict(

type='MyFilelist',

data_prefix='F:./val_filelist',

ann_file='./val.txt',

pipeline=[

dict(type='LoadImageFromFile'),

dict(type='Resize', size=(256, -1)),

dict(type='CenterCrop', crop_size=224),

dict(

type='Normalize',

mean=[123.675, 116.28, 103.53],

std=[58.395, 57.12, 57.375],

to_rgb=True),

dict(type='ImageToTensor', keys=['img']),

dict(type='Collect', keys=['img'])

]),

test=dict(

type='MyFilelist',

data_prefix='./val_filelist',

ann_file='./val.txt', # ?????

pipeline=[

dict(type='LoadImageFromFile'),

dict(type='Resize', size=(256, -1)),

dict(type='CenterCrop', crop_size=224),

dict(

type='Normalize',

mean=[123.675, 116.28, 103.53],

std=[58.395, 57.12, 57.375],

to_rgb=True),

dict(type='ImageToTensor', keys=['img']),

dict(type='Collect', keys=['img'])

]))

evaluation = dict(interval=1, metric='accuracy')

optimizer = dict(type='SGD', lr=0.1, momentum=0.9, weight_decay=0.0001)

optimizer_config = dict(grad_clip=None)

lr_config = dict(policy='step', step=[30, 60, 90])

runner = dict(type='EpochBasedRunner', max_epochs=100)

checkpoint_config = dict(interval=50)

log_config = dict(interval=100, hooks=[dict(type='TextLoggerHook')])

dist_params = dict(backend='nccl')

log_level = 'INFO'

load_from = None

resume_from = None

workflow = [('train', 1)]

work_dir = './work_dirs/resnet18_8xb32_in1k'

gpu_ids = [0]

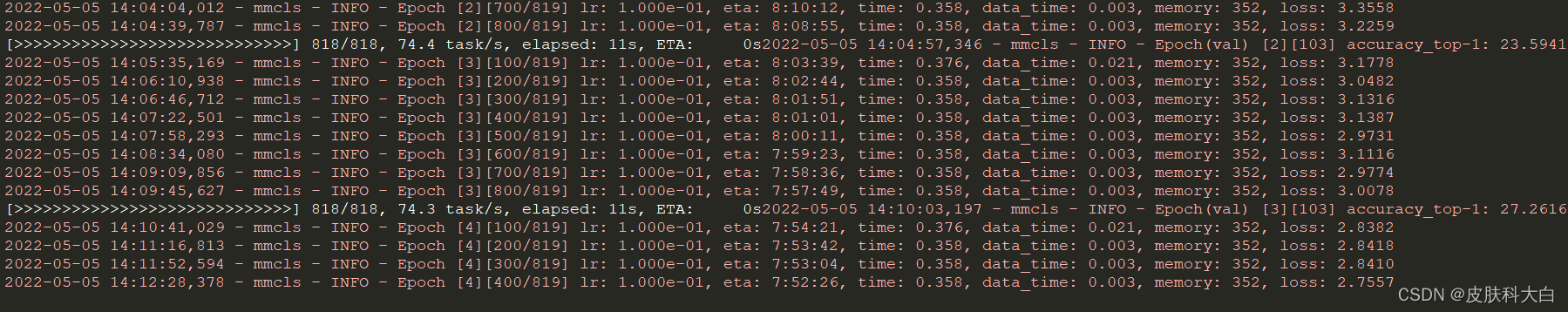

训练成功