Abstract

本文表明,将机器学习应用于数字变焦时,对真实、原始的传感器数据进行操作是有益的。现有的基于学习的超分辨率方法不使用真实的传感器数据,而是对经过处理的RGB图像进行操作。我们表明,这些方法丧失了对原始数据进行操作所能获得的细节和准确性,尤其是在放大远处物体时。使用真实的传感器数据进行训练的关键障碍是缺少ground-truth的高分辨率图像。我们展示了如何通过光学变焦获得这样的ground truth数据,并为真实的计算变焦提供一个数据集SR-RAW。我们使用SR-RAW来训练一个深度网络,该网络具有一种新的上下文双边损失,对输入和输出图像之间的轻微失调具有很强的鲁棒性。经过训练的网络在4倍和8倍的计算变焦中实现了最先进的性能。我们还表明,通过对高分辨率RGB图像重新采样来合成传感器数据是对真实传感器数据和噪声的一种过于简化的近似,导致图像质量较差。

1. Introduction

变焦功能是当今手机和相机的必备功能。人们在拍摄的照片中会将镜头拉近到遥远的物体上,比如野生动物和运动员,以便更详细地观察物体。iPhoneX等智能手机甚至配备了两个不同变焦级别的摄像头,这表明了高品质变焦功能对消费相机市场的重要性。

光学变焦是图像变焦的最佳选择,可以保持较高的图像质量,但变焦镜头通常是昂贵和笨重的。或者,我们可以方便地使用标准镜头的数码变焦。然而,数码变焦只是简单地向上采样相机传感器输入的裁剪区域,产生模糊的输出。在没有昂贵光学设备的情况下,为遥远的物体获取高质量的图像仍然是一个挑战。

我们建议从实际的原始传感器数据开始,提高超分辨率的质量。近年来,单幅图像的超分辨率已经随着深度模型的发展,并从大规模数据集中学习图像的先验信息[2,13,15,16,18,19,21,24,34]。然而,这些方法在以下两个方面受到限制。首先,它们在合成设置下接近计算变焦,其中输入图像是高分辨率图像的下采样版本,间接降低了输入中的噪声水平。实际上,由于在曝光时间内进入光圈的光子更少,遥远物体的区域往往包含更多的噪声。其次,现有的大多数方法都是从8位RGB图像开始的,该图像由相机图像信号处理器(ISP)处理,ISP将高位原始传感器数据中的高频信号用于其他目标(例如降噪)。

在这项工作中,我们提出了将机器学习应用于使用真实原始传感器数据作为输入的计算缩放的可能性。这项任务的基本挑战是获取ground truth:低分辨率原始传感器数据和相应的高分辨率图像。一种方法是将经过合成噪声模型[9]的8位RGB图像合成传感器数据。然而,来自真实传感器[27]的噪声建模非常具有挑战性,目前任何为训练综合传感器数据的工作都不能很好地建模。究其原因,传感器的噪声来源多种多样,表现为色彩的串扰以及靠近传感器表面的微几何和微光学效应。我们发现在模型训练综合传感器数据比使用8位RGB数据更有效(例如比较(B)和(C)在图1),模型训练的原始传感器数据执行最好的(如比较(C)和(D)如图1所示)。

使学习真正的原始传感器数据更好的计算放大,我们建议用变焦镜头捕捉到真实数据[17],透镜可以从物理上远离图像传感器,从较窄的立体角收集光子,用于光学放大。我们构建SRRAW,这是第一个用于实际计算缩放的数据集。SR-RAW包含用高光学变焦级别拍摄的ground truth高分辨率图像。

在训练中,使用较长焦距拍摄的8位图像作为使用较短焦距拍摄的较高位(如12-14位)原始传感器图像的ground truth。在训练过程中,SR-RAW提出了一个新的挑战:源和目标图像不是完全对齐的,因为它们是用不同的相机配置拍摄的,会导致轻微的视角变化。此外,预处理在低分辨率和高分辨率图像的对齐中引入了模糊性。轻度的输入-输出图像对失调使得像素损失函数不适合训练。因此,我们引入了一种新的上下文双边损失(CoBi),它对这种轻微的失调具有很强的鲁棒性。CoBi的灵感来自最近提出的上下文丢失(CX)[22]。CX直接应用于我们的任务会产生强大的构件,因为CX没有考虑空间结构。为了解决这个问题,CoBi优先考虑本地特性,同时还允许在特性没有对齐时进行全局搜索。

简而言之,我们学习了用光学变焦获得的ground truth高分辨率图像采集数据集,学习了变焦训练深度模型,从而获得更好的计算变焦效果。为了评估我们的方法,我们与现有的超分辨率方法进行了比较,也与我们的模型进行了比较。图像质量是通过失真指标,如SSIM, PSNR和一个学习感知指标来衡量的。我们还收集了人类的判断,以验证生成的图像与人类感知的一致性。结果表明,真实的原始传感器数据包含有用的图像信号,可用于恢复高保真超分辨率图像。我们的贡献可以总结如下:

- 我们演示了使用真实的高位传感器数据进行计算变焦的实用性,而不是处理8位RGB图像或合成传感器模型。

- 我们介绍了一种新的数据集SR-RAW,它是第一个具有光学ground truth的超分辨率原始数据集。SR-RAW是用变焦镜头拍摄的。对于焦距较短的图像,长焦距图像作为光学ground truth。

- 我们提出了一种新的上下文双边损失(CoBi)处理稍微失调的图像对。CoBi用加权空间意识来考虑局部上下文相似性。

2. Related Work

Image Super-resolution.图像超分辨率已经从传统的滤波方法向基于学习的方法发展。其目标是从低分辨率RGB图像重建高分辨率图像。传统的方法包括基于过滤的技术,如双三次上采样和边缘保持滤波[20]。这些滤波方法通常会在高分辨率图像中产生过于平滑的纹理。有几种方法使用patch匹配在训练数据集中或图像本身中搜索相似的patch[8,10,12]。近年来,深度神经网络已被应用于超分辨率,并经过各种损耗的训练[5,13,16]。

最近的许多超分辨率方法都是基于生成的对抗性网络。SRGAN[19]是一种即时的超分辨率方法,它利用GAN生成高分辨率图像。在SRGAN中使用的损失结合了深度特征匹配损失和对抗性损失。Lai等人[18]提出了拉普拉斯金字塔超分辨率网络来逐步预测低分辨率图像的高频细节在粗到细的图像金字塔中的残留。Wang等人提出了ESRGAN,它使用相对论性GAN[14]来增强图像的超分辨率,该GAN[14]可以估计一张图像相对于另一张图像的逼真程度。Wang等人研究了[29]类条件图像的超分辨率,提出了一种训练有GAN丢失和感知丢失的SFT-GAN。大多数现有的超分辨率模型采用合成的低分辨率RGB图像(通常从高分辨率图像中向下采样)作为输入。与此相反,我们获得了用较短焦距拍摄的真实低分辨率图像,并使用光学放大图像作为ground truth。

Image Processing with Raw Data.之前的工作已经使用原始传感器数据来增强图像处理任务。Farsiua等人提出了一种利用原始传感器数据进行联合多帧解调和超分辨率估计的最大后验技术。Gharbi等人训练了一种用于关节去噪和去噪的深度神经网络。Zhou等人研究了联合去噪、去噪和超分辨率。这些方法使用合成拜耳镶嵌。类似地,Mildenhall等人的[23]合成原始的突发序列用于去噪。Chen等人提出了一种基于学习的图像处理管道,用于使用原始传感器数据进行极端微光摄影。DeepISP是一种端到端深度学习模型,它对传统的相机图像信号处理流水线[25]进行了改进。同样,我们对原始传感器数据进行操作,提出了一种通过联合优化相机图像处理管道和原始传感器数据的超分辨率来实现图像超分辨率的方法。

3. Dataset With Optical Zoom Sequences

为了使用真实的原始传感器数据进行计算变焦训练,我们收集了一个不同的数据集SR-RAW,其中包含原始传感器数据和用变焦镜头在不同变焦级别拍摄的地面真相高分辨率图像。为了进行数据预处理,我们通过视场匹配和几何变换对不同缩放级别的捕获图像进行对齐。SR-RAW数据集支持训练端到端模型,该模型可以联合对原始传感器数据进行解码、去噪和超分辨率处理。对真实传感器数据的训练使我们的框架有别于现有的图像超分辨率算法,这些算法在低位RGB图像上运行。

3.1. Data Capture with a Zoom Lens

我们使用24-240毫米变焦镜头来收集不同光学变焦水平的原始图像对。每对图像形成一个输入-输出对,用于训练模型:以短焦距原始传感器图像作为输入,以长焦距RGB图像作为超分辨率的基础。例如,使用70mm焦距拍摄的RGB图像作为使用35mm焦距拍摄的原始传感器数据的2X缩放地面真相。在实际应用中,为了提高数据采集效率,我们在每个场景的7个光学变焦设置下采集了7幅图像。来自7幅图像序列的每一对图像形成一个数据对,用于训练特定的缩放模型。我们总共收集了500个室内外场景的序列。ISO从100到400。图2A显示了一个示例序列。

在数据采集过程中,相机设置非常重要。首先,景深(DOF)随着焦距的变化而变化,调整孔径大小使每个焦距的DOF相同是不现实的。我们选择一个小的光圈尺寸(至少f/20)来最小化DOF差异(在图2 B2中仍然可以看到),使用一个三脚架来捕捉长时间曝光的室内场景。其次,我们使用相同的曝光时间的所有图像在一个序列,使噪音水平不受焦距变化的影响。但是我们仍然观察到由于快门和物理光瞳是机械的并且涉及到动作变化而引起的明显的光照变化。这种颜色的变化是我们避免使用像素对像素的损失进行训练的另一个动机。第三,虽然透视不随焦距的变化而变化,但当镜头放大或缩小时,在投影中心存在微小的变化(镜头的长度),在不同深度的物体之间产生明显的透视变化(图2 B1)。我们使用的Sony FE 24-240mm镜头,需要与被摄对象至少56.4米的距离,才能在相距5米的物体之间产生小于1像素的透视位移。因此,我们避免捕获非常接近的对象,但允许在数据集中进行这样的透视图转换。

3.2. Data Preprocessing

对于一对训练图像,我们用RGB-L表示低分辨率图像,用RAW-L表示传感器数据。对于高分辨率的地面真相,我们使用RGB-H和RAWH。我们首先匹配rawl和RGB-H之间的视图(FOV)。然后计算RGB-L和RGB-H之间的对齐,以考虑手动缩放相机以调整焦距所引起的相机轻微移动。我们应用一个欧几里德运动模型,通过增强相关系数最小化[6]来实现图像的旋转和平移。训练时,将匹配FOV的RAW-L作为输入输入到网络中;它的地面真值目标是RGB-H,与RAW-L对齐并具有相同的FOV。如果光学变焦与目标变焦比不完全匹配,则对图像应用比例偏移。例如,如果我们使用(35mm, 150mm)训练一个4X变焦模型,那么目标图像的偏移量为1.07。

3.3. Misalignment Analysis

数据捕获过程中不可避免地会出现偏差,预处理步骤很难消除偏差。由于我们捕捉的数据焦距不同,所以像3.1节中描述的那样,视角的变化会导致视角的不对齐。此外,当对不同分辨率的图像进行对齐时,高分辨率图像中的锐边不能与低分辨率图像中的模糊边精确对齐(图2 B3)。SR-RAW中描述的失调通常会导致800万像素图像对中的40-80像素偏移。

4. Contextual Bilateral Loss

使用SR-RAW培训时,我们发现pixelto-pixel损失如L1和L2产生模糊图像由于训练数据的偏差(第三节)。另一方面,最近提出的上下文(CX)[22]对齐数据丢失也不满意,因为它只考虑功能而不是他们在图像空间位置。简要回顾一下,建议使用未对齐的数据对训练上下文损失。它将源图像P看作特征点 的集合,目标图像Q看作特征点

的集合,目标图像Q看作特征点 的集合。p为每个源图像特性,这对最近邻搜索(NN)特征匹配q,这样

的集合。p为每个源图像特性,这对最近邻搜索(NN)特征匹配q,这样 。在某些距离测量

。在某些距离测量 。由于输入图像P及其目标Q,相关损失试图最小化总结对距离的匹配特性,为制定:

。由于输入图像P及其目标Q,相关损失试图最小化总结对距离的匹配特性,为制定:

我们发现,使用上下文丢失进行训练会生成受重要工件影响的图像,如图3所示。我们假设这些伪影是由上下文丢失中不准确的特征匹配造成的。因此,我们分析了唯一匹配的特性的百分比(即双射)。与唯一源特性匹配的目标特性的百分比仅为43.7%,远低于100%的理想百分比。

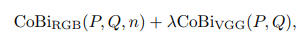

为了对模型进行适当的训练,我们需要设计一种适用于轻度失调的图像对的图像相似性度量方法。在保留边缘的双边滤波器[28]的启发下,我们将空间像素坐标和像素级RGB信息集成到图像特征中。我们的上下文双边损失(CoBi)被定义为

我们使用CoBi训练的模型的一对一特征匹配的平均数量从43.7%增加到93.9%。

我们对不同的特征空间进行了CoBi实验,得出了一种RGB图像修补的组合而预先训练的感知特征会带来最好的表现。特别地,我们使用预先训练的VGG-19特性[26],选择‘conv1 2’、‘conv2 2’、‘conv3 2’作为我们的深度特征,对图像合成和增强效果良好[4,33]。利用余弦距离度量特征相似度。最终的损失函数定义为

其中,我们使用n x n RGB补丁作为CoBiRGB的特性,对于8倍变焦(最佳n = 15), n应该大于4倍变焦模型(最佳n = 10)。定性比较的影响λ补充所示。

5. Experimental Setup

我们使用来自SR-RAW的图像来训练一个4X模型和一个8X模型。我们将原始Bayer mosaic中的每个2x2块打包成4个通道作为模型的输入。在不丢失任何信号的情况下,该包装将图像的空间分辨率在宽度和高度上降低了两倍。我们减去黑电平,然后将数据标准化为[0,1]。White balance从EXIF元数据中读取,并作为后处理应用于网络输出,以便与ground truth进行比较。我们采用了一个16层的ResNet架构[11],然后是 上卷积层,其中N是缩放因子。

上卷积层,其中N是缩放因子。

我们将SR-RAW中的500个序列按80:10:10的比例分割为训练、验证和测试集,这样就有400个序列用于训练,50个序列用于验证,50个序列用于测试。对于4倍变焦模型,每个序列有3对输入-输出对用于训练,对于8倍变焦模型,每个序列有1对输入-输出对。每对包含一个全分辨率(800万像素)拜耳马赛克图像及其相应的全分辨率光学放大RGB图像。我们随机从一个全分辨率的Bayer mosaic中裁剪64 64个patch作为训练的输入。附录中显示了示例训练补丁。

我们首先将我们的方法与现有的处理RGB图像的超分辨率方法进行比较。然后,我们对针对不同源数据类型训练的模型变体进行控制实验。所有的比较都是在SR-RAW的50个helout测试序列上测试的。

5.1. Baselines

我们选择了几种具有代表性的超分辨方法进行比较:基于gan的超分辨模型SRGAN [19];SRResnet[19]和LapSRN[18]演示了不同的SR网络架构;Johnson等人提出的采用知觉损失的[13]模型;最后是ESRGAN[30],最近知觉SR挑战的冠军PIRM[1]。对于除[13]外的所有基线,我们使用公共的预训练模型;我们首先尝试在SR-RAW上微调他们的模型,采用文献中的标准设置:对于每个图像,输入是目标高分辨率图像的下采样(双三次)版本。但是,我们注意到,与未经微调的预训练模型相比,平均性能差异不大(SSIM < 0.04, PSNR < 0.05, lpip < 0.025),因此我们直接使用未经微调的模型进行比较。对于没有预先训练模型的基线方法,我们在SR-RAW上从零开始训练它们的模型。

5.2. Controlled Experiments on Our Model

Ours-png: 为了进行比较,我们还使用经过8位处理的RGB图像来训练模型的副本(our -png),以评估拥有真实原始传感器数据的好处。与5.1节中描述的合成设置不同,我们没有使用向下采样的RGB图像作为输入,而是使用较短焦距拍摄的RGB图像作为输入。用较长焦距拍摄的RGB图像作为地面真实值。

“Ours-syn-raw”: 测试合成的原始数据是否可以代替训练的感知真实数据。我们采用Gharbi等人描述的标准传感器合成模型[9]代替真实的传感器数据进行训练,从8位RGB图像中生成合成的Bayer马赛克。简而言之,我们根据白平衡、gammacorrected sRGB图像的Bayer镶嵌模式,每个像素保留一个颜色通道,并引入随机方差高斯噪声。我们在这些合成传感器数据(“our - sync -raw”)上训练我们的模型的一个副本,并在经过白平衡和伽玛校正的真实传感器数据上进行测试。

6. Results

6.1. Quantitative Evaluation

为了定量评价所提出的方法,我们使用了标准的SSIM和PSNR度量,以及最近提出的学习感知度量LPIPS[32],它使用预先训练的深度网络测量感知图像的相似性。尽管SR-RAW中的输入-输出图像对存在轻微的不对齐(参见第3节),但是这种不对齐存在于所有方法中,因此比较是公平的。

结果见表1。他们指出,现有的超分辨率模型在实际需要数码变焦的低分辨率图像上表现不佳。这些模型是在一个合成设置下训练的,其中输入图像(通常向下采样)是干净的,只包含8位信号。基于gan的方法常常产生噪声伪影,导致PSNR和SSIM评分较低。双三次上采样和SRResnet产生模糊的结果,在LPIPS中得分较低。我们的模型以高比特的真实原始数据为训练对象,在光学缩放图像的监督下,通过4倍和8倍的计算缩放,可以有效地恢复高保真度的视觉信息。

在表2中,我们展示了使用两种不同策略训练的模型的评估。Ours-png是我们在处理过的RGB图像上训练的模型。通过对短焦距实际低分辨率数据的访问,该模型能够较好地处理噪声,但其超分辨率受到低位图像源的限制。我们的模型是在合成拜耳图像上训练的。该模型在测试过程中获取原始传感器数据,但受合成数据与真实传感器数据之间的区域差距的限制。

我们在图4中说明,合成传感器模型中没有反映出一系列真实的传感器特性。抗混叠滤波器(AA滤波器)存在于选定的相机模型中。合成传感器数据由8位图像生成,而实际传感器数据包含高位信号。传感器间的串扰和传感器的填充因子将噪声引入到彩色滤波器阵列中,简单的噪声模型[31]很难对其进行参数化。合成的传感器模型不足以表示这些复杂的噪声模式。

6.2. Qualitative Results

图5显示了与基线方法的定性比较,图6显示了与使用不同数据训练的模型变体的定性比较。大多数输入图像包含远离视点的对象,并且在实践中需要计算缩放。地面真相是获得使用变焦镜头与4倍光学变焦。在图5中,基线方法未能将内容从噪声中分离出来;它们的性能似乎受限于只能访问彩色图像中的8位信号,尤其是包含高频细节的条纹图像。在所有基线结果中,停车时的文本都显示有噪声,而我们的模型生成了一个清晰可辨的输出图像。在图6中,基于合成传感器数据训练的模型在Mario和Poster中产生锯齿状边缘,在Pattern中产生demosaic颜色伪影。该模型以真实的传感器数据为训练对象,利用SR-RAW对图像进行处理,生成了一幅高保真度的图像。

6.3. Perceptual Experiments

我们还通过在Amazon Mechanical Turk上进行感知实验来评估生成图像的感知质量。在每个任务中,我们将我们的模型与100张4倍放大的图像(来自SR-RAW的50张测试图像和另外50张未经地面真实拍摄的图像)的基线进行比较。我们针对LapSRN、Johnson等人、ESRGAN进行盲随机A/B测试,我们的模型基于合成传感器数据进行训练。我们以随机的左右顺序,将两种结果并排显示给参与者。给出了原始低分辨率图像,供参考。我们问这个问题:A和B是给定低分辨率图像的高分辨率图像的两个版本。哪个图像(A或B)的图像质量更好?共有50名工人参加了实验。表3中列出的结果表明,我们的模型生成的图像在绝大多数的盲对比较中更真实。

6.4. Generalization to Other Sensors

不同的图像传感器在Bayer马赛克中具有不同的结构噪声模式(见图4)。我们的模型针对一种类型的Bayer马赛克进行训练,当应用于另一种设备(如iPhoneX)的Bayer马赛克时,效果可能不太好。为了探索推广到其他传感器的潜力,我们在户外环境中捕获了另外50对iPhoneX-DSLR数据对。我们仅用5000次迭代对模型进行微调,使模型适应iPhoneX传感器。定性结果如图7所示,更多的结果可以在附录中找到。结果表明,我们的预训练模型可以通过对用该传感器捕获的小数据集上的模型进行微调,推广到另一个传感器上,也表明输入-输出数据对可以来自不同的设备,表明我们的方法在有限光学变焦功率的设备上的应用。

7. Conclusion

我们已经证明了使用真实的原始传感器数据进行计算缩放的有效性。图像直接超分辨从原始传感器数据通过一个学习的深层模型,执行联合ISP和超分辨率。我们的方法从原始数据中吸收有用的信号,并产生比在处理过的RGB图像或合成传感器数据上训练的模型更高的保真度结果。为了利用真实的传感器数据进行训练,我们收集了一个新的数据集,其中包含了作为地面真实的光学放大图像,并引入了一种新的上下文双边损失,该损失对训练数据对的轻微失调具有鲁棒性。我们的结果表明,学习模型可以集成到相机的高质量数码变焦。我们的工作也表明,从原始传感器数据中保存信号可能有利于其他图像处理任务。

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)