信息论中,自信息量和一阶熵是用来度量信息的重要概念。它们提供了一种方式来理解和量化信息的不确定性和平均量,对于解决信息传输、编码和存储等问题非常有用。

首先,让我们来了解一下自信息量。自信息量是用来度量一个事件的信息量或不确定性的大小。假设有一个事件发生的概率是p,那么这个事件的自信息量可以被定义为-log(p)。

自信息量是一个非负数,当事件的概率越大,

自信息量越小,表示信息越确定或重要

。相反,当事件的概率越小,自信息量越大,表示信息越不确定或重要。

自信息量的单位通常使用比特(bit)

,因为使用一个底为2的对数计算出来的结果最直接地表示了信息的二进制位数。例如,当事件的概率是1时,自信息量为0,表示事件是确定的或者已知的;当事件的概率是0.5时,自信息量为1,表示事件的信息量是1比特,相当于提供了一个二分选择的答案。

自信息量的一个重要特性是它越大,表示事件越罕见或意外,提供的信息量越大

。例如,当一个非常罕见的事件发生时,它的自信息量会比较大,因为它提供了一些非常有用和重要的信息。

接下来,

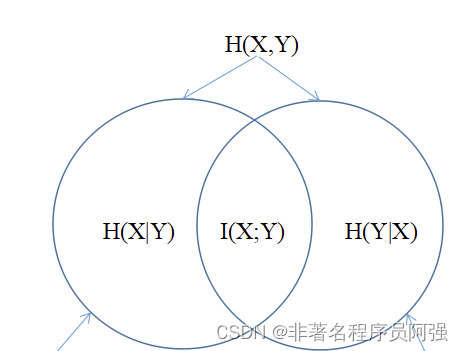

我们来介绍一阶熵,也叫作熵

。熵是用来度量一个随机变量的平均信息量或不确定性。对于离散随机变量来说,熵可以通过计算每个可能值的概率乘以它们的自信息量,并将它们相加来求得。

数学上,一阶熵H(X)可以用下面的公式来表示:

H(X) = -Σ p(x)log(p(x))

其中,p(x)是离散随机变量X取值为x的概率。

熵是一个非负数,当一个随机变量的取值是确定的(概率为1),熵为0,表示信息是完全确定且不可变的。

相反,当一个随机变量的取值是均匀分布时,熵达到最大值,表示信息是最不确定的。

一阶熵也可以用来衡量一个消息的平均编码长度。

根据香农的信息编码定理,

使用最优编码方案,比如霍夫曼编码,可以达到熵的下限

。这样一来,我们可以根据一阶熵的计算结果来评估编码方案的优劣,以及选择合适的编码方式来降低信息传输和存储的成本。

自信息量和一阶熵是信息论中非常重要的概念,它们提供了度量和理解信息不确定性和平均量的方法。

通过自信息量,我们可以判断事件的重要性和罕见程度;通过一阶熵,我们可以比较随机变量的不确定性和评估编码方案的效率。在信息传输、编码和存储等应用中,理解和应用自信息量和一阶熵的概念是非常重要的。

总而言之,自信息量和一阶熵是信息论中用来度量信息不确定性和平均量的重要概念。

自信息量用来衡量事件的不确定性和提供的信息量,而一阶熵用来衡量随机变量的平均信息量和不确定性。它们在信息传输、编码和存储等方面有广泛的应用和重要性。通过理解和运用自信息量和一阶熵,我们能够更好地处理和优化信息的存储、传输和使用。

【学习交流群】不知道怎么学?遇到问题没人问?到处找资料?邀请你加入我的人工智能学习交流群,群内气氛活跃,大咖小白、在职、学生都有,还有群友整理收集的100G教程资料,点击下方进群占位。(点击跳转到群二维码,请放心点击!)

扫码进群领资料