常见的优化算法介绍

1. 批量梯度下降算法(batch gradient descent BGD)

每次迭代都需要把所有样本都送入,这样的好处是每次迭代都顾及了全部的样本,做的是全局最优化,但是有可能达到局部最优。

2. 随机梯度下降算法(Stochastic gradient descent SGD)

针对梯度下降算法训练速度过慢的缺点,提出了随机梯度下降算法,随机梯度下降算法算法是从样本中随机抽出一组,训练后按梯度更新一次,然后再抽取一组,再更新一次,在样本量及其大的情况下,可能不用训练完所有的样本就可以获得一个损失值在可接受范围之内的模型了。

torch.optim.SGD()

3. 小批量梯度性下降(Mini-batch gradient descent MBGD)

SGD相对来说要快很多,但是也有存在问题,由于单个样本的训练可能会带来很多噪声,使得SGD并不是每次迭代都向着整体最优化方向,因此在刚开始训练时可能收敛得很快,但是训练一段时间后就会变得很慢。在此基础上又提出了小批量梯度下降法,它是每次从样本中随机抽取一小批进行训练,而不是一组,这样即保证了效果又保证的速度。

4.动量法

mini-batch SGD算法虽然这种算法能够带来很好的训练速度,但是在到达最优点的时候并不能够总是真正到达最优点,而是在最优点附近徘徊。

另一个缺点就是mini-batch SGD需要我们挑选一个合适的学习率,当我们采用小的学习率的时候,会导致网络在训练的时候收敛太慢;当我们采用大的学习率的时候,会导致在训练过程中优化的幅度跳过函数的范围,也就是可能跳过最优点。我们所希望的仅仅是网络在优化的时候网络的损失函数有一个很好的收敛速度同时又不至于摆动幅度太大。

所以Momentum优化器刚好可以解决我们所面临的问题,它主要是基于梯度的移动指数加权平均,对网络的梯度进行平滑处理的,让梯度的摆动幅度变得更小。

v

=

0.8

v

+

0.2

▽

w

,

▽

w

表

示

当

前

一

次

的

梯

度

v = 0.8v + 0.2▽w ,▽w 表示当前一次的梯度

v=0.8v+0.2▽w,▽w表示当前一次的梯度

w

=

w

−

w

−

l

r

∗

v

,

l

r

表

示

学

习

率

w = w-w - lr*v ,lr表示学习率

w=w−w−lr∗v,lr表示学习率

5.AdaGrad

AdaGrad算法就是将每一个参数的每一次迭代的梯度取平方累加后在开方,用全局学习率除以这个数,作为学习率的动态更新,从而达到自适应学习率的效果。

g

r

a

d

e

n

t

=

h

i

s

t

o

r

y

g

r

a

d

e

n

t

+

(

▽

w

)

2

gradent = history_gradent+(▽w)^{2}

gradent=historygradent+(▽w)2

w

=

w

−

l

r

/

(

g

r

a

d

e

n

t

1

/

2

+

t

)

(

▽

w

)

t

为

小

常

数

,

设

置

为

1

0

−

7

w = w - lr/(gradent^{1/2}+t)(▽w) t为小常数,设置为10^{-7}

w=w−lr/(gradent1/2+t)(▽w)t为小常数,设置为10−7

6.RMSProp

动力算法(Momentum)优化算法中,虽然初步解决了优化中摆动幅度大的问题,为了进一步优化损失函数在更新中存在摆动幅度过大的问题,并且进一步加快函数的收敛速度,RMSProp算法对参数的梯度使用了平方加权平均数。

g

r

a

d

e

n

t

=

0.8

∗

h

i

s

t

o

r

y

g

r

a

d

e

n

t

+

(

▽

w

)

2

gradent =0.8*history_gradent+(▽w)^{2}

gradent=0.8∗historygradent+(▽w)2

w

=

w

−

w

−

l

r

/

(

g

r

a

d

e

n

t

1

/

2

+

t

)

(

▽

w

)

w =w -w - lr/(gradent^{1/2}+t)(▽w)

w=w−w−lr/(gradent1/2+t)(▽w)

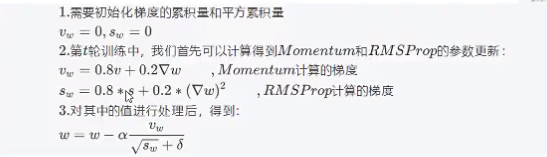

7.Adam

Adam(Adaptive Moment Estimation)算法是将Momentum算法和RMSProp算法结合起来使用的一种算法,能够达到防止梯度的摆幅多大,同时还能够加开收敛速度。

优点:学习率可以自适应,梯度的振幅不会过大。

torch中API的使用

torch.optim.Adam()

8.总结

- 批量梯度下降法在进行参数更新时,会使用所有的样本信息,当数据量很大时,会造成训练过程慢,但迭代次数较少。

- 随机梯度下降法每次只使用一个样本的信息来更新参数,在样本很大的情况下,可能只用其中几万条或者几千条的样本,就已经将theta迭代到最优解了,相比于批量梯度下降来说就快了很多了。但是,因为每次只利用一个样本的信息,不能保证每次迭代都向着整体最优化方向,也就是会曲折着前行。

- 小批量梯度下降法就是结合BGD和SGD的折中,对于含有n个训练样本的数据集,每次参数更新,选择一个大小为m 的mini-batch数据样本计算其梯度,虽然既保证了训练速度又保证了准确率,但是如何选择学习率是一个难题,如何自适应调整学习率?

- 因此引出了AdaGrad算法,RMSProp算分,Adam算法;这3中优化算法可以实现自适应学习率。

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)