1、TensorRT发布的模型(engine)不能跨平台使用

例如linux发布的模型不能在windows下用。

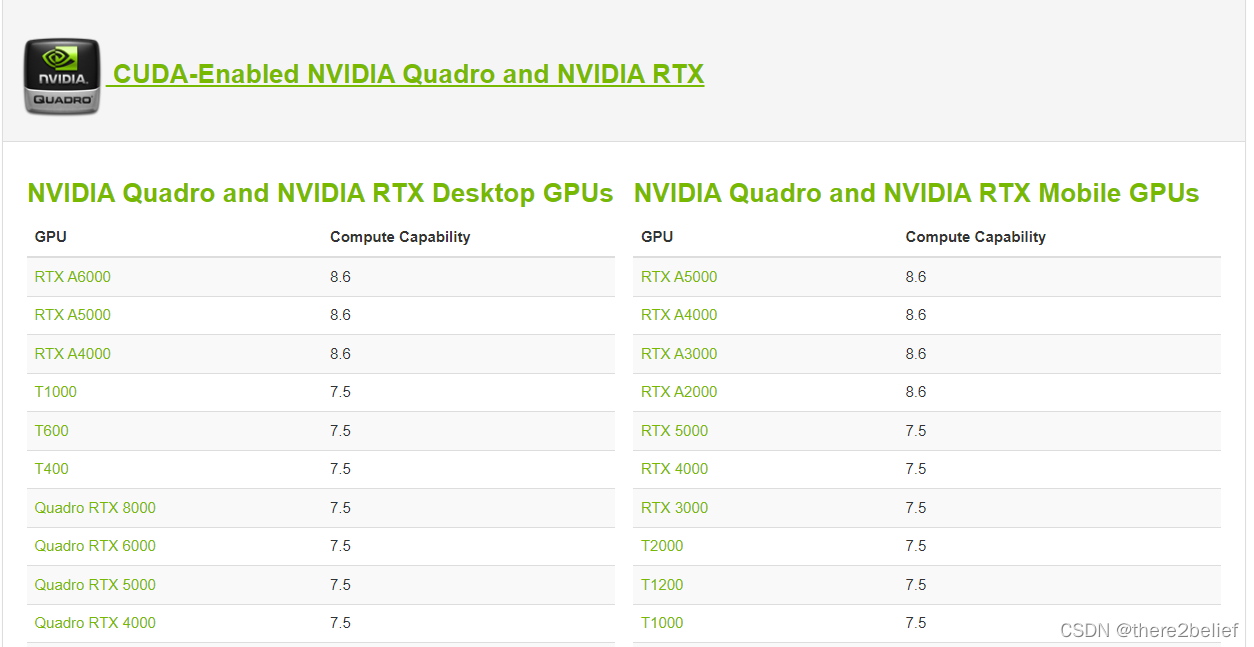

2、TensorRT发布的模型需要在相同GPU算力(compute capability)的情况下使用

否则会导致compute capability不匹配问题,例如算力6.1发布的模型不能在7.5上用。

查询显卡算力:CUDA GPUs | NVIDIA Developer

3、TensorRT发布的模型需要在匹配的CUDA和cudnn环境下用

TensorRT本身有严格的CUDA/cudnn版本兼容细分,虽然部分环境版本浮动可以有一定的适用性,但可能导致速度不稳定等问题,推荐使用同发布模型匹配的CUDA和cudnn环境。

CUDA小版本不一致会遇到警告:

[W] [TRT] TensorRT was linked against cuBLAS/cuBLAS LT 11.3.0 but loaded cuBLAS/cuBLAS LT 11.2.1

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)