一、安装win10编译过的hadoop

1、将编译好的hadoop包放在非中文目录

2、配置HADOOP_HOME环境变量

3、将hadoop包的bin目录加到PATH环境变量中

二、在idea中创建一个maven项目

1、创建maven项目

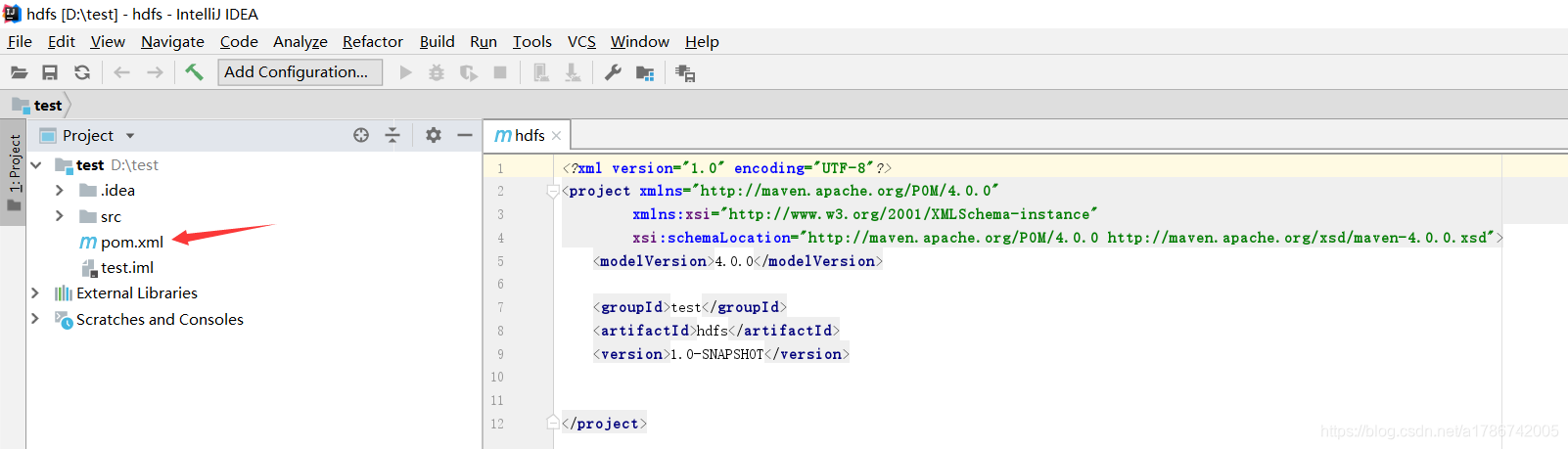

2、导入相应的依赖坐标+日志添加

在pom.xml文件中添加:

在pom.xml文件中添加:

<dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>RELEASE</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>2.8.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-common</artifactId>

<version>2.7.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-hdfs</artifactId>

<version>2.7.2</version>

</dependency>

<dependency>

<groupId>jdk.tools</groupId>

<artifactId>jdk.tools</artifactId>

<version>1.8</version>

<scope>system</scope>

<systemPath>${JAVA_HOME}/lib/tools.jar</systemPath>

</dependency>

</dependencies>

3、编辑"log4j.properties"文件

需要在项目的src/main/resources目录下,新建一个文件,命名为"log4j.properties”,在文件中填入:

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

这样就可以在控制台中打印出日志

三、利用api编写java代码操作hdfs集群

需要在项目的src/main/java目录下,新建一个包,命名为hdfs。在包下创建一个类HdfsClient,编写的java代码如下:

package hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.io.IOUtils;

import org.junit.Test;

import java.io.File;

import java.io.FileInputStream;

import java.io.FileOutputStream;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

public class HdfsClient {

@Test

public void testMkdirs() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

fs.mkdirs(new Path("/0202/aa/cc"));

fs.close();

}

@Test

public void testCopyFromLocalFile() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

configuration.set("dfs.replication", "2");

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

fs.copyFromLocalFile(new Path("D:/123.txt"), new Path("/baozhu.txt"));

fs.close();

}

@Test

public void testCopyToLocalFile() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

fs.copyToLocalFile(false, new Path("/jdk-8u144-linux-x64.tar.gz"), new Path("D:/jdk-8u144-linux-x64.tar.gz"), true);

fs.close();

}

@Test

public void testDelete() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

fs.delete(new Path("/sanguo"), true);

fs.close();

}

@Test

public void testRename() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

fs.rename(new Path("/baozhu.txt"), new Path("/bao.txt"));

fs.close();

}

@Test

public void testListFiles() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/"), true);

while (listFiles.hasNext()) {

LocatedFileStatus status = listFiles.next();

System.out.println(status.getPath().getName());

System.out.println(status.getLen());

System.out.println(status.getPermission());

System.out.println(status.getGroup());

BlockLocation[] blockLocations = status.getBlockLocations();

for (BlockLocation blockLocation : blockLocations) {

String[] hosts = blockLocation.getHosts();

for (String host : hosts) {

System.out.println(host);

}

}

System.out.println("------------------分割线----------------");

}

fs.close();

}

@Test

public void testListStatus() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

FileStatus[] listStatus = fs.listStatus(new Path("/"));

for (FileStatus fileStatus : listStatus) {

if (fileStatus.isFile()) {

System.out.println("f:" + fileStatus.getPath().getName());

} else {

System.out.println("d:" + fileStatus.getPath().getName());

}

}

fs.close();

}

@Test

public void putFileToHDFS() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

FileInputStream fis = new FileInputStream(new File("D:/123.txt"));

FSDataOutputStream fos = fs.create(new Path("/abc.txt"));

IOUtils.copyBytes(fis, fos, configuration);

IOUtils.closeStream(fos);

IOUtils.closeStream(fis);

fs.close();

}

@Test

public void getFileFromHDFS() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

FSDataInputStream fis = fs.open(new Path("/baozhu.txt"));

FileOutputStream fos = new FileOutputStream(new File("D:/test.txt"));

IOUtils.copyBytes(fis, fos, configuration);

IOUtils.closeStream(fos);

IOUtils.closeStream(fis);

fs.close();

}

@Test

public void readFileSeek1() throws URISyntaxException, IOException, InterruptedException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "test");

FSDataInputStream fis = fs.open(new Path("/hadoop-2.7.2.tar.gz"));

FileOutputStream fos = new FileOutputStream(new File("D:/hadoop-2.7.2.tar.gz.part1"));

byte[] buf = new byte[1024];

for (int i = 0; i < 1024 * 128; i++) {

fis.read(buf);

fos.write(buf);

}

IOUtils.closeStream(fis);

IOUtils.closeStream(fos);

fs.close();

}

@Test

public void readFileSeek2() throws IOException, InterruptedException, URISyntaxException {

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://192.168.1.151:9000"), configuration, "atguigu");

FSDataInputStream fis = fs.open(new Path("/hadoop-2.7.2.tar.gz"));

fis.seek(1024 * 1024 * 128);

FileOutputStream fos = new FileOutputStream(new File("D:/hadoop-2.7.2.tar.gz.part2"));

IOUtils.copyBytes(fis, fos, configuration);

IOUtils.closeStream(fis);

IOUtils.closeStream(fos);

}

}

四、软件包地址

有hadoop2.7.2 win10版 以及 jdk1.8 windows版

在进行以上操作之前,要先安装jdk,配置JAVA_HOME,软件链接如下:

https://pan.baidu.com/s/1x3EORUC8_ehfNP08idBOaw

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)