目录

原文翻译:基于方面的情感分析的上下文和句法特征建模

摘要:

1 介绍

2 相关工作

3 方法提出

3.1 方面提取

3.1.1 输入表示

3.1.2 词性嵌入

3.1.3 基于依赖关系的嵌入

3.1.4 微调过程

3.2 方面情感分类

3.2.1 输入表示

3.2.2 局部上下文关注

4 效果评估

4.1 数据集

4.2 基线模型(baseline)

4.3 模型的变化

5、实验

6 结果和分析

6.1 方面提取

6.1.1 主要结果

6.1.2 消融实验

6.2 方面情感分类

6.2.1 主要结果

6.2.2 通过注意分数可视化分析SRD的效果

7 总结和未来工作

8 致谢

文章个人解读

一、摘要:

二、引言:

三、相关工作

四、方法提出

原文翻译:基于方面的情感分析的上下文和句法特征建模

原文链接:https://aclanthology.org/2020.acl-main.293.pdf

摘要:

基于方面的情感分析(ABSA)包括两个概念任务,即方面提取和方面情感分类。我们构建了一个端到端的ABSA解决方案,而不是分别考虑这些任务。以往的ABSA任务研究没有充分发挥句法信息的重要性,因此,方面提取模型往往无法检测到多词方面术语的边界。另一方面,方面情感分类器无法解释方面词与上下文词之间的句法相关性。

本文探讨了句子的语法方面,并运用自注意机制进行句法学习。我们结合了词性嵌入、基于依赖的嵌入和情境化嵌入(例如BERT、RoBERTa)来增强方面提取器的性能。我们还提出了句法相对距离的概念,以弱化不相关词的不利影响,这些词与方面术语的句法联系较弱,这提高了方面情感分类器的准确性。在SemEval-2014数据集上,我们的解决方案都优于最先进的模型在这两个子任务上的表现。

1 引言

理解消费者在产品评论(有主见的文本)中表达的情感的过程被称为情感分析。通过对所审查的产品进行细粒度的实体或基于方面的情感标签,可以深入了解有观点的文本。这样的见解对于业务决策是非常宝贵的。

基于方面的情感分析(ABSA)包括两个子任务,即方面提取(AE)和方面情感分类(ASC)。然而,大多数报道的作品专注于两个子任务中的一个。用于方面提取的代表作有(Xu等,2018;达乌和萨利姆,2019年;Poria等,2016年);用于方面情感分类的代表作有(Zeng等,2019;Huang等,2018;Song等,2019年;Thet等,2010年)。最近的方法(He等, 2019;Wang等,2018;Li等人,2019年)试图开发一种集成解决方案,通过将两个子任务制定为具有统一标记方案的单个序列标记来同时解决这两个任务。添加统一令牌会在原始ABSA任务中引入开销和复杂性。因此,与独立训练的单任务模型相比,多任务模型的性能往往较差。

NLU(自然语言理解)的最新进展引入了情景化语言模型,即OpenAI GPT (Radford等人,2018),BERT (Devlin等人,2018)和RoBERTa (Liu等人,2019)。这些模型可以捕捉单词使用的特征,并解释单词出现的不同文本上下文。在研究了用于方面提取的最新BERT/RoBERTabased体系结构后,很明显,它们无法确定多词方面的边界。例如,提取器将多词表达“quality of food”分解为“quality of”和“food”。我们假设这个缺点是由于情境化嵌入无法编码丰富的语法信息造成的。

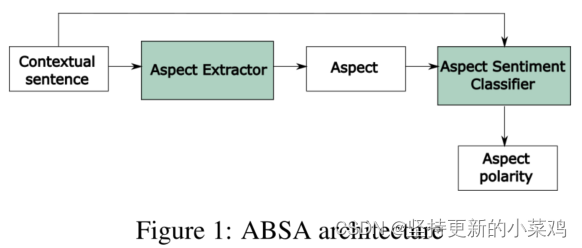

在本文中,我们将语法信息集成到上下文化嵌入中,并提出了一个由方面提取器和方面情感分类器组成的ABSA解决方案,如图1所示。所提出的AE架构被命名为基于上下文语法的方面提取(CSAE-contextualized syntax-based aspect extraction),除RoBERTa层外,还包括POS嵌入、基于依赖的嵌入(Levy和Goldberg, 2014)和自注意。

我们的ASC(aspect sentiment classifier)解决方案与Zeng等人(2019)的工作密切相关,在该工作中,利用本地上下文焦点(LCF-local context focus)机制来降低远离本地上下文的单词的贡献。但是,这种方法简单地将词与词之间的字数视为语义相对距离,而忽略了词与词之间的句法关系。我们的方法使用依赖分析树中两个词之间的最短路径作为句法相对距离(SRD-syntactic realtive distance)。我们将这个模型命名为局部上下文关注语法ASC (LCFS-ASC)-local context focus on syntax。在两个SemEval-2014数据集上进行了对比实验(Pontiki et al, 2014),以证明句法特征在改进AE和ASC模型方面的重要性。

本文的主要贡献如下:(1)我们提出了多通道CSAE模型,该模型将语法方面提炼为上下文化的特征,以改进顺序标记;(2)我们贡献了LCFS-ASC,它可以分析单词之间的句法联系,以更好地理解与目标方面术语相关的局部上下文;(3)我们通过探索LCF层的注意评分来研究SRD的重要性。

2 相关工作

本节详细介绍了ABSA解决方案从基于词嵌入的模型到基于上下文嵌入的模型的演变,并强调了它们的优缺点。

基于词嵌入的模型

最近的ABSA工作使用预训练的词嵌入作为数据处理层,并添加后续层以进行更丰富的特征学习。目标依赖长短期记忆(target - dependent Long - Short-Term Memory, TD-LSTM)模型(Tang et al., 2015)将上下文单词和目标单词嵌入到向量空间中,并使用LSTM单元对输入序列中的长距离关系进行编码。TD-LSTM通过捕获目标词与语境词的相关性,为ABSA提取相关信息。注意机制被广泛应用于ABSA问题,以克服在长输入序列中观察到的梯度消失问题。基于注意的带有方面嵌入的LSTM (ATAE-LSTM) (Wang et al, 2016)除了LSTM层之外,还利用了注意机制。因此,网络可以集中在句子的关键情感部分,以响应给定的方面。

情境化预训练语言模型

词表示的质量是通过它对句法特征和多义行为(即词义)的编码能力来衡量的。传统的词嵌入只能产生单上下文的词表示。最近的工作偏离了全局单词表示,并考虑了上下文依赖的单词嵌入,它以不同的方式“描述”单词,以解释固有的单词含义。BERT (Devlin et al, 2018)是一种掩码语言模型(LM),它在句子中掩盖了一定比例的单词,并设置了训练目标来预测掩码单词。RoBERTa (Liu et al, 2019)对BERT模型进行了改进,训练模型的时间更长,数据量更大,并消除了下句预测目标。BERT在ABSA问题上有几个应用。

AEN-BERT (Song et al, 2019)使用BERT嵌入上下文序列和目标序列;并注意绘制目标词与语境词之间的语义交互关系。LCF-BERT (Zeng等人,2019)使用上下文动态掩蔽/上下文动态加权来使用语义相对距离来定位情感信号。这个距离是通过上下文单词和目标方面术语之间的字数来衡量的。局部上下文层允许模型强调语义相对的上下文单词。然而,批评性情感词汇有时可以通过语法规则与目标方面词相关联,尽管它们的语义相对距离较大。我们假设使用句法相对距离来识别不相关的单词,可以避免错误地消除关键情感词的贡献。

最近有一些基于BERT的方法在AE任务中取得了有前景的结果(例如Xu等人(2019))。然而,他们需要在大型领域特定的语料库上重新训练BERT模型,这使得实现领域独立的方面提取器不可行。我们放弃这种训练后的方法,并寻找通用的AE架构。

3 方法提出

给定一个包含n个标记的上下文句子S,S = {wi|i∈[1,n]},一个端到端的ABSA任务旨在提取被提及的m个方面项的集合a,其中a = {ai|i∈[1,m]};并确定与每个提取方面相关联的极性yp∈{Positive,Netural,Negative}。

3.1 方面提取

方面提取可以转换为顺序标记问题,其中每个输入词wi被分配一个标签yi。标签yi从集合{B, I, O} (Begin, Inside, Outside)中取值,分别表示方面项的开始、方面项的内部和非方面词。

图2描述了所提出的基于上下文语法的方面提取(CSAE)模型的总体架构。CSAE由上下文嵌入(例如BERT或RoBERTa)、词性嵌入和基于依赖的嵌入组成。通过连接上下文的隐藏状态、参与的POS状态和参与的基于依赖的状态,最终表示中的语法信息得到了丰富。

3.1.1 输入表示

上下文化的模型需要在输入序列的开头添加一个特殊的分类标记[CLS],并在输入序列的末尾添加分隔符[SEP]。输入语句转换为“[CLS]”+输入序列+“[SEP]”格式。

3.1.2 词性嵌入

每个单词的词性(POS)由通用POS标记注释;则输入序列P = {p1, p2,…, pn}被检索。POS嵌入层采用稀疏向量表示P提取稠密向量表示 = {

= { |i∈[1,n]},其中

|i∈[1,n]},其中 ∈

∈ , h-pos-emb为POS嵌入的隐藏大小。然后,利用自注意层观察POS标记符的整个序列,提取输入句子中的语法依赖关系。

, h-pos-emb为POS嵌入的隐藏大小。然后,利用自注意层观察POS标记符的整个序列,提取输入句子中的语法依赖关系。

3.1.3 基于依赖关系的嵌入

基于依赖的嵌入(Levy和Goldberg, 2014) (DE)不是使用线性单词袋上下文来形成上下文窗口,而是使用基于单词参与的语法关系的基于依赖的上下文。这个过程首先使用依赖关系树来解析句子。对于每个目标词w和修饰语m1, m2,…, mn与w相关,上下文C = {(m1, rel1), (m2, rel2),…,( ,

,  )}。在这种情况下,

)}。在这种情况下, 是目标词w和修饰语mi之间的依赖关系(如subj,amod,pobj),而

是目标词w和修饰语mi之间的依赖关系(如subj,amod,pobj),而 则代表相反的关系。在提取最后的上下文之前,通过将介词包含到依赖标签中来分解由介词组成的关系。图3描述了将介词分解为依赖关系的过程,并展示了提取出的句子中每个目标词的上下文。DE可以将线性上下文词嵌入中不可及的距离关系融合在一起。它还减少了对无意中进入上下文窗口的无关单词的强调。

则代表相反的关系。在提取最后的上下文之前,通过将介词包含到依赖标签中来分解由介词组成的关系。图3描述了将介词分解为依赖关系的过程,并展示了提取出的句子中每个目标词的上下文。DE可以将线性上下文词嵌入中不可及的距离关系融合在一起。它还减少了对无意中进入上下文窗口的无关单词的强调。

dobj:直接宾语;prep:介词;amod:形容词;nsubj:名词性主语;pobj:介词宾语;dobj:直接宾语

3.1.4 微调过程

训练目标是最小化L2正则化的交叉熵损失。具体而言,深度学习模型的最优参数θ是由 得到,其中λ为正则化参数,

得到,其中λ为正则化参数, 为

为 对应的预测标签。

对应的预测标签。

3.2 方面情感分类

给定一个上下文句![S = \left \{ w_{i}|i\epsilon \left [ 1,n \right ] \right \}](https://latex.csdn.net/eq?S%20%3D%20%5Cleft%20%5C%7B%20w_%7Bi%7D%7Ci%5Cepsilon%20%5Cleft%20%5B%201%2Cn%20%5Cright%20%5D%20%5Cright%20%5C%7D) ,提取的方面项

,提取的方面项![A = \left \{ a_{i}|i\epsilon \left [ 1,m \right ] \right \}](https://latex.csdn.net/eq?A%20%3D%20%5Cleft%20%5C%7B%20a_%7Bi%7D%7Ci%5Cepsilon%20%5Cleft%20%5B%201%2Cm%20%5Cright%20%5D%20%5Cright%20%5C%7D) ,我们需要确定上下文句中方面项的极性{Positive, Netural, Negative}。

,我们需要确定上下文句中方面项的极性{Positive, Netural, Negative}。

图4展示了所提出的局部上下文特征-方面情感分类的总体架构,包括针对全局和局部上下文的两个独立的上下文化的嵌入。

3.2.1 输入表示

为了理解全局语境,语境句S和方面术语A结合起来构成全局语境G,全局语境G的输入格式为G = [CLS]+S+[SEP]+A+[SEP]。局部语境L是语境句S,其格式为[CLS] + S + [SEP]。在BERT体系结构中,全局上下文G显式地表示为由上下文句子S和方面术语A组成的一对文本。当G中的一个token属于句子对的第一个或第二个段时,其段标记的索引分别为1或2。BERT模型的这种下句预测特征使得基于BERT的ASC模型能够捕捉上下文句与方面之间的语义关系。由于RoBERTa在训练模型时删除了下一个句子预测任务,因此怀疑RoBERTa表示法在ASC任务中的信息量不如BERT表示法。对应于特殊分类标记[CLS]的隐藏状态表示整个句子的聚合。

3.2.2 局部上下文关注

局部上下文向量![V^{l} = \left \{ v_{i}^{l}|i\epsilon \left [ 1,n \right ] \right \}](https://latex.csdn.net/eq?V%5E%7Bl%7D%20%3D%20%5Cleft%20%5C%7B%20v_%7Bi%7D%5E%7Bl%7D%7Ci%5Cepsilon%20%5Cleft%20%5B%201%2Cn%20%5Cright%20%5D%20%5Cright%20%5C%7D) 是通过将局部上下文放入上下文化嵌入得到的。接下来,我们将在

是通过将局部上下文放入上下文化嵌入得到的。接下来,我们将在 上应用上下文动态特征权重/上下文特征动态掩码技术(CDW/CDM)(Zeng 等 2019),以缓解与目标方面术语距离较远的无关意见词之间的影响。

上应用上下文动态特征权重/上下文特征动态掩码技术(CDW/CDM)(Zeng 等 2019),以缓解与目标方面术语距离较远的无关意见词之间的影响。

相对距离

单词之间的SRD是通过依赖项解析树中对应节点之间的最短距离来度量的。如果方面项由多个词组成,则输入词与多词方面项之间的SRD计算为每个组成词与输入词之间的平均距离。图5说明了由一个产品评论例子构建的依赖关系解析树。方面词“Sound amplifier” 和情感词“loudly”之间的SRD计算为:SRD(amplifier,loudly)= 2,SRD(sound,loudly)= 3,→SRB(sound,amplifier, loudly)= 2.5

另一方面,当计数“sound amplifier” 和 “loudly”之间的相对语义距离是7时(如曾,等,2019所述),这可能会使关键情感词被不必要地降低权重。

上下文动态掩码(CDM)对目标词的SRD大于预定义阀值的语义性较差的上下文特征进行屏蔽。给定局部上下文 ,每个上下文单词

,每个上下文单词 的掩码向量

的掩码向量 是基于特定的SRD阀值

是基于特定的SRD阀值 计算:

计算: ,

,![M = \left [ v_{1}^{m},v_{2}^{m}...v_{n}^{m} \right ]](https://latex.csdn.net/eq?M%20%3D%20%5Cleft%20%5B%20v_%7B1%7D%5E%7Bm%7D%2Cv_%7B2%7D%5E%7Bm%7D...v_%7Bn%7D%5E%7Bm%7D%20%5Cright%20%5D) ,

, ,O和I分别是0和1的向量;O和I∈

,O和I分别是0和1的向量;O和I∈ ,其中h是上下文化嵌入的隐藏大小,也是局部上下文化向量

,其中h是上下文化嵌入的隐藏大小,也是局部上下文化向量 的维数。

的维数。 表示用掩码矩阵M掩码局部向量

表示用掩码矩阵M掩码局部向量 的逐元素点积。

的逐元素点积。

上下文动态加权(CDW)保留了语义相对较低的上下文特征的贡献,但基于他们与方面术语的距离去减少对他们的重视。因此 ,

,![W = \left [ v_{1}^{w},v_{2}^{w}...v_{n}^{w} \right ]](https://latex.csdn.net/eq?W%20%3D%20%5Cleft%20%5B%20v_%7B1%7D%5E%7Bw%7D%2Cv_%7B2%7D%5E%7Bw%7D...v_%7Bn%7D%5E%7Bw%7D%20%5Cright%20%5D) ,

, ,其中N是上下文句子的长度。

,其中N是上下文句子的长度。

微调过程

分类token“![\left [ CLS \right ]](https://latex.csdn.net/eq?%5Cleft%20%5B%20CLS%20%5Cright%20%5D) ”

” 的影藏状态被池化并输入到softmax层,以从集合{Positive,Netural,Negative}中预测极性。与AE模型相似,我们使用L2正则化的交叉熵作为损失函数来微调整个ASC深度学习模型。

的影藏状态被池化并输入到softmax层,以从集合{Positive,Netural,Negative}中预测极性。与AE模型相似,我们使用L2正则化的交叉熵作为损失函数来微调整个ASC深度学习模型。

4 效果评估

4.1 数据集

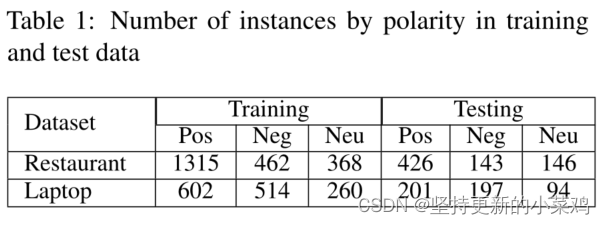

我们在两个基准数据集上评估并比较了所提出的AE和ASC模型,如表1所示。它们是来自SemEval2014 Task 4挑战的笔记本电脑和餐厅数据集(Pontiki et al, 2014)。数据集中的每个样本句子都标注了标记的方面术语及其相关的极性。

4.2 基线模型(baseline)

Baseline就是参照物,可以是最基础的模型,业界的普遍做法或者你要去pk的对手玩法。选取什么作Baseline看自己的目的。

我们在ABSA任务中对最近的模型进行了性能基准测试,以证明所提出的CSAE模型和LCFS-ASC模型的有效性。

第一组模型采用流水线方法,独立训练单任务模型,并将AE和ASC的输出进行流水线化,构建端到端的ABSA解决方案。为了突出上下文嵌入在ABSA任务中的改进性能,我们在AE和ASC任务中选择了高性能的基于词嵌入和基于上下文嵌入的模型。为了进行公平的比较,我们只考虑与领域无关的模型,而避免与训练后的方法进行比较,因为它们需要,在对域内终端任务进行微调之前,在大型语料库上重新使用整个模型。

对于AE任务,我们选择了两个基于词嵌入的模型和一个基于上下文嵌入的模型,以证明一个简单的BERT层可以优于使用词嵌入的复杂网络:

BiLSTM (Liu et al, 2015)是一种在单词嵌入表示上使用双向LSTM的命名实体识别模型。

DTBCSNN (Ye et al, 2017)是一种基于依赖树的堆叠卷积神经网络,它使用推理层进行方面提取。

BERT-AE (Devlin等人,2018)使用BERT表示AE。该模型作为一个参考,展示了我们添加到上下文化表示中的设计组件的重要性。

对于ASC任务,我们选择了两种基于词嵌入的模型和四种基于上下文嵌入的模型。检验了五种不同的基于bert的ASC模型,以证明所提供的有关方面的信息可以用于关注相关的情感信息,并改进基于bert的ASC模型:

AOA (Huang et al, 2018)使用多个注意层来建模方面和句子之间的相互作用。

MGAN (Fan et al, 2018)使用细粒度和粗粒度的注意力来捕获方面和句子之间的单词级交互。

BERT-ASC (Devlin等人,2018)使用BERT表示ASC。

BERT- PT (Xu等人,2018)在大型领域特定语料库上重新训练上下文化BERT模型,以提高单词表示到最终任务的质量。

AEN-BERT (Song et al, 2019)采用情境化BERT模型和注意力机制对情境与目标之间的关系进行建模。该模型用于显示在给定上下文中利用关于目标术语的附加信息时,ASC任务中的改进。

LCF-BERT (Zeng等人,2019)采用局部-上下文-焦点设计和语义-相对距离(SeRD)来丢弃不相关的情感词。该模型作为一个参考来说明我们提出的SRD指标在改进ASC模型中的重要性。由于文中没有说明BERT模型的选择(Zeng et al, 2019),并且我们没有访问 模型,因此我们基于他们提出的方法使用

模型,因此我们基于他们提出的方法使用 模型重新实现了LCF-BERT模型。

模型重新实现了LCF-BERT模型。

第二组由综合方法组成,旨在通过统一的标记方案同时提取方面项和确定极性。这组模型可以对两个子任务中的联合信息建模,并利用所有可用的训练信息源来处理端到端ABSA问题:

MNN (Wang et al, 2018)利用注意力机制联合学习方面和情感之间的关系,形成多任务神经网络。

UABSA (Li et al, 2019)是ABSA的统一模型,由两个用于目标边界检测任务(辅助)和完整的ABSA任务(主)的堆叠RNN组成。

IMN (He et al, 2019)使用消息传递架构沿潜在变量在不同任务之间迭代传递信息。

4.3 模型的变化

为了评估我们提出的模型及其在AE和ASC任务中的组件,我们在不同的设置下进行了一系列实验。

对于我们提出的AE解决方案,我们进行了消融研究,其中某些模块从CSAE架构中移除,以显示它们对最终性能的影响:

RoBERTa-AE利用RoBERTa表示法来证明AE任务中RoBERTa表示法质量的提高。

RoBERTa-POS使用RoBERTa表示和POS嵌入来证明POS有助于识别句子中的方面术语。

RoBERTa- Dep使用RoBERTa表示和基于依赖的嵌入来比较基于依赖的特征和POS特征在AE任务中的效果。

CSAE是一个完整的模型,由RoBERTa、POS嵌入层和基于依赖的嵌入层组成。

对于我们提出的ASC解决方案,我们实验了不带LCF层的RoBERTa-ASC模型和带LCF层的完整LCFS-ASC模型。由此可见LCF层对ASC任务的影响。

RoBERTa-ASC利用RoBERTa表示法来比较BERT和RoBERTa表示法在ASC任务中的适用性。

LCFS-ASC-CDW是采用CDW技术的LCFS-ASC模型。

LCFS-ASC-CDM是采用CDM技术的LCFS-ASC模型。

请注意,由于缺乏足够的计算资源,我们使用BERTbase来实现LCFS-ASC模型,以及确保LCF-BERT与我们提出的模型之间的公平比较。类似地,CSAE模型构建在RoBERT基本模型之上。对于AE任务,我们使用SemEval challenge提供的标准评估脚本来报告F1-score。另一方面,准确性和宏观f1得分超过3类极性被认为是ASC任务的评价指标。

5、实验

表2:示例列显示了用红色高亮显示的具有多词方面术语的句子。下面两列分别显示了由RoBERTa-AE和CSAE模型预测的方面项

表2比较了基于RoBERTa - AE的模型和完整的CSAE模型的性能。值得注意的是,CSAE模型在定义多词方面术语边界方面优于RoBERTa-AE模型。使用上下文化RoBERTa特征,RoBERTa- ae只能识别名词短语中的名词“鸡尾酒”,这表明RoBERTa表示无法捕获上下文句子中的丰富语法结构。在普适依赖模式中,“Times”和“Square”是一个PROPN(专有名词)标签,是特定地点名称的一部分,与名词“鸡尾酒”有复合关系。在给出一个例子的特殊语法属性的明确信息后,CSAE成功地将一个复合名词识别为方面术语,即使方面术语“Time Square cocktail”没有出现在训练集中。

此外,即使RoBERTa-AE可以在例2中识别单独的方面术语“装满的浓缩咖啡杯”和“巧克力慕斯”,但它无法将它们组合在一起形成一个完整的多词术语。另一方面,CSAE能够对介词“with”的作用进行建模,并检测方面项的真实边界。

6 结果和分析

6.1 方面提取

6.1.1 主要结果

表3总结了我们提出的模型与基线模型的比较结果。与基于词嵌入的模型相比,我们的CSAE模型比BiLSTM和DTBCSNN模型表现更好,分别获得3.93个百分点(p.p), 1.99p.p和5.23p.p和2.68p.p分别在笔记本电脑和餐厅数据集中。在笔记本电脑领域,我们的模型的性能接近IMN,在这两种情况下都优于其他集成方法。特别是,我们的CSAE模型的f1得分至少比餐厅领域的其他集成方法高3.32个百分点,这表明单任务模型可以通过简单地提高特征表示的质量,显著优于具有复杂架构的集成解决方案。

6.1.2 消融实验

为了研究CSAE中不同设计组件的影响,我们从仅使用RoBERTa表示进行方面提取的基本模型开始,并依次添加其他组件。我们发现,与基于BERT的模型相比,我们的基本模型总是具有更好的性能。通过引入POS嵌入和基于依赖的嵌入来捕获丰富的语法信息,性能得到了提高。POS嵌入仅表示每个单词的POS,并将特征提取工作留给注意层,而基于依赖关系的嵌入直接将单词之间的语法交互注入到单词表示中。因此,基于依赖特性的RoBERTa的F1score比POS特性的RoBERTa略高。总体而言,两个组成部分都得到充分补充的CSAE得到了显著改善。这表明RoBERTa模型还没有完全“理解”自然语言的语法方面,通过进一步利用句子的语法信息,语境化LM还有改进的空间。

6.2 方面情感分类

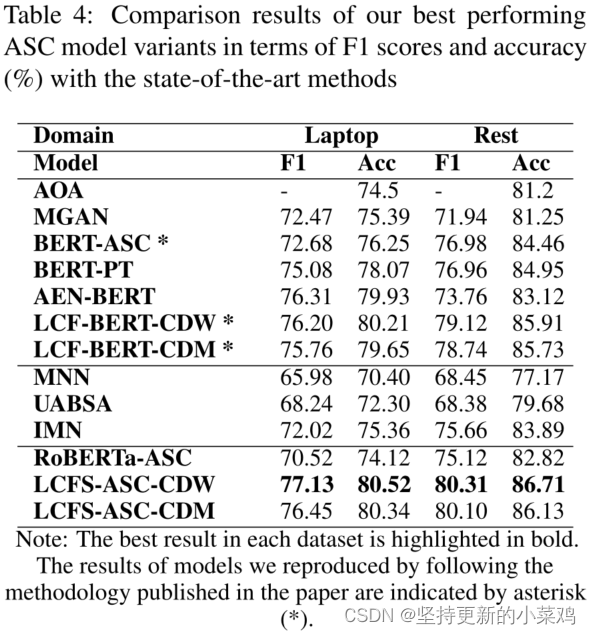

6.2.1 主要结果

表4表明,我们提出的使用句法相对距离来本地化上下文特征的LCFS-ASC在Laptop和Restaurant数据集中都具有最佳性能。第一部分、第二部分和第三部分分别展示了单任务、集成和我们提出的方法。我们提出的模型在不使用来自更大语料库的额外知识来训练特定领域的嵌入的情况下,在很大程度上优于BERT-PT。所有基于BERT的单任务模型都优于集成模型,这表明统一标签模式通过引入额外的类来增加ASC任务的开销。如3.2.1节所述,RoBERTa中删除了下一个句子对任务,使得RoBERTa表示法不太适合ASC任务,导致RoBERTa-ASC性能不佳。

当使用CDM或CDW时,提出的LCFS-ASC与LCF-BERT相比性能略有提高。实验结果证明了句法相对距离在句法信息编码中的有效性。CDW比CDM更能提高LCFS-ASC模型的性能。由于CDM完全屏蔽了被认为不重要的上下文信号,它可能会错误地忽略有用的信号。另一方面,CDW强调灵活性,并允许进一步的信号贡献对应于其与基于依赖的树中的方面项的相关性的小权重。

6.2.2 通过注意分数可视化分析SRD的效果

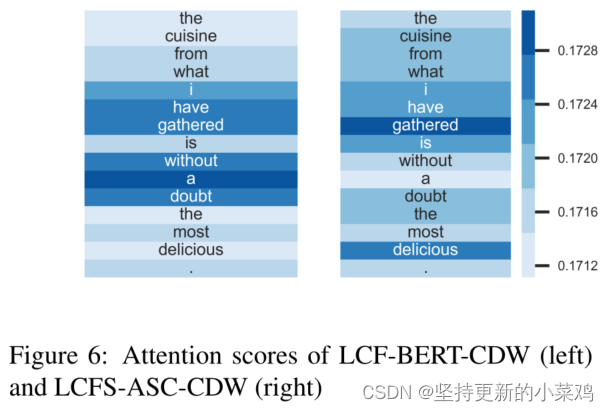

图6显示了表现最佳的LCFS-ASC-CDW和LCF-BERTCDW模型的注意力得分。对于给定的输入句子,LCFSASC为方面术语“cuisine”分配了正确的正极性,而LCF-BERT则给出了错误的负极性预测。由于LCF-BERT使用语义相对距离,情感术语“毫无疑问”受到了最多的关注,因为它与基于字数指标的方面术语“烹饪”距离很近。另一方面,关键情感词“美味”的信号被错误地降低了,因为它远离了方面词“美食”。尽管如此,LCFS-ASC仍然保留了单词“delicious”的重要性,因为句法相对距离解释了形容词“delicious”和方面术语“cuisine”在基于依赖关系的树中的直接相互作用。

7 总结和未来工作

我们提出了一个端到端的ABSA解决方案,该方案将方面提取器和方面情感分类器流水线化。研究结果表明,利用句子的句法结构可以使情境化模型在ASC和AE任务中都能在现有工作的基础上得到改进。我们提出的方面情感分类器优于训练后的ASC模型,并能够创建一个领域无关的解决方案。该方法允许方面情感分类器关注关键情感词,这些关键情感词通过基于依赖的结构对目标方面词进行修改。这些实质性的改进突出了最近的上下文化嵌入模型在“理解”语法特征方面的不佳表现,并为开发更多语法学习的上下文化嵌入指明了未来的方向。人们可以尝试通过应用统一的标签方案来适应我们提出的CSAE架构的集成方法;因此,可以同时实现方面提取和情感分类。

8 致谢

文章个人解读

一、摘要:

1、作者提出了一个端到端的ABSA解决方案,而不是分别考虑方面词提取和方面词情感分类这两个任务。

2、由于以前的工作不能完全利用语法信息的重要性,因此,方面词提取模型经常在检测多词方面词边界时失败。

3、方面词情感分类器不能够说明方面词和上下文单词之间的语法相关性,所以此篇论文探索了句子中的语法方面词并且将自注意力机制用于语义的学习。

4、作者将词性(part-of-speech,POS)embeddings、基于依赖关系的(dependency-based)embeddings和上下文的(contextualized)例如(BERT、RoBERTa)embeddings三者结合去增强方面提取词的表现。

5、作者提出语法相关距离去削弱与方面词有微弱关系的不相关单词的不利影响,这提高了方面词情感分类器的精度。

二、引言:

1、多任务模型与单任务模型相比通常表现更差

2、上下文(contextualized)的语言模型,即OpenAI GPT,BERT,RoBERT不能确定多词方面词的边界。作者假设这一缺陷是因为contextualized embeddings无法编码丰富的语法信息。作者提出AE架构syntax-based aspect extraction(CSAE),它包含POS embeddings、dependency-based embeddings、self-atention和RoBERTa层。

3、Zeng等人简单地将两个词之间的字数作为它们的语义相对距离,而忽略了它们之间的句法关系。作者使用dependency parsing tree中两个词之间的最短路径作为句法相对距离(syntactic relative distance,SRD)。作者将此模型命名为local context focus on syntax-ASC(LCFS-ASC)模型。

4、所以综上所述,本文的主要贡献在于:(1)提出了多通道CSAE模型,该模型将语法方面词提炼为上下文的特征;(2)提出了LCFFS-ASC模型,它可以分析单词之间的句法联系,从而更好地理解与目标词相关的本地语境;(3)我们通过探索LCF层的注意力得分来研究SRD的重要性。

三、相关工作

相关工作这一节、作者详细介绍了ABSA解决方案从Word-embedding-based Model到contextualized-embedding-based models的演变过程,并重点介绍了它们的优缺点。Word-embedding-based Model:目标依赖的长短期记忆(TD-LSTM),注意力机制,Attention-based LSTM with Aspect Embedding(ATAE-LSTM)。Contextualized Pre-trained Language Model:词汇表征的质量由其对句法特征和多义行为(即词义)的编码能力来衡量。最近的研究偏离了全局词表示,考虑了上下文相关的词嵌入,它以不同的方式“描述”单词,以说明固有的词义。BERT,RoBERTa,AEN-BERT,LCF-BERT(作者参考了这篇文章,上文提到的语义相对距离)。最近有一些基于BERT 的方法在AE任务中取得了很好的成果。然而,他们需要在一个大型特定领域语料库上重新训练BERT模型。作者不采用这种培训后的方法,而是寻找通用的AE架构。

四、方法提出

作者怎么做的方法参考论文翻译方法提出这一节

欢迎阅读者批评指正!