在企业信息化建设不断推进、逐渐进行数字化转型的今天,几乎所有的企业都卷入到数据及其处理(数据收集、存储、检索、传输、分析和表示)的浪潮中,数据已成为重要生产要素和无形资产,针对主数据的全生命周期管理迫在眉睫。

对企业而言,分散管理的数据由于不具备一致性、完整性、准确性,使整个企业普遍存在产品管理不力、供应商管理不力、订单管理不力等现象,解决这一问题的根本方法就是引入主数据管理,通过

对主数据进行全生命周期管理,实现主数据的全一视图,从而实现全方面的管理

。

1总体说明

总体说明主要包括对于产品的功能架构、整体的数据集成架构以及业务需求等进行介绍。

1.1业务需求

在实际的项目上,主数据分布在各个业务系统间,而当领导层需要获取这些数据很困难,这时便需要将上游系统的数据通过基础数据平台进行集中的管理,将基础数据进行集成,之后将标准的、唯一的、准确的主数据分发到下游系统,打通系统间的壁垒。

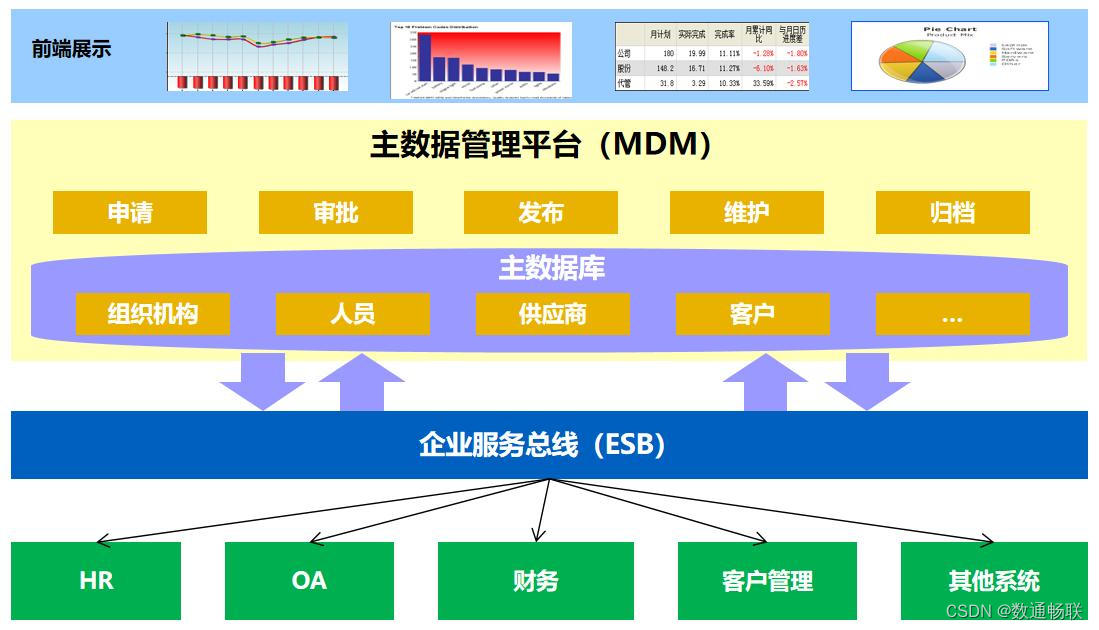

1.2集成架构

整体集成架构以MDM+ESB为主,具体如下:

1.以业务系统为数据源头,提供基础数据通过ESB流程同步数据到主数据,在主数据中进行统一治理。

2.MDM提供治理之后的基础数据,通过BPM流程推送数据到下游系统。

3.同时,也可以在ESB流程当中配置主数据自动分发业务系统。

1.3功能架构

MDM基础数据平台整体功能架构如下图所示:

MDM基础数据平台分为了主数据管理平台与MDC控制台,具体模块的功能如下。

MDM主数据管理平台:包含了首页看板、数据管理、质量管理和统计分析。

1.

首页看板

:用于展示主数据的类型数量、参考数据的类型数量、已经注册了的应用数量、目前正在代办的任务、已经办理的任务、MDM的个性化配置等等;

2.

数据管理

:对组织、人员、岗位、客户等基础信息的管理,包括基础数据的关联,发起流程,再次分发等功能。每类主数据都有各自的参考数据,对比如民族、地区、学位等常用而又比较复杂的元数据进行管理;

3.

质量管理

:对相似数据进行筛选、巡检,分析数据的血缘,进行大批量数据的清洗;

4.

统计分析

:从主数据的数据量、同步情况、分发情况,进行数据角度,以及从各个应用所下发的数据,从源头业务系统同步进来的数据,对其他业务系统进行数据下发,进行应用角度两个方面进行统计分析。

MDC控制台:包含了数据建模、功能建模、流程建模、应用管理等。

1.

数据建模

:对主数据、参考数据、分类数据进行建模操作;

2.

功能建模

:创建数据表结构,为主数据进行功能建模,为主数据配置功能组件,以及附件内容的管理;

3.

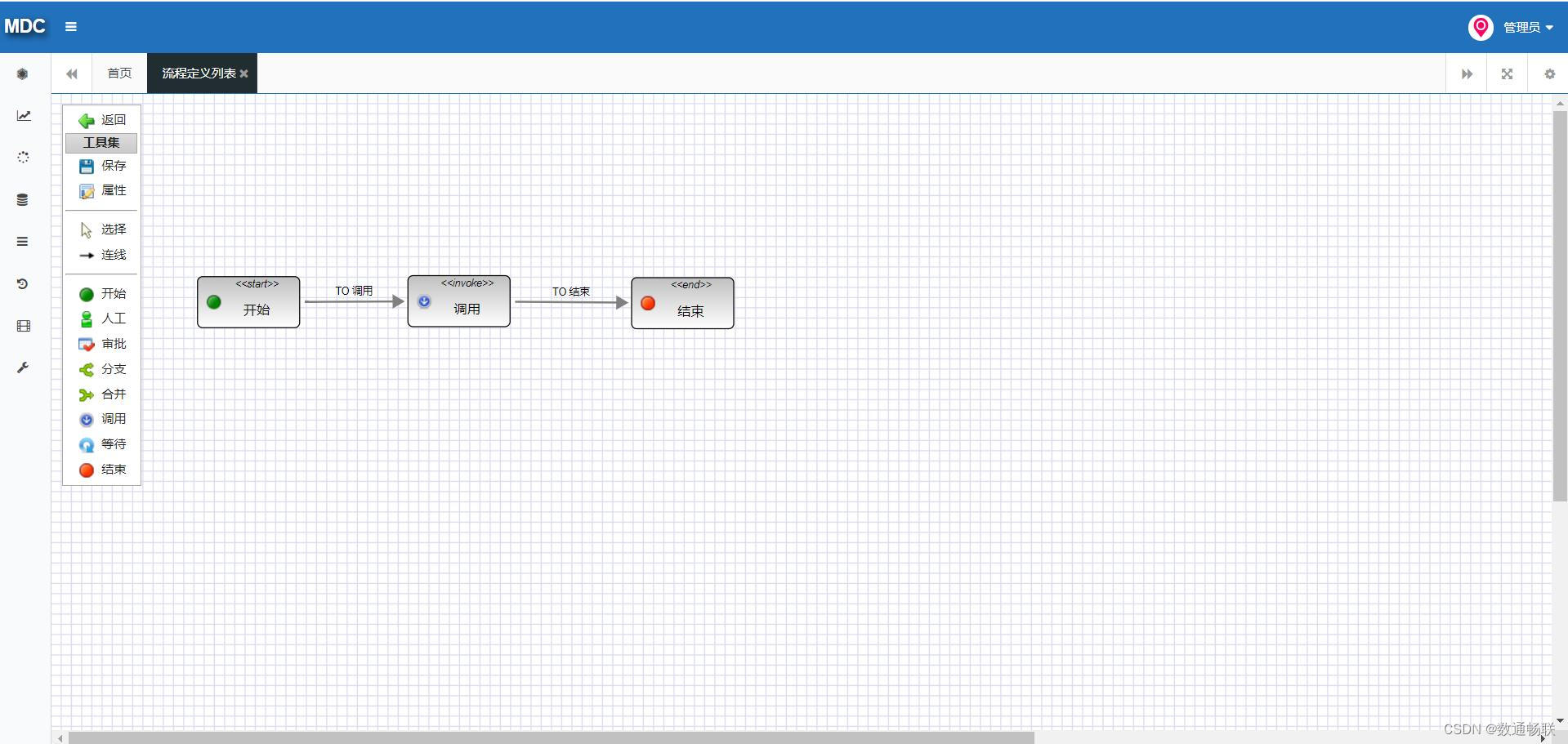

流程建模

:为主数据和参考数据定义审批流程,如:流程定义、模拟仿真等操作;

4.

应用管理

:包括元数据的关联、分组和外部管理系统的关联、分组。

2实现方式

在本章中将对于主数据治理的具体实现方式进行详细的介绍,具体将分为管理体系、标准规范以及平台功能三个方面进行展开说明。

2.1管理体系

企业要做数据管理工作时,因为主数据固有的一些特性,不得不面对治理中的一些难题,需要在管理层面去解决部门责任不清晰、数据定义不明确、维护流程不统一、数据共享不及时等问题,为制定统一的主数据标准体系做铺垫。

2.2标准规范

标准规范是主数据管理体系建设的核心内容,结合企业数字化转型规划和主数据建设需求,梳理企业核心主数据,针对各类主数据的产生、使用、管理、维护等过程进行规范,编制企业主数据管理规范、主数据标准规范、历史数据清洗规范和主数据集成规范等。

2.3平台功能

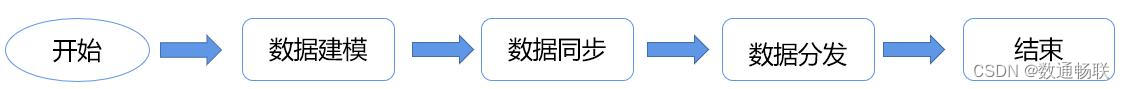

在进行了管理体系和标准规范建设之后则需要借助主数据管理平台进行主数据的全生命周期的管理和维护,而在主数据管理平台的管理过程的实现思路具体如下:

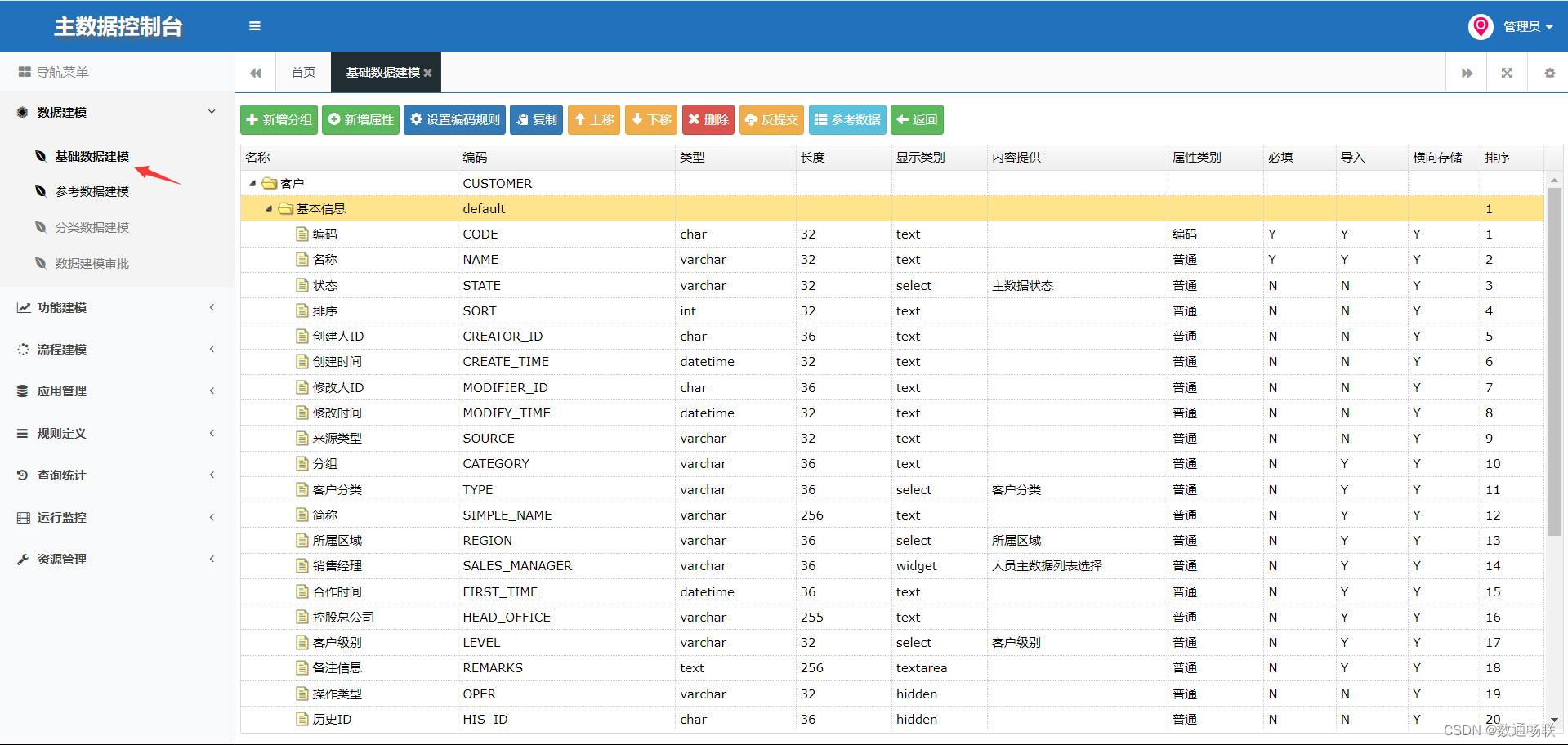

1.数据建模:

(1)基础建模(建表):过程中进行字段校验规则的设置;

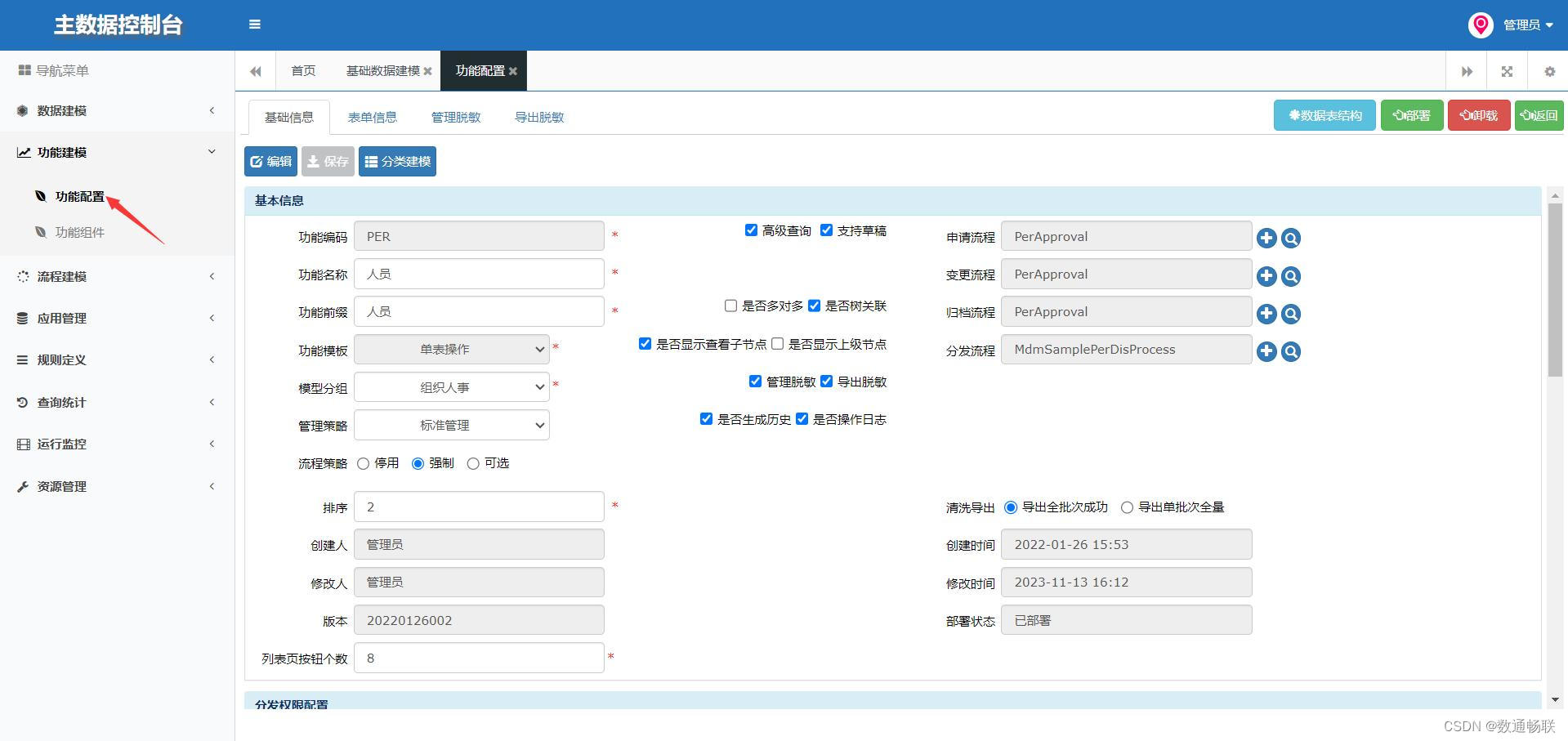

(2)功能建模(页面):通过功能建模进行页面的功能配置;

2.数据同步:通过ESB流程将数据同步到主数据(也可以配置自动分发);

3.数据分发:通过BPM将治理后的数据分发到各个业务系统。

而本次主数据治理的过程中涉及到的场景清单如下:

3管理体系

管理体系主要分为管理内容、部门协作以及管理架构的建设三个方面,下面进行详细的介绍。

3.1管理内容

建立一套以静态数据为核心的主数据标准化管理体系,内容包括主数据管理组织、制度、流程、主数据编码标准、主数据质量管理、主数据安全管理、主数据交换标准、主数据运维管理等。

3.2部门协作

主数据管理体系的建设不是某个部门能够独立完成的工作,

从人资、财务的基础科目统一,到供应链、生产制造涉及的物料体系、供应商管理

等,需要企业各业务部门的参与,因此,建立由分管领导牵头、业务部门负责人共同组成的管理委员会十分必要。这个组织不是实体机构,而是跨部门、跨业务板块的虚拟组织,由企业赋予一定的权限,至少是针对主数据管理相关的权限。

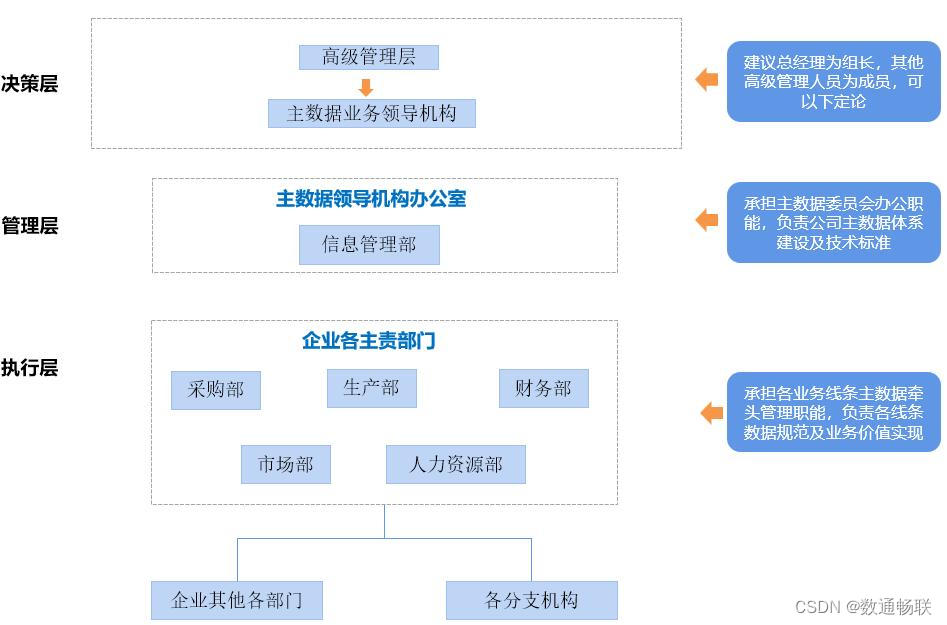

3.3管理架构

最终要搭建的管理架构如下所示:

构建主数据管理组织,通常采用三层管理架构:决策层、管理层、执行层。

1.

决策层

:主要由公司领导机构构成,负责总体决策。

管理职责:

(1)主数据管理战略决策,促进整个组织达成共识;

(2)监督、审议企业标准的制定、修订、复审和宣贯工作。

2.

管理层

:主要由公司信息管理部构成,负责主数据体系建设以及技术标准。

管理职责:

(1)负责制定企业主数据管理策略;

(2)负责组组织、人员、岗位、客户、供应商、物料分组、物料、设计BOM、制造BOM、工艺信息、项目、令号、费用项目、财务科目、仓库、仓位、知识产权等主数据标准的编制、修订工作;

(3)收集、识别和管理关键的主数据管理问题和风险;

(4)负责主数据标准工作的宣传与培训。

3.

执行层

:由企业各主责部门构成,负责主数据相关业务进行统一归口管理。

管理职责:

(1)负责所归口主数据标准的制订和调整;

(2)负责企业归口主数据的日常审核、维护等业务管理工作;

(3)负责协调解决归口主数据业务工作中出现的重大问题;

(4)负责归口主数据应用情况监督检查与绩效考核工作。

4标准规范

主数据管理标准规范涉及三大块内容,包括主数据标准规范、主数据管理标准规范、主数据集成标准规范,具体如下。

4.1管理标准

企业主数据管理在“统一标准、集中管控、专业负责、分级审核”的原则下,建立高效快捷的管理和运行机制。

1.

统一标准

:企业统一建立、发布各主数据的组织标准、流程标准、编码标准和属性标准,并持续更新和优化主数据管理标准;

2.

集中管控

:企业通过主数据管理系统实现主数据管控流程的集中统一管理;

3.

专业负责

:企业设立主数据管理办公室、各类主数据的专业管理部门,实现主数据的专业化、标准化管理;

4.

分级审核

:企业对主数据的管理,要分别设立固定的组织、配备专业的人员、设置独立的管理和业务流程。对于统一管理的主数据由归口部门负责预审,主数据管理办公室负责终审。

4.2数据标准

主数据的标准规范清单如下:

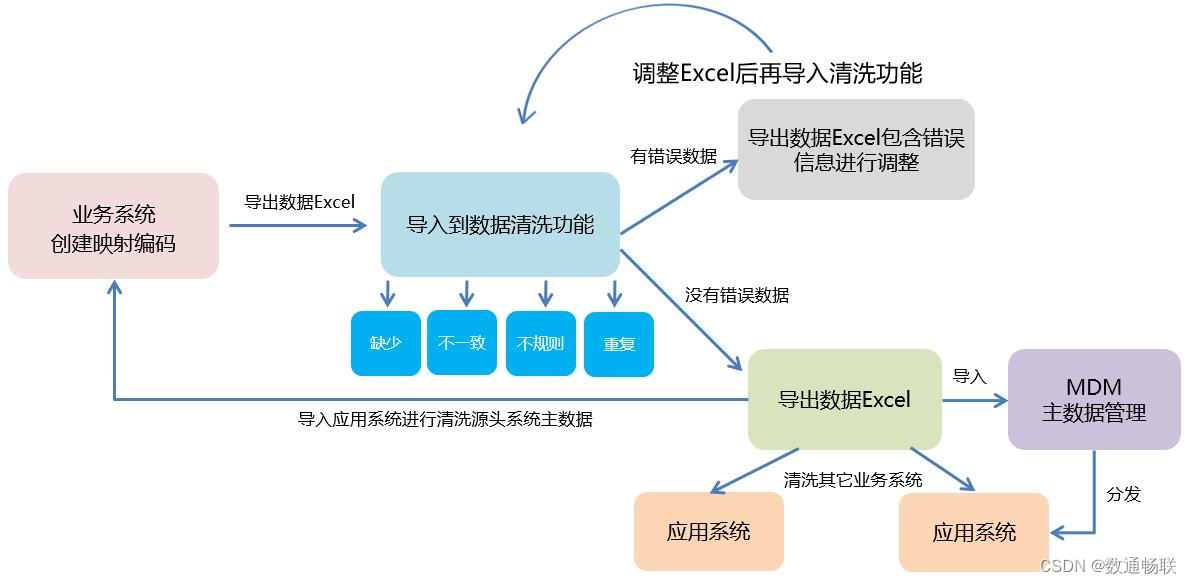

4.3清洗标准

清洗的工作方式分两种:excel清洗、接口清洗。excel清洗和接口清洗是在将数据导入MDM基础数据平台之前保证数据规范和标准性的必要操作。批量清洗导入MDM基础数据平台后可能出现遗漏的不规范数据,需要工作人员在MDM基础数据平台中检查维护。

1.

excel清洗

:excel清洗过程中,工作人员以原始数据为基础,按MDM基础数据平台中的excel模板将需要清洗的数据进行清洗整合,再将清洗好的excel数据表导入MDM基础数据平台中。

2.

接口清洗

:接口清洗过程中,工作人员以原始数据为基础,按MDM基础数据平台中的excel模板将需要清洗的数据进行整理,再调用ESB企业服务总线中的清洗导入流程将数据清洗后导入MDM基础数据平台中。

3.

注意事项

:批量导入信息过程中要确保必填项是都添加完整,批量导入信息过程中要确保信息格式标准性,使用接口清洗的方式需要根据主数据类别制定对应的清洗规则。

4.4集成标准

主数据的服务标准规范主要包括主数据格式规范、原系统接入规范等,由主数据平台给出对接的标准规范文档主要,源头系统按照标准规范进行数据服务提供,而下游接收系统则按照对应的主数据分发报文进行数据解析,以此完成主数据的集成打通。

其中集成标准具体包括以下内容:

5平台功能

通过管理体系以及标准规范的建设之后,便可以采用主数据管理平台进行主数据的治理,下面对于具体内容进行详细的介绍。

5.1数据清洗

通过上文已经对于整体主数据治理的实现步骤进行了相应的梳理,下面对于治理过程中尤为重要的数据清洗的具体实现过程进行详细的介绍。

5.1.1清洗流程

数据清洗可以分为初始化清洗、数据同步时的清理以及数据在下发过程中对已上线的下游系统的清洗。

1.主数据在数据建模完毕后需要进行数据初始化,在数据建模时定义会定义校验规则,数据初始化时将相似数据、重复数据、缺失数据进行筛选调整,最终将全量数据初始化至主数据中;

2.在源头系统将数据同步至临时表时,根据校验规则等对同步数据进行甄别的筛选,不通过校验规则的数据不会同步至主数据中并会将错误信息回写给源头系统;

3.针对已经上线的业务系统,在数据分发时会通过扩展字段写入的形式由MDM配合目标系统协助进行数据清洗。

5.1.2初始化清洗

在数据初始化时进行主数据清洗,可以通过接口调用、Excel等方式获取到全量数据。MDM根据基础数据字段的校验规则对全量数据进行清洗,在清洗过程中针对不符合校验规则的数据进行甄别调整,在清洗完毕后将标准的主数据导入进MDM中。

5.1.3同步清洗

当主数据通过接口同步至MDM中时,MDM首先会调用临时表接口,将数据同步至临时表,在这个过程中MDM会对同步数据进行校验清洗,在同步至真实表过程中针对已有数据进行修改,而对没有的数据进行新增处理。当调用临时表接口时,MDM不会接受不符合接口规则的数据,并将错误的日志反馈给源头系统。

5.1.4下游清洗

新上线的业务系统可以直接调用MDM的初始化接口,将主数据同步至对应系统中,但是在MDM上线时有很多情况会对接已上线的业务系统,针对这种系统可以通过以下方式进行清洗:

1.已上线的业务系统可以扩展一个编码字段;

2.MDM将生成的编码给到下游系统,下游系统将编码信息存储在扩的编码字段中;

3.MDM在数据下发时新的数据直接新增至业务系统;

4.旧数据可根据扩展的编码字段进行比对,并进行调整变更。

5.2数据治理

在本章节中,将对数据治理的实现方式进行具体介绍,下面按照前置准备以及数据同步、数据分发、自动分发等三种场景的实现方式进行详细介绍。

5.2.1前置准备

在进行主数据治理的相关场景实现之前,首先需要进行前置的一些准备,包括数据建模、功能建模、流程建模以及应用配置。

1.数据建模(建表):通过主数据平台进行基础数据的建模,过程中进行字段校验规则的设置(校验规则可以在数据清洗当中使用);

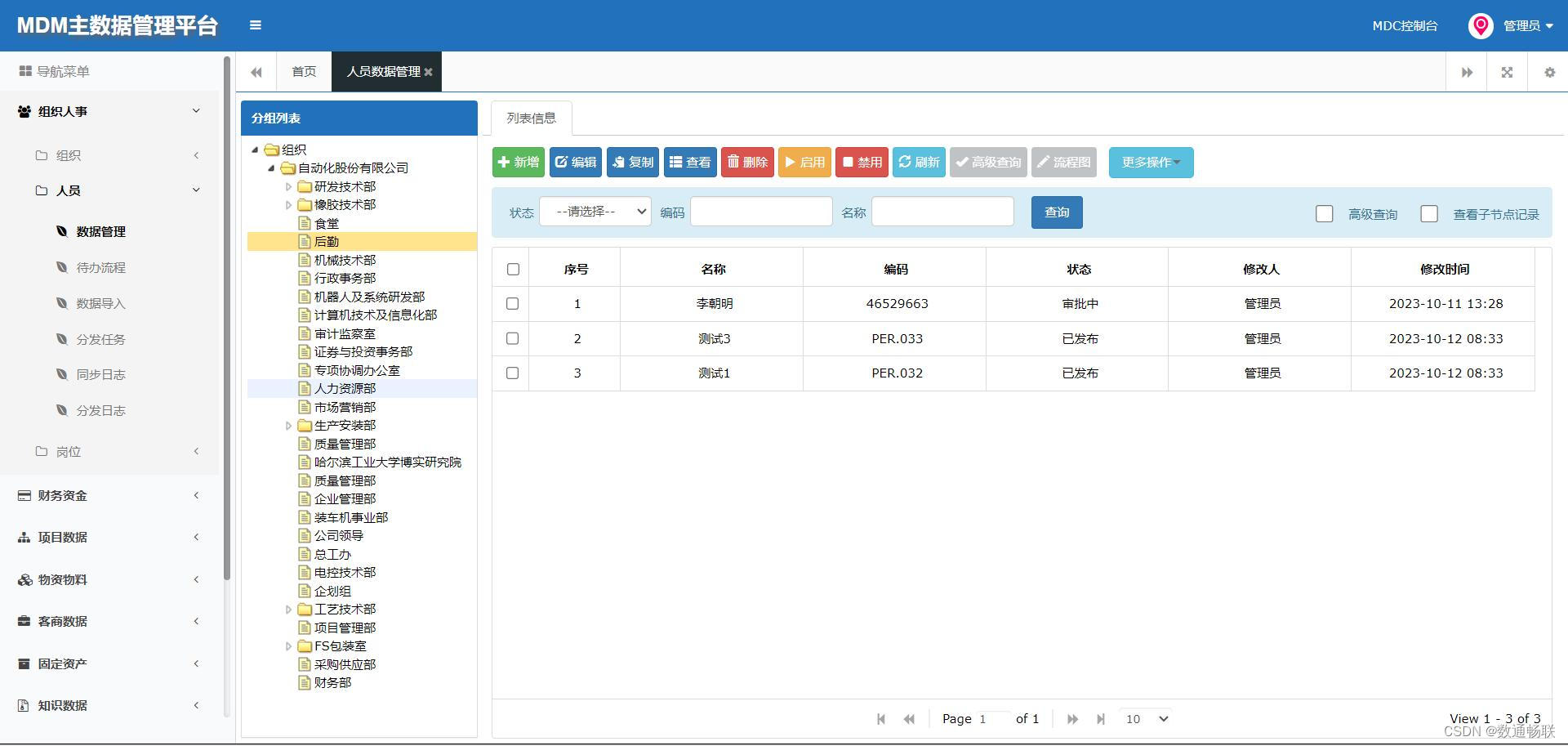

2.功能建模(页面):数据建模之后可以进行页面的功能配置,用于对于数据管理台的页面功能进行配置,部署之后便可以通过前台页面功能对于主数据进行全生命周期的管理;

功能建模:

管理页面:

3.流程建模:配置对于BPM分发工作流后可以在前台将主数据通过生成任务的方式触发BPM工作流推送到应用配置当中的业务系统接收接口当中;

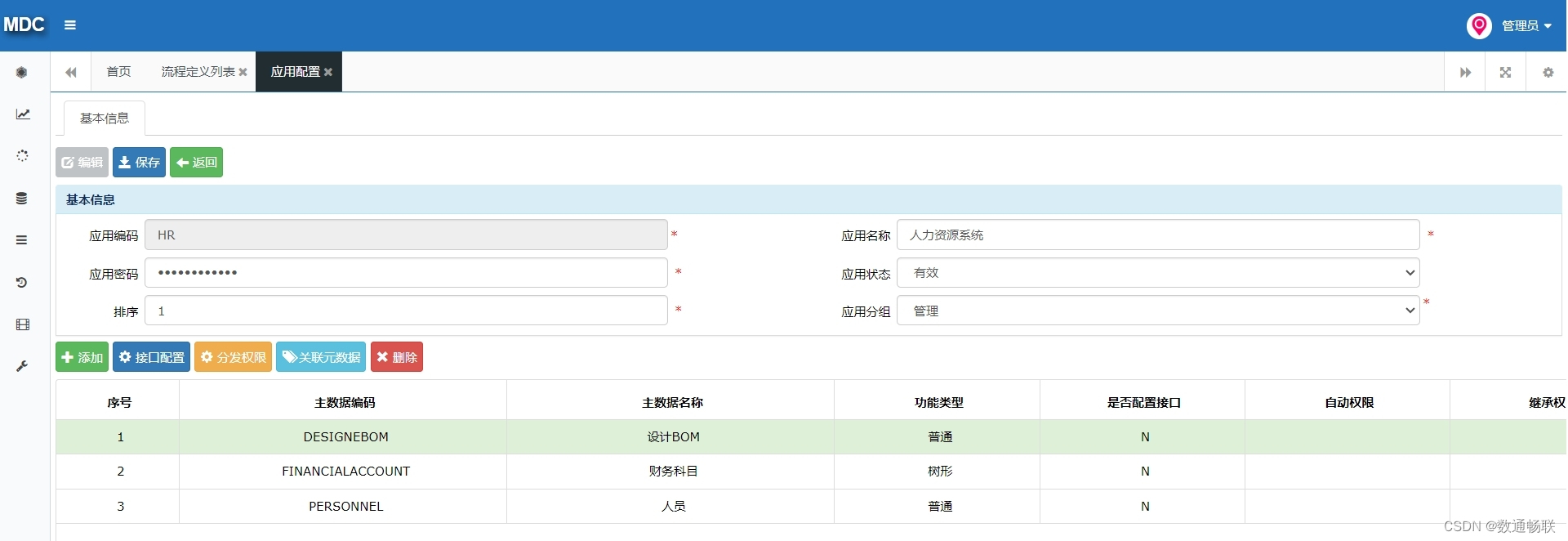

4.应用配置:通过应用配置可以管理业务系统信息,同时可以进行业务系统的主数据接收接口的地址配置,用于进行业务系统主数据的接收。

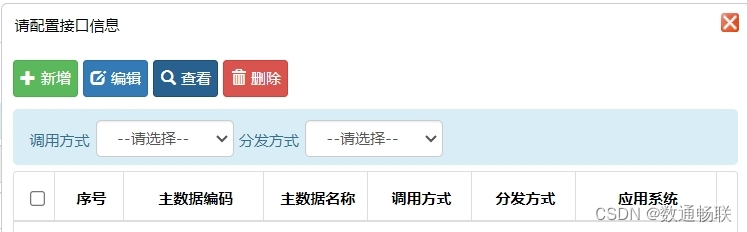

5.2.2数据同步

主数据的同步是以上游系统为源头,通过ESB构建集成通道,调用主数据的接收接口,通过流程的调用将数据同步到主数据平台。具体的流程节点如下:

1.获取业务系统的主数据;

2.循环对于入参进行映射解析;

3.获取mdmTokenId;

4.数据存入MDM临时表;

5.数据存入MDM真实表;

注意事项:在同步的过程中可以选择是否配置主数据自动分发的接口,控制主数据是否自动通过BPM流程分发下游系统。

5.2.3数据分发

主数据的分发有两种方式,一种是自动分发,一种是手动分发。其中自动分发在同步时进行配置,而手动分发是在主数据平台进行手动生成任务的方式选择BPM流程推送数据到下游系统,操作如下:

6总结说明

通过本次单点退出的开发,使自身有了一定的感悟和提升,现从过程总结、难点攻克以及后续思路几个方面进行总结。

6.1过程总结

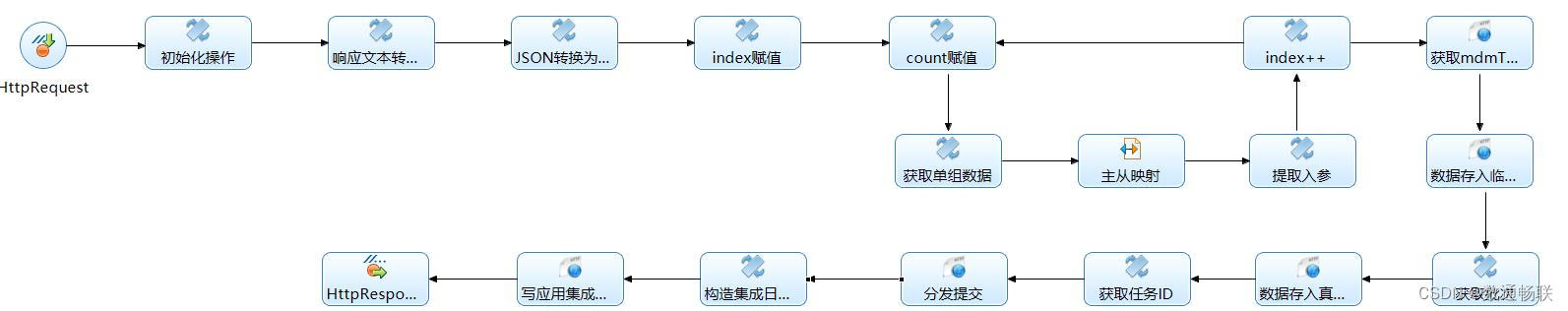

主数据的治理主要包括以下过程:

1.

数据建模

:

(1)基础建模(建表):过程中进行字段校验规则的设置;

(2)功能建模(页面):通过功能建模进行页面的功能配置;

2.

数据同步

:通过ESB流程将数据同步到主数据(也可以配置自动分发);

3.

数据分发

:通过BPM将治理后的数据分发到各个业务系统;

4.

清洗导入

:初始化数据以及历史数据都需要清洗导入,筛选出不合规的数据,用于保证数据的质量。

6.2难点攻克

在本次工作的历练,让我的能力有了很大的提升,同时在配置的过程中也是遇到了一些难点,现从以下几点进行阐述。

1.对于同步流程的数据转换:在刚开始配置同步流程的过程中没有梳理好数据的转换格式以及字段的映射关系,最后通过断点调试加以解决。

2.质量管理相关功能的使用:对于相关功能掌握的熟练度不够,比如匹配度、匹配字段的配置,校验规则的设置等。

6.3后续思路

通过开发配置的过程对实现方式进行了总结梳理,在进行实际项目的开发和配置时要结合真实的业务场景,在使用过程中加深了产品的了解,同时深化了业务理解,而在平时也要及时对于产品的相关功能进行学习和掌握,更多地了解产品与业务的结合使用。

在实际项目中需要更多去参与到实际的业务,通过业务场景发现自身的不足,同时在使用产品实现场景的过程中发现产品的不足,通过项目打磨自己完善产品,同时累积更多的项目经验,为后续工作打下良好的基础。