大神笔记,转载自http://blog.csdn.net/u012162613/article/details/45397033

- Keras简介

Keras是基于Theano的一个深度学习框架,它的设计参考了Torch,用Python语言编写,是一个高度模块化的神经网络库,支持GPU和CPU。使用文档在这:http://keras.io/,这个框架貌似是刚刚火起来的,使用上的问题可以到github提issue:https://github.com/fchollet/keras

下面简单介绍一下怎么使用Keras,以Mnist数据库为例,编写一个CNN网络结构,你将会发现特别简单。

- Keras里的模块介绍

Optimizers

顾名思义,Optimizers包含了一些优化的方法,比如最基本的随机梯度下降SGD,另外还有Adagrad、Adadelta、RMSprop、Adam,一些新的方法以后也会被不断添加进来

上面的代码是SGD的使用方法,lr表示学习速率,momentum表示动量项,decay是学习速率的衰减系数(每个epoch衰减一次),Nesterov的值是False或者True,表示使不使用Nesterov momentum。其他的请参考文档。

Objectives

这是目标函数模块,keras提供了mean_squared_error,mean_absolute_error

,squared_hinge,hinge,binary_crossentropy,categorical_crossentropy这几种目标函数。

这里binary_crossentropy 和 categorical_crossentropy也就是常说的logloss.

Activations

这是激活函数模块,keras提供了linear、sigmoid、hard_sigmoid、tanh、softplus、relu、softplus,另外softmax也放在Activations模块里(我觉得放在layers模块里更合理些)。此外,像LeakyReLU和PReLU这种比较新的激活函数,keras在keras.layers.advanced_activations模块里提供。

Initializations

这是参数初始化模块,在添加layer的时候调用init进行初始化。keras提供了uniform、lecun_uniform、normal、orthogonal、zero、glorot_normal、he_normal这几种。

layers

layers模块包含了core、convolutional、recurrent、advanced_activations、normalization、embeddings这几种layer。

其中core里面包含了flatten(CNN的全连接层之前需要把二维特征图flatten成为一维的)、reshape(CNN输入时将一维的向量弄成二维的)、dense(就是隐藏层,dense是稠密的意思),还有其他的就不介绍了。convolutional层基本就是Theano的Convolution2D的封装。

Preprocessing

这是预处理模块,包括序列数据的处理,文本数据的处理,图像数据的处理。重点看一下图像数据的处理,keras提供了ImageDataGenerator函数,实现data augmentation,数据集扩增,对图像做一些弹性变换,比如水平翻转,垂直翻转,旋转等。

Models

这是最主要的模块,模型。上面定义了各种基本组件,model是将它们组合起来,下面通过一个实例来说明。

3.一个实例:用CNN分类Mnist

数据下载

Mnist数据在其官网上有提供,但是不是图像格式的,因为我们通常都是直接处理图像,为了以后程序能复用,我把它弄成图像格式的,这里可以下载:http://pan.baidu.com/s/1qCdS6,共有42000张图片。

读取图片数据

keras要求输入的数据格式是numpy.array类型(numpy是一个python的数值计算的库),所以需要写一个脚本来读入mnist图像,保存为一个四维的data,还有一个一维的label,代码:

import os

from PIL import Image

import numpy as np

def load_data():

data = np.empty((42000,1,28,28),dtype="float32")

label = np.empty((42000,),dtype="uint8")

imgs = os.listdir("./mnist")

num = len(imgs)

for i in range(num):

img = Image.open("./mnist/"+imgs[i])

arr = np.asarray(img,dtype="float32")

data[i,:,:,:] = arr

label[i] = int(imgs[i].split('.')[0])

return data,label

构建CNN,训练

短短二十多行代码,构建一个三个卷积层的CNN,直接读下面的代码吧,有注释,很容易读懂:

from __future__ import absolute_import

from __future__ import print_function

from keras.preprocessing.image import ImageDataGenerator

from keras.models import Sequential

from keras.layers.core import Dense, Dropout, Activation, Flatten

from keras.layers.advanced_activations import PReLU

from keras.layers.convolutional import Convolution2D, MaxPooling2D

from keras.optimizers import SGD, Adadelta, Adagrad

from keras.utils import np_utils, generic_utils

from six.moves import range

from data import load_data

data, label = load_data()

print(data.shape[0], ' samples')

label = np_utils.to_categorical(label, 10)

model = Sequential()

model.add(Convolution2D(4, 1, 5, 5, border_mode='valid'))

model.add(Activation('tanh'))

model.add(Convolution2D(8,4, 3, 3, border_mode='valid'))

model.add(Activation('tanh'))

model.add(MaxPooling2D(poolsize=(2, 2)))

model.add(Convolution2D(16, 8, 3, 3, border_mode='valid'))

model.add(Activation('tanh'))

model.add(MaxPooling2D(poolsize=(2, 2)))

model.add(Flatten())

model.add(Dense(16*4*4, 128, init='normal'))

model.add(Activation('tanh'))

model.add(Dense(128, 10, init='normal'))

model.add(Activation('softmax'))

sgd = SGD(l2=0.0,lr=0.05, decay=1e-6, momentum=0.9, nesterov=True)

model.compile(loss='categorical_crossentropy', optimizer=sgd,class_mode="categorical")

model.fit(data, label, batch_size=100,nb_epoch=10,shuffle=True,verbose=1,show_accuracy=True,validation_split=0.2)

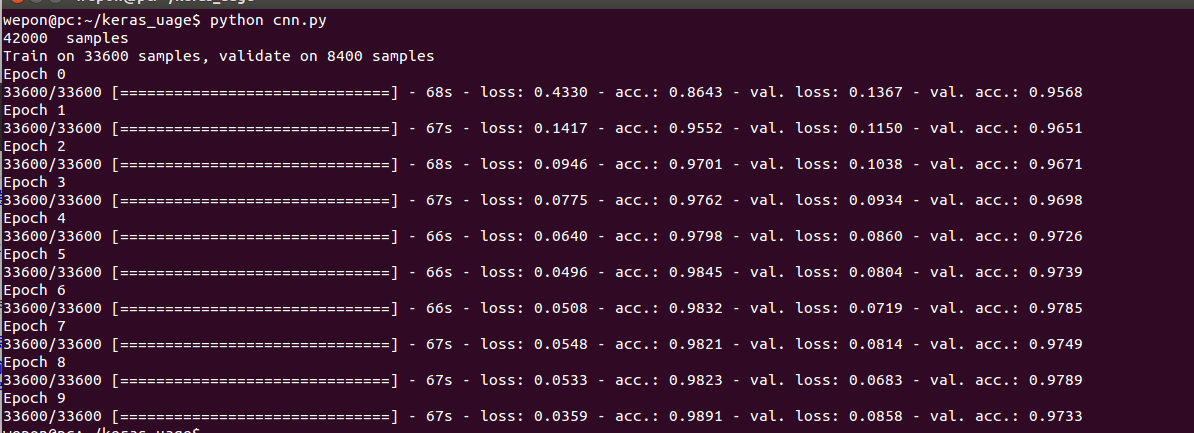

代码使用与结果

结果如下所示,在Epoch 9达到了0.98的训练集识别率和0.97的验证集识别率:

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)