Paper name

Monocular Fisheye Camera Depth Estimation Using Sparse LiDAR Supervision

Paper Reading Note

URL: https://arxiv.org/pdf/1803.06192.pdf

TL;DR

2018 年 ITSC 文章,出自于德国 Valeo 自动驾驶公司,提出了单目鱼眼深度估计的有监督训练方案,并针对雷达与鱼眼相机安装位置不一样造成的遮挡问题提出了一种基于形态学滤波的过滤方法

Introduction

- 自动驾驶汽车周围的近景深度估计是十分重要的功能,一般是通过四个鱼眼相机(FOV>=180°)来做汽车周围的图片采集

- 有监督训练的难度:

- 基于雷达获取稠密深度数据较为困难

- 合成场景的深度数据被广泛应用, 但是存在着在真实场景中遇到泛化性较差的问题,需要处理 domain shift

- 本文提出一种基于稀疏雷达数据(64线)训练单目鱼眼深度估计模型的方法,主要贡献有:

- 展示了基于稀疏雷达的训练犯法

- 展示了在鱼眼相机使用 CNN 做深度估计

- 根据摄像机和V激光雷达视点的差异调整训练数据以处理遮挡

- 修改损失函数和训练算法以处理稀疏深度数据

Dataset/Algorithm/Model/Experiment Detail

实现方式

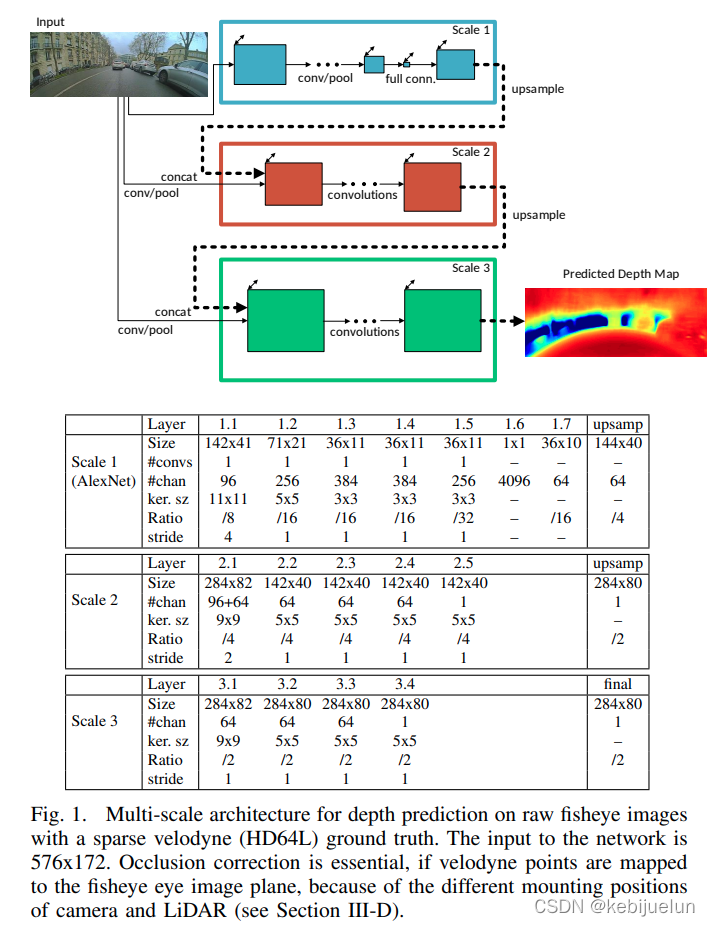

网络结构

- 使用 AlexNet 作为以下网络结构的 Scale1,参考 2014Nips(Eigen) 文章的网络结构设计,能够在 Nvidia TX2 上实时运行

稀疏雷达深度图

- 使用 HDL-64ES2 雷达,64线,垂直可见的视场角为 26.8°;另外因为雷达的传感器旋转和汽车的运动,较远的点的反射率较差,所以雷达采集的图相对来说比较稀疏

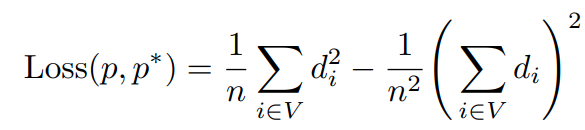

训练损失(Scale-Invariant Error)

- l2 的 scale-invarian 损失,与 2014Nips(Eigen) 一样,这里网络直出的是深度,与 gt 深度计算损失

- 对于没有深度的区域就是简单的不计算损失而已

模型训练

- AlexNet 的模型 load pretrain 参数;使用 Adam 优化器,Relu 替换为 Swish(原因是替换了 SELU、ELU、leaky ReLU 的效果都没有 Swish 好)

- 数据集

- 作者公司的内部数据集(类似于后来开源的 woodscape),60000 图片的数据集,其中 5000 图片作为测试集

- 主要在法国巴黎和德国巴伐利亚,场景主要是城市、住宅和郊区

- 基于 tstamp 将 10Hz 的激光雷达数据和 30 Hz 的鱼眼图像数据进行对齐,对于每个 RGB 采集图像选取最近的 depth 采集图

- 输入尺寸: w:576 px,h:172 px

遮挡校正

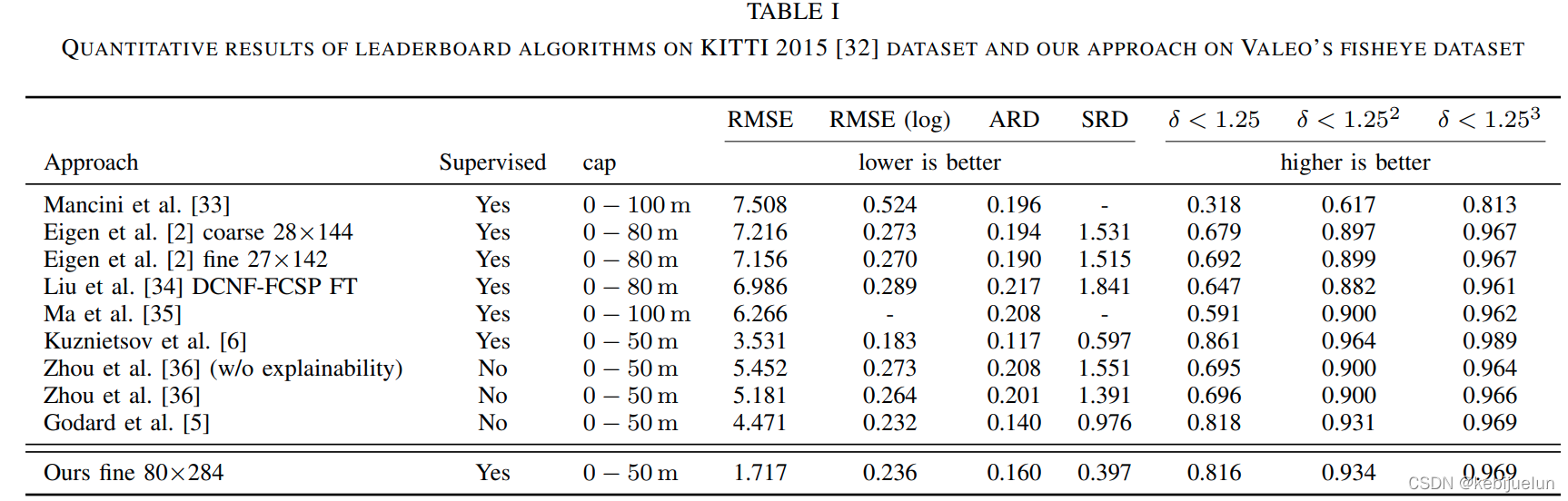

实验结果

- KITTI 和 Valeo 鱼眼数据集上的定量对比实验结果

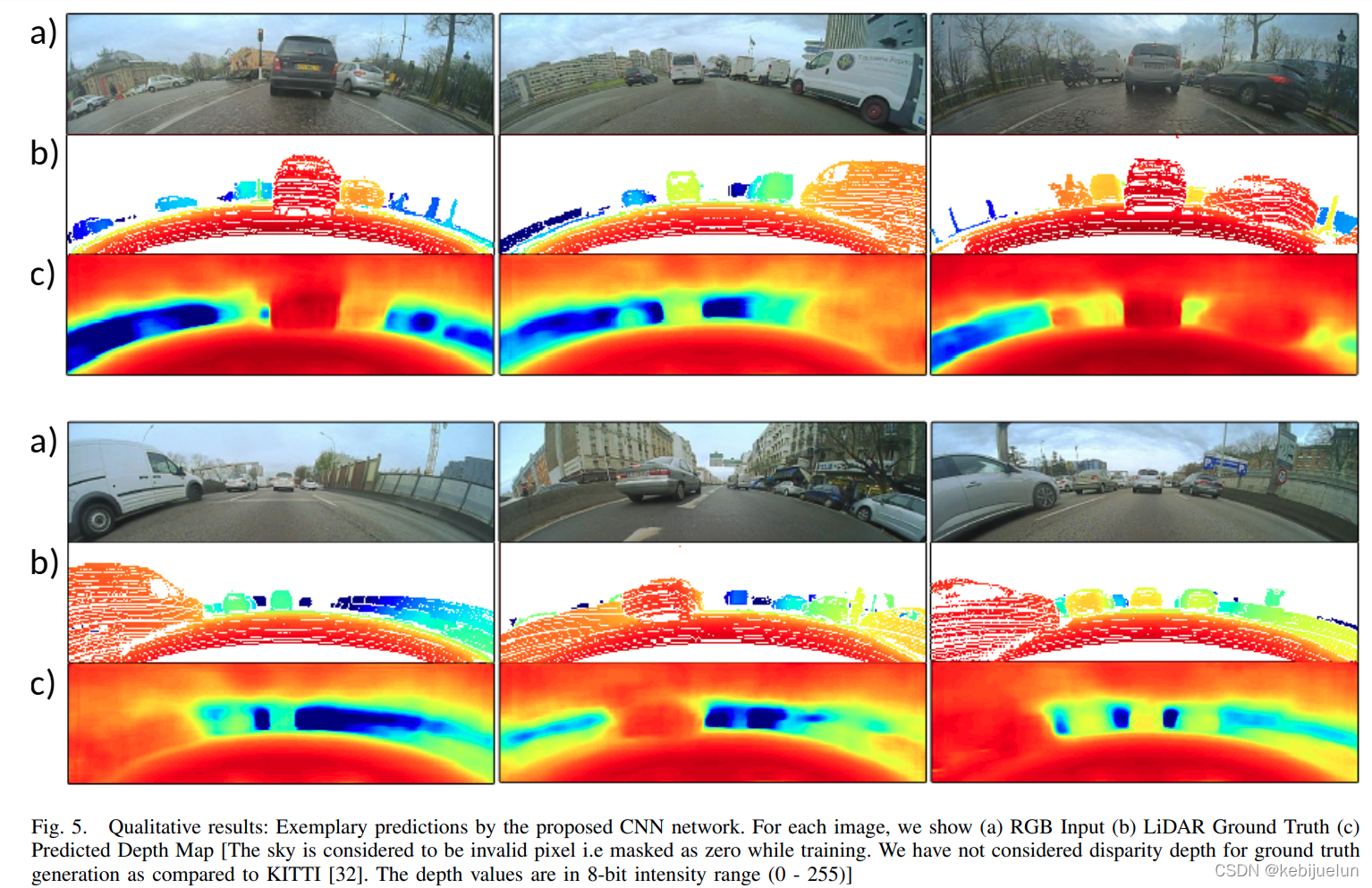

- 定性分析,gt 深度及预测深度可视化,天空区域因为没有足够的雷达监督信息基本都挂了

Thoughts

- 这篇工作创新性和参考性一般,主要是参考了 2014Nips(Eigen) 的网络设计和训练 loss,对比实验也不是很充分(对比不同方法在不同数据集上的精度)

- 由于雷达和鱼眼相机安装高度和位置不同产生的遮挡导致雷达采集的 gt 深度部分无法映射到鱼眼图像平面上的情况,提出了一种基于深度分层过滤的方案,值得参考,但文章中对于这部分工作连消融实验都没有

- 数据集和代码均没有开源,无法复现

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)