文章目录

- 前言

- linux socket api介绍

- 简单客户端例子

- 简单的服务端

- 上述程序的问题

- epoll

前言

我们都知道socket编程实际上是使用tcp或者udp协议进行消息传输,所以我们要更为的了解tcp/udp协议

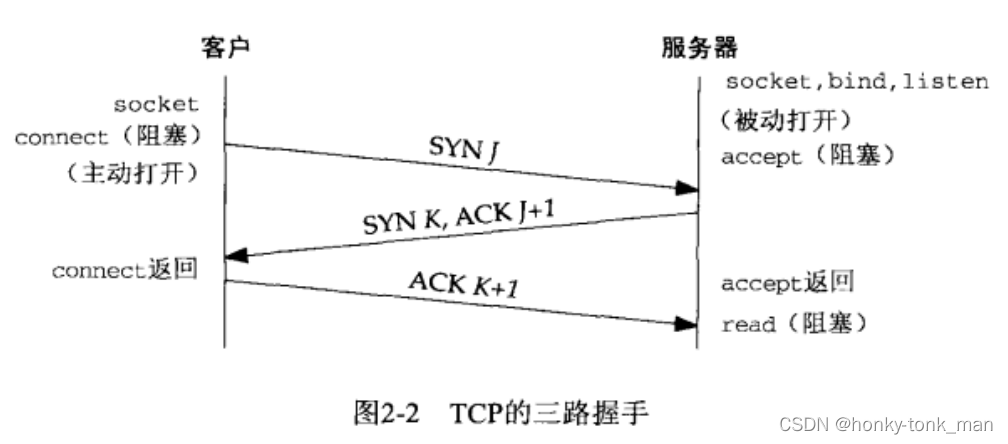

tcp三次握手

先看tcp的三次握手示意图

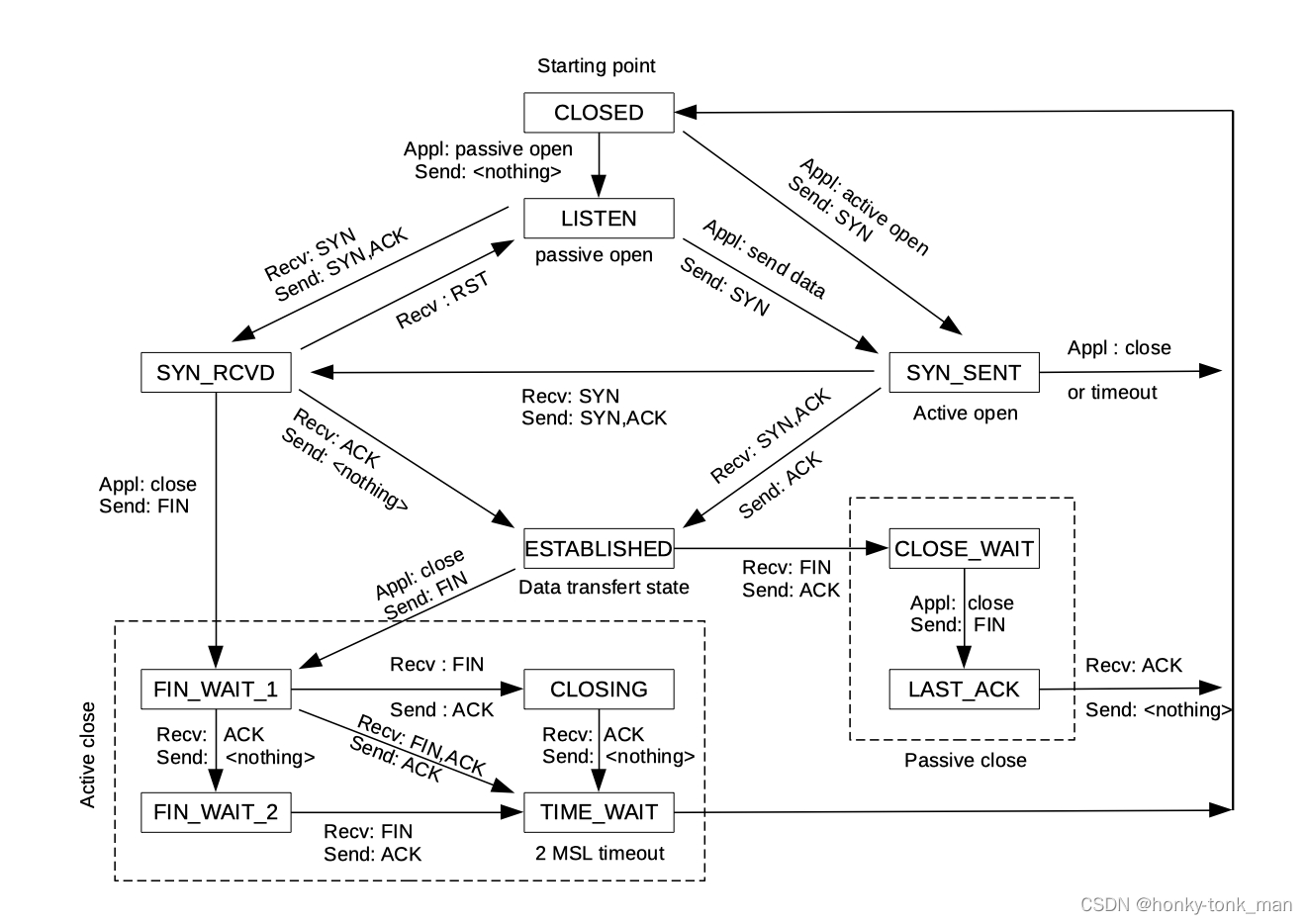

TCP 状态转换图

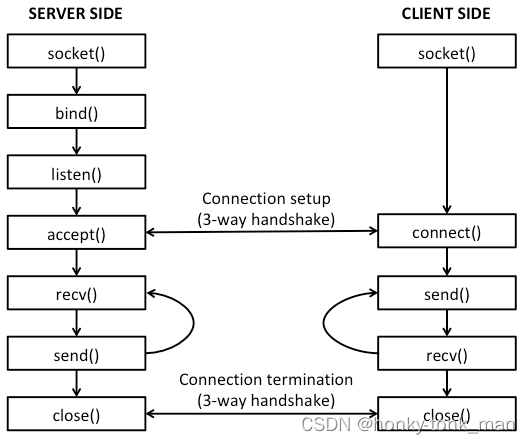

linux socket和tcp的关系

linux socket api介绍

首先我们要先#include头文件,我们进行socket编程先#include <sys/types.h>和#include <sys/socket.h>他们作为socket函数等必要使用的头文件,我们还要一些结构体存储ip地址等等信息,所以我们还要#include <netinet/in.h>

我们编写socket程序要先创建一个socket,socket其实就是一个int

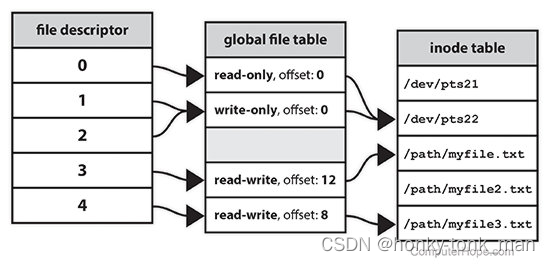

什么是socket?其实socket是一个fd,fd可以说是linux一切皆文件的精髓,linux外部设备可以抽象成fd,比如socket,其本质是网络fd,fd是用户空间和网络空间的一个接口,用户每打开一个文件(unix一切皆文件就会返回一个独一无二的fd),用户看fd就是一个int类型的数字,从内核空间看,我们打开一个文件,回返回一个fd,并且会在global file table中创建一个表项,其每个表项包含此fd的读取限制,偏移量,指向的inode

关于inode可以看这里

创建socket

我们一般用socket()函数创建socket,使用示例如下

socket(DOMAIN, SOCKET_TYPE, PROTOCOL);

DOMAIN:指的是我们使用什么协议族,比如UNIX本地传输(AF_UNIX),比如隧道(AF_PPPOX),比如Infiniband(AF_IB),蓝牙(AF_BLUETOOTH),比如IPV4(AF_INET),比如IPV6(AF_INET6),IPV4,IPV6一般限定在传输层,如果向处理二层等低层次报文我们可以用(AF_PACKET)

SOCKET_TYPE:指的是我们socket类型(相较于DOMAIN更具体),我们可以使用tcp/ip类型的socket(SOCK_STREAM),也可以使用UDP(SOCK_DGRAM),也可以使用raw socket,一旦使用raw socket我们就把数据链路层的包头移除自己写(rawsocket一般用于二层网路编程)(SOCK_RAW)

protocol:protocal一般是指一些socket可以进行特殊的socket配置,如果不进行特殊配置我们就置为0,

我们创建一个简单的tcp socket(四层,ip是三层),然后如下

int sock = socket(AF_INET, SOCK_STREAM, 0);

因为我们上面创建的tcp socket传输到4层已经没有前面的二层帧头,所以我们为了让我们的socket能处理二层也就是数据链路层的报文,就创建raw socket,如下

int sock = socket(AF_PACKET, SOCK_RAW, htons(ETH_P_ALL));

ETH_P_ALL是一个宏,代表接收所有二层以太网包

创建ip/port结构

我们要访问对方,要有对方的ip和端口,所以我们要创建地址相关的结构,这个结构就是sockaddr_in

struct sockaddr_in server_address;

我们设置这个地址的地址组(ipv4)

server_address.sin_family = AF_INET;

我们设置这个地址的端口

server_address.sin_port = htons(9002);

设置对端的地址的ip

server_address.sin_addr.s_addr = INADDR_ANY;

INADDR_ANY是一个宏代表ip是任意ip,一般指的是本机的任意ip

还有一种表示ip的方法是用inet_addr()函数,这个函数输入一个ip地址的字符串(xxx.xxx.xxx.xxx),然后inet_addr()将这个ip地址的字符串其转换成int类型输出,怎么转换,主要是讲ip地址转换成二进制合并在一起(小端法),怎么使用这个int类型的ip地址呢?将其转换成16进制,然后每2个16进制位代表一个xxx(因为2个16进制最大ff转换成二进制是255)

connect服务端

我们知道我们有了socket,有了服务端的地址,我们可以使用connect连接服务端了

connect函数如下

connect(SOCKET, ADDR, ADDR_LEN);

上述三个参数都好理解,注意的是我们上面第二个参数指的是sockkaddr,我们要将我们的sockaddr_in转换成sockaddr,我们直接根据上述的例子接着写

int conn_status = connect(sock, (struct sockaddr* )&server_address, sizeof(server_address));

连接可能出错,假如connect返回-1说明连接出错,我们要侦测这个错误,用perror侦测错误码

if(conn_status == -1){

perror("connect error because: ");

close(sock);

exit(EXIT_FAILURE);

}

传输数据

connect成功后我们就已经完成了三次握手,所以此时我们需要的是和服务端传输数据,比如向服务端发送数据,或者从服务端接收数据,我们就假定从服务端接收数据,用recv,接收数据的时候我们要设定接收数据的缓冲区

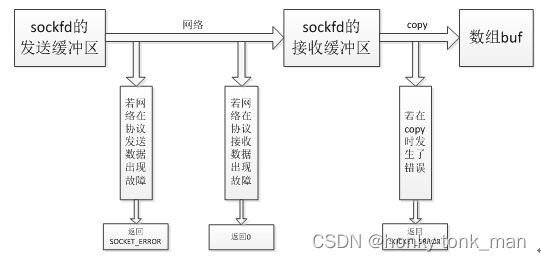

因为传输中容易出错,而出错后会写入errno中,recv常见的错误如下

发送缓冲区故障和copy的时候出现故障都会返回SOCKET_ERROR,且设置errno

我们先看recv函数,recv是block的

recv(SOCKET, &BUFFER, BUFFER_LEN, flag);

前三个参数都好理解,最后一个flag有啥呢?太多了直接man recv看吧,里面有设置成non-block等等

代码示例如下

char recv_buffer[255];

recv(sock, &recv_buffer, stizeof(recv_buffer), 0);

printf("the server sent the data is: %s\", recv_buffer);

发送数据我们用send

send(sockfd, &sendbuf, sendbuflen, flag);

bind

这个用于服务端,将socket和本地地址端口进行bind,以方便后面监听

bind(SOCKET, struct sockaddr* ADDR, ADDR_LEN);

上面三个参数就不用介绍了吧

listen

listen后server就监听在这个端口上,这里主要是配置半连接(backlog)等东西

我们的tcp三次握手是由客户端发起的,客户端最开始是CLOSE状态,发送完syn给服务端后,客户端的状态变成SYN_SEND,服务端一开始也是CLOSE状态,收到客户端发送的syn后变成SYN_RECV,服务端在此时会将这个连接放入半连接队列中(syn queue),我们可以通过ss -i查看半连接队列大小, 在服务端将ACK(客户端SYN+1)和服务端的SYN发送给客户端后,客户端接收服务端的ACK(客户端SYN+1)和服务端的SYN发送给客户端后客户端变成ESTABLISH,然后客户端发送ACK(服务端SYN+1)给服务端,服务端收到客户端的ACK后也变成ESTABLISH,并且将这个连接从半连接队列中拿出到全连接队列中

listen的函数如下

listen(socket, backlog);

backlog是个啥?如下

backlog is the number of connections allowed on the incoming queue. What does that mean? Well, incoming connections are going to wait in this queue until you accept() them

换句话说我们listen后,linux的tcp/ip协议栈已经开始开始处理tcp连接,等请求到达,服务端后,服务端先缓存起来(缓存到半连接队列,此时服务端的状态是SYN_REVIC),然后进行正常的三次握手,最后都服务端成为ESTABLISH状态后将半连接队列对应的数据移动到全连接队列,最后accpet函数返回一个新的socket给客户端,也就是说我们accept发生在三次握手之后(服务端和客户端都已经成ESTABLISH的状态),backlog也就是我们的全连接队列大小,我们当然也可以通过设置/proc/sys/net/core/somaxconn,当然这个是设置上限

accept

这个只是将新的socket发送给客户端(连接已经被缓存在全连接队列中),函数如下

accept(sockfd, struct sockaddr*, addrlen)

第二个和第三个参数可以为NULL,因为我们可以不用特别指定对端的客户端ip是多少,accept返回客户端的socket

设置socket block和no block

int fcntl(int fd, int cmd,...);

fcnt是设置fd属性的,我们的socket在linux中是一个fd,这是毋庸置疑的,首先设置flag,在设置flag的参数,比如我们可以设置fd的fd flag(F_SETFD),设置fd的file statue flag(F_SETFL),比如我们设置fd为no_block如下

fcntl(sock, F_SETFL, O_NONBLOCK);

我们也可以先将当前fd的flag先取出来再设置

int flags = fcntl(fd, F_GETFL, 0);

if(flags < 0){

(void)close(fd);

}

flags |= O_NONBLOCK;

如果我们将fd设置为非阻塞后,假设数据还没有经过内核到用户空间,此时我们read或者其他方式操作这个noblock的fd,会发生错误(errno),且errno会设置成EAGAIN,意思是等会再试,所以用noblock的时候一般用轮询(while),但是这样耗费cpu资源

select

select就是选择多个fd进行监听,如果那个fd有情况就返回,select也可以阻塞和非阻塞

int select(int nfds, fd_set *readfds, fd_set *writefds,fd_set *exceptfds, struct timeval *timeout);

nfd代表我们要监听的fd范围[0,nfd),

readfds一旦我们的fd集合中有情况可以读这里都会返回

writefds同上

exceptfds同上不过这里是如果fd有错误

timeout因为select会阻塞,这里设置阻塞时间,如果超过这个时间还没有fd有反应就返回

include <sys/select.h>

#include <stdio.h>

int main(void){

fd_set rd;

struct timeval tv;

FD_ZERO(&rd);

FD_SET(0, &rd);

tv.tv_sec = 5;

tv.tv_usec = 0;

int err = select(1, &rd, NULL, NULL, &tv);

if(err == 0){

printf("select time out!!!\n");

}else if(err == -1){

printf("select error!!!\n");

}else if(err >0){

printf("select success!!!\n");

}

return 0;

}

简单客户端例子

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <unistd.h>

#include <netinet/in.h>

#include <errno.h>

int main(void){

int sock = socket(AF_INET, SOCK_STREAM, 0);

if(sock < 0){

fprintf(stderr, "can't create socket because of %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

struct sockaddr_in server_addr;

server_addr.sin_addr.s_addr = INADDR_ANY;

server_addr.sin_port = htons(9001);

server_addr.sin_family = AF_INET;

if( (connect(sock, (struct sockaddr*)&server_addr, sizeof(server_addr))) == -1 ){

perror("connect error because of: ");

close(sock);

exit(EXIT_FAILURE);

}

char recv_buffer[255];

recv(sock, recv_buffer, sizeof(recv_buffer), 0);

printf("printf recv: %s\n", recv_buffer);

close(sock);

return 0;

}

简单的服务端

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <netinet/in.h>

#include <sys/types.h>

#include <errno.h>

int

main(void){

char send_message[255] = "hello i am server";

int server_sock = socket(AF_INET, SOCK_STREAM, 0);

struct sockaddr_in server_addr;

server_addr.sin_addr.s_addr = INADDR_ANY;

server_addr.sin_port = htons(9001);

server_addr.sin_family = AF_INET;

if ( (bind(server_sock, (struct sockaddr*) &server_addr, sizeof(server_addr))) != 0 ){

fprintf(stderr, "couldn't bind: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

if ((listen(server_sock, 10)) != 0){

fprintf(stderr, "couldn't listen: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

int client_sock;

if( (client_sock = accept(server_sock, NULL, NULL)) == -1 ){

fprintf(stderr, "couldn't accept: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

send(client_sock, send_message, sizeof(send_message), 0);

close(server_sock);

close(client_sock);

}

上述程序的问题

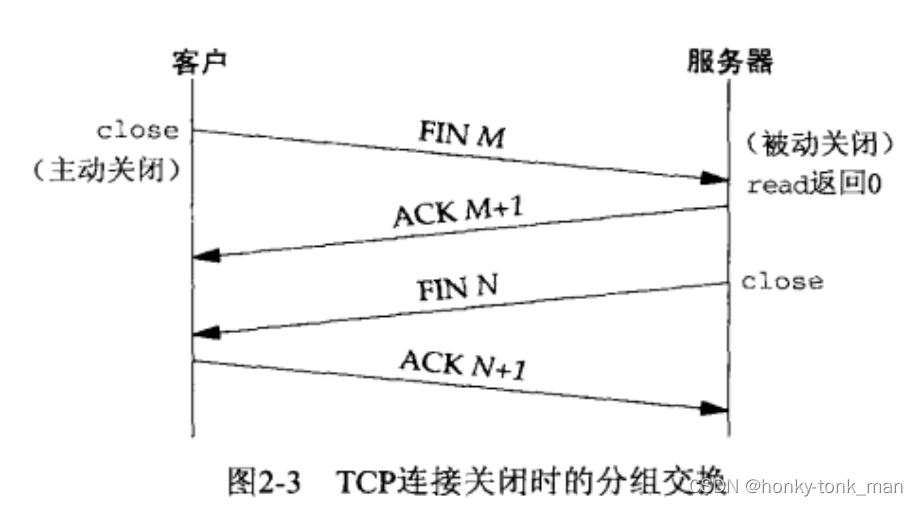

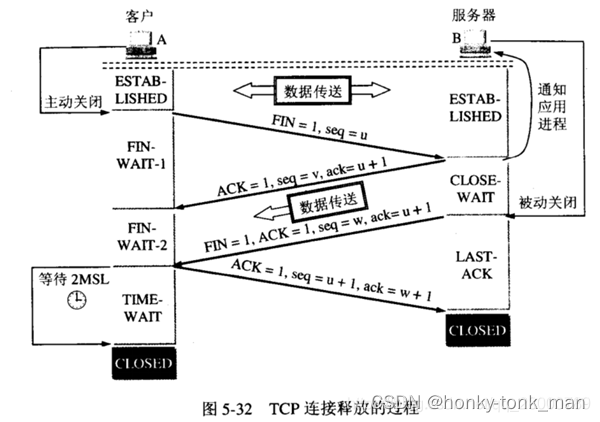

我们的服务端起来后会在accept这里block住,但是当我们crtl + c强制退出的时候,listen的端口还会继续占用

这个可以在我们的状态图中找到答案

首先我们正常的四次挥手是客户端发起的(连接也是客户端发起的),如下

epoll

在中文互联网中关于epoll的介绍太少,要么就是上来直接内核源码分析,要么上来直接放代码,虽然epoll操作就那么几个函数,但是代码中完全不讲怎么设计,为什么这么使用,本篇教程主要从头开始细讲epoll使用

首先epoll这个技术早在2000年前后就提出,他是使用IO复用技术解决高并发问题

正对高并发业务(C!0K)我们首先理想的解决方法是服务段为每一个连接创建一个线程去处理,但是假设在C10K场景下,我们一个进程要创建10000个线程,虽然在OS理论中创建10000个线程是没问题的(linux中可能要设置内核参数),但是想过这个问题没有,我们的线程是不是也要进行上下文切换(CPU Core上的线程就那么多),虽然线程的上下文切换没有进程那么复杂且繁重,但是你也要保存SP,PC,等等寄存器信息,10000个线程(操作系统概念的线程)在CPU Core(硬件线程,就是我们操作系统线程最终正真映射,运行的位置)上仅有的那么几个线程上来回切换,想想效率就不高,并且最重要的我们一个进程有10000个线程意味着我们进程的地址空间的stack区域分成10000份(一个进程中的线程共享进程地址空间的data,heap,code区域),其中某个线程处理数据过大极有可能超出他应该在的stack区域,到其他线程的stack区域中,所以这个方案不是非常好

而epoll就有点像事件驱动io(我不知道他是不是事件驱动io),关于io的5大分类分别是阻塞io,非阻塞io,io复用,事件驱动io,异步io,如果想了解这方面的只是请看这里

epoll到底是怎么做到一个线程监控多个客户端fd呢?首先我们都知道unix一切皆文件这个哲学,unix对网络连接抽象成socket文件(socket fd),那么数以万计的client连接过来在unix中都是client socket fd(本质还是文件),我们在使用epoll之初先创建一个epoll fd(epoll_create())这个epoll fd指向的文件是一个红黑树,当我们想监听某个client socket fd就讲这个client socket fd放入这个红黑树中,这样做到了一个epoll fd监听多个client socket fd

但是我们不可能去每时每刻的轮询红黑树中的所有socket(效率太差),所以我们的解决方法是epoll fd监听的socket中,那个socket触发了预先设置绑定的事件(epoll_ctl()),那么那个socket fd就返回通知epollfd(这里都是内核在通知),假设有太多太多的socket通知epollfd,epollfd不会要一个一个回应把,这里不是的因为我们在epoll_wait()使某个epollfd开始阻塞监听的时候会传入一个epoll_event结构数组,当有一个socket被触发就将这个socket的信息覆写到epoll_event结构数组的某个成员中,所以我们后面确定哪个socket返回了数据就看epoll_event.data.fd

下面的示例代码我们用epoll的edge-trigger来写(level trigger不会),因为edge-trigger代表当被监听的socket因为某个预先注册的事件被触发而notification epollfd(将这个被触发的socket的对应信息写入epoll_event.data.fd中),这个notification在edge-trigger中只有一次,所以我们处理数据的时候要尽量处理完,因为我们设置事件的时候可能触发事件为EPOLLIN代表socket有数据来我们就触发notification,不管数据有没有发送完毕,所以我们处理数据的时候最好把read()放在while中读取

下面是代码

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <unistd.h>

#include <netinet/in.h>

#include <sys/types.h>

#include <sys/epoll.h>

#include <errno.h>

#include <fcntl.h>

#define MAXBUF 1024

#define CLIENT_ADDR_NAME 20

#define MAXEVENT 64

void set_noblocking(int fd){

int flags,s;

flags = fcntl(fd, F_GETFL, 0);

if(flags == -1){

fprintf(stderr, "couldn't fcntl: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

flags |= O_NONBLOCK;

if((s = fcntl(fd, F_SETFL, flags)) == -1){

fprintf(stderr, "couldn't fcntl: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

}

int setup_epoll_et(int epollfd, int serverfd, struct epoll_event * ev){

ev->data.fd = serverfd;

ev->events = EPOLLIN|EPOLLET;

if((epoll_ctl(epollfd, EPOLL_CTL_ADD, serverfd, ev)) == -1){

fprintf(stderr, "couldn't set epoll: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

return epollfd;

}

void http_setup(struct sockaddr_in* server_addr){

int server_sock = socket(AF_INET, SOCK_STREAM, 0);

set_noblocking(server_sock);

int opt = 1;

setsockopt(server_sock, SOL_SOCKET,SO_REUSEADDR|SO_REUSEPORT, &opt, sizeof(opt) );

if ( (bind(server_sock, (struct sockaddr*) server_addr, sizeof(struct sockaddr_in))) != 0 ){

fprintf(stderr, "couldn't bind: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

if ((listen(server_sock, 10)) != 0){

fprintf(stderr, "couldn't listen: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

struct epoll_event ev;

struct epoll_event* events;

int epollfd;

if((epollfd = epoll_create1(0)) == -1){

fprintf(stderr, "couldn't createpoll fd: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

epollfd = setup_epoll_et(epollfd, server_sock, &ev);

events = malloc(sizeof(ev) * MAXEVENT);

while(1){

int client_sock;

int rval;

struct sockaddr_in client_addr;

char client_addr_name[CLIENT_ADDR_NAME];

socklen_t length;

int i,n;

n = epoll_wait(epollfd, events, MAXEVENT, -1);

for(i = 0; i < n; i++){

if((events[i].events & EPOLLERR) || (events[i].events & EPOLLHUP) || (!(events[i].events & EPOLLIN)) ){

printf("fd error,or socket not ready to reading%s\n");

close(events[i].data.fd);

continue;

}else if (events[i].data.fd == server_sock){

if( (client_sock = accept(server_sock, (struct sockaddr *)&client_addr, &length)) == -1 ){

fprintf(stderr, "couldn't accept: %s\n", strerror(errno));

exit(EXIT_FAILURE);

}

set_noblocking(client_sock);

ev.data.fd = client_sock;

ev.events = EPOLLIN|EPOLLET;

setup_epoll_et(epollfd, client_sock, &ev);

}else{

int done = 0;

char buf[MAXBUF] = {0};

while(1){

int n = read(events[i].data.fd, buf, MAXBUF);

if(n < 0){

if(errno == EAGAIN){

break;

}else{

fprintf(stderr, "read error:%s\n", strerror(errno));

done = 1;

break;

}

}else if(n == 0){

done = 1;

break;

}

}

if(done) {

close(events[i].data.fd);

inet_ntop(AF_INET, &client_addr.sin_addr, client_addr_name, CLIENT_ADDR_NAME);

printf("client: %s connect quit\n", client_addr_name);

continue;

}

inet_ntop(AF_INET, &client_addr.sin_addr, client_addr_name, CLIENT_ADDR_NAME);

printf("client:%s, send:%s\n", client_addr_name, buf);

}

}

}

close(server_sock);

}

int

main(void){

char send_message[255] = "hello i am server";

struct sockaddr_in server_addr1;

server_addr1.sin_addr.s_addr = INADDR_ANY;

inet_pton(AF_INET, "192.168.152.215", &server_addr1.sin_addr);

server_addr1.sin_port = htons(9001);

server_addr1.sin_family = AF_INET;

http_setup(&server_addr1);

return 0;

}

我们实现非常简单,用epoll的方式同时接收多个client 发送过来的内容打印在server的屏幕上

对于epoll部分,我们先用epoll_create1()创建了一个epollfd,用epoll_ctr()要epollfd监听我们需要被监听的fd,并且设置边缘触发和触发事件(设置边缘触发和触发事件需压写入epoll_event然后再当参数传进epoll_ctl()具体看函数setup_epoll_et())

然后我们使用epoll_wait()监听epollfd,第二个参数events上面讲了用于将触发事件的socket信息(fd等)放到预先定义好的epoll_event结构数组中,至于为什么要将epoll_wait()放到一个循环中,因为我要一直监听,epoll_wait()随后的是一个for循环,这里最为重要,上一句讲了epoll_wait()的第二个参数用于接收触发事件的socket信息,那么这里我们遍历这个epoll_event结构数组,看他的fd是否等于我们的server fd,如果等于说明有请求(三次握手)到达我们的服务端,然后accept()并且再将accept()返回的client socket fd注册进epollfd中(epoll_ctr())且设置成边缘触发,最后如果epoll_event结构数组的元素的fd不等于serverfd,且没有出错那么就等于我们刚刚注册的client sock fd,此时我们就开始进行处理来的数据

处理进来的数据的时候还有一些坑,因为我们之前设置client sock fd为非阻塞,如果数据来了之后在read()的时候,kernel会请求阻塞,但是我们设置了非阻塞,那么就会报错报错返回EAGAIN,我们要对他进行特殊处理,因为在我们的这个场景中他不再是报错,而是提醒我们数据来了,我们将数据读出打印

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)