SVM简介

支持向量机(Support Vector Machines)是一种二分类模型,对于多分类通常将其分解为多个二元分类问题,再进行分类。SVM 的基本模型是定义在特征空间上的间隔最大的线性分类器,SVM 还包括核技巧,这使它成为实质上的非线性分类器。SVM 的学习策略就是间隔最大化,最终可转化为一个凸二次规划问题的求解。

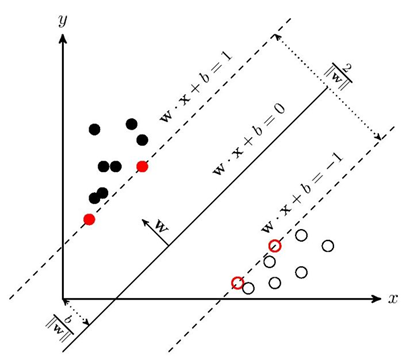

SVM学习的基本想法是求解能够正确划分训练数据集并且几何间隔最大的分隔超平面。如下图所示, 即为分隔超平面。

距离分隔超平面最近的点,即空心和实心的红色圆圈即为支持向量(Support Vector)。SVM的目标就是最大化支持向量所在的超平面之间的几何距离,两条平行直线的距离公式推广到高维可求得图中几何间隔距离:

m

a

r

g

i

n

=

2

∣

∣

ω

∣

∣

margin = \frac{2}{||\omega||}

margin=∣∣ω∣∣2

使得 margin 最大,也就等价于使得

∣

∣

ω

∣

∣

2

2

\frac{||\omega||^2}{2}

2∣∣ω∣∣2 最小,这里的

1

2

\frac{1}{2}

21 只是为了后续求导后刚好能消去,没有其他特殊意义。再加上使得所有数据能被分开的条件,转换成数学表达即是:

{

m

i

n

∣

∣

ω

∣

∣

2

2

s

.

t

.

y

i

(

ω

x

i

+

b

)

≥

1

i

=

1

,

.

.

.

,

m

\begin{cases} min\frac{||\omega||^2}{2} \\ s.t. \ y_i (\omega x_i+b) \geq 1 \ \ \ \ \ \ i = 1,...,m \end{cases}

{min2∣∣ω∣∣2s.t. yi(ωxi+b)≥1 i=1,...,m

这是一个凸二次规划问题,一般的优化方法求解不够高效,可以使用拉格朗日乘子法,转换成它的对偶问题求解。其对偶形式如下:

{

m

a

x

∑

i

=

1

m

α

i

−

1

2

∑

i

=

1

m

∑

j

=

1

m

α

i

α

j

y

(

i

)

y

(

j

)

(

x

(

i

)

)

T

x

(

j

)

s

.

t

.

∑

i

=

1

m

α

i

y

(

i

)

=

0

α

i

≥

0

i

=

1

,

.

.

.

,

m

\begin{cases} max\sum^m_{i=1}\alpha_i-\frac{1}{2}\sum^m_{i=1}\sum^m_{j=1}\alpha_i\alpha_jy^{(i)}y^{(j)}(x^{(i)})^Tx^{(j)}\\ s.t. \ \sum^m_{i=1}\alpha_iy^{(i)} = 0 \ \ \ \ \ \ \ \ \ \alpha_i \geq 0 \ \ \ \ \ i = 1,...,m \end{cases}

{max∑i=1mαi−21∑i=1m∑j=1mαiαjy(i)y(j)(x(i))Tx(j)s.t. ∑i=1mαiy(i)=0 αi≥0 i=1,...,m

在原始问题下,求解的复杂度与样本的维度有关,即

ω

\omega

ω 的维度。在对偶问题下,只与样本数量有关,即改变了问题的复杂度。因为只用求解

α

\alpha

α 系数,而

α

\alpha

α 系数只有支持向量才非

0

0

0,其它全部为

0

0

0,使得求解更高效。

对于得到的最优解

α

∗

\alpha^*

α∗ 可以求得:

ω

∗

=

∑

i

=

1

m

α

i

∗

y

(

i

)

x

(

i

)

b

∗

=

y

j

−

∑

i

=

1

m

α

i

∗

y

(

i

)

(

x

(

i

)

)

T

x

j

\omega^* = \sum^m_{i=1}\alpha_i^*y^{(i)}x^{(i)}\\ b^* = y_j - \sum^m_{i=1}\alpha_i^*y^{(i)}(x^{(i)})^Tx_j

ω∗=i=1∑mαi∗y(i)x(i)b∗=yj−i=1∑mαi∗y(i)(x(i))Txj

其中式中的

j

j

j 是任意一个

α

j

∗

>

0

α_j^* > 0

αj∗>0 时的

j

j

j。此外,当样本点是非支持向量时,因为

a

i

∗

=

0

a_i^*=0

ai∗=0,所以,SVM 的解只与支持向量有关,与非支持向量无关,即在决定最佳超平面时只有支持向量起作用,而其他数据点并不起作用。

对于线性不可分的情况,引入“软间隔(soft margin)”允许少量样本不满足约束,将目标函数改为:

m

i

n

ω

,

b

∣

∣

ω

∣

∣

2

2

+

C

∑

i

=

1

m

m

a

x

(

0

,

1

−

y

(

i

)

(

ω

T

x

(

i

)

+

b

)

)

min_{\omega,b}\frac{||\omega||^2}{2} + C\sum^m_{i=1}max(0, 1-y^{(i)}(\omega^Tx^{(i)}+b))

minω,b2∣∣ω∣∣2+Ci=1∑mmax(0,1−y(i)(ωTx(i)+b))

其中 C>0 称为惩罚参数,C 越小时对误分类惩罚越小,越大时对误分类惩罚越大,当 C 取正无穷时就变成了硬间隔。实际上应用时需要合理选取 C,C 越小越容易欠拟合,C 越大越容易过拟合。

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)