从今天开始就要出品自己的Tensorflow系列啦!由于是第一篇关于Python的博文,所以先把接触Python以来的感想和心得都放了进来,想看Tensorflow的博友请直接跳到标题三。

一、Python,Anaconda,Pycharm到底是什么?

这个看似很Low的问题在刚刚学Python的时候困扰了我很久。我们要学的是Python,直接去Python官网安装一个Python编译器不就可以了吗?为什么还要大费周折安装Anaconda和Pycharm?

经过入门的折腾,自己总算有了一个初步的答案:(个人观点,若有错误欢迎大家批评指正!)

1. Python+各种包=Anaconda:若只安装官网的Python,的确可以完成.py文件的编译。但是在开发中我们会用到各种各样的包。一方面,Anaconda自带了很多经常用到的包,这就为我们后期的直接使用提供了很大的方便;另一方面,我们额外pip的包也将会安装在Anaconda目录下面,例如下图,我们import tensorflow模块,会自动显示这个包的路径,的确是在Anaconda目录下的:

同时,我们打开Anaconda的安装目录,会发现:目录下有python.exe,这就是编译器

所以:Anaconda的核心依旧是Python.exe编译器,它的存在会使得Python的包更容易管理。

2.Pycharm:我们写好了一个Python程序,只要有Python.exe和必需的包,就可以运行了。但是程序的编写最好要有一个环境,就像VC++ 6.0这样的界面。如果没有界面,仅仅在txt中编辑,那我们的界面会像左图这样,有了界面就像右图一样了。没错,一个IDE环境可以为编程者提供高亮提醒、关键词提示、Debug等功能。Pycharm就是这样一个环境,本身不可以编译py文件,但是可以调用Anaconda的exe完成编译。

二、为什么下载Python相关软件时总会有Linux版本的?很多DL、ML的教程也是在Linux环境下进行教学的?Windows用户才是最普遍的,为什么依然有很多人放弃自己熟悉的Windows而转战Linux环境呢?

我之前也很迷惑这个问题,直到看了B站的一个教学视频才明白(视频地址文末放送)

核心原因:

1.Windows风靡是因为具有友好的操作界面,我们点点鼠标就可以对手边的电脑进行一系列的操作。但是在真正的服务器维护中(大到谷歌、百度、QQ这种大公司,小到学校机房),99%遇到的情况是在一个地方登陆远在千里之外的服务器进行维护。这些维护是没有界面操作的,只能通过终端命令来完成。

2.Linux的稳定性、实时性比Windows好的多。你的Windows肯定会随着文件的增多而变得卡顿,但是Linux却可以稳定运行

3.Linux全开源,商家几乎全部选用Linux来完成服务器维护。

个人建议:先在自己熟悉的Windows环境中学会环境搭建与程序编写。当完成基础学习之后,再进军Linux系统,更接近专业的开发。

三、正文:Tensorflow安装躺坑实录

这个破东西我整整搞了两天......

要明确的是,Tensorflow一共有两个版本,一个是CPU版本,一个是GPU版本,那么装哪个版本的呢?

一定先要搞懂自己电脑的显卡是什么版本的,一般来说,电脑的显卡基本都是由两大厂商所承包的:NVIDIA(绿色Logo)和AMD(红色Logo),如果你是NVIDIA的,那么恭喜你,你的电脑是可以进行深度学习GPU加速的。如果你是AMD的,很遗憾告诉你,你的电脑只能用CPU进行运算。一般来说,GPU加速后的神经网络训练速度要比CPU的快十几倍。但是AMD的也不用担心,因为入门时跑的神经网络都是轻量级的,时间差异不会显现出来的。由于我的电脑是AMD显卡,所以只能安装CPU版本的了。

GPU版本的安装过程详见此博客:http://www.mclover.cn/blog/index.php/archives/179.html

好,接下来是CPU版本的安装过程:

1.安装Visual Studio 2015:如果不安装,IDE将会无法import tensorflow

2.Win+R打开运行,输入cmd进入终端,输入:

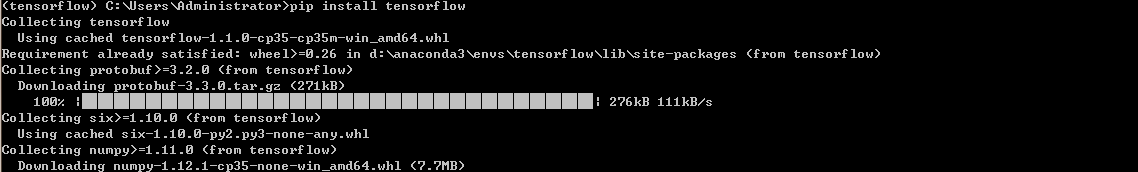

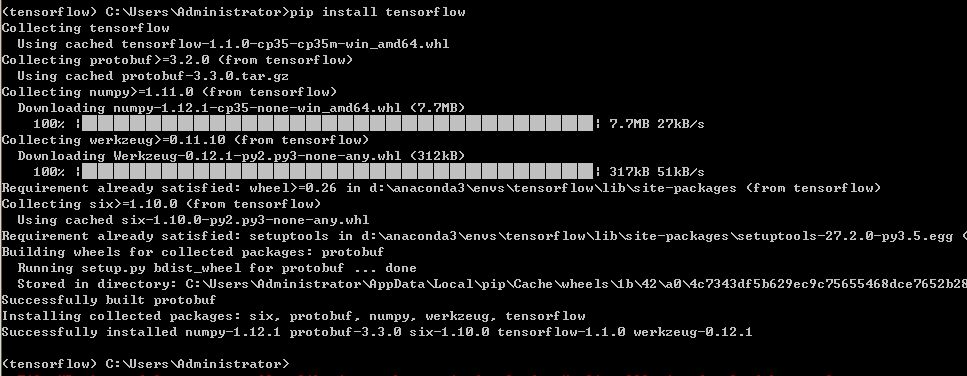

pip install tensorflow

然后就是漫长的等待,如果命令窗口重新显示了C:User:>>的话,就表示pip完毕,成功界面如下:

3.打开Pycharm,输入:

import tensorflow as tf

print("123")

首次导入tf包可能需要较长时间,编译结束后如果没有报错,则安装完毕。

接下来是我的躺坑过程,都是用时间换来的教训啊.......

坑1:一定要先确定好自己的电脑显卡是NIVIDA还是AMD的,AMD的不能够安装GPU版本的Tensorflow(我就是先安装了CUDA、CUDNN、Tensorflow-gpu)之后发现自己显卡居然TDM是AMD的,

坑2:一定要先给电脑安装好VS2015,这个软件安装的时候非常缓慢(我装了将近2个小时),建议在睡觉之前进行安装。如果不安装VS2015,import 时会出现一大堆报错,类似于:

总结:每次接触一门新的语言或芯片,都要首先花很长的时间在环境的搭建上面,比如51、ARM的Keil,DSP的CCS。安装的过程中也是躺了很多很多的坑。当遇到问题时,一定要多去搜索,积极寻找解决途径。好的开始是成功的一半!

文末彩蛋:

1.Python入门教程:https://www.bilibili.com/video/av14184325

2.Tensorflow笔记(北京大学):https://www.bilibili.com/video/av22530538

3.英文原版《Pattern Recognition and Machine Learning》:

(上册):https://download.csdn.net/download/qq_36342854/10594775

(下册):https://download.csdn.net/download/qq_36342854/10596375

这是系列博文的第一篇,写的比较啰嗦,不对的地方还请大家批评指正!后面会继续更新Tf的基础知识和实际应用,希望大家持续关注,感谢阅读!

(完)

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)