csdn的排版真的太垃圾了,想看的移步知乎

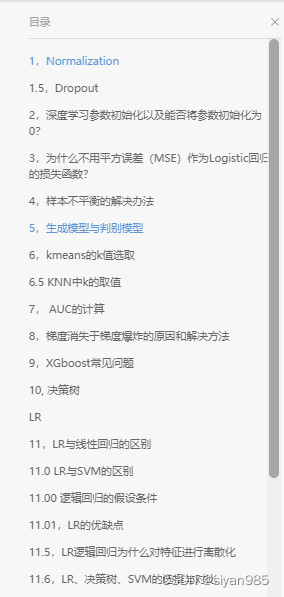

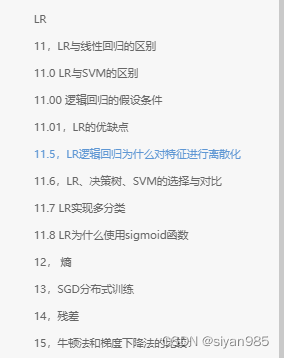

1,Normalization

数据标准化处理主要包括数据同趋化处理和无量纲化处理两个方面。数据同趋化处理主要解决不同性质数据问题,对不同性质指标直接加总不能正确反映不同作用力的综合结果,须使所有指标对测评方案的作用力同趋化,之后再加总才能得出正确结果。数据无量纲化处理主要解决数据的可比性。经过标准化处理,原始数据均转换为无量纲化指标测评值,即各指标值都处于同一个数量级别上,可以进行综合测评分析。

机器学习中常见的Normalization方法分为两种类型,一种是特征标准化,是对输入的数据进行预处理,是对数据的不同特征分别进行处理,常见有max-min normalizaiton,z-score normalization等;第二种是参数归一化,比如L1范数,L2范数等。

深度学习中的normalization主要是为了减少Internal Covariate Shift,对某层每个神经元的激活值进行normalization。不论哪种标准化方法,其规范化目标都是一样的,就是将其激活值调整为均值为0,方差为1的正态分布。规范化统一形式为

γ和β是两个可学习的参数,用于减弱标准化的影响(比如,激活函数的输出分布并不需要归一化)。

为了能够将网络中某个神经元的激活值规范到均值为0方差为1的范围,必须求出均值和方差。要计算这两个指标需在一个集合范围内才可行,所以这就要求必须指定一个神经元组成的集合,利用这个集合里每个神经元的激活值来统计出所需的均值和方差,这样才能达到预定的规范化目标。所以,不同标准化方法最主要的区别在于神经元集合S的范围怎么定。

Batch Normalization中的集合S是由batch中n个样本在神经元k上的激活值组成的。n个样本,n个激活值。

Layer Normalization中集合S是由同一层神经元的激活值组成的。

Instacnce Normalization中的集合S是由CNN的同一卷积层内每个卷积核产生的输出通道单独构成。一个通道包含多个激活值。

Group Normalization中的集合是对CNN中某一层卷积层的输出或者输入通道进行分组,在分组范围内进行统计。

归一化可以加快基于梯度下降法的收敛速度;使各个特征对结果做出的贡献相同,提升模型的精度。BN本身上也是一种正则的方式,可以使用大学习率,但对batchsize 大小敏感,RNN等动态网络使用BN效果不佳且使用起来不方便

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)