2020.09.06

任务:传统OpenCV方法ROS版本改造

选取大神陈光的高级车道线检测方法进行改造,总体逻辑是:

第一、创建订阅者,接收摄像头发布的数据,用cv_bridge将opencv格式的数据转换为ROS的消息格式数据。

第二、创建发布者,将检测到的数据以特定的消息类型发布出去

传统方法的难点:

(1)对光照、明暗、车道线磨损、非常敏感

(2)在十字路口转弯时,摄像头检测不到前方车道线,会造成绿色区域“变幻莫测”地跳动

(3)总会出现x expect non zero vector错误,导致程序退出

计划对程序的改进

(1)在十字路口等工况下检测不到车道线时,直接return回spin()函数,等待下一帧数据

(2)在进入np.polyfit()函数进行二次曲线拟合时,先判断参数是否为空

(3)在画面上打印FPS和 本车距离坐车道线的距离

问题记录

import os

import cv2

import matplotlib.pyplot as plt

import numpy as np

from moviepy.editor import VideoFileClip

import glob

import time

import math

import os

os.environ["CUDA_VISIBLE_DEVICES"] = "0"

import rospy

from sensor_msgs.msg import Image

from cv_bridge import CvBridge, CvBridgeError

def warpImage(image, src_points, dst_points):

image_size = (image.shape[1], image.shape[0])

M = cv2.getPerspectiveTransform(src_points, dst_points)

Minv = cv2.getPerspectiveTransform(dst_points, src_points)

warped_image = cv2.warpPerspective(image, M,image_size, flags=cv2.INTER_LINEAR)

return warped_image, M, Minv

def hlsLSelect(img, thresh=(220, 255)):

hls = cv2.cvtColor(img, cv2.COLOR_BGR2HLS)

l_channel = hls[:,:,1]

l_channel = 255*(l_channel/np.max(l_channel))

binary_output = np.zeros_like(l_channel)

binary_output[(l_channel > thresh[0]) & (l_channel <= thresh[1])] = 1

return binary_output

def labBSelect(img, thresh=(195, 255)):

lab = cv2.cvtColor(img, cv2.COLOR_BGR2Lab)

lab_b = lab[:,:,2]

if np.max(lab_b) > 100:

lab_b = 255*(lab_b/np.max(lab_b))

binary_output = np.zeros_like(lab_b)

binary_output[((lab_b > thresh[0]) & (lab_b <= thresh[1]))] = 1

return binary_output

def find_lane_pixels(binary_warped, nwindows, margin, minpix):

out_img = np.dstack((binary_warped, binary_warped, binary_warped))

histogram = np.sum(binary_warped[binary_warped.shape[0]//2:,:], axis=0)

midpoint = np.int(histogram.shape[0]//2)

leftx_base = np.argmax(histogram[:midpoint])

rightx_base = np.argmax(histogram[midpoint:]) + midpoint

window_height = np.int(binary_warped.shape[0]//nwindows)

nonzero = binary_warped.nonzero()

nonzeroy = np.array(nonzero[0])

nonzerox = np.array(nonzero[1])

leftx_current = leftx_base

rightx_current = rightx_base

left_lane_inds = []

right_lane_inds = []

for window in range(nwindows):

win_y_low = binary_warped.shape[0] - (window+1)*window_height

win_y_high = binary_warped.shape[0] - window*window_height

win_xleft_low = leftx_current - margin

win_xleft_high = leftx_current + margin

win_xright_low = rightx_current - margin

win_xright_high = rightx_current + margin

cv2.rectangle(out_img,(win_xleft_low,win_y_low),

(win_xleft_high,win_y_high),(0,255,0), 2)

cv2.rectangle(out_img,(win_xright_low,win_y_low),

(win_xright_high,win_y_high),(0,255,0), 2)

good_left_inds = ((nonzeroy >= win_y_low) & (nonzeroy < win_y_high) &

(nonzerox >= win_xleft_low) & (nonzerox < win_xleft_high)).nonzero()[0]

good_right_inds = ((nonzeroy >= win_y_low) & (nonzeroy < win_y_high) &

(nonzerox >= win_xright_low) & (nonzerox < win_xright_high)).nonzero()[0]

left_lane_inds.append(good_left_inds)

right_lane_inds.append(good_right_inds)

if len(good_left_inds) > minpix:

leftx_current = np.int(np.mean(nonzerox[good_left_inds]))

if len(good_right_inds) > minpix:

rightx_current = np.int(np.mean(nonzerox[good_right_inds]))

try:

left_lane_inds = np.concatenate(left_lane_inds)

right_lane_inds = np.concatenate(right_lane_inds)

except ValueError:

pass

leftx = nonzerox[left_lane_inds]

lefty = nonzeroy[left_lane_inds]

rightx = nonzerox[right_lane_inds]

righty = nonzeroy[right_lane_inds]

return leftx, lefty, rightx, righty, out_img

def fit_polynomial(binary_warped, nwindows=9, margin=100, minpix=50):

leftx, lefty, rightx, righty, out_img = find_lane_pixels(

binary_warped, nwindows, margin, minpix)

print('leftx:', leftx)

print('lefty:', lefty)

print('rightx:', rightx)

print('righty:', righty)

if len(leftx) == 0 or len(rightx) == 0:

out_img=0

left_fit=np.array([0, 0, 0])

right_fit=np.array([0, 0, 0])

ploty=0

return out_img, left_fit, right_fit, ploty

left_fit = np.polyfit(lefty, leftx, 2)

right_fit = np.polyfit(righty, rightx, 2)

ploty = np.linspace(0, binary_warped.shape[0]-1, binary_warped.shape[0] )

out_img[lefty, leftx] = [255, 0, 0]

out_img[righty, rightx] = [0, 0, 255]

print('left shape:', left_fit.shape)

print('left type:', type(left_fit))

return out_img, left_fit, right_fit, ploty

def fit_poly(img_shape, leftx, lefty, rightx, righty):

left_fit = np.polyfit(lefty, leftx, 2)

right_fit = np.polyfit(righty, rightx, 2)

ploty = np.linspace(0, img_shape[0]-1, img_shape[0])

left_fitx = left_fit[0]*ploty**2 + left_fit[1]*ploty + left_fit[2]

right_fitx = right_fit[0]*ploty**2 + right_fit[1]*ploty + right_fit[2]

return left_fitx, right_fitx, ploty, left_fit, right_fit

def search_around_poly(binary_warped, left_fit, right_fit):

margin = 60

nonzero = binary_warped.nonzero()

nonzeroy = np.array(nonzero[0])

nonzerox = np.array(nonzero[1])

left_lane_inds = ((nonzerox > (left_fit[0]*(nonzeroy**2) + left_fit[1]*nonzeroy +

left_fit[2] - margin)) & (nonzerox < (left_fit[0]*(nonzeroy**2) +

left_fit[1]*nonzeroy + left_fit[2] + margin)))

right_lane_inds = ((nonzerox > (right_fit[0]*(nonzeroy**2) + right_fit[1]*nonzeroy +

right_fit[2] - margin)) & (nonzerox < (right_fit[0]*(nonzeroy**2) +

right_fit[1]*nonzeroy + right_fit[2] + margin)))

leftx = nonzerox[left_lane_inds]

lefty = nonzeroy[left_lane_inds]

rightx = nonzerox[right_lane_inds]

righty = nonzeroy[right_lane_inds]

left_fitx, right_fitx, ploty, left_fit, right_fit = fit_poly(binary_warped.shape, leftx, lefty, rightx, righty)

out_img = np.dstack((binary_warped, binary_warped, binary_warped))*255

window_img = np.zeros_like(out_img)

out_img[nonzeroy[left_lane_inds], nonzerox[left_lane_inds]] = [255, 0, 0]

out_img[nonzeroy[right_lane_inds], nonzerox[right_lane_inds]] = [0, 0, 255]

left_line_window1 = np.array([np.transpose(np.vstack([left_fitx-margin, ploty]))])

left_line_window2 = np.array([np.flipud(np.transpose(np.vstack([left_fitx+margin,

ploty])))])

left_line_pts = np.hstack((left_line_window1, left_line_window2))

right_line_window1 = np.array([np.transpose(np.vstack([right_fitx-margin, ploty]))])

right_line_window2 = np.array([np.flipud(np.transpose(np.vstack([right_fitx+margin,

ploty])))])

right_line_pts = np.hstack((right_line_window1, right_line_window2))

cv2.fillPoly(window_img, np.int_([left_line_pts]), (0,255, 0))

cv2.fillPoly(window_img, np.int_([right_line_pts]), (0,255, 0))

result = cv2.addWeighted(out_img, 1, window_img, 0.3, 0)

return result, left_fit, right_fit, ploty

def CalculateDistFromCenter(binary_image, left_fit, right_fit):

img_size = (binary_image.shape[1], binary_image.shape[0])

dist_from_center = 0.0

if right_fit is not None:

if left_fit is not None:

camera_pos = img_size[0] / 2

left_lane_pix = np.polyval(left_fit, binary_image.shape[0])

right_lane_pix = np.polyval(right_fit, binary_image.shape[0])

center_of_lane_pix = (left_lane_pix + right_lane_pix) / 2

dist_from_center = (camera_pos - center_of_lane_pix) * 3.7/1280

return dist_from_center

def drawing(undist, bin_warped, color_warp, left_fitx, right_fitx, ploty, Minv):

warp_zero = np.zeros_like(bin_warped).astype(np.uint8)

color_warp = np.dstack((warp_zero, warp_zero, warp_zero))

pts_left = np.array([np.transpose(np.vstack([left_fitx, ploty]))])

pts_right = np.array([np.flipud(np.transpose(np.vstack([right_fitx, ploty])))])

pts = np.hstack((pts_left, pts_right))

cv2.fillPoly(color_warp, np.int_([pts]), (0,255, 0))

newwarp = cv2.warpPerspective(color_warp, Minv, (undist.shape[1], undist.shape[0]))

result = cv2.addWeighted(undist, 1, newwarp, 0.3, 0)

return result

def overlay_text_on_image (image, dist_from_center, fps):

new_img = np.copy(image)

font = cv2.FONT_HERSHEY_SIMPLEX

font_color = (255,255,255)

num_format = '{:04.2f}'

text = 'FPS: ' + str(fps)

cv2.putText(new_img, text, (40,70), font, 1.5, font_color, 2, cv2.LINE_AA)

direction = 'left'

if dist_from_center > 0:

direction = 'right'

abs_dist = abs(dist_from_center)

text = 'Vehicle is ' + num_format.format(abs_dist) + ' m ' + direction + ' of center'

cv2.putText(new_img, text, (40,120), font, 1.5, font_color, 2, cv2.LINE_AA)

return new_img

src = np.float32([[603, 342], [727, 342], [1150, 720], [225, 720]])

wrap_offset = 150

dst = np.float32([[225+wrap_offset, 0], [1150-wrap_offset, 0], [1150-wrap_offset, 720], [225+wrap_offset, 720]])

bridge = CvBridge()

detected = False

def callbackFunc(image):

rospy.loginfo('receive frame success')

global bridge, src, dst, detected

try:

undistort_image = bridge.imgmsg_to_cv2(image, "bgr8")

except CvBridgeError as e:

print(e)

start = time.time()

warp_image, M, Minv = warpImage(undistort_image, src, dst)

hlsL_binary = hlsLSelect(warp_image)

labB_binary = labBSelect(warp_image, (205, 255))

combined_binary = np.zeros_like(hlsL_binary)

combined_binary[(hlsL_binary == 1) | (labB_binary == 1)] = 1

left_fit = []

right_fit = []

ploty = []

if detected == False:

out_img, left_fit, right_fit, ploty = fit_polynomial(combined_binary, nwindows=9, margin=80, minpix=40)

if left_fit[0] == 0 and left_fig[1] == 0:

detected = False

return

else :

detected = True

else:

track_result, left_fit, right_fit, ploty, = search_around_poly(combined_binary, left_fit, right_fit)

if (len(left_fit) > 0 & len(right_fit) > 0) :

detected = True

else :

detected = False

return

end = time.time()

fps = math.floor(1 / (end - start))

dist_from_center = CalculateDistFromCenter(warp_image, left_fit, right_fit)

left_fitx = left_fit[0]*ploty**2 + left_fit[1]*ploty + left_fit[2]

right_fitx = right_fit[0]*ploty**2 + right_fit[1]*ploty + right_fit[2]

result = drawing(undistort_image, combined_binary, warp_image, left_fitx, right_fitx, ploty, Minv)

result = overlay_text_on_image (result, dist_from_center, fps)

cv2.imshow("result",result)

cv2.waitKey(40)

def msg_subscriber():

rospy.init_node('msg_subscriber', anonymous=True)

rospy.Subscriber('/miivii_gmsl_ros/camera3', Image, callbackFunc)

rospy.spin()

if __name__ == '__main__':

msg_subscriber()

(1)追踪车道线的函数中,计算left_lane_inds时出现数组下标溢出错误

(2)提取车道线的颜色空间阈值还没有调整

2020.09.07

任务:深度学习方法检测车道线

1、AdamShan大神将MaybeShewill-CV/lanenet-lane-detection改造成为ROS 版本。

2、权重文件有2版:MaybeShewill作者发的一版,在网上下载的一版,tensorflow模型介绍了怎么加载模型

3、执行程序前要修改launch文件里的权重路径,只包含.index .data .meta等后缀前面的前缀。

问题记录

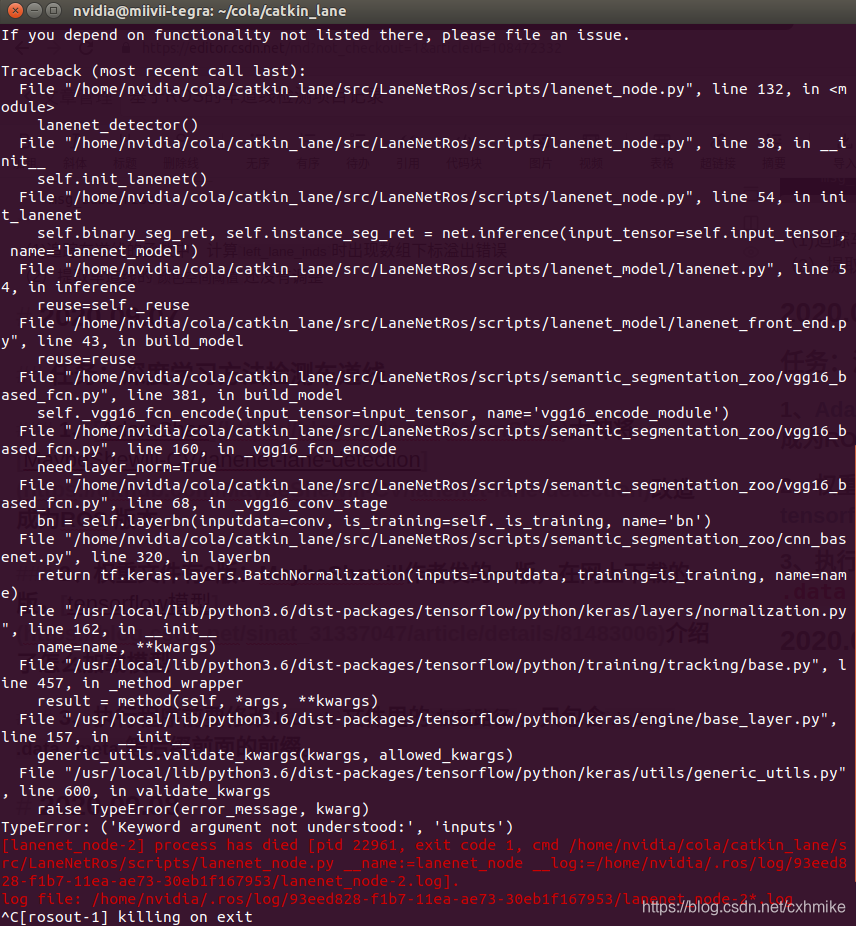

1、执行程序时由于tensorflow等软件的版本不匹配,出现各种warning:...已过期,用...代替,照着一个一个修改,最后也没全部改完,不改了。。。

2、如图,还没解决

2020.09.08

任务:英伟达JetsonPak车道线检测例程,Autoware

1、看了例程视频,是在车道线上画点,有的稀疏有的稠密,也会在路两边栏杆、汽车上画点,效果不好,不用。

2、Autoware还没有安装

2020.09.09

任务:安装Autoware

1、总体安装参考官网教程,其中安装qt5参考教程1和教程2

2、安装配置eigen参考教程,其中下载安装包的步骤参考教程

2020.09.19

问题记录

1、autoware暂时没有安装成功

2、看了autoware的感知和路径规划框架,它用的不是从摄像头读取数据进行车道线检测的,摄像头只用来做物体检测。

成果

1、与论文对应的ultra-fast-lane-detection项目跑通了,在miivii域控制器(基于Xavier)上复现Ultra-Fast-Lane-Detection源论文项目

计划

2020.10.15

痛苦如此持久,像蜗牛充满耐心地移动;快乐如此短暂,像兔子的尾巴掠过秋天的草原。

国庆节前一天刷了JetPack4.4,终于运行通了车道线检测的tensorRT加速项目,惊喜之余心凉凉,发现darknet_ros因为OpenCV版本的问题编译不通,于是对OpenCV千般改造miivii域控制器(Xavier)配置ROS与OpenCV3.x.x,运行成功darknet_ros后,发现域控制器自带的GMSL摄像头驱动又编译不通,昨天休整了半天,对目前的困境进行了小结:

JetPack4.4下有4项任务:(1)启动GMSL摄像头(2)demo检测行人、车辆和自行车(3)检测交通标志(4)检测车道线

(1)和(2)的程序依赖刷机时提供的动态库,因此必须用初始的默认版本OpenCV4.1.1。昨天验证了(4),在OpenCV3.2.0和4.1.1下都能运行。我查了一些资料后,发现(3)darknet_ros只在OpenCV3.x.x下运行正常,4.x.x下问题很多,昨晚上github,发现有人尝试在4.x.x下编译darknet_ros,Opencv4, now working #202,结论是将darknet_ros/下的darknet替换为AlexeyAB/darknet,后者在OpenCV2/3/4下都能编译。于是将OpenCV改回4.1.1,尝试编译AlexeyAB/darknet。

2020.10.16

AlexeyAB/darknet编译运行成功,替换darknet_ros下的darknet后,catkin_make失败。

用kunaltyagi/darknet替换darknet_ros下的darknet,参照OpenCV4 compilation success修改相应文件,catkin_make仍失败。

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)