引言

YOLOv5+Deep Sort 实现目标跟踪,并利用MOTChallengeEvalKit实现多目标跟踪结果的评估。

YOLOv5+Deep Sort 实现目标跟踪可以参考笔者的【YOLOv5】yolov5目标识别+DeepSort目标追踪

实现步骤

1 安装MATLAB

安装MATLAB

MATLAB是一款商业数学软件,用于算法开发、数据可视化、数据分析以及数值计算的高级技术计算语言和交互式环境,主要包括MATLAB和Simulink两大部分,可以进行矩阵运算、绘制函数和数据、实现算法、创建用户界面、连接其他编程语言的程序等,主要应用于工程计算、控制设计、信号处理与通讯、图像处理、信号检测、金融建模设计与分析等领域。

直接附上安装的参考链接:https://mp.weixin.qq.com/s/LAatgqNf55zpxzOYlpn8fg

2 必要的开源

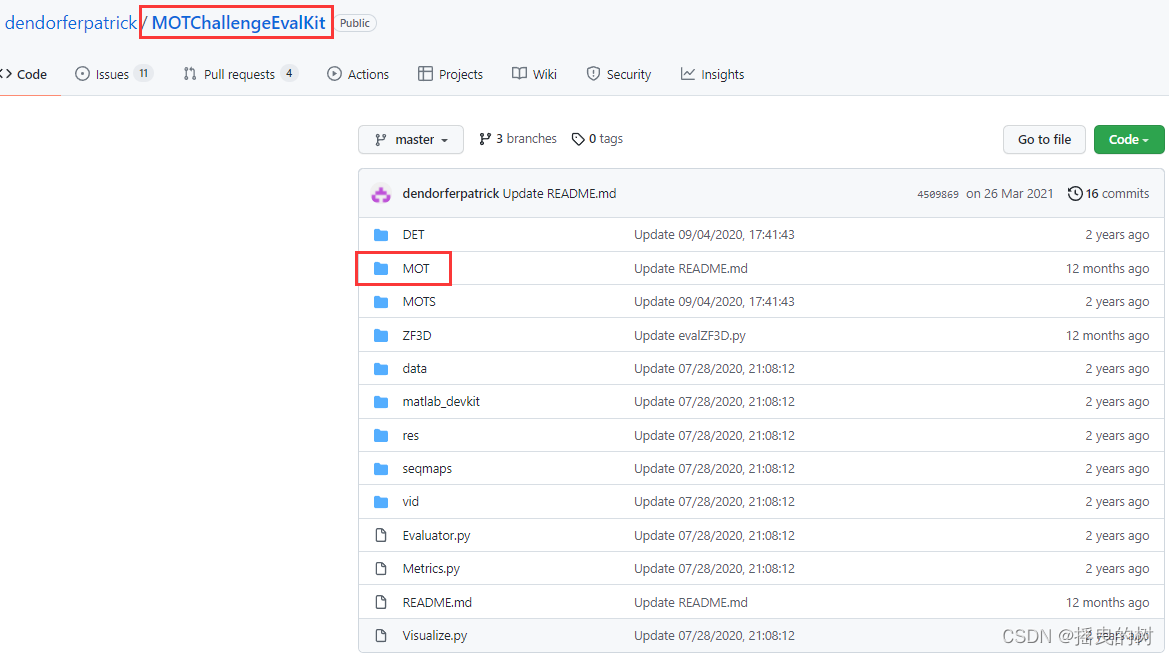

- MOT评估工具:dendorferpatrick-MOTChallengeEvalKit

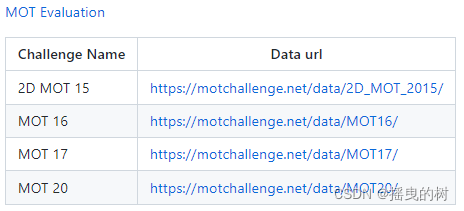

- 开源的评估数据库:例如MOT 17,其他链接如下

- Deep Sort目标跟踪:mikel-brostrom-Yolov5_DeepSort_Pytorch

- YOLOv5目标识别:ultralytics-yolov5

下载上述开源压缩包,进行解压,文件的部署如下:

-----------------------------------------------------------------------------------------------------------

|-MOTChallengeEvalKit(评估工具源码)

|-MOT

|-matlab_devkit

|-evalMOT.py

|-Evaluator.py

|-Metrics.py

|-MOT_metrics.py

|-MOTVisualization.py

|-Visualize.py

|-Yolov5_DeepSort_Pytorch(目标跟踪)

|-deep_sort

|-yolov5

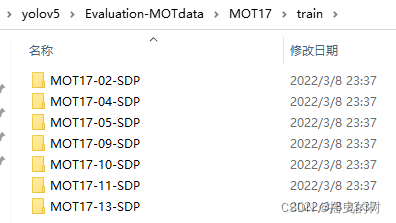

|-Evaluation-MOTdata(开源数据库)

|-MOT16

|-MOT17

|-MOT20

-----------------------------------------------------------------------------------------------------------

3 环境部署

首先利用Anaconda创建新的环境,以优先满足YOLOv5的环境部署,特别是python的版本不能低于YOLOv5要求的下限。

conda create -n yolov5-6 python=3.7

conda activate yolov5-6

3.1 MATLAB编译

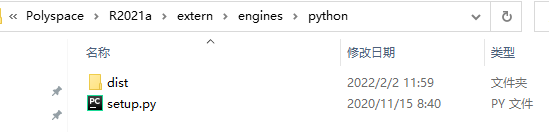

笔者MATLAB的版本是:MATLAB R2021a

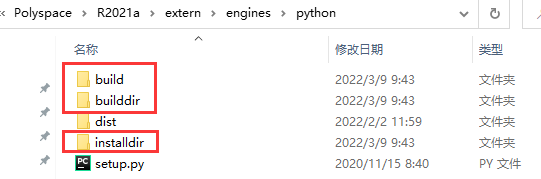

终端进入MATLAB的安装路径:D:\Program Files\Polyspace\R2021a\extern\engines\python 自定义的安装路径

cd D:\Program Files\Polyspace\R2021a\extern\engines\python

python setup.py build --build-base="builddir" install

python setup.py install --prefix="installdir"

python setup.py build --build-base="builddir" install --prefix="installdir"

python setup.py install --user

执行完上述指令之后,MATLAB的安装路径下新增文件如下:

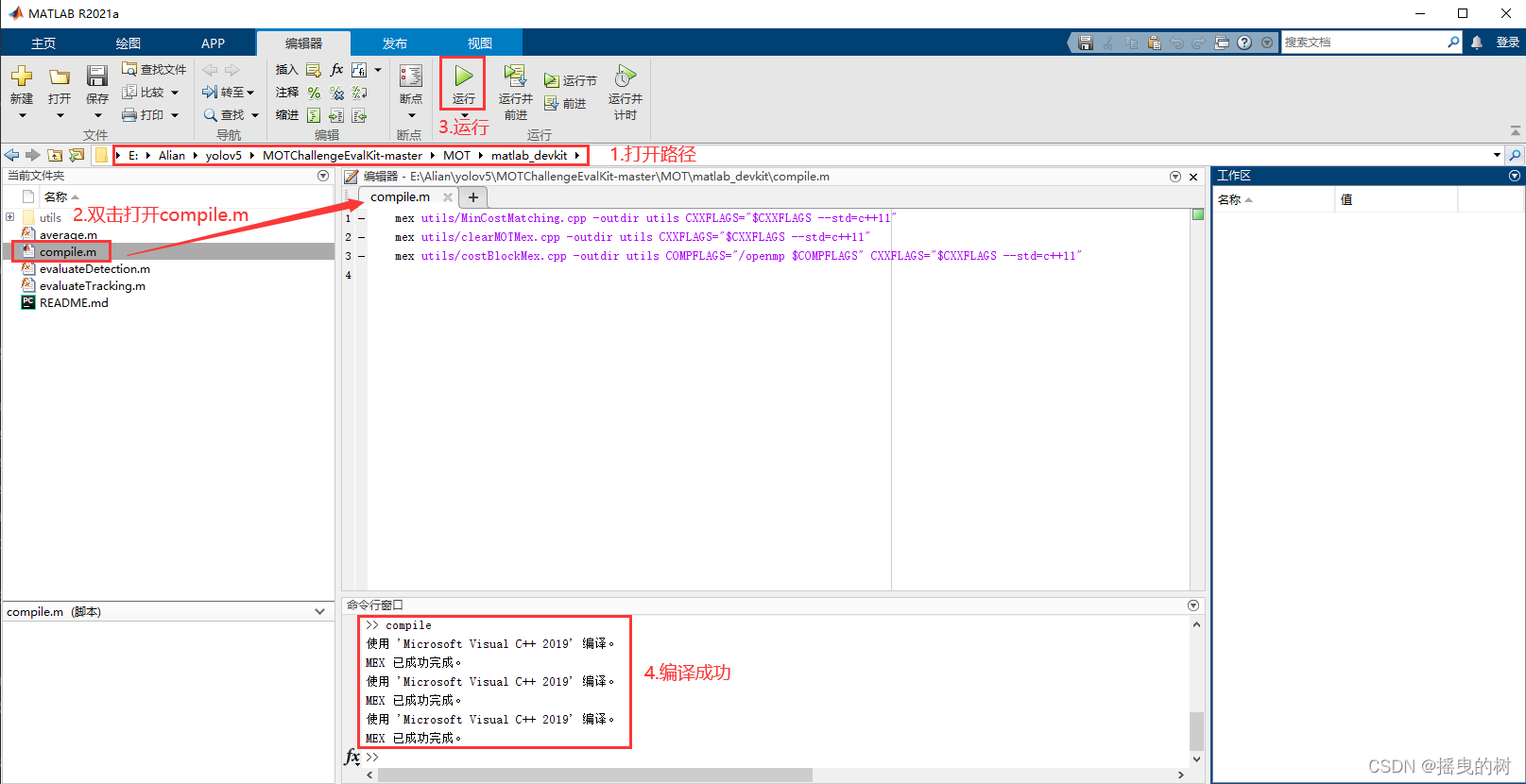

打开MATLAB完成编译

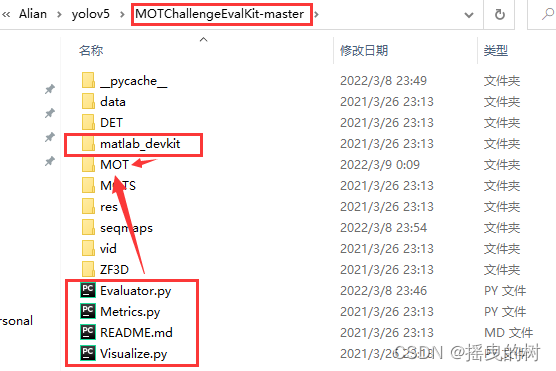

打开评估工具源码项目文件,并将如下文件复制到MOT文件夹下面,这一步的复制操作十分重要,否则即使编译成功,评估也会失败。

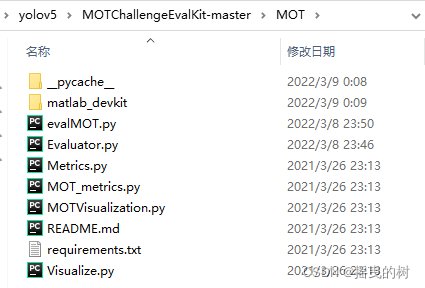

复制后MOT文件夹下的文件如下:

根据截图完成编译

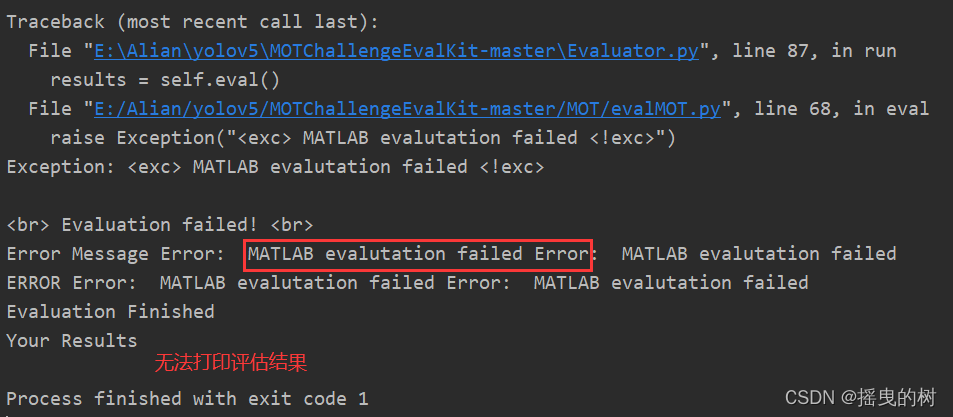

若没有复制上述文件,则评估是会有如下的错误:

3.2 DeepSort +YOLOv5环境搭建

优先满足YOLOv5的环境部署,DeepSort没有特殊的要求,在运行时缺啥补啥

参考链接【YOLOv5】6.0环境搭建(不定时更新)

3.3 MOT基准数据集格式

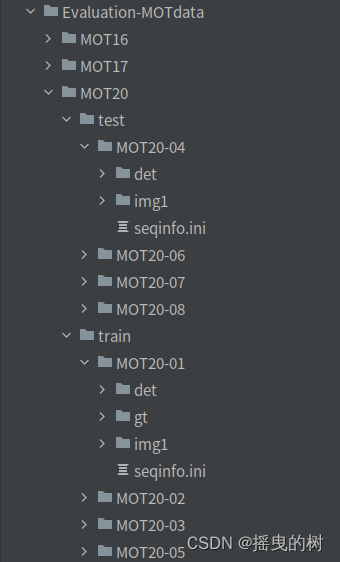

介绍下基准数据集中的数据格式,以MOT20为例:

包括test和train,其中 只有train 包含跟踪的真值,即可以用于评估的

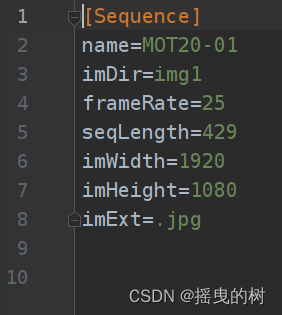

1. seqinfo.ini

在每个子文件夹中都有这个,主要用于说明这个文件的一些信息,比如长度,帧率,图片的长和宽,图片的后缀名。

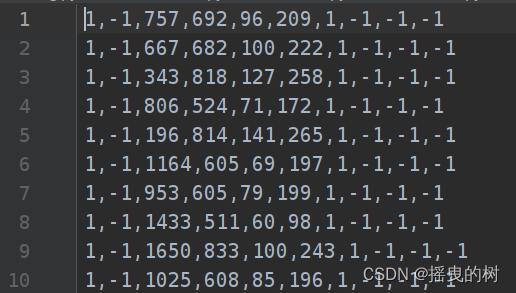

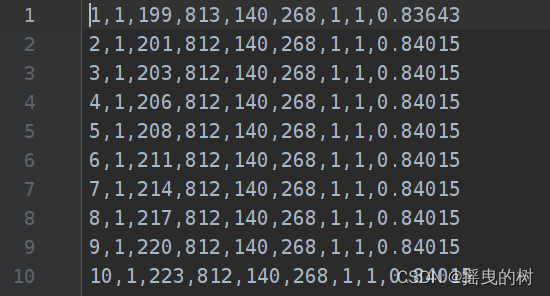

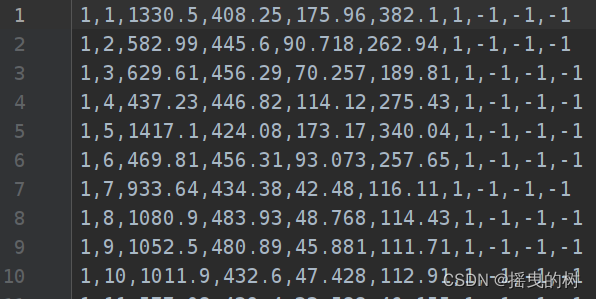

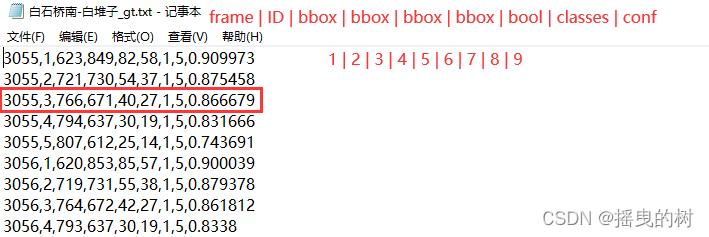

2. det.txt

这个文件中存储了图片的检测框的信息 (检测得到的信息文件),无法进行MOT评估,因为没有id信息(笔者一开始一直无法理解第二列的-1跟自生成的评估格式之间的关联,后面才知道det.txt只是保存检测信息,与mot评估无关,后面会介绍如何生成用于MOT评估的结果)部分内容展示如下:

从左到右分别代表:

• frame: 第几帧图片

• id: 这个检测框分配的 id,在这里都是-1 代表没有 id 信息(因为检测是没有跟踪信息id的)

• bbox(四位): 分别是左上角坐标和长宽

• conf:这个 bbox 包含物体的置信度,可以看到并不是传统意义的 0-1,分数越高代表置信度越高• MOT3D(x,y,z): 是在 MOT3D 中使用到的内容,这里关心的是 MOT2D,所以都设置为-1可以看出以上内容主要提供的和目标检测的信息没有区别,所以也在一定程度上可以用于检测器的训练。

3. gt.txt

这个文件只有 train 的子文件夹中有,test 中没有,其中内容的格式和 det.txt 有一些类似,部分内容

如下:

从左到右分别是:

• frame: 第几帧图片

• ID: 也就是轨迹的 ID,可以看出 gt 里边是按照轨迹的 ID 号进行排序的

• bbox: 分别是左上角坐标和长宽

• 是否忽略:0 代表忽略(即不需要跟踪的目标)

• classes: 目标的类别索引,从1开始!!!!!!!!

• 最后一个代表目标运动时被其他目标包含、覆盖、边缘裁剪的情况,1代表完全被遮挡(如果是自定义基准的话,这部分一般为0,或者可以写入其他信息)

4 评估测试

测试上述所搭建的环境是否能在开源的MOT17实现评估

4.1 下载现成的跟踪结果

现成的跟踪结果笔者的参考链接:(python版 MOTChallengeEvalKit 评估工具运行,运行MOT评估工具)

链接:https://pan.baidu.com/s/1CkPse7rcx53qOEy8YlU6qw

提取码:rlwj

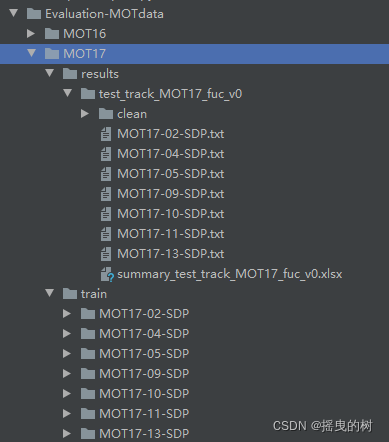

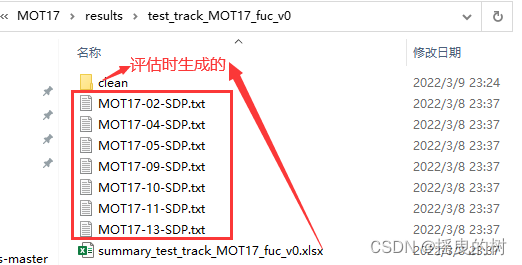

将下载的文件放入开源数据集中:

4.2 运行评估

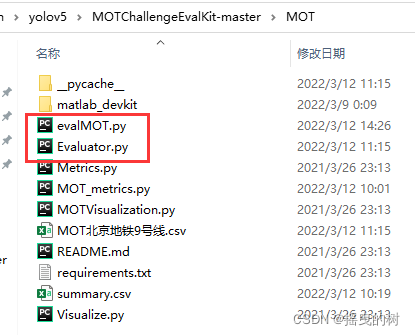

(1)打开评估代码MOTChallengeEvalKit-master\MOT\evalMOT.py

修改配置如下:

if __name__ == "__main__":

eval = MOT_evaluator()

benchmark_name = "MOT17"

gt_dir = r"E:\Alian\yolov5\MOTChallengeEvalKit-master\MOT17"

res_dir = r"E:\Alian\yolov5\MOTChallengeEvalKit-master\MOT17\results\test_track_MOT17_fuc_v0"

eval_mode = "train"

seqmaps_dir = r'E:\Alian\yolov5\MOTChallengeEvalKit-master\seqmaps'

eval.run(

benchmark_name = benchmark_name,

gt_dir = gt_dir,

res_dir = res_dir,

eval_mode = eval_mode,

seqmaps_dir=seqmaps_dir

)

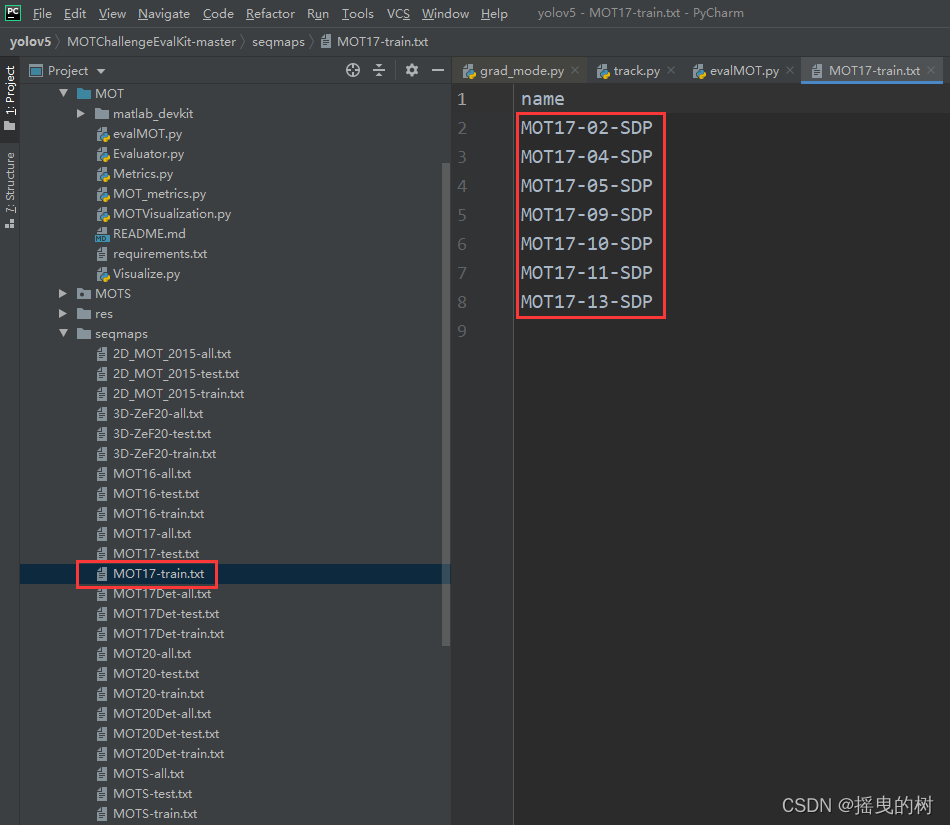

(2)打开MOTChallengeEvalKit-master\seqmaps\MOT17-train.txt

只保留下述的内容,多余的删除(因为只有下述文件的跟踪结果),检查基准、跟踪结果是否一一对应

评估基准

跟踪结果

以下格式才是用于评估的结构(区别det.txt):

终端执行命令,打印结果如下

python evalMOT.py

5 在自定义的数据下实现跟踪评估

5.1 修改评估代码

./MOT/evalMOT.py 修改如下

"""

2022.3.12

author:alian

实现跟踪结果的评估

"""

import sys, os

sys.path.append(os.path.abspath(os.getcwd()))

import math

from collections import defaultdict

from MOT_metrics import MOTMetrics

from Evaluator import Evaluator, run_metrics,My_Evaluator

import multiprocessing as mp

import pandas as pd

class My_MOTevaluator(My_Evaluator):

def __init__(self):

super().__init__()

pass

def my_eval(self):

arguments = []

for seq, res, gt in zip(self.sequences, self.tsfiles, self.gtfiles):

arguments.append({"metricObject": MOTMetrics(seq), "args": {

"gtDataDir": os.path.join(os.path.dirname(gt),seq),

"sequence": str(seq),

"pred_file":res,

"gt_file": gt,

"benchmark_name": self.benchmark_name}})

try:

if self.MULTIPROCESSING:

p = mp.Pool(self.NR_CORES)

print("Evaluating on {} cpu cores".format(self.NR_CORES))

processes = [p.apply_async(run_metrics, kwds=inp) for inp in arguments]

self.results = [p.get() for p in processes]

p.close()

p.join()

else:

self.results = [run_metrics(**inp) for inp in arguments]

self.failed = False

except:

self.failed = True

raise Exception("<exc> MATLAB evalutation failed <!exc>")

self.Overall_Results = MOTMetrics("OVERALL")

return self.results,self.Overall_Results

./MOT/Evaluator.py

"""

2022.3.12

author:alian

"""

import sys, os

sys.path.append(os.getcwd())

import argparse

import traceback

import time

import pickle

import pandas as pd

import glob

from os import path

import numpy as np

class My_Evaluator(object):

""" 评估器类运行每个序列的评估并计算基准的整体性能"""

def __init__(self):

pass

def run(self, benchmark_name=None, gt_dir=None, mot_dir=None,save_csv = None):

self.benchmark_name = benchmark_name

start_time = time.time()

self.gtfiles = glob.glob('%s/*_gt.txt'%gt_dir)

self.tsfiles = glob.glob('%s/*_mot.txt'%mot_dir)

self.sequences = [os.path.split(x)[-1].split('_')[0] for x in self.gtfiles]

print('Found {} ground truth files and {} test files.'.format(len(self.gtfiles), len(self.tsfiles)))

self.MULTIPROCESSING = True

MAX_NR_CORES = 10

if self.MULTIPROCESSING: self.NR_CORES = np.minimum(MAX_NR_CORES, len(self.tsfiles))

try:

""" 执行评估 """

self.results,self.Overall_Results = self.my_eval()

results_attributes = self.Overall_Results.metrics.keys()

for attr in results_attributes:

""" 在所有序列上累积评估值 """

try:

self.Overall_Results.__dict__[attr] = sum(obj.__dict__[attr] for obj in self.results)

except:

pass

cache_attributes = self.Overall_Results.cache_dict.keys()

for attr in cache_attributes:

""" accumulate cache values over all sequences """

try:

self.Overall_Results.__dict__[attr] = self.Overall_Results.cache_dict[attr]['func']([obj.__dict__[attr] for obj in self.results])

except:

pass

print("evaluation successful")

for res in self.results:

res.compute_clearmot()

self.Overall_Results.compute_clearmot()

summary = self.accumulate_df(type="mail")

summary.to_csv(save_csv)

except:pass

end_time=time.time()

self.duration = (end_time - start_time)/60.

print("Evaluation Finished")

print("Your Results")

print(self.render_summary())

print("Successfully save results")

return self.Overall_Results, self.results

def my_eval(self):

raise NotImplementedError

def accumulate_df(self, type = None):

""" create accumulated dataframe with all sequences """

summary = None

for k, res in enumerate(self.results):

res.to_dataframe(display_name = True, type=type)

if k == 0: summary = res.df

else:summary = pd.concat([summary,res.df])

summary = summary.sort_index()

self.Overall_Results.to_dataframe(display_name=True, type=type)

self.summary = pd.concat([summary,self.Overall_Results.df])

return self.summary

def render_summary( self, buf = None):

"""

Params:

summary : pd.DataFrame

Kwargs:

buf : StringIO-like, optional 写入缓存区

formatters : dict, optional(为单个指标定义自定义格式化程序的字典){'mota': '{:.2%}'.format}.MetricsHost.formatters

namemap : dict, optional {'num_false_positives': 'FP'}

Returns:

string

"""

output = self.summary.to_string(

buf=buf,

formatters=self.Overall_Results.formatters,

justify="left"

)

return output

def run_metrics( metricObject, args ):

""" Runs metric for individual sequences

Params:

-----

metricObject: metricObject that has computer_compute_metrics_per_sequence function

args: dictionary with args for evaluation function

"""

metricObject.compute_metrics_per_sequence(**args)

return metricObject

if __name__ == "__main__":

Evaluator()

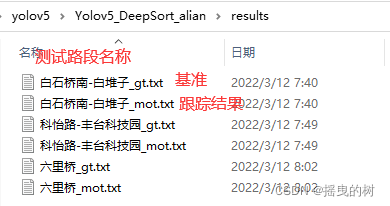

5.2 基准和评估结果准备

(1)基准文件:name_gt.txt

从左到右分别是:

1. frame: 第几帧图片

2. ID:也就是轨迹的ID,可以看出gt里边是按照轨迹的ID号进行排序的

3. bbox: 分别是左上角坐标和长宽

4. bbox: 分别是左上角坐标和长宽

5. bbox: 分别是左上角坐标和长宽

6. bbox: 分别是左上角坐标和长宽

7. bool类型:代表是否忽略:0代表忽略,1代表该目标被选

8. classes:目标的类别个数(开源的MOT数据集中:驾驶场景包括12个类别,7代表的是静止的人, 第8个类代表错检,9-11代表被遮挡的类别,如下图),自定数据集就根据自己的目标类别数

9. 最后一个代表目标运动时被其他目标包含、覆盖、边缘裁剪的情况,这里笔者将目标的置信度写入该列的值

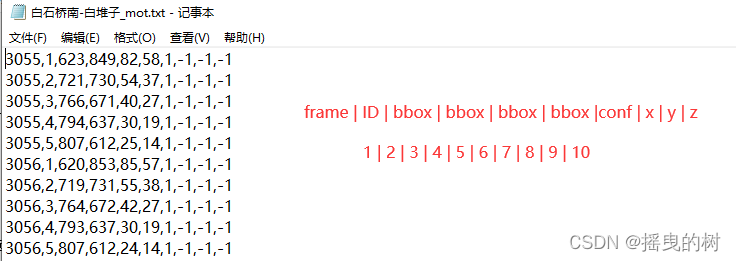

(2)跟踪结果:name_mot.txt

从左到右分别是:

1. frame: 第几帧图片

2. ID:也就是轨迹的ID,可以看出gt里边是按照轨迹的ID号进行排序的

3. bbox: 分别是左上角坐标和长宽

4. bbox: 分别是左上角坐标和长宽

5. bbox: 分别是左上角坐标和长宽

6. bbox: 分别是左上角坐标和长宽

7. conf:目标置信度

8. MOT3D(x,y,z): 是在MOT3D(三维跟踪)中使用到的内容,这里关心的是MOT二维,所以都设置为-1

5.3 实现自定义数据集的MOT评估

打开./MOT/evalMOT.py 修改配置如下

if __name__ == "__main__":

my_eval = My_MOTevaluator()

benchmark_name = "MOT北京地铁9号线"

gt_dir = r"E:\Alian\yolov5\Yolov5_DeepSort_alian\results"

res_dir = r"E:\Alian\yolov5\Yolov5_DeepSort_alian\results"

my_eval.run(

benchmark_name=benchmark_name,

gt_dir=gt_dir,

mot_dir=res_dir,

save_csv='MOT北京地铁9号线.csv'

)

6 完整代码汇总

6.1 evalMOT.py

"""

2022.3.12

author:alian

实现跟踪结果的评估

"""

import sys, os

sys.path.append(os.path.abspath(os.getcwd()))

import math

from collections import defaultdict

from MOT_metrics import MOTMetrics

from Evaluator import Evaluator, run_metrics,My_Evaluator

import multiprocessing as mp

import pandas as pd

class MOT_evaluator(Evaluator):

def __init__(self):

super().__init__()

self.type = "MOT"

def eval(self):

print("Check prediction files")

error_message = ""

for pred_file in self.tsfiles:

print(pred_file)

df = pd.read_csv(pred_file, header=None, sep=",")

if len(df.columns) == 1:

f = open(pred_file, "r")

error_message+= "<exc>Submission %s not in correct form. Values in file must be comma separated.<br>Current form:<br>%s<br>%s<br>.........<br><!exc>" % (pred_file.split("/")[-1], f.readline(), f.readline())

raise Exception(error_message)

df.groupby([0,1]).size().head()

count = df.groupby([0,1]).size().reset_index(name='count')

if any(count["count"]>1):

doubleIDs = count.loc[count["count"]>1][[0,1]].values

error_message+= "<exc> Found duplicate ID/Frame pairs in sequence %s." % pred_file.split("/")[-1]

for id in doubleIDs:

double_values = df[((df[0] == id[0]) & (df[1] == id[1]))]

for row in double_values.values:

error_message += "<br> %s" % row

error_message+="<br> <!exc> "

if error_message != "":

raise Exception(error_message)

print("Files are ok!")

arguments = []

for seq, res, gt in zip(self.sequences, self.tsfiles, self.gtfiles):

arguments.append({"metricObject": MOTMetrics(seq), "args": {

"gtDataDir": os.path.join(self.datadir,seq),

"sequence": str(seq),

"pred_file":res,

"gt_file": gt,

"benchmark_name": self.benchmark_name}})

try:

if self.MULTIPROCESSING:

p = mp.Pool(self.NR_CORES)

print("Evaluating on {} cpu cores".format(self.NR_CORES))

processes = [p.apply_async(run_metrics, kwds=inp) for inp in arguments]

self.results = [p.get() for p in processes]

p.close()

p.join()

else:

self.results = [run_metrics(**inp) for inp in arguments]

self.failed = False

except:

self.failed = True

raise Exception("<exc> MATLAB evalutation failed <!exc>")

self.Overall_Results = MOTMetrics("OVERALL")

return self.results,self.Overall_Results

class My_MOTevaluator(My_Evaluator):

def __init__(self):

super().__init__()

pass

def my_eval(self):

arguments = []

for seq, res, gt in zip(self.sequences, self.tsfiles, self.gtfiles):

arguments.append({"metricObject": MOTMetrics(seq), "args": {

"gtDataDir": os.path.join(os.path.dirname(gt),seq),

"sequence": str(seq),

"pred_file":res,

"gt_file": gt,

"benchmark_name": self.benchmark_name}})

try:

if self.MULTIPROCESSING:

p = mp.Pool(self.NR_CORES)

print("Evaluating on {} cpu cores".format(self.NR_CORES))

processes = [p.apply_async(run_metrics, kwds=inp) for inp in arguments]

self.results = [p.get() for p in processes]

p.close()

p.join()

else:

self.results = [run_metrics(**inp) for inp in arguments]

self.failed = False

except:

self.failed = True

raise Exception("<exc> MATLAB evalutation failed <!exc>")

self.Overall_Results = MOTMetrics("OVERALL")

return self.results,self.Overall_Results

if __name__ == "__main__":

my_eval = My_MOTevaluator()

benchmark_name = "MOT北京地铁9号线"

gt_dir = r"E:\Alian\yolov5\Yolov5_DeepSort_alian\results"

res_dir = r"E:\Alian\yolov5\Yolov5_DeepSort_alian\results"

my_eval.run(

benchmark_name=benchmark_name,

gt_dir=gt_dir,

mot_dir=res_dir,

save_csv='MOT北京地铁9号线.csv'

)

6.2 Evaluator.py

"""

2022.3.12

author:alian

"""

import sys, os

sys.path.append(os.getcwd())

import argparse

import traceback

import time

import pickle

import pandas as pd

import glob

from os import path

import numpy as np

class Evaluator(object):

""" 评估器类运行每个序列的评估并计算基准的整体性能"""

def __init__(self):

pass

def run(self, benchmark_name=None, gt_dir=None, res_dir=None, save_pkl=None, eval_mode="train", seqmaps_dir="seqmaps"):

"""

Params

benchmark_name: 基准名称,如 MOT17

gt_dir: directory of folders with gt data, including the c-files with sequences

res_dir: directory with result files

<seq1>.txt

<seq2>.txt

...

<seq3>.txt

eval_mode:

seqmaps_dir:

seq_file: File name of file containing sequences, e.g. 'c10-train.txt'

save_pkl: path to output directory for final results

"""

start_time = time.time()

self.benchmark_gt_dir = gt_dir

self.seq_file = "{}-{}.txt".format(benchmark_name, eval_mode)

res_dir = res_dir

self.benchmark_name = benchmark_name

self.seqmaps_dir = seqmaps_dir

self.mode = eval_mode

self.datadir = os.path.join(gt_dir, self.mode)

error_traceback = ""

assert self.mode in ["train", "test", "all"], "mode: %s not valid " %self.mode

print("Evaluating Benchmark: %s" % self.benchmark_name)

self.sequences = np.genfromtxt(os.path.join(self.seqmaps_dir, self.seq_file), dtype='str', skip_header=True)

self.gtfiles = []

self.tsfiles = []

for seq in self.sequences:

gtf = os.path.join(self.benchmark_gt_dir, self.mode ,seq, 'gt/gt.txt')

if path.exists(gtf): self.gtfiles.append(gtf)

else: raise Exception("Ground Truth %s missing" % gtf)

tsf = os.path.join(res_dir, "%s.txt" % seq)

if path.exists(gtf): self.tsfiles.append(tsf)

else: raise Exception("Result file %s missing" % tsf)

print('Found {} ground truth files and {} test files.'.format(len(self.gtfiles), len(self.tsfiles)))

print(self.tsfiles)

self.MULTIPROCESSING = True

MAX_NR_CORES = 10

if self.MULTIPROCESSING: self.NR_CORES = np.minimum(MAX_NR_CORES, len(self.tsfiles))

try:

""" 执行评估 """

self.results,self.Overall_Results = self.eval()

results_attributes = self.Overall_Results.metrics.keys()

for attr in results_attributes:

""" 在多进程上累积评估值 """

try:

self.Overall_Results.__dict__[attr] = sum(obj.__dict__[attr] for obj in self.results)

except:

pass

cache_attributes = self.Overall_Results.cache_dict.keys()

for attr in cache_attributes:

""" accumulate cache values over all sequences """

try:

self.Overall_Results.__dict__[attr] = self.Overall_Results.cache_dict[attr]['func']([obj.__dict__[attr] for obj in self.results])

except:

pass

print("evaluation successful")

for res in self.results:

res.compute_clearmot()

self.Overall_Results.compute_clearmot()

summary = self.accumulate_df(type="mail")

self.summary.to_csv('summary.csv')

self.failed = False

except Exception as e:

print(str(traceback.format_exc()))

print ("<br> Evaluation failed! <br>")

error_traceback+= str(traceback.format_exc())

self.failed = True

self.summary = None

end_time=time.time()

self.duration = (end_time - start_time)/60.

if self.failed:

startExc = error_traceback.split("<exc>")

error_traceback = [m.split("<!exc>")[0] for m in startExc[1:]]

error = ""

for err in error_traceback:

error += "Error: %s" % err

print( "Error Message", error)

self.error = error

print("ERROR %s" % error)

print ("Evaluation Finished")

print("Your Results")

print(self.render_summary())

if save_pkl:

self.Overall_Results.save_dict(os.path.join( save_pkl, "%s-%s-overall.pkl" % (self.benchmark_name, self.mode)))

for res in self.results:

res.save_dict(os.path.join( save_pkl, "%s-%s-%s.pkl" % (self.benchmark_name, self.mode, res.seqName)))

print("Successfully save results")

return self.Overall_Results, self.results

def eval(self):

raise NotImplementedError

def accumulate_df(self, type = None):

""" create accumulated dataframe with all sequences """

summary = None

for k, res in enumerate(self.results):

res.to_dataframe(display_name = True, type=type)

if k == 0: summary = res.df

else: summary = pd.concat([summary,res.df])

summary = summary.sort_index()

self.Overall_Results.to_dataframe(display_name=True, type=type)

self.summary = pd.concat([summary,self.Overall_Results.df])

return self.summary

def render_summary( self, buf = None):

"""

Params:

summary : pd.DataFrame

Kwargs:

buf : StringIO-like, optional 写入缓存区

formatters : dict, optional(为单个指标定义自定义格式化程序的字典){'mota': '{:.2%}'.format}.MetricsHost.formatters

namemap : dict, optional {'num_false_positives': 'FP'}

Returns:

string

"""

output = self.summary.to_string(

buf=buf,

formatters=self.Overall_Results.formatters,

justify="left"

)

return output

class My_Evaluator(object):

""" 评估器类运行每个序列的评估并计算基准的整体性能"""

def __init__(self):

pass

def run(self, benchmark_name=None, gt_dir=None, mot_dir=None,save_csv = None):

self.benchmark_name = benchmark_name

start_time = time.time()

self.gtfiles = glob.glob('%s/*_gt.txt'%gt_dir)

self.tsfiles = glob.glob('%s/*_mot.txt'%mot_dir)

self.sequences = [os.path.split(x)[-1].split('_')[0] for x in self.gtfiles]

print('Found {} ground truth files and {} test files.'.format(len(self.gtfiles), len(self.tsfiles)))

self.MULTIPROCESSING = True

MAX_NR_CORES = 10

if self.MULTIPROCESSING: self.NR_CORES = np.minimum(MAX_NR_CORES, len(self.tsfiles))

try:

""" 执行评估 """

self.results,self.Overall_Results = self.my_eval()

results_attributes = self.Overall_Results.metrics.keys()

for attr in results_attributes:

""" 在所有序列上累积评估值 """

try:

self.Overall_Results.__dict__[attr] = sum(obj.__dict__[attr] for obj in self.results)

except:

pass

cache_attributes = self.Overall_Results.cache_dict.keys()

for attr in cache_attributes:

""" accumulate cache values over all sequences """

try:

self.Overall_Results.__dict__[attr] = self.Overall_Results.cache_dict[attr]['func']([obj.__dict__[attr] for obj in self.results])

except:

pass

print("evaluation successful")

for res in self.results:

res.compute_clearmot()

self.Overall_Results.compute_clearmot()

summary = self.accumulate_df(type="mail")

summary.to_csv(save_csv)

except:pass

end_time=time.time()

self.duration = (end_time - start_time)/60.

print("Evaluation Finished")

print("Your Results")

print(self.render_summary())

print("Successfully save results")

return self.Overall_Results, self.results

def my_eval(self):

raise NotImplementedError

def accumulate_df(self, type = None):

""" create accumulated dataframe with all sequences """

summary = None

for k, res in enumerate(self.results):

res.to_dataframe(display_name = True, type=type)

if k == 0: summary = res.df

else:summary = pd.concat([summary,res.df])

summary = summary.sort_index()

self.Overall_Results.to_dataframe(display_name=True, type=type)

self.summary = pd.concat([summary,self.Overall_Results.df])

return self.summary

def render_summary( self, buf = None):

"""

Params:

summary : pd.DataFrame

Kwargs:

buf : StringIO-like, optional 写入缓存区

formatters : dict, optional(为单个指标定义自定义格式化程序的字典){'mota': '{:.2%}'.format}.MetricsHost.formatters

namemap : dict, optional {'num_false_positives': 'FP'}

Returns:

string

"""

output = self.summary.to_string(

buf=buf,

formatters=self.Overall_Results.formatters,

justify="left"

)

return output

def run_metrics( metricObject, args ):

""" Runs metric for individual sequences

Params:

-----

metricObject: metricObject that has computer_compute_metrics_per_sequence function

args: dictionary with args for evaluation function

"""

metricObject.compute_metrics_per_sequence(**args)

return metricObject

if __name__ == "__main__":

Evaluator()

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)